Command Palette

Search for a command to run...

암퇘지는 언제 출산해야 할지 알고 있습니다. 이번에는 NNU가 NVIDIA Edge AI Jetson을 사용합니다.

내용을 한눈에 보기:돼지 사육 산업에 있어서 암퇘지 새끼 낳기는 중요한 고리입니다. 따라서 돼지 새끼의 생존율을 높이고 암퇘지 분만 과정의 안전을 확보하는 것이 중요한 문제가 되었습니다. 기존 AI 모니터링 방법은 장비 비용이 높고 정보 전송이 불안정하다는 문제점이 있습니다. 난징 농업 대학의 연구진은 가벼운 딥러닝 방법을 사용하여 모돈 분만 과정에 대한 조기 경보와 효과적인 모니터링을 제공하고, 모니터링 정확도를 높이는 동시에 비용을 절감했습니다.

키워드:임베디드 개발 보드 경량 딥 러닝

본 기사는 HyperAI WeChat 공개 플랫폼에 처음 게재되었습니다~

우리나라의 돼지 사육 산업은 세계 1위를 차지하고 있지만, 산업 전체는 여전히 낮은 번식률이라는 문제에 직면해 있습니다. 많은 대규모 돼지 농장에서 가장 중요한 것은 비용을 절감하는 동시에 돼지 새끼의 생존율을 높이는 것입니다. 전통적인 방법은 인간의 감독에 의존하는데, 이는 어렵고 매우 주관적입니다.암퇘지 분만 시 난산, 돼지 질식 등 일련의 문제에 직면하면 시기적절하고 효과적으로 대처하는 것이 어렵습니다.

최근 몇 년 동안 AI 모니터링은 이 문제를 해결하는 중요한 방법으로 자리 잡았습니다. 원칙은 주로 모니터링을 위해 클라우드 컴퓨팅을 기반으로 한 딥러닝을 사용하는 것입니다.하지만 이 방법은 장비와 네트워크 대역폭에 대한 요구 사항이 높고, 제한적이고 불안정합니다.

중국 돼지 사육 네트워크에 따르면, 암퇘지는 종종 둥지 짓기 행동을 보이며, 옥시토신이나 프로락틴의 영향으로 출산 전 12~24시간 내에 자세를 바꾸는 빈도가 증가합니다.이를 바탕으로 실험팀은 YOLOv5 알고리즘을 통해 암퇘지 자세와 새끼 돼지 출산을 모니터링하는 모델을 설계하고 NVIDIA Jetson Nano 개발 보드에 배포했습니다.이를 통해 복잡한 시나리오에서 프로세스를 모니터링하고 분석할 수 있으며, 낮은 비용, 낮은 지연 시간, 높은 효율성 및 쉬운 구현의 특징이 있습니다.

이 성과는 "임베디드 보드 구현을 위한 암퇘지 분만 조기 경고 및 감독"이라는 제목으로 2023년 1월 "센서" 저널에 게재되었습니다.

서류 주소:

실험 개요

데이터 및 처리

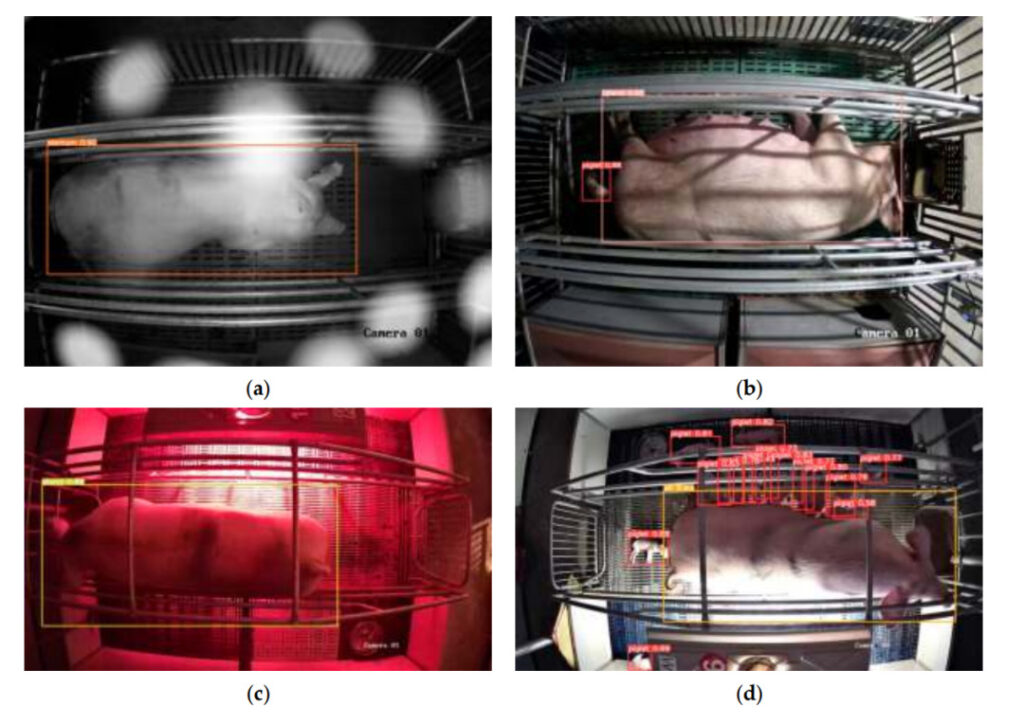

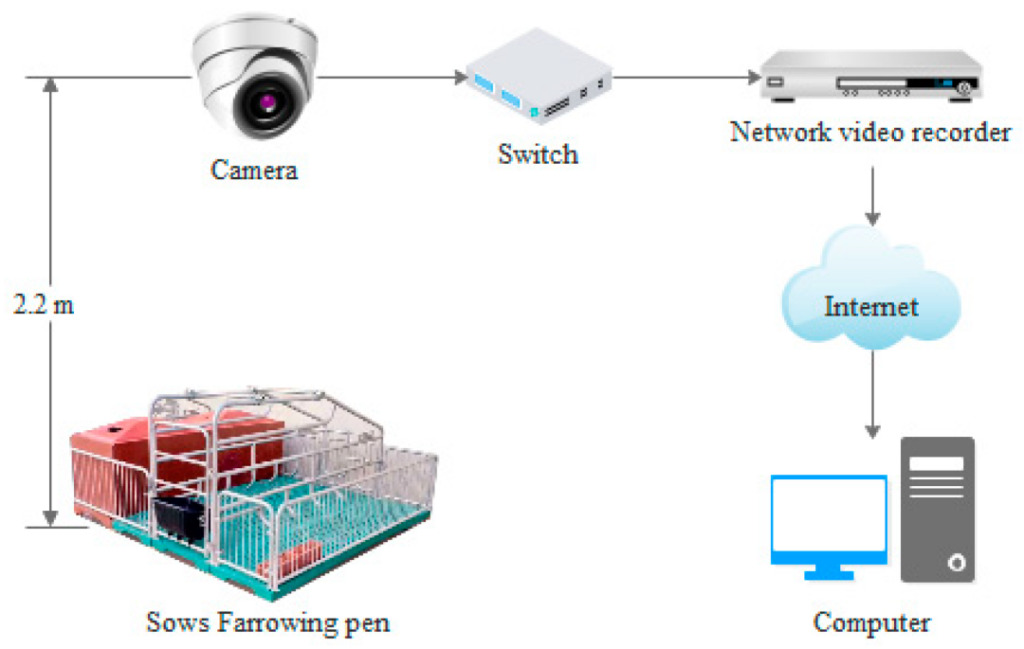

이 영상 데이터는 장쑤성 쑤첸과 징장에 있는 두 농장에서 나왔습니다.분만 전후 암퇘지 35마리의 비디오 데이터가 수집되었습니다.이 중, 2017년 4월 27일부터 5월 13일까지 진장 돼지농장의 암퇘지 11마리에 대한 데이터를 기록하였고, 2020년 6월 9일부터 15일까지 쑤첸 돼지농장의 암퇘지 24마리에 대한 데이터를 기록하였습니다. 암퇘지들은 특정 크기(2.2m x 1.8m)의 분만장에 무작위로 배치되었고, 비디오 데이터는 카메라로 24시간 동안 연속 녹화되었습니다.

과정은 다음과 같습니다.

다음으로, 데이터를 전처리합니다. 실험팀은 먼저 암퇘지가 출산하기 하루 전과 출산 후 하루 동안 녹화된 영상을 선별한 다음, Python과 OpenCV를 사용하여 이를 이미지 데이터로 처리했습니다.라벨링 소프트웨어는 12,450개의 이미지에서 암퇘지 자세와 신생 돼지 새끼의 데이터에 수동으로 주석을 달고 향상시키는 데 사용되었습니다., 32,541개의 이미지 데이터가 수집되어 데이터 세트를 형성합니다.

데이터 증강 (데이터 증강): 자르기, 이동, 회전, 미러링, 밝기 변경, 노이즈 추가, 전단 등을 말합니다.)

이 데이터 세트는 5가지 범주로 나뉩니다: 4가지 암퇘지 자세(옆으로 누워 있는 자세, 흉골 누워 있는 자세, 서 있는 자세 및 앉아 있는 자세)와 새끼 돼지,훈련 세트, 검증 세트, 테스트 세트의 비율은 7:1:2입니다.

실험 모델

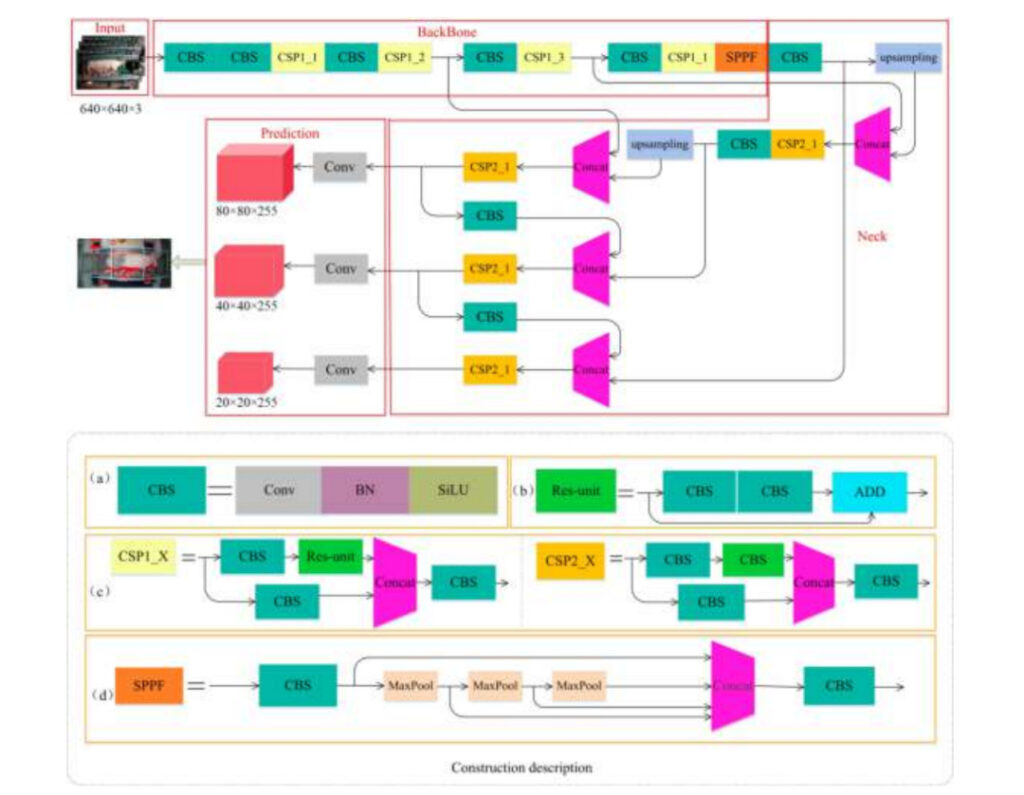

실험팀은 YOLOv5s-6.0을 사용하여 암퇘지 자세와 새끼 돼지를 감지하는 모델을 구축했습니다.이 모델은 4개 부분으로 구성되어 있습니다.

입력:이미지 입력

등뼈:모돈 및 새끼 돼지 이미지 특징 추출

목:이미지 특징의 융합

예측:예측(암퇘지와 새끼 돼지의 크기 차이가 크기 때문에 이 부분에서는 크고 중간 크기, 작은 타겟을 감지하기 위해 3가지 다른 특징 맵을 사용합니다)

에이:CBS 모듈 세부 정보

비:재분배 모듈 세부 정보

기음:CSP1_X 및 CSP2_X 모듈 세부 정보

디:SPPF 모듈 세부 구조

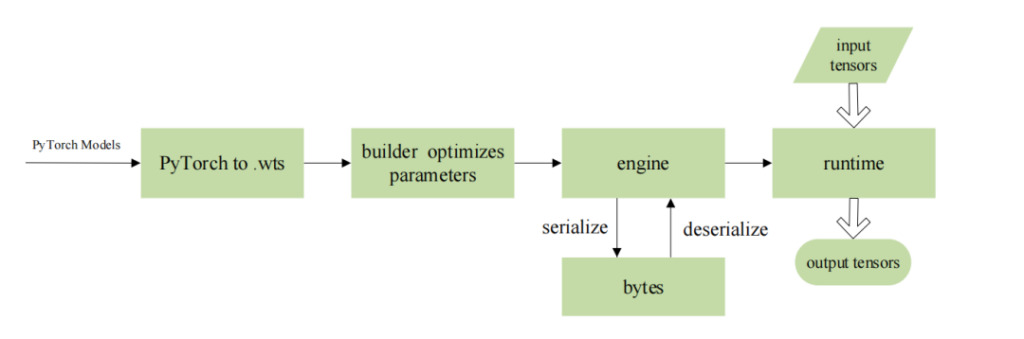

실험팀은 NVIDIA의 Jetson Nano 시리즈 임베디드 AI 컴퓨팅 플랫폼에 알고리즘을 배포하고 TensorRT를 사용하여 모델을 최적화했습니다.이를 통해 임베디드 개발 보드에서 후속 작업을 수행할 때 처리량을 높이고 지연 시간을 줄이는 동시에 네트워크 전송 중에 발생할 수 있는 데이터 유출을 방지할 수 있습니다.

구체적인 매개변수는 다음과 같습니다.

모델 학습 환경:Ubuntu 18.04 운영 체제, Intel(R) Xeon(R) Gold 5118 @ 2.30 GHz CPU, NVIDIA Quadro P4000 GPU, 8GB 비디오 메모리, 64GB 메모리, 2TB 하드 디스크, PyTorch 1.7.1 및 Torchvision 0.8.2 딥 러닝 프레임워크, CUDA 버전 10.1.

모델 배포 환경:ARM 기반 Ubuntu 16.04 운영 체제, 4코어 ARM A57 @ 1.43 GHz CPU, 128코어 Maxwell 아키텍처 GPU, 4GB 메모리, JetPack 4.5, Cuda10.2.89, Python 3.6, TensorRT 7.1, Opencv 4.1.1, CMake 3.21.2 딥러닝 환경.

모델 매개변수:(1) YOLOv5 학습의 경우 epoch 300, learning_rate 0.0001, batch_size 16으로 설정합니다. (2) TensorRT 최적화된 네트워크의 경우 batch_size는 1이고 precision은 fp16입니다.

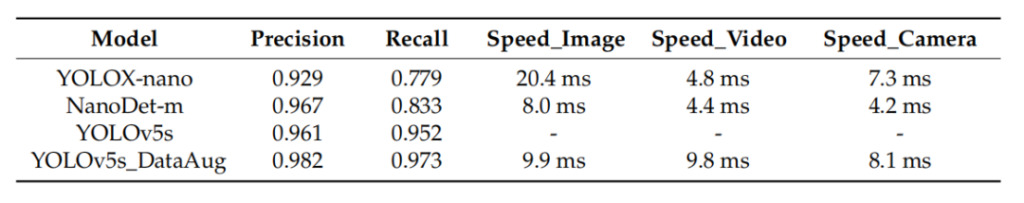

마지막으로 실험팀은 정밀도, 재현율, 감지 속도와 같은 지표를 사용하여 다양한 알고리즘의 성능을 평가했습니다.

안에,정밀도와 재현율은 알고리즘이 모든 범주의 데이터를 감지하는 능력을 측정하는 데 사용할 수 있습니다.여기에는 4가지 암퇘지 자세(옆으로 눕기, 흉골 눕기, 서기, 앉기)와 신생 돼지 새끼가 포함됩니다.모델 크기와 감지 속도는 알고리즘이 내장된 장치에 배포하기에 적합한지 여부를 측정하는 데 사용됩니다.

계산 공식은 다음과 같습니다.

TP:양성 샘플에 대한 정확한 예측 수

FP:양성 샘플에 대한 잘못된 예측 수

FN:음성 샘플에 대한 잘못된 예측 수

실험 결과

모델 성능

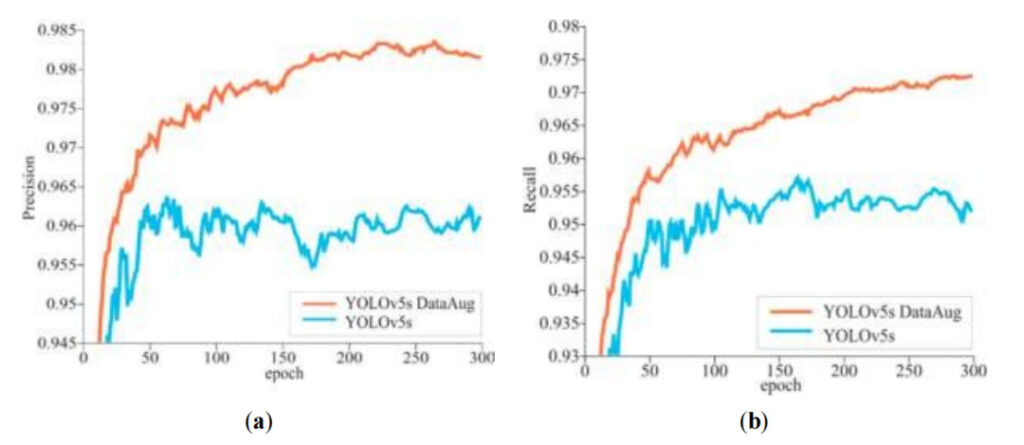

실험팀은 300개의 모델 학습 에포크에서 다음과 같은 사실을 발견했습니다.반복 주기가 길어질수록 정확도와 재현율은 일반적으로 상승 추세를 보입니다.동시에, 다음 사실을 알 수 있습니다.데이터 증강 후 YOLOv5s 모델의 정확도와 재현율은 일관되게 높습니다.

에이:정도

비:상기하다

주황색 선:데이터 증강 후 YOLOv5s 모델의 정밀도/재현율

블루 라인:데이터 증강 없이 YOLOv5s 모델의 정밀도/재현율

실험에서는 평균 정밀도(mAP)를 사용하여 알고리즘이 모든 범주를 감지하는 능력을 평가합니다.실험팀은 YOLOv5s 알고리즘을 평가하는 동안 YOLOX-nano와 NanoDet-m 알고리즘의 성능도 비교했습니다. 실험 결과, YOLOX-nano와 NanoDet-m의 검출 속도는 YOLOv5s보다 약간 빠른 것으로 나타났으나, 정확도는 낮았고, 검출 실패 및 새끼 돼지 오검출 사례가 있었습니다. YOLOv5s 알고리즘은 다양한 크기의 객체를 감지하는 데 좋은 성능을 보이며, 이미지, 로컬 비디오, 카메라에서 모델의 평균 감지 속도는 다른 두 가지와 비슷합니다.게다가, 데이터 증강된 YOLOv5s 모델은 가장 높은 정밀도와 재현율을 보이는데, 각각 0.982와 0.937입니다.

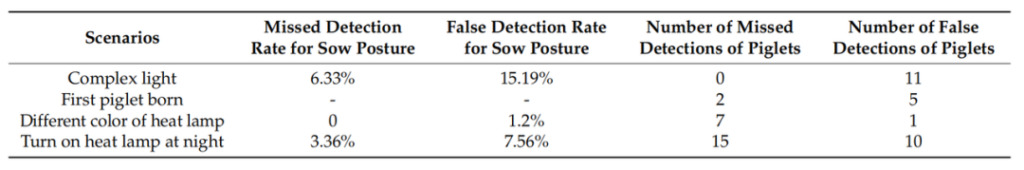

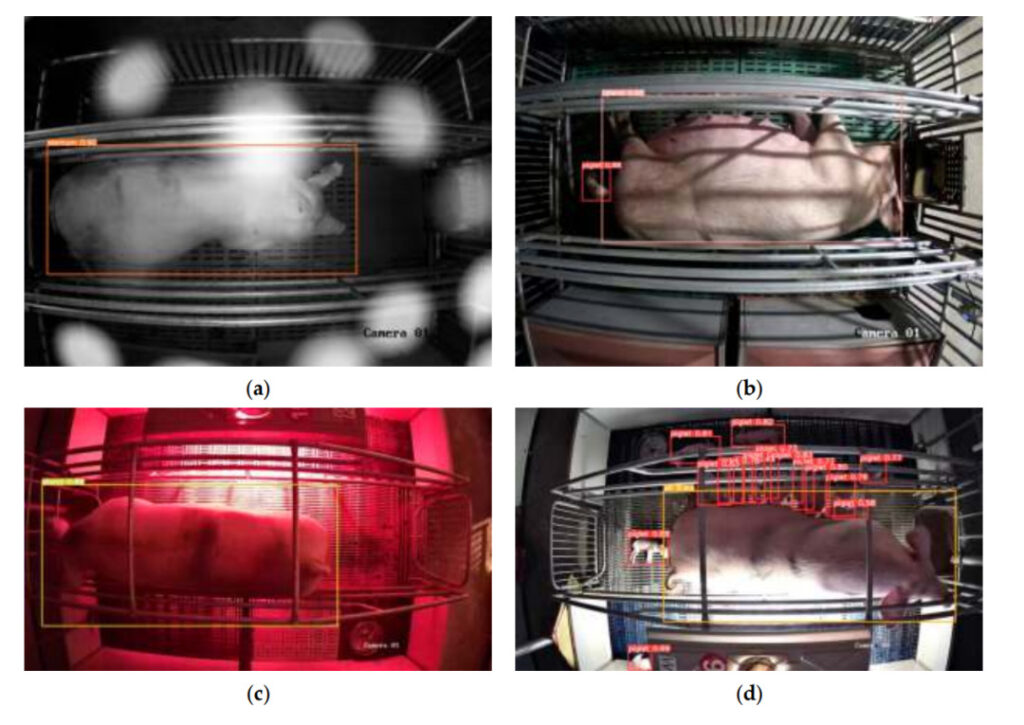

실험팀은 모델의 일반화 능력과 간섭 방지 능력을 테스트하기 위해 모델을 훈련할 때 암퇘지 한 마리를 "새로운 샘플"로 유지하고, 모델을 테스트하기 위해 서로 다른 복잡한 장면이 담긴 이미지 410개를 선택했습니다. 결과는 다음과 같습니다암퇘지 자세의 오탐지 및 감지 실패는 주로 조명 변화의 영향을 받습니다. 돼지 새끼는 주로 열 램프의 켜짐에 영향을 받습니다. 즉, 강한 빛 아래에서 돼지 새끼를 식별하기 어렵습니다. 첫 새끼 돼지가 태어나는 시간과 다양한 색상의 열 램프 장면은 모델의 감지 능력에 거의 영향을 미치지 않습니다.

왼쪽에서 두 번째 열:복잡한 조명 조건에서 암퇘지 자세의 미탐지율이 가장 높습니다.

왼쪽 3개 열:복잡한 조명 조건과 밤에 열 램프가 켜지면 암퇘지 자세의 오탐지율이 더 높습니다.

왼쪽 4개 열:혼합된 조명 조건과 열 램프가 켜진 밤에는 거짓 양성 반응이 더 많았습니다.

왼쪽 5개 열:밤에 열등이 켜져 있을 때 놓친 새끼 돼지의 수가 더 많았습니다.

에이:복잡한 조명 아래

비:첫 새끼 돼지 탄생

기음:다양한 색상의 열 램프

디:밤에 히터 램프 켜기

배치 전과 배치 후

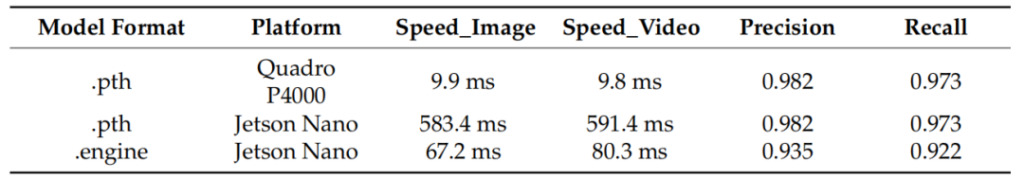

실험팀은 NVIDIA Jetson Nano에 모델을 배포한 후 암퇘지와 돼지 새끼의 자세를 정확하게 감지할 수 있었습니다. 테스트 결과를 비교한 결과,이 모델은 NVIDIA Jetson Nano에 배포된 후 정확도가 약간 떨어졌지만 속도는 8배 이상 증가했습니다.

왼쪽 열:모델 형식

왼쪽에서 두 번째 열:모델 배포 플랫폼인 Quadro P4000은 비교 테스트에 사용되는 플랫폼입니다.

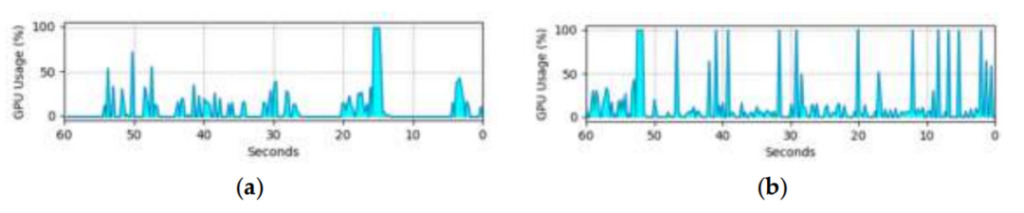

임베디드 개발 보드의 GPU 활용으로 인해 이 모델의 실제 적용이 제한됩니다. 다음 그래프는 임베디드 개발 보드에서 이미지와 비디오의 객체를 감지할 때 모델의 GPU 활용도를 보여줍니다. 비디오 스트림을 디코딩해야 하므로 비디오를 감지할 때의 GPU 활용률은 이미지를 감지할 때보다 높지만, 이는 모델의 성능에는 영향을 미치지 않습니다.테스트 결과는 이 연구의 모델이 다양한 생산 시나리오에 적용될 수 있음을 보여줍니다.

(에이) 이미지 감지에서의 GPU 활용

(비) 비디오 감지에서의 GPU 활용

테스트 결과

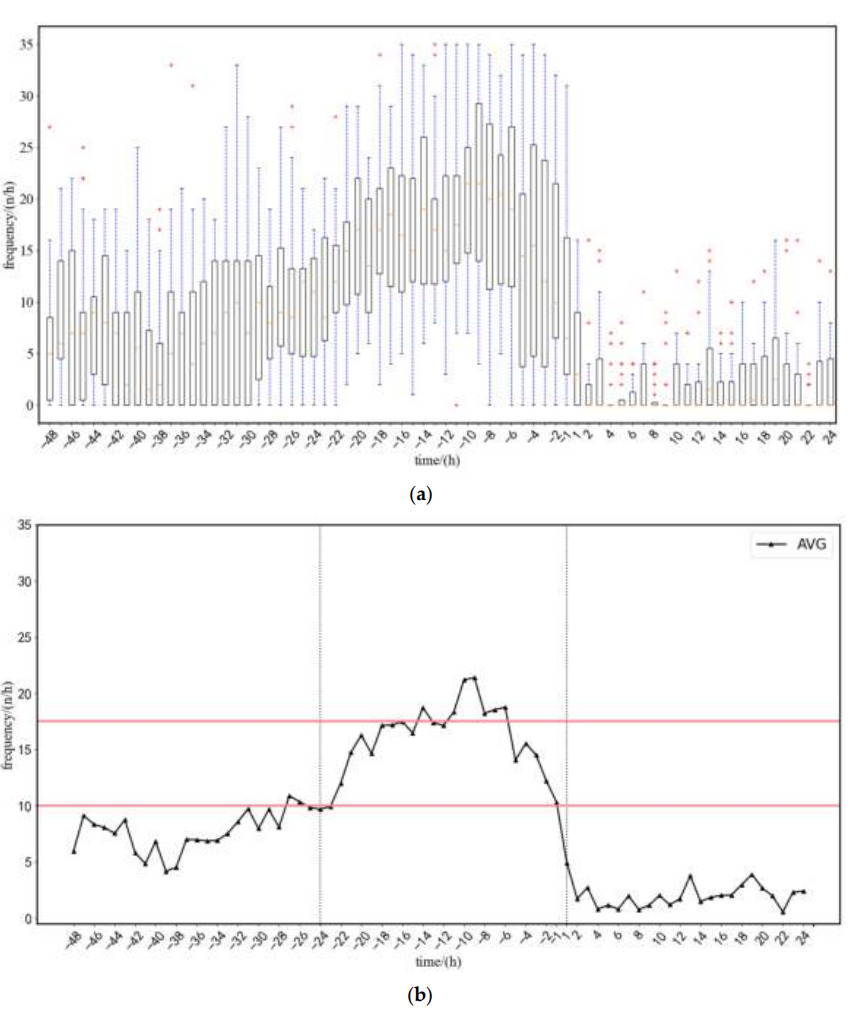

실험팀은 암퇘지 22마리의 데이터를 시험하고 분석했습니다.분만 48시간 전부터 분만 24시간 후까지 암퇘지의 자세 변화의 평균 빈도를 얻었습니다.팀은 변화 빈도(아래 그림 참조)를 기준으로 모델의 조기 경보 전략을 다음과 같이 요약했습니다.

1. 자세전환 빈도가 상한(17.5회/시)을 초과하거나 하한(10회/시) 미만으로 떨어질 경우 알람이 발생합니다.

2. 암퇘지의 일상 활동이 경고에 미치는 영향을 줄이기 위해 상한 또는 하한은 5시간 이상이어야 합니다.

샘플에 대한 테스트 결과이 모델은 분만이 시작되기 5시간 전에 경보를 낼 수 있었으며, 경고 시간과 실제 분만 시간 사이의 오차는 1.02시간이었습니다.

(에이) 평균 자세 전환 속도 범위

(비) 평균 자세 전환 빈도

배달 48시간~24시간 전,이 기간 동안 암퇘지의 활동은 정상적입니다.

배달 24시간 전 ~ 1시간 전,자세변화의 빈도는 점차 증가하다가 점차 감소한다.

분만 후 1시간~24시간,자세 전환 빈도는 0에 가깝고 그 후 약간 증가합니다.

첫 새끼 돼지가 감지되면 분만 경보가 울리고 "분만 시작! 시작 시간: XXX"이 표시됩니다. 또한, 깜박이는 LED 조명은 사육자가 출산하는 암퇘지를 빠르게 찾아내고 수동 개입이 필요한지 여부를 판단하는 데 도움이 될 수 있습니다.

하지만 감지율이 너무 높으면 돼지 새끼가 잘못 감지되는 경우가 많습니다. 따라서 실시간 탐지를 달성하고 오탐을 줄이기 위해 실험팀은 다음을 채택했습니다. "3회 연속 테스트"오직 3번 연속으로 새끼 돼지가 발견될 때에만 새끼 돼지로 판단할 수 있습니다.이 방법에 대한 오탐지 횟수는 1.59회인 반면, 기존 단일 감지 규칙의 오탐지 횟수는 9.55회입니다. 거짓 양성 판정의 수는 크게 감소하였고, 전체 평균 정확도는 92.9%였습니다.

AI 돼지 사육: 스마트 농업의 새로운 시대

세계 주요 돼지 사육 국가로서, 우리나라의 연간 돼지 사육두수는 2015년부터 2018년까지 약 7억 마리였습니다. 그러나 최근 돼지열병 등의 영향으로 살아있는 돼지의 수와 도축두수가 계속해서 크게 변동되었습니다. 공개된 업계 연구 데이터에 따르면,최근 들어 개별 돼지 농가의 비중은 지속적으로 감소하고 있는 반면, 생산 규모는 지속적으로 증가하고 있어 돼지 사육 산업에 보다 효율적이고 집약적인 육종 기술이 필요해졌습니다.

국내에는 이미 AI 돼지 사육을 위한 신뢰할 수 있는 제품이 있습니다. 알리바바 클라우드는 아이보 머시너리와 치슈오 테크놀로지와 협력하여 다양한 시나리오의 요구를 충족하는 AI 돼지 사육 솔루션을 출시했습니다. JD농업축산의 스마트 번식 솔루션은 AI, 사물 인터넷 등의 기술을 기반으로 "돼지 얼굴 인식 및 전체 체인 추적"을 실현했습니다. AI가 가져온 더욱 스마트하고 정교한 농업 모델이 점차 확산되고 있습니다.

하지만 AI 돼지 사육의 확산은 여전히 높은 비용과 복잡한 운영 등의 시급한 문제에 직면해 있습니다.더 많은 돼지 농장이 AI를 도입하기까지는 아직 갈 길이 멀 것으로 보인다.

본 기사는 HyperAI WeChat 공개 플랫폼에 처음 게재되었습니다~

참조 링크:

[1]https://www.163.com/dy/article/HCSQN810055360T7.html

[2]https://xueshu.baidu.com/usercenter/paper/show

[3]https://www.aliyun.com/solution/govcloud/ai-pig

[4]http://www.dekanggroup.com/index/news/detail/id/182.html

[5]https://www.thepaper.cn/newsDetail_forward_3695180

[7] Ding Qian, Liu Longshen, Chen Jia, Tai Meng, Shen Mingxia. Jetson Nano를 기반으로 한 젖먹이 돼지 새끼의 표적 탐지[J/OL]. 중국농업기계학회 논문집.