Command Palette

Search for a command to run...

GPT-4는 멀티모달리티를 목표로 하고 있으며, 과거 Google PaLM-E와 마찬가지로 AI 환경이 바뀔까요?

내용을 한눈에 보기:GPT-4는 3월 14일에 기술계 전체를 폭발시킨 핵폭탄과 같았습니다. 이 핵폭발의 중심에서 많은 기대를 모았던 GPT-4는 근육을 과시했고, 핵폭발 주변에서는 구글과 다른 신들이 탐욕스럽게 지켜보며 끊임없이 움직였습니다.

3월 14일 동부 표준시,OpenAI는 대규모 멀티모달 모델 GPT-4를 출시했습니다. GPT-4는 ChatGPT와 Bing AI 챗봇의 기반이 되는 기술입니다. OpenAI는 GPT-4가 이미지와 텍스트를 입력받고 텍스트 콘텐츠를 출력할 수 있다고 밝혔지만, 많은 실제 상황에서 그 능력은 인간의 능력만큼 좋지는 않다고 합니다.그러나 다양한 전문적, 학문적 기준에서 인간 수준의 성과를 달성했습니다.

GPT-4, 갑자기 착륙… 세 가지 특징 주목

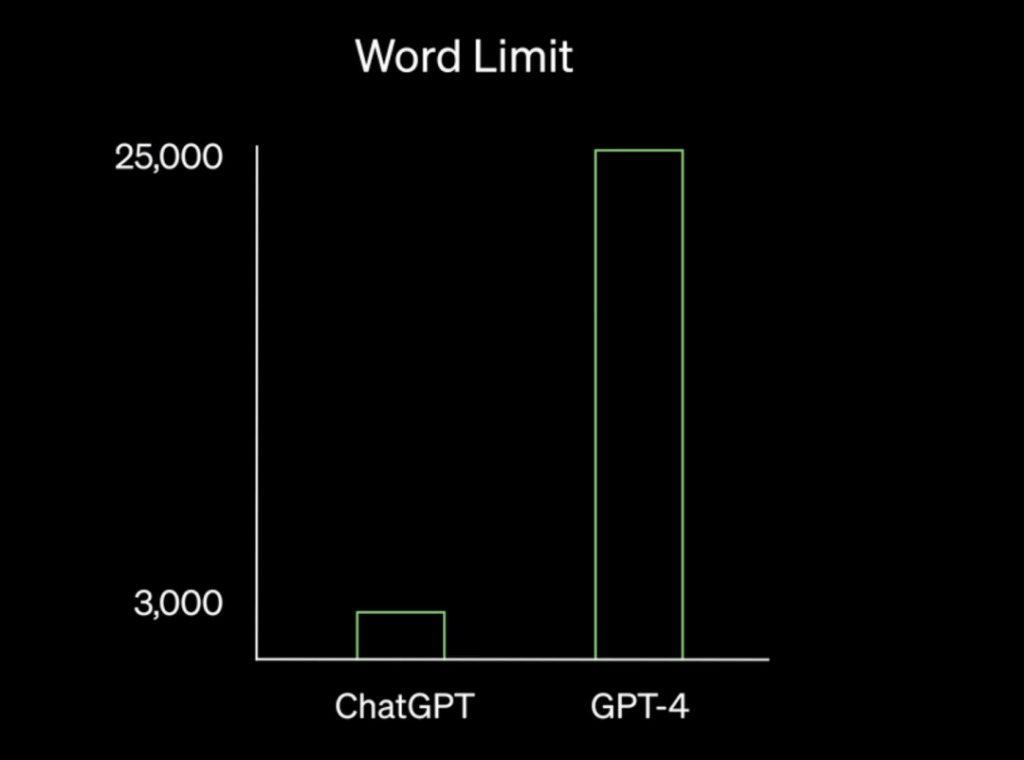

GPT-4의 이번 업데이트에는 크게 개선된 세 가지 주요 새로운 기능이 추가되었습니다.텍스트 입력 한계가 개선되었고, 이미지를 인식하는 기능과 추론 능력이 강화되었습니다.

더 길고 풍부한 콘텐츠

OpenAI에 따르면,GPT-4는 25,000단어 이상의 텍스트를 처리할 수 있습니다. Medium 작가 마이클 킹은 이 기능을 사용하면 기사나 블로그와 같은 장문 콘텐츠를 만들 수 있어 기업과 개인의 시간과 리소스를 절약할 수 있다고 말했습니다.

또한 GPT-4는 대량의 텍스트를 처리하기 때문에 장시간 대화가 가능해지며, 서비스 분야와 같은 산업에서 AI 챗봇은 고객 문의에 대해 더욱 자세하고 통찰력 있는 답변을 제공할 수 있습니다. 동시에 이 기능은 효율적인 문서 검색 및 분석을 가능하게 하여 금융, 법률, 의료 등의 산업에 유용한 도구가 됩니다.

추론 능력 향상

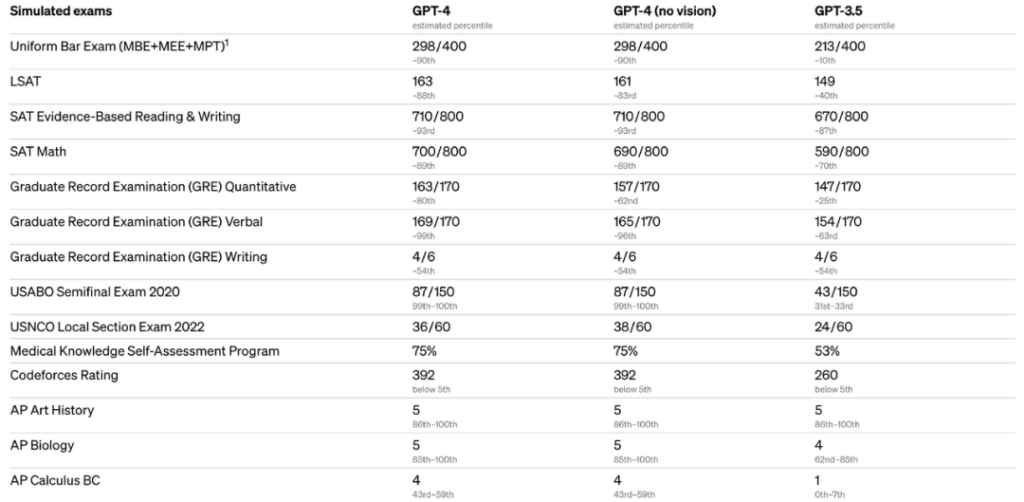

OpenAI는 GPT-4가 생성한 답변은 오류가 적고 GPT-3.5보다 40% 더 정확하다고 밝혔습니다. 동시에 채팅에서는 GPT-3.5와 GPT-4 사이에 큰 차이가 없지만, 작업이 충분히 복잡하다면 GPT-4는 GPT-3.5보다 더 안정적이고 창의적이며 더 미묘한 지시를 처리할 수 있습니다. GPT-4는 다양한 벤치마크 테스트에 참여한 것으로 알려졌습니다.이들 중에는 통일 변호사 시험, LSAT 및 기타 시험에서 88%보다 높은 점수를 받은 지원자가 있습니다.

새로운 기능: 다중 모달리티

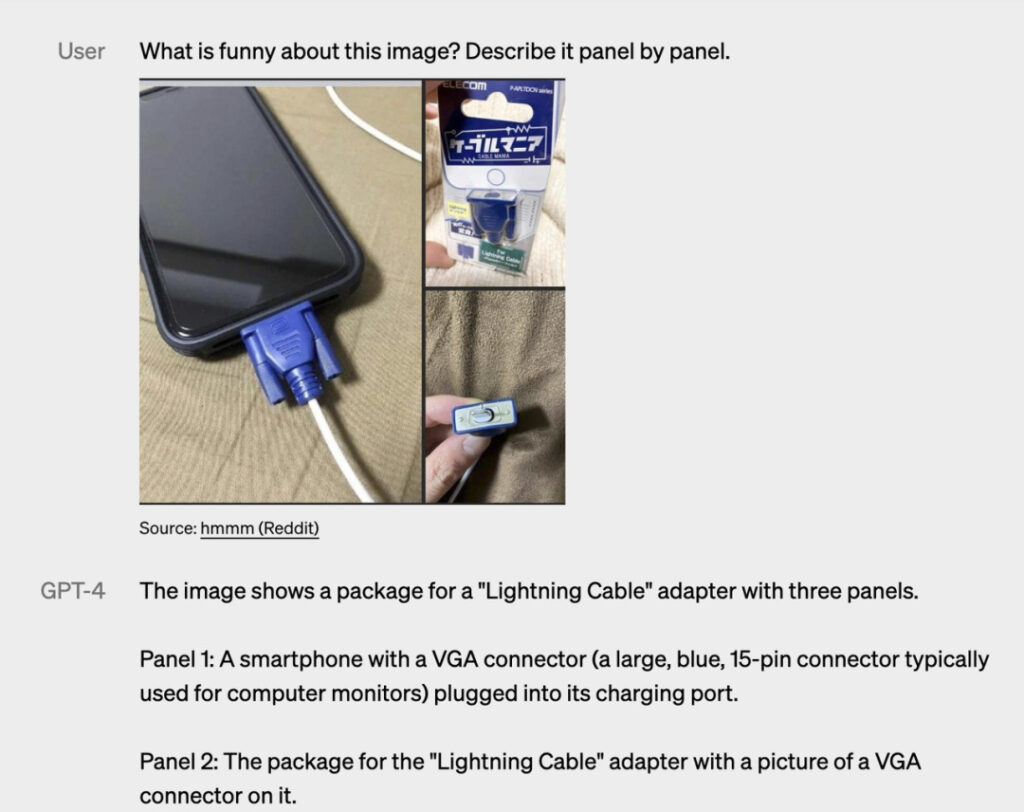

더 나은 답변 기술 외에도,GPT-4의 또 다른 뛰어난 특징은 텍스트와 이미지 형태의 입력을 받을 수 있다는 것입니다.이미지 유형은 사진, 차트, 스크린샷 등일 수 있습니다. 예를 들어, 다음 예는 다음과 같습니다.

질문: 이 사진에서 재밌는 점은 무엇인가요? 하나하나씩 설명해 보세요.

GPT-4 답변: 이미지는 세 개의 사진이 포함된 "Lightning Cable" 어댑터를 보여줍니다.

그림 1: VGA 커넥터(컴퓨터 모니터에 일반적으로 사용되는 크고 파란색의 15핀 커넥터)가 충전 포트에 꽂힌 스마트폰.

그림 2: VGA 커넥터 이미지가 있는 "Lightning Cable" 어댑터의 포장.

그림 3: VGA 커넥터의 클로즈업과 끝부분의 작은 Lightning 커넥터(iPhone 및 기타 Apple 기기 충전에 사용).

이 사진의 유머는 크고 오래된 VGA 커넥터를 작고 현대적인 스마트폰 충전 포트에 꽂는다는 터무니없는 짓에서 비롯됩니다.

이 기능은 아직 연구자 미리보기 버전에 있습니다.대중에게 공개되지 않았습니다.OpenAI는 언제 공개될지는 아직 밝히지 않았습니다.

"완벽하지 않아요"

OpenAI는 GPT-4의 새로운 기능을 소개하면서 몇 가지 한계점도 인정했습니다. 이전 버전의 GPT와 마찬가지로GPT-4는 여전히 사회적 편견, 환각, 적대적 자극 등의 문제를 안고 있습니다.즉, GPT-4는 현재 완벽하지 않습니다. 하지만 OpenAI는 이것이 자신들이 해결하기 위해 열심히 노력하고 있는 문제라고 말했습니다.

멀티모달 모델: 구글, 애피타이저 서비스 선두주자

GPT-4의 하이라이트는 멀티모달리티이지만,GPT-4는 유일한 다중 모드 모델이 아닙니다.

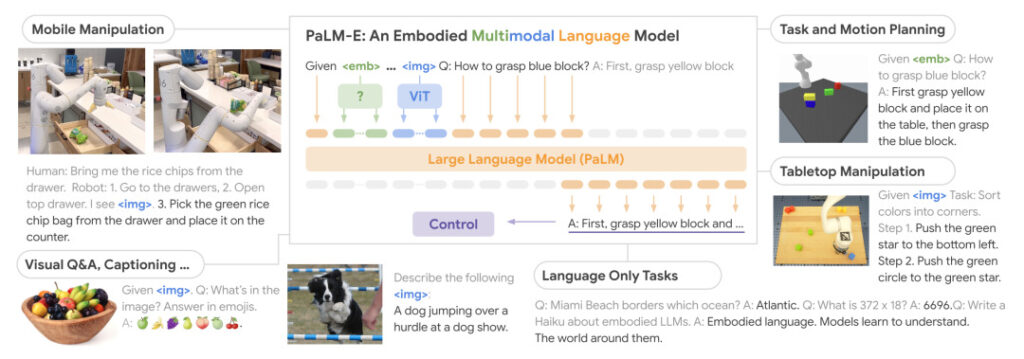

Microsoft AI 기술 전문가 홀거 켄은 텍스트를 이미지로만 변환하는 것이 아니라 오디오와 비디오로도 변환할 수 있는 멀티모달 모델을 소개했습니다. 이번 달 초,구글이 역사상 가장 큰 시각 언어 모델인 PaLM-E(Pathways Language Model with Embodied)를 출시했습니다.,로봇공학을 위한 내장형 다중 모달 언어 모델. PalM-E는 540B PaLM 언어 모델과 22B ViT 시각 모델을 통합하여 562B 매개변수를 갖습니다.

연구자들은 로봇 작동 규칙, 시각적 질의응답, 이미지 캡션 작성 등 다양한 작업에 대한 종단 간 훈련을 수행했습니다. 평가 결과는 이 모델이 다양한 추론 과제를 효과적으로 해결할 수 있고, 다양한 관찰 방식과 여러 개체에 대한 "긍정적인 전이"를 보인다는 것을 보여주었습니다. 이 모델은 로봇 작업에 대한 훈련을 받았을 뿐만 아니라, 시각 언어 작업에서도 좋은 성과를 보였습니다.

시연 사례에서, 사람이 "서랍에 있는 감자칩을 내놔"라고 명령하면 PaLM-E는 로봇 팔을 장착한 로봇에 대한 동작 명령을 생성하고 해당 동작을 실행할 수 있습니다. 이는 장면을 사전 처리하지 않고 로봇 카메라의 데이터를 분석하여 수행됩니다.

로봇에 위와 같은 기능을 제공하는 것 외에도 PaLM-E 자체는 그림을 기반으로 이야기를 들려주거나 그림의 내용을 기반으로 질문에 답할 수 있는 시각 언어 모델이기도 합니다.

멀티모달 모델은 아이폰 출시와 동일한가요?

이제 AI 분야 전체가 본격적으로 군비 경쟁에 돌입한 것 같습니다. ChatGPT의 폭발적인 인기에 직면하여 Google은 계속해서 발전하기 위해 Bard를 긴급히 출시했습니다. 최근에는 자체 대규모 언어 모델 API인 "PaLM API"를 공개하고, 개발자가 AI 프로그램을 빠르게 구축할 수 있도록 돕는 도구인 MakerSuite도 출시하여 다시 한번 반격에 나섰습니다.

OpenAI CEO Sam Altman은 얼마 전 인터뷰에서 GPT-4 출시 날짜에 대해 "출시 시 안전하고 책임감 있는 결과를 보장하고 싶다"고 주장하며 비밀을 유지했지만 GPT-4의 갑작스러운 등장은구글과 같은 거대 기업의 끊임없는 반격과 포위 공격으로 인해 이 회사가 속도를 높일 수밖에 없는 것이 아니냐는 추측이 나오는 것은 불가피하다.

샘이 인터뷰에서 한 가지 요점을 언급한 것도 주목할 만합니다.인공지능의 다음 진화 단계는 다중 모드 대형 모델의 도래입니다."저는 그것이 큰 추세가 될 것이라고 생각합니다. 더 일반적으로 말해서, 이러한 강력한 모델은 모바일 이후로 우리가 갖지 못했던 진정한 새로운 기술 플랫폼 중 하나가 될 것입니다."

GPT-4의 대대적인 출시가 멀티모달 모델 시대의 공식 도래를 알리는 신호인지는 아직 알 수 없지만, 그 강력한 성능으로 인해 많은 개발자와 일반인들조차 자신들이 GPT-4에 의해 대체될까 봐 걱정하기 시작했습니다. 아마도 며칠 전 Microsoft Germany의 CEO인 마리아네 야닉이 한 공식 발언이 이 질문에 대한 답이 될 수 있을 것입니다. 그녀는 현재 AI의 발전이 아이폰의 등장과 같다고 믿는다. 동시에 그녀는 또한 다음과 같은 점을 분명히 했습니다.일자리를 대체하는 것이 아니라, 이전과는 다른 방식으로 반복적인 작업을 완료하는 것입니다.

「변화는 전통적인 근무 모델을 변화시킬 것입니다. 하지만 이러한 변화가 많은 새로운 가능성을 더해 주었고, 그로 인해 흥미진진한 새로운 직업이 생겨날 것이라는 점도 알아야 합니다."

참조 링크:

[1]https://openai.com/research/gpt-4

[2]https://venturebeat.com/ai/openai-releases-highly-anticipated-gpt-4-model-in-surprise-announcement/

[3] https://palm-e.github.io/

[4]https://medium.com/@neonforge