DeepMind는 다이아몬드를 집어 올리는 방법을 스스로 학습할 수 있는 일반 강화 학습 알고리즘인 DreamerV3를 출시했습니다.

마인크래프트는 사람만 플레이하는 게임이 아닙니다. 유명한 AI 기술 회사인 딥마인드도 마인크래프트를 플레이하기 위한 전담 AI를 개발했습니다!

내용을 한눈에 보기:강화 학습은 학제 간 산물이며, 그 핵심은 자동적이고 지속적인 의사 결정을 달성하는 것입니다. 이 글에서는 DeepMind의 최신 연구 개발 성과를 소개합니다. 강화 학습의 적용 범위를 확장하는 일반 알고리즘인 DreamerV3입니다. 키워드:강화 학습 DeepMind 일반 알고리즘

1월 12일 베이징 시간, DeepMind의 공식 트위터 계정에 다음과 같은 글이 게시되었습니다.Dreamer V3가 공식 발표되었습니다.이는 인간 데이터를 참조하지 않고 게임 "마인크래프트"에서 다이아몬드를 처음부터 수집할 수 있는 최초의 일반 알고리즘으로, AI 분야의 또 다른 중요한 과제를 해결했습니다.

강화학습은 확장성 측면에서 문제가 있으며, 이를 개발하기 위해서는 일반적인 알고리즘이 필요합니다.

강화 학습을 통해 컴퓨터는 상호작용을 통해 과제를 해결할 수 있습니다. 예를 들어, AlphaGo는 바둑에서 인간을 이겼고, OpenAI Five는 Dota 2에서 아마추어 인간 플레이어를 이겼습니다.

그러나 보드 게임에서 비디오 게임이나 로봇 작업으로 전환하는 것과 같은 새로운 응용 시나리오에 알고리즘을 적용하려면엔지니어는 지속적으로 전문화된 알고리즘을 개발해야 합니다.예를 들어, 지속적인 제어, 희소한 보상, 이미지 입력, 공간 환경 등이 있습니다.

알고리즘을 미세하게 조정하려면 많은 전문 지식과 컴퓨팅 리소스가 필요합니다.이는 모델 확장에 큰 방해가 됩니다. 튜닝 없이도 새로운 도메인을 학습하고 익힐 수 있는 일반 알고리즘을 만드는 것은 강화 학습 응용 프로그램의 범위를 확장하고 의사 결정 문제를 해결하는 중요한 방법이 되었습니다.

그 결과, DeepMind와 토론토 대학이 공동으로 개발한 DreamerV3가 탄생했습니다.

DreamerV3: 세계 모델 기반 일반 알고리즘

DreamerV3는 세계 모델을 기반으로 한 일반적이고 확장 가능한 알고리즘입니다.이 방법은 고정된 하이퍼파라미터를 전제로 광범위한 도메인에 적용될 수 있으며, 특수 알고리즘보다 더 뛰어납니다.

이러한 도메인에는 연속적 행동과 개별적 행동, 시각적 입력과 저차원 입력, 2D 세계와 3D 세계, 다양한 데이터 예산, 보상 빈도와 보상 규모 등이 포함됩니다.

DreamerV3는 그래디언트를 공유하지 않고 재생된 경험을 통해 동시에 학습된 3개의 신경망으로 구성됩니다.

1. 세계 모델:잠재적 행동의 미래 결과 예측

2. 비평가:각 사례의 가치를 결정하세요

3. 배우: 가치 있는 상황을 만드는 방법을 배우세요

위 그림에서 보듯이, 세계 모델은 감각적 입력을 이산적 표현 zt로 인코딩합니다. zt는 반복적인 상태 ht와 동작 ht를 갖는 시퀀스 모델에 의해 예측됩니다. 입력은 학습 신호로 재구성되고, 그 후 모양 표현으로 변환됩니다.

배우와 비평가는 세계 모델이 예측한 추상적 표현 궤적을 통해 배웁니다.

크로스 도메인 작업에 더 잘 적응하기 위해이러한 구성 요소는 다양한 신호 크기에 적응해야 하며 목표 간의 항목을 견고하게 균형 잡아야 합니다.

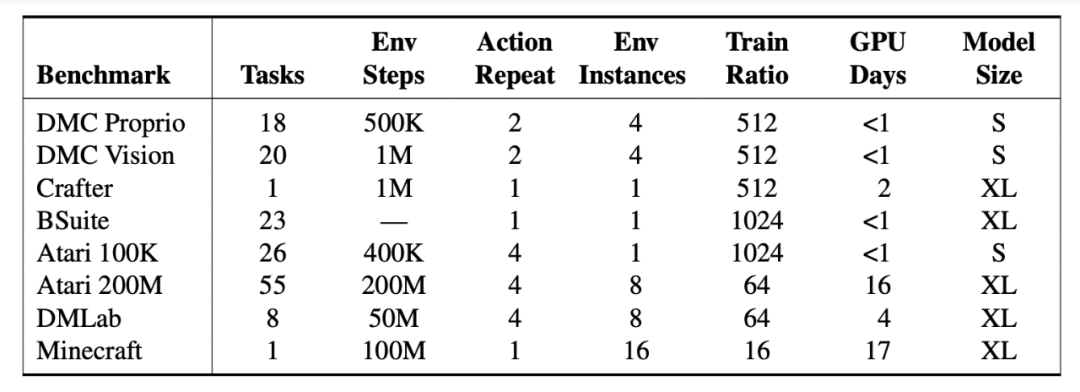

엔지니어들은 150개 이상의 고정 매개변수 작업에 대해 DreamerV3를 테스트하고 문헌에 기록된 가장 우수한 방법과 비교했습니다. 실험 결과, DreamerV3는 다양한 도메인의 작업에 대해 높은 다용성과 확장성을 가지고 있는 것으로 나타났습니다.

DreamerV3는 7개 벤치마크에서 우수한 성과를 거두었고, 상태 및 이미지의 지속적인 제어, BSuite 및 Crafter에서 새로운 SOTA 수준을 확립했습니다.

하지만 DreamerV3에도 여전히 몇 가지 한계가 있습니다.예를 들어, 환경 단계가 1억 미만이면 알고리즘은 인간 플레이어처럼 모든 장면에서 다이아몬드를 수집할 수 없고, 가끔만 수집할 수 있습니다.

거인의 어깨 위에 서서 Dreamer 가족의 발전 역사를 돌아보며

1세대: 드리머

출시 시간:2019년 12월

참여 기관:토론토 대학교, 딥마인드, 구글 브레인

서류 주소:https://arxiv.org/pdf/1912.01603.pdf

알고리즘 소개:

Dreamer는 잠재적 상상력만을 사용하여 이미지에서 장기적 과제를 해결할 수 있는 강화 학습 에이전트입니다.

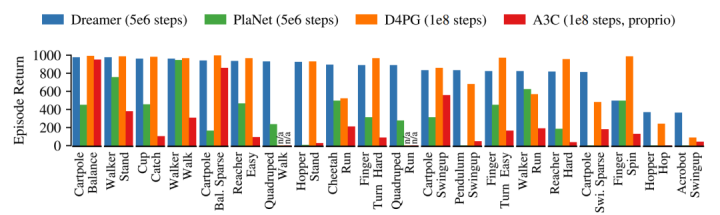

모델 예측의 역전파를 기반으로 효율적인 행동 학습을 달성하기 위해 세계 모델을 사용합니다. Dreamer는 20가지 까다로운 시각 제어 작업에서 데이터 효율성, 계산 시간, 최종 성능 측면에서 기존 방법보다 우수한 성과를 보였습니다.

Dreamer는 PlaNet의 데이터 효율성을 계승하는 동시에 당시 최고의 모델 없는 에이전트의 점근적 성능을 능가합니다. 5×106 환경 단계 후 Dreamer의 각 작업 평균 성능은 823에 도달한 반면 PlaNet은 332에 불과했습니다. 모델이 없는 가장 높은 D4PG 에이전트는 108단계 후 786이었습니다.

2세대: DreamerV2

출시 시간:2020년 10월

참여 기관:구글 리서치, 딥마인드, 토론토 대학교

서류 주소:https://arxiv.org/pdf/2010.02193.pdf

알고리즘 소개:

DreamerV2는 세계 모델의 컴팩트한 잠재 공간에서 예측을 통해 행동을 학습하는 강화 학습 에이전트입니다.

참고: 세계 모델은 이산 표현을 사용하며 정책과 별도로 학습됩니다.

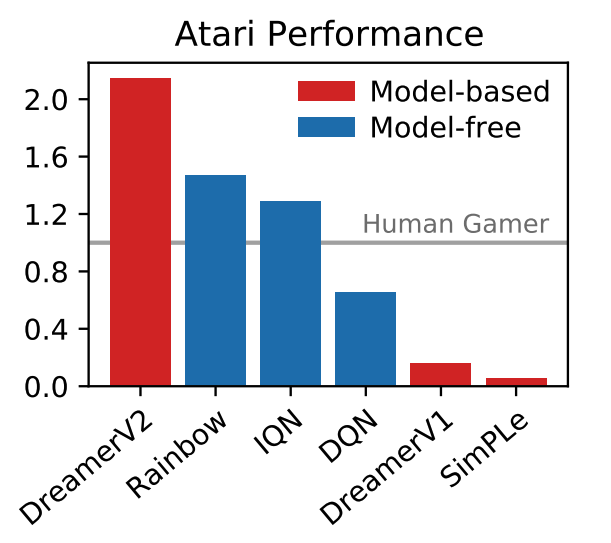

DreamerV2는 별도로 훈련된 세계 모델로부터 행동을 학습하여 Atari 벤치마크의 55개 작업에서 인간 수준의 성과를 달성한 최초의 에이전트입니다. 동일한 계산 예산과 실제 시간으로 DreamerV2는 2억 프레임을 달성하여 최고 단일 GPU 에이전트인 IQN과 Rainbow의 최종 성능을 능가합니다.

또한 DreamerV2는 연속적인 동작이 있는 작업에도 적합합니다. 인간형 로봇의 복잡한 세계 모델을 학습하고 픽셀 입력만으로 서기와 걷기 문제를 해결합니다.

트위터 사용자들은 댓글 섹션에 밈을 사용하는 데 앞장서고 있습니다.

DreamerV3의 탄생을 두고 많은 네티즌들이 DeepMind의 트위터 댓글란에 농담을 걸기도 했습니다.

인류를 해방하고 다시는 마인크래프트를 플레이하지 않아도 되도록 하세요.

게임을 그만두고 진짜 일을 하세요! @DeepMind와 CEO Demis Hassabis

"마인크래프트"의 최종 보스, 엔더 드래곤이 떨고 있습니다.

최근 몇 년 동안 게임 '마인크래프트'는 강화 학습 연구의 초점이 되었고, '마인크래프트'에서 다이아몬드를 모으는 국제 대회가 여러 차례 개최되었습니다.

인간의 데이터 없이 이 과제를 해결한 것은 인공지능의 획기적인 발전으로 널리 인정받고 있습니다.희소한 보상, 어려운 탐색, 절차적으로 생성된 오픈 월드 환경에서의 긴 시간 범위 등의 장애물 때문에, 이전 방법은 인간 데이터나 튜토리얼을 기반으로 할 수밖에 없었습니다.

DreamerV3는 Minecraft에서 다이아몬드를 수집하는 방법을 처음부터 완벽하게 스스로 학습한 최초의 알고리즘입니다.이는 강화 학습의 적용 범위를 더욱 확장합니다.네티즌들이 말했듯이 DreamerV3는 이미 성숙한 일반 알고리즘입니다. 이제 스스로 업그레이드하고 몬스터를 처치하는 방법을 배우고 최고의 보스, 엔더 드래곤과 싸울 시간입니다!

원본 링크 보기:DeepMind는 다이아몬드를 집어 올리는 방법을 스스로 학습할 수 있는 일반 강화 학습 알고리즘인 DreamerV3를 출시했습니다.

HyperAI를 팔로우하여 더욱 흥미로운 AI 알고리즘과 애플리케이션에 대해 알아보세요. 튜토리얼도 정기적으로 업데이트하니, 함께 배우고 발전해봐요!