Command Palette

Search for a command to run...

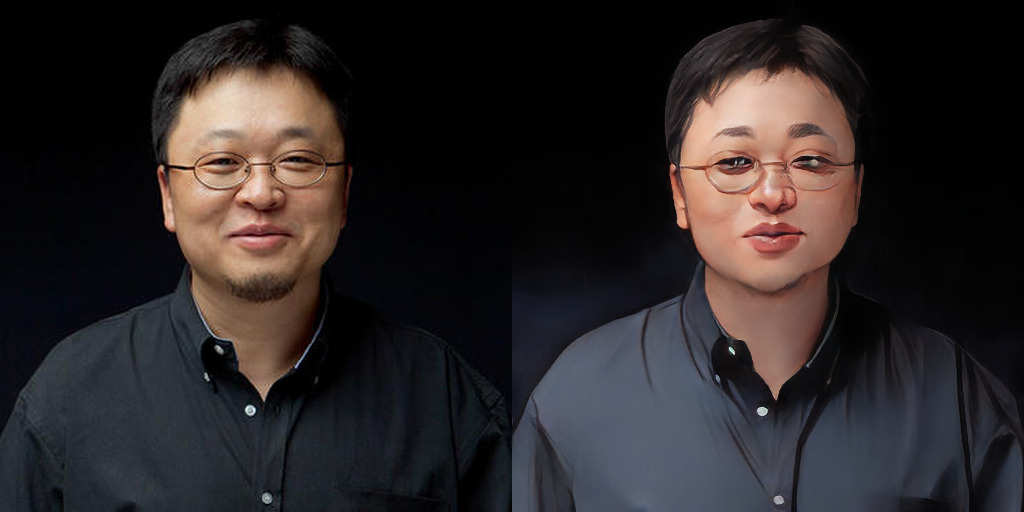

애니메이션 스타일 전송 AnimeGANv2, 온라인 데모 실행 출시

AnimeGANv2는 최근 커뮤니티 기여자들이 개발한 업데이트를 출시했습니다.Gradio를 통해 온라인으로 실행 가능한 데모가 구현되어 huggingface에 게시되었습니다..

입장 https://huggingface.co/spaces/akhaliq/AnimeGANv2

AnimeGANv2의 처리 효과는 온라인에서 쉽게 구현할 수 있습니다(정적 이미지 처리만 지원).

AnimeGAN: 모든 3차원 객체가 2차원이 됩니다

AnimeGAN은 CartoonGAN을 기반으로 한 개량형으로, 더 가벼운 생성기 아키텍처를 제안합니다. 2019년에 AnimeGAN이 처음으로 오픈소스로 공개되었고, 놀라운 결과로 인해 격렬한 토론이 일어났습니다.

최초 출시 당시의 서류 "AnimeGAN: 사진 애니메이션을 위한 새로운 경량 GAN"본 논문에서는 양식화된 애니메이션의 시각 효과를 개선하기 위해 세 가지 새로운 손실 함수를 제안합니다.

세 가지 손실 함수는 다음과 같습니다.회색조 스타일 손실, 회색조 적대적 손실, 색상 재구성 손실.

지난 9월에 출시된 AnimeGANv2는 모델을 최적화하고 AnimeGAN 초기 버전의 몇 가지 문제를 해결했습니다.

v2에서는 마코토 신카이, 미야자키 하야오, 사토시 콘 등 세 명의 만화가의 만화 스타일을 담은 새로운 훈련 데이터 세트가 추가되었습니다.

머스크를 예로 들면, 첫 번째 세대의 AnimeGAN의 효과는 이미 놀라웠지만, 그는 너무 하얗고 병약해서 마치 한국 보이 밴드 멤버 같았습니다. 비교해 보면 v2가 더 자연스럽고 실제 기질에 더 잘 맞습니다.

AnimeGANv2 업데이트 주요 내용:

– 생성된 이미지의 고주파 아티팩트 문제가 해결되었습니다.

– v2는 훈련이 더 쉽고 논문에 설명된 결과를 직접 얻을 수 있습니다.

– 발전기 네트워크의 매개변수 수를 더욱 줄입니다. (생성기 크기 8.17Mb);

– 더 높은 품질의 이미지 데이터를 추가합니다.

프로젝트 정보

TensorFlow 버전 환경 구성 요구 사항

- 파이썬 3.6

- 텐서플로우-GPU

- tensorflow-gpu 1.8.0(ubuntu, GPU 1080Ti 또는 Titan XP, CUDA 9.0, CUDNN 7.1.3)

- tensorflow-gpu 1.15.0(ubuntu, GPU 2080Ti, cuda 10.0.130, cudnn 7.6.0)

- 오픈CV

- 티큐디엠

- 넘파이

- 글로브

- argparse

PyTorch 구현

무게 변환

git clone https://github.com/TachibanaYoshino/AnimeGANv2

python convert_weights.py추리

python test.py --input_dir [image_folder_path] --device [cpu/cuda]벽 안의 콜랩

프로젝트 GitHub

https://github.com/TachibanaYoshino/AnimeGANv2

온라인 데모

https://huggingface.co/spaces/akhaliq/AnimeGANv2

벽 안의 콜랩

https://openbayes.com/console/open-tutorials/containers/pROHrRgKItf