Command Palette

Search for a command to run...

StyleCLIP 해체: 텍스트 기반 주문형 디자인, 인간 포토샵과 유사

StyleGAN은 누구나 잘 알고 있습니다. NVIDIA가 출시한 이 새로운 생성적 적대 네트워크는스타일 전송을 차용하면 많은 수의 새로운 스타일 기반 이미지를 빠르게 생성할 수 있습니다.

StyleGAN은 강력한 학습 능력을 가지고 있으며 실제 이미지와 구별할 수 없는 이미지를 생성합니다.하지만 "그림을 보면서 배우는" 이런 학습 및 2차 창작 방식은 너무 많이 사용되면서 다소 전통적이고 보수적인 면이 있습니다.

히브리 대학교, 텔아비브 대학교 및 Adobe Research의 연구원들은사전 훈련된 StyleGAN 생성기의 생성 능력과 CLIP의 시각적 언어 기능을 창의적으로 결합했습니다.StyleGAN 이미지를 수정하는 새로운 방법 소개 – 텍스트에 따라 무엇을 "쓰느냐"에 따라 원하는 이미지가 생성됩니다..

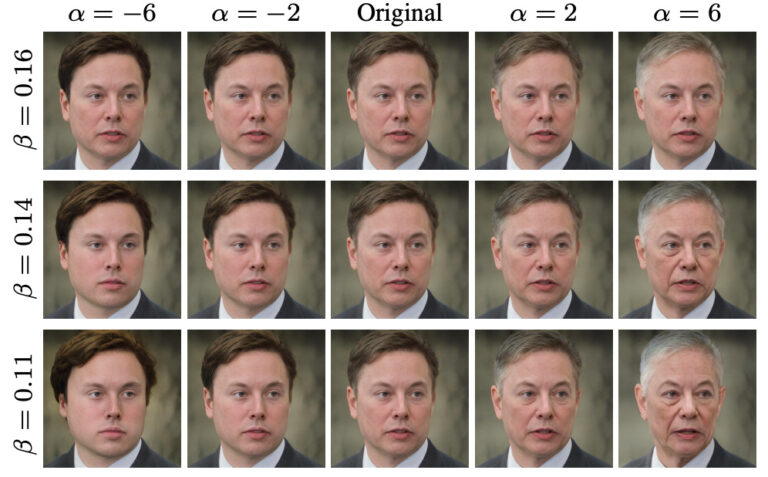

첫 번째 행은 입력 이미지이고 두 번째 행은 연산 결과입니다.

각 이미지 열 아래의 텍스트는 이미지 변경을 구동하는 텍스트에 해당합니다.

StyleCLIP은 누구인가요?

이름에서 알 수 있듯이 StyleCLIP은 StyleGAN과 CLIP의 결합입니다.

StyleGAN은 이미지 반전을 사용하여 이미지를 잠재 코드로 표현한 다음 잠재 코드를 편집하고 수정하여 이미지 스타일을 제어합니다.

CLIP은 Contrastive Language-Image Pretraining의 약자입니다. 4억 개의 이미지-텍스트 쌍으로 훈련된 신경망입니다. 주어진 텍스트 설명에 따라 가장 관련성 있는 이미지를 출력할 수 있습니다.

이 논문에서 연구진은 StyleGAN과 CLIP을 결합하는 세 가지 방법을 연구했습니다.

- CLIP 모델을 손실 네트워크로 사용하는 컨텍스트 기반 잠재 벡터 최적화.

- 잠재 벡터를 특정 텍스트에 하나씩 대응시키도록 잠재 매퍼를 훈련합니다.

- StyleGAN의 StyleSpace에서 텍스트 설명은 입력 이미지의 글로벌 방향에 매핑되어 이미지 작업의 강도와 분리 정도를 제어합니다.

관련 작업

2.1 비전과 언어

공동 표현텍스트 기반 이미지 검색, 이미지 캡션, 시각적 답변 등 교차 모달 시각 및 언어(VL) 표현을 학습할 수 있는 작업이 많이 있습니다. 다양한 언어 작업에서 BERT가 성공함에 따라, 현재 VL 방법은 일반적으로 변압기를 사용하여 공동 표현을 학습합니다.

텍스트 기반 이미지 생성 및 처리

사전 훈련된 인코더에서 텍스트 임베딩을 얻어 텍스트 기반 이미지 생성을 위한 적격 GAN을 훈련합니다.

2.2 잠재 공간 이미지 처리

StyleGAN의 중간 잠재 공간은 다음과 같이 입증되었습니다.대량의 분해 및 의미 있는 이미지 처리 작업이 가능합니다.예를 들어, 주어진 이미지를 처리된 이미지의 임베딩 벡터로 인코딩하도록 네트워크를 훈련시켜 종단 간 방식으로 이미지 처리를 수행하는 방법을 학습합니다.

이미지 처리는 사전 훈련된 CLIP 모델의 감독 하에 텍스트 입력에 대해 직접 수행됩니다. CLIP은 수억 개의 텍스트-이미지 쌍을 기반으로 학습되므로따라서 이 방법은 보편적이며 특정 필드나 특정 처리에 대한 데이터 주석이 필요 없이 많은 분야에서 사용될 수 있습니다.

3. StyleCLIP 텍스트 기반 이미지 처리

이 연구에서는 텍스트 기반 이미지 처리의 세 가지 방법을 탐구합니다.이러한 모든 접근 방식은 StyleGAN의 생성 능력과 CLIP의 풍부한 공동 시각-언어 표현을 결합합니다.

4. 잠재 최적화

CLIP을 사용하여 이미지 처리를 안내하는 간단한 방법은 직접적인 잠재 코드 최적화입니다.

5. 잠재 매퍼

잠재 최적화는 보편적입니다.모든 소스 이미지-텍스트 설명 쌍에 맞게 특별히 최적화되었기 때문입니다.단점은 하나의 이미지를 편집하는 데 최적화 시간이 몇 분이나 걸릴 수 있으며, 이 방법이 매개변수 값에 다소 민감하다는 것입니다.

여기에 사용된 텍스트 프롬프트는 "놀라움"입니다.

다양한 StyleGAN 레이어는 생성된 이미지의 세부 정보 수준이 서로 다릅니다.

6. 글로벌 방향

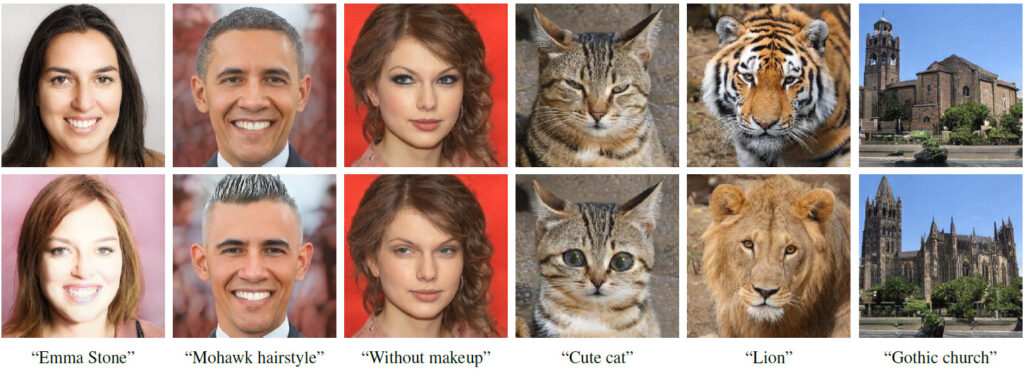

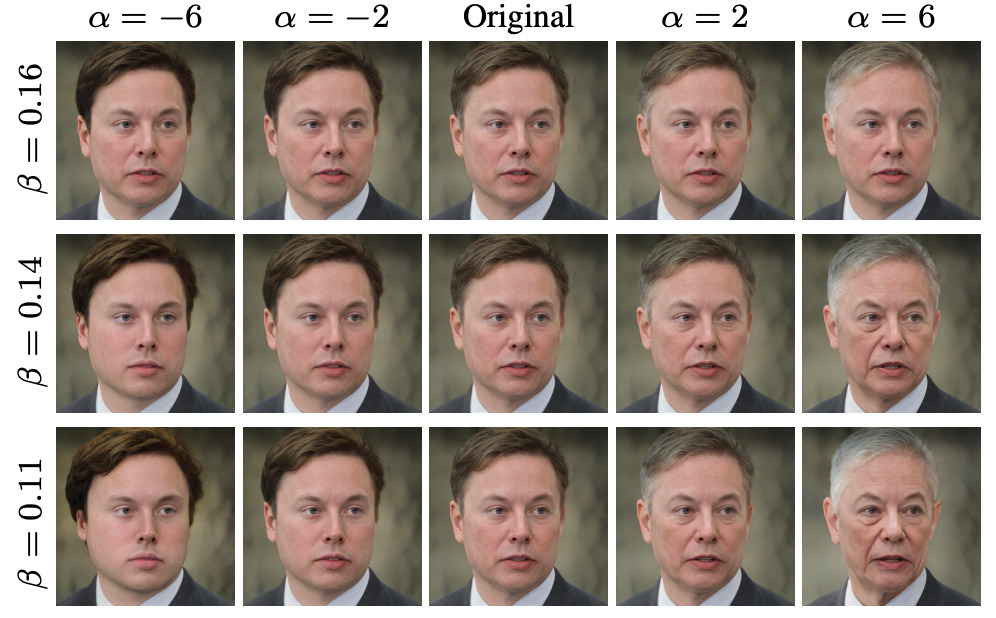

StyleGAN의 스타일 공간에서 텍스트 신호를 단일 글로벌 방향으로 매핑하는 것은 다음과 같은 효과가 있는 것으로 입증되었습니다.다른 잠재 공간보다 더 분리되어 있습니다.

다양한 작동 강도 및 분리 임계값에 적합

논문 저자: GAN에 초점을 맞춘 이스라엘 대학 출신

이 논문의 첫 번째 저자인 오르 파타쉬닉은 텔아비브 대학의 컴퓨터공학과 대학원생입니다.주로 이미지 생성 및 처리 관련 프로젝트에 참여합니다. 그녀는 머신 러닝, 컴퓨터 그래픽, 머신 비전에 많은 관심이 있습니다.주로 이미지 생성 및 처리와 관련된 프로젝트에 참여했으며, StyleGAN 관련 논문을 여러 편 발표했습니다.

논문의 또 다른 저자인 Zongze Wu는예루살렘 히브리 대학의 에드먼드 & 릴리 사프라 뇌 과학 센터에서 박사과정을 공부하고 있습니다.현재 저는 주로 HUJI 머신 비전 연구실에서 일하고 있으며, Adobe 연구소의 다니 리신스키 교수님과 엘리 셰흐트만 교수님과 함께 프로젝트를 진행하고 있습니다.

종쩌 우는 컴퓨터 비전 관련 주제에 중점을 두고 있습니다.예를 들어 생성적 적대 신경망, 이미지 처리, 이미지 변환 등이 있습니다.

Zongze Wu의 이력서에 따르면,그는 2011년부터 2016년까지 동지대학교에서 생물정보학을 전공했습니다.졸업 후, 종쩌 우는 예루살렘 히브리 대학교에 입학하여 계산 신경 과학 박사 학위를 취득했습니다.

StyleGAN과 CLIP을 결합한 3가지 방법에 대한 자세한 설명

StyleCLIP 관련 논문에 따르면, 연구자들은 StyleGAN과 CLIP을 결합하는 세 가지 방법을 개발했습니다.이 세 가지 방법은 각각 잠재 최적화, 잠재 매퍼, 전역 방향에 기반합니다.

1. 잠재 최적화 기반

이 튜토리얼에서는 반복 최적화를 기반으로 한 얼굴 편집을 주로 소개합니다. 사용자가 텍스트 표현을 입력하면 텍스트와 일치하는 얼굴 편집 이미지를 얻습니다.

1단계: 코드 환경 준비

import os

os.chdir(f'./StyleCLIP')

! pip install ftfy regex tqdm

! pip install git+https://github.com/openai/CLIP.git2단계 매개변수 설정

experiment_type = 'edit' # 可选: ['edit', 'free_generation']

description = 'A person with blue hair' # 编辑的描述,需要是字符串

latent_path = None # 优化的起点 (一般不需修改)

optimization_steps = 100 # 优化的步数

l2_lambda = 0.008 # 优化时候 L2 loss 的权重

create_video = True # 是否将中间过程存储为视频

args = {

"description": description,

"ckpt": "/openbayes/input/input0/stylegan2-ffhq-config-f.pt",

"stylegan_size": 1024,

"lr_rampup": 0.05,

"lr": 0.1,

"step": optimization_steps,

"mode": experiment_type,

"l2_lambda": l2_lambda,

"latent_path": latent_path,

"truncation": 0.7,

"save_intermediate_image_every": 1 if create_video else 20,

"results_dir": "results"

}3단계: 모델 실행

from optimization.run_optimization import main

from argparse import Namespace

result = main(Namespace(**args))4단계: 처리 전후의 이미지 시각화

# 可视化图片

from torchvision.utils import make_grid

from torchvision.transforms import ToPILImage

result_image = ToPILImage()(make_grid(result.detach().cpu(), normalize=True, scale_each=True, range=(-1, 1), padding=0))

h, w = result_image.size

result_image.resize((h // 2, w // 2))

5단계: 최적화 프로세스를 비디오 출력으로 저장

#@title Create and Download Video

!ffmpeg -y -r 15 -i results/%05d.png -c:v libx264 -vf fps=25 -pix_fmt yuv420p /openbayes/home/out.mp4전체 노트북 액세스 주소

2. Latent Mapper 기반

첫 번째 단계는 코드 환경을 준비하는 것입니다.

2단계: 매개변수 설정

3단계: 모델 실행

4단계: 처리 전후의 이미지 시각화

방문하려면 클릭하세요완전한 노트북

3. 글로벌 방향에 기반

이 튜토리얼에서는 StyleGAN의 잠재 공간에 텍스트 정보를 매핑하고 이미지의 내용을 추가로 수정하는 방법을 소개합니다. 사용자는 텍스트 설명을 입력하여 텍스트와 매우 일치하고 특징 분리가 양호한 편집된 얼굴 이미지를 얻을 수 있습니다.

1단계: 코드 환경 준비

2단계: StyleCLIP 설정

3단계. e4e 설정

4단계: 이미지를 선택하고 dlib를 사용하여 얼굴 정렬

5단계: 편집할 이미지를 StyleGAN의 잠재 공간으로 반전합니다.

6단계: 텍스트 설명 입력

7단계: 이미지 편집을 위한 조작 강도(알파) 및 분리 임계값(베타) 선택

8단계: 편집 과정을 시각화하기 위한 비디오 생성

방문하려면 클릭하세요완전한 노트북

OpenBayes 소개

OpenBayes는 중국을 대표하는 머신 인텔리전스 연구 기관입니다.컴퓨팅 파워 컨테이너, 자동 모델링, 자동 매개변수 조정 등 AI 개발과 관련된 다양한 기본 서비스를 제공합니다.

동시에 OpenBayes는 데이터 세트, 튜토리얼, 모델 등 많은 대중적인 공공 리소스도 출시했습니다.개발자가 빠르게 학습하고 이상적인 머신 러닝 모델을 만들 수 있도록 해줍니다.

지금 방문하세요 오픈베이즈닷컴 그리고 등록하다,주당 600분의 vGPU 사용 가능 그리고 주당 300분의 무료 CPU 컴퓨팅 시간

지금 당장 StyleCLIP을 사용해 원하는 얼굴을 디자인해보세요!

방문하려면 클릭하세요전체 튜토리얼