Command Palette

Search for a command to run...

Huake 팀은 OVIS 가려진 비디오 인스턴스 분할 벤치마크 데이터 세트를 출시했습니다.

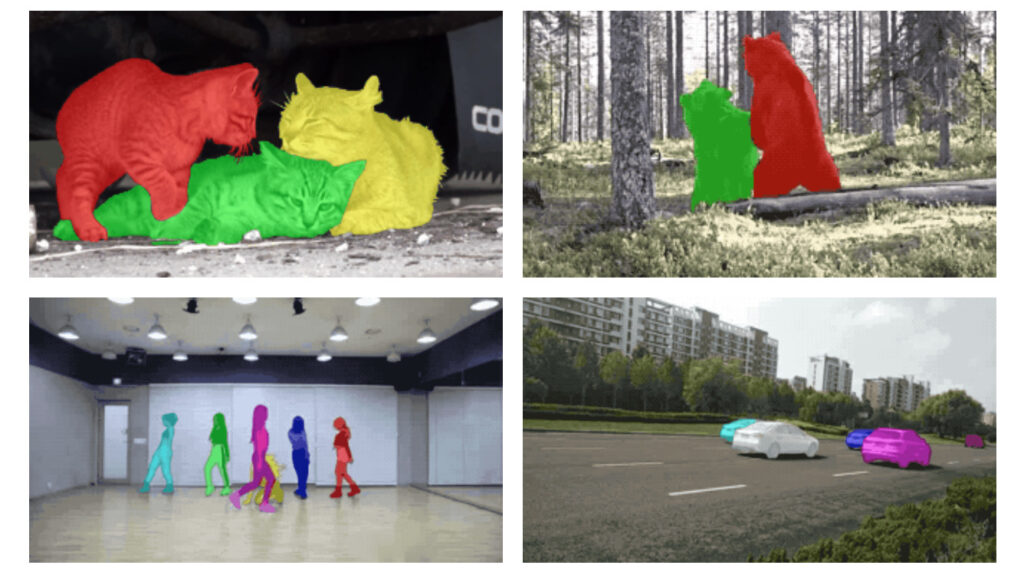

인스턴스 분할은 다양한 애플리케이션 시나리오에서 널리 사용될 수 있습니다. 컴퓨터 비전 분야의 중요한 연구 방향으로서 매우 어렵고 도전적인 분야이기도 합니다. 그러나 많은 장면에서 가려짐이 발생하기 때문에 인스턴스 분할이 어려운 문제가 됩니다. 최근 화중대학, 알리바바 및 기타 기관의 연구자들은 이 문제를 해결하기 위해 대규모 가려진 비디오 인스턴스 분할 데이터 세트 OVIS를 제안했습니다.

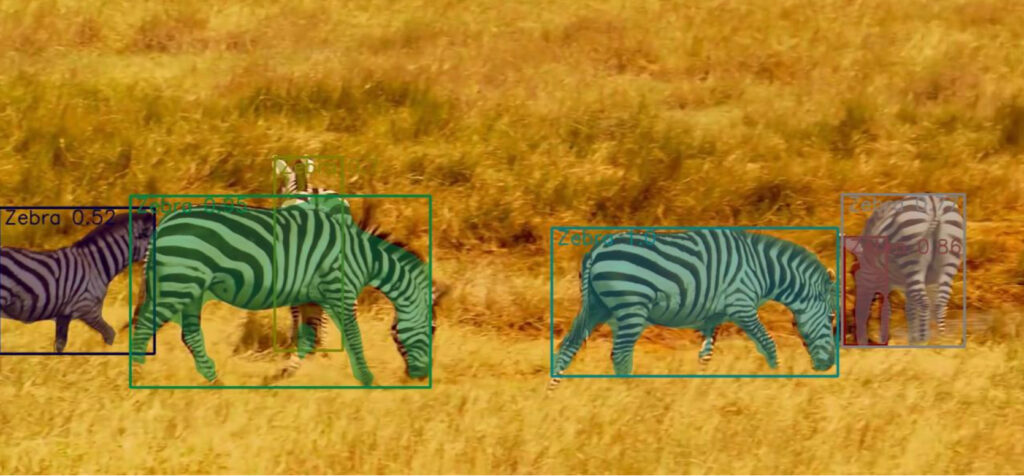

컴퓨터 비전에서 객체 탐지는 가장 핵심적인 문제이며, 인스턴스 분할은 객체 탐지에서 가장 어려운 작업으로 간주됩니다. 인스턴스 분할은 타겟 감지를 기반으로 객체의 픽셀을 분할하는 것입니다.

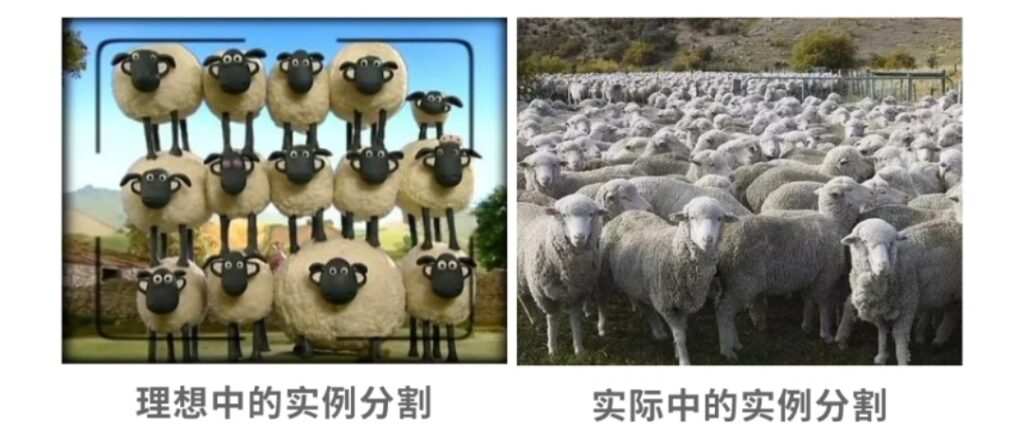

물체들이 서로 막히는 경우가 잦아 엔지니어들에게 골치 아픈 문제로 대두되고 있습니다. 우리 인간은 가려진 물체를 볼 때, 경험이나 연상을 통해 그것을 식별할 수 있습니다.

그렇다면 컴퓨터 비전에서 사람처럼 가려진 물체를 정확하게 식별하는 것이 가능할까요? 인스턴스 분할 연구 주제에서 폐색으로 인한 간섭을 해결하는 것은 항상 중요한 연구 방향이었습니다.

이 문제를 해결하기 위해 화중과학기술대학교, 알리바바, 코넬대학교, 존스홉킨스대학교, 옥스퍼드대학교의 팀이가려진 비디오 인스턴스 분할을 위한 대규모 데이터 세트 OVIS(Occluded Video Instance Segmentation)를 수집하여 가려진 장면에서 인스턴스를 동시에 감지, 분할 및 추적하는 데 사용할 수 있습니다.

이는 Google YouTube-VIS 데이터 세트에 이어 두 번째 대규모 폐쇄형 비디오 인스턴스 분할 데이터 세트입니다.

OVIS: 심하게 방해받은 901개의 영상에서 탄생

우리가 일상생활에서 보는 모든 것 중에서 고립되어 나타나는 물체는 거의 없으며, 다소간 가려져 있는 경우도 있습니다. 그러나 연구에 따르면 인간의 시각 시스템은 가려진 경우에도 대상 객체의 실제 경계를 구분할 수 있는 반면, 컴퓨터 비전 시스템에서는 가려진 비디오 인스턴스 분할 문제라는 큰 문제가 발생합니다.

이 문제를 더욱 탐구하고 해결하기 위해 화중과학기술대학, 알리바바 및 기타 기관의 팀은 원래 오픈소스 인스턴스 분할 알고리즘을 기반으로 더 나은 모델을 개발하려고 시도했습니다.

이 작업을 수행하기 위해 팀은 먼저 가려진 장면의 비디오 인스턴스 분할을 위해 특별히 설계된 OVIS 데이터 세트를 수집했습니다. 최근 발표된 논문에서《가려진 비디오 인스턴스 분할》이 데이터세트에 대해 자세히 소개합니다.

논문 주소: https://arxiv.org/pdf/2102.01558.pdf

이 데이터 세트를 수집하려면연구팀은 총 10,000여 개의 영상을 수집하였고, 최종적으로 심한 폐색, 많은 움직임, 복잡한 장면을 포함한 901개의 영상을 선정하였습니다. 각 영상에는 서로를 가리는 두 개 이상의 대상 객체가 있었습니다.

대부분의 영상은 1920×1080 해상도이고, 영상 길이는 5초에서 60초 사이입니다. 그들은 5개 프레임당 1개 프레임의 밀도로 고품질 주석을 수행했고, 최종적으로 OVIS 데이터 세트를 얻었습니다.

OVIS에는 5,223개 대상 객체에 대한 총 296,000개의 고품질 마스크 주석이 포함되어 있습니다.4,883개의 대상 객체와 131,000개의 마스크가 포함된 이전의 Google Youtube-VIS 데이터 세트와 비교했을 때, OVIS는 확실히 더 많은 대상 객체와 마스크 주석을 가지고 있습니다.

그러나 OVIS는 실제로 YouTube-VIS보다 적은 수의 비디오를 사용합니다. 이 팀의 철학은 장기적인 추적 기능을 구현하기 위해 더 긴 비디오를 선호하기 때문입니다. OVIS의 평균 비디오 지속 시간과 평균 인스턴스 지속 시간은 각각 12.77초와 10.55초인 반면, YouTube-VIS의 평균 비디오 지속 시간과 평균 인스턴스 지속 시간은 각각 4.63초와 4.47초입니다.

가려진 비디오 인스턴스 분할 작업을 더 어렵게 만들기 위해, 연구팀은 특정 수의 비디오 세그먼트를 희생하고 더 길고 복잡한 비디오에 주석을 달았습니다.

OVIS 데이터 세트에는 삶에서 흔히 볼 수 있는 25가지 범주가 포함되어 있습니다.아래 그림에서 볼 수 있듯이 구체적인 범주로는 사람, 물고기, 차량, 말, 양, 얼룩말, 토끼, 새, 가금류, 코끼리, 오토바이, 개, 원숭이, 보트, 거북이, 고양이, 소, 앵무새, 자전거, 기린, 호랑이, 자이언트 팬더, 비행기, 곰, 도마뱀 등이 있습니다.

이러한 카테고리는 다음 세 가지 고려 사항을 바탕으로 선택되었습니다.

- 이러한 목표물은 종종 움직이고 있으며 심하게 가려질 가능성이 더 큽니다.

- 그것들은 일상생활에서 매우 흔하게 발견됩니다.

- 이러한 카테고리는 현재 인기 있는 대규모 이미지 인스턴스 분할 데이터 세트(예: MS COCO, LVIS, Pascal VOC 등)와 많은 부분이 겹치므로 연구자들이 모델을 마이그레이션하고 데이터를 재사용하는 데 편리합니다.

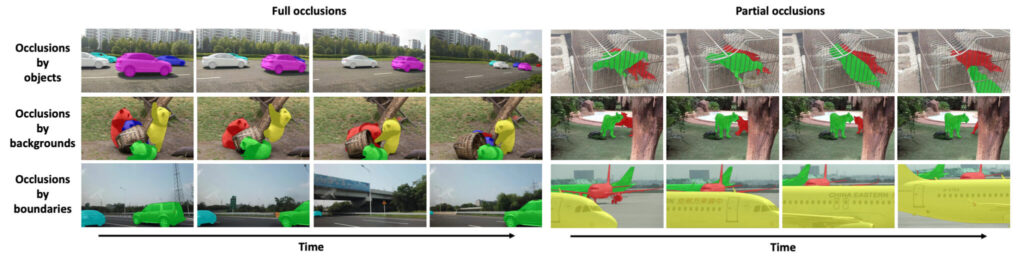

이전의 다른 VIS 데이터 세트와 비교했을 때,OVIS 데이터 세트의 가장 주목할 만한 특징은 다양한 요인으로 인해 많은 객체가 심하게 가려져 있다는 것입니다.따라서 OVIS는 심각한 폐색을 처리하는 비디오 인스턴스 분할 모델을 평가하기 위한 효과적인 테스트베드입니다.

연구팀은 폐색의 심각도를 정량화하기 위해 폐색의 정도를 대략적으로 반영하는 지표 평균 경계 상자 중첩률(mBOR)을 제안했습니다. mBOR은 이미지에서 모든 경계 상자의 면적에 대한 겹치는 경계 상자의 면적 비율을 나타냅니다. 매개변수 비교 목록을 보면 OVIS가 YouTube-VIS보다 더 심각한 폐색을 보인다는 것을 알 수 있습니다.

OVIS 데이터 세트의 세부 정보는 다음과 같습니다.

가려진 비디오 인스턴스 분할

오클루전 비디오 인스턴스 분할 데이터 세트

데이터 출처:《가려진 비디오 인스턴스 분할》

포함된 수량:5223개의 대상 객체, 296,000개의 마스크

유형의 수:25가지 유형

데이터 형식:프레임: jpg; 댓글: Json

비디오 해상도:1920×1080 데이터 크기:12.7GB

다운로드 주소:https://orion.hyper.ai/datasets/14585

OVIS는 비디오 인스턴스 분할을 위한 더 높은 벤치마크를 제안합니다.

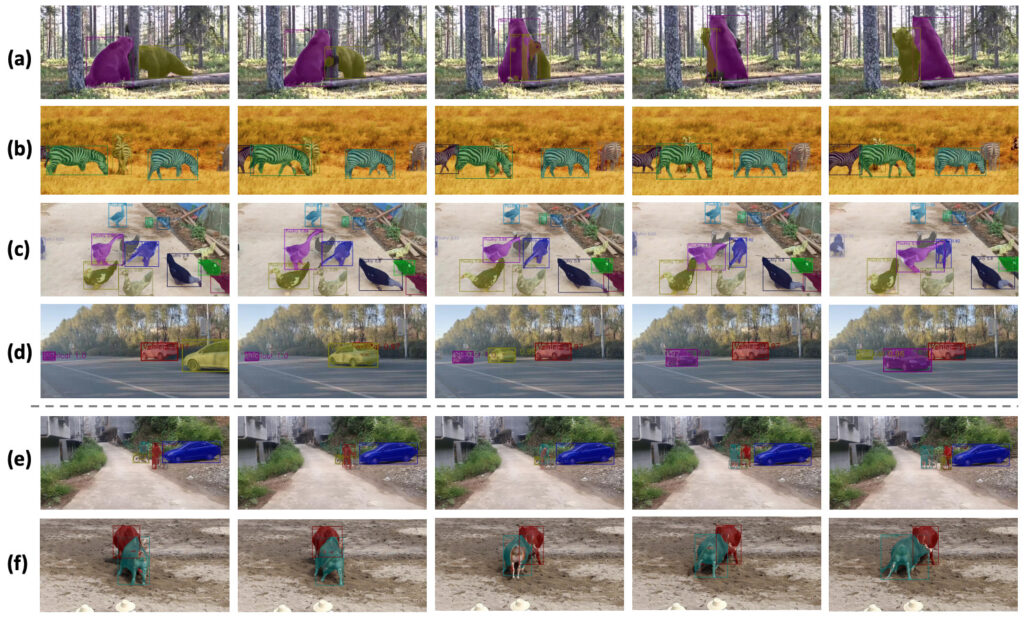

OVIS 데이터 세트는 무작위로 607개의 훈련 비디오, 140개의 검증 비디오, 154개의 테스트 비디오로 나뉩니다. 이 팀은 OVIS에서 기존의 오픈소스 비디오 인스턴스 분할 알고리즘 5개에 대한 포괄적인 평가를 수행했으며, 이는 OVIS 데이터 세트의 기준 성능에 대한 벤치마크 역할도 했습니다.

평가 결과는 다음 표에 나와 있습니다.

YouTube0-VIS와 비교했을 때, OVIS에서 FEELVOS, IoUTracker+, MaskTrack R-CNN, SipMask, STEm-Seg의 5가지 알고리즘의 성능은 최소 50%만큼 떨어졌습니다.예를 들어, SipMask의 AP는 32.5에서 12.1로 떨어지고, STEm-Seg의 AP는 30.6에서 14.4로 떨어집니다. 이러한 결과는 연구자들에게 비디오 인스턴스 분할 문제에 더 많은 주의를 기울여야 한다는 점을 상기시켜 줍니다.

또한, 해당 팀은 교정 모듈을 사용하여 원래 알고리즘의 성능을 크게 개선했습니다.이를 통해 개발한 CMaskTrack R-CNN은 기존 알고리즘인 MaskTrack R-CNN의 AP를 12.6에서 15.2로 2.6 향상시켰고, CSipMask는 SipMask의 AP를 12.1에서 15.0으로 2.9 향상시켰습니다.

위 그림(c)에서 오리가 붐비는 장면에서 팀의 방법은 거의 정확하게 모든 오리를 감지하고 추적했지만 두 번째 프레임에서 가장 왼쪽에 있는 오리를 감지하는 데 실패했습니다. 그러나 이후 프레임에서 오리를 다시 추적하여 해당 팀의 모델이 시간적 단서를 잘 포착했다는 것을 보여주었습니다.

연구팀은 YouTube-VIS 데이터세트에서 제안된 CMaskTrack R-CNN과 CSipMask 알고리즘을 추가로 평가했고, 그 결과 AP 측면에서 원래 방법을 능가하는 것으로 나타났습니다.

미래 응용 분야: 비디오 파노라마 분할, 합성 폐색 데이터

연구팀은 OVIS에서 일반적으로 사용되는 비디오 분할 알고리즘의 기본 성능이 YouTube-VIS보다 훨씬 낮다고 밝혔습니다. 이는 앞으로 연구자들이 가려진 비디오 객체를 처리하는 데 더 많은 에너지를 투자해야 함을 시사합니다.

또한 연구팀은 시간적 맥락적 단서를 활용해 폐색 문제를 해결하는 방법을 모색했습니다. 앞으로 연구팀은 비지도 학습, 반지도 학습 또는 대화형 학습 환경에서 비디오 객체 분할 시나리오에서 OVIS의 실험 궤적을 공식화할 예정이다. 또한, OVIS를 비디오 파노라마 분할로 확장하는 것도 중요합니다(참고: 비디오 파노라마 분할은 배경의 의미적 분할과 전경의 인스턴스 분할을 모두 달성하는 것으로, 인스턴스 분할 분야의 최근 새로운 추세입니다).

또한, 합성 폐색 데이터 역시 팀이 더욱 탐구해야 할 방향입니다. 연구팀은 OVIS 데이터 세트를 통해 복잡하고 다양한 시나리오에서 비디오를 이해하기 위한 연구가 더욱 활발해질 것으로 믿는다고 밝혔습니다.

이 기술은 앞으로 영화와 텔레비전 특수효과, 단편 영상, 생방송 등에서 캐릭터와 배경을 분리하는 데 중요한 역할을 할 것입니다.

참고문헌:

논문 주소: https://arxiv.org/pdf/2102.01558.pdf

프로젝트 공식 웹사이트: http://songbai.site/ovis/

Google YouTube-VIS 데이터 세트: