Command Palette

Search for a command to run...

MMEvalPro 다중 모드 벤치마크 평가 데이터 세트

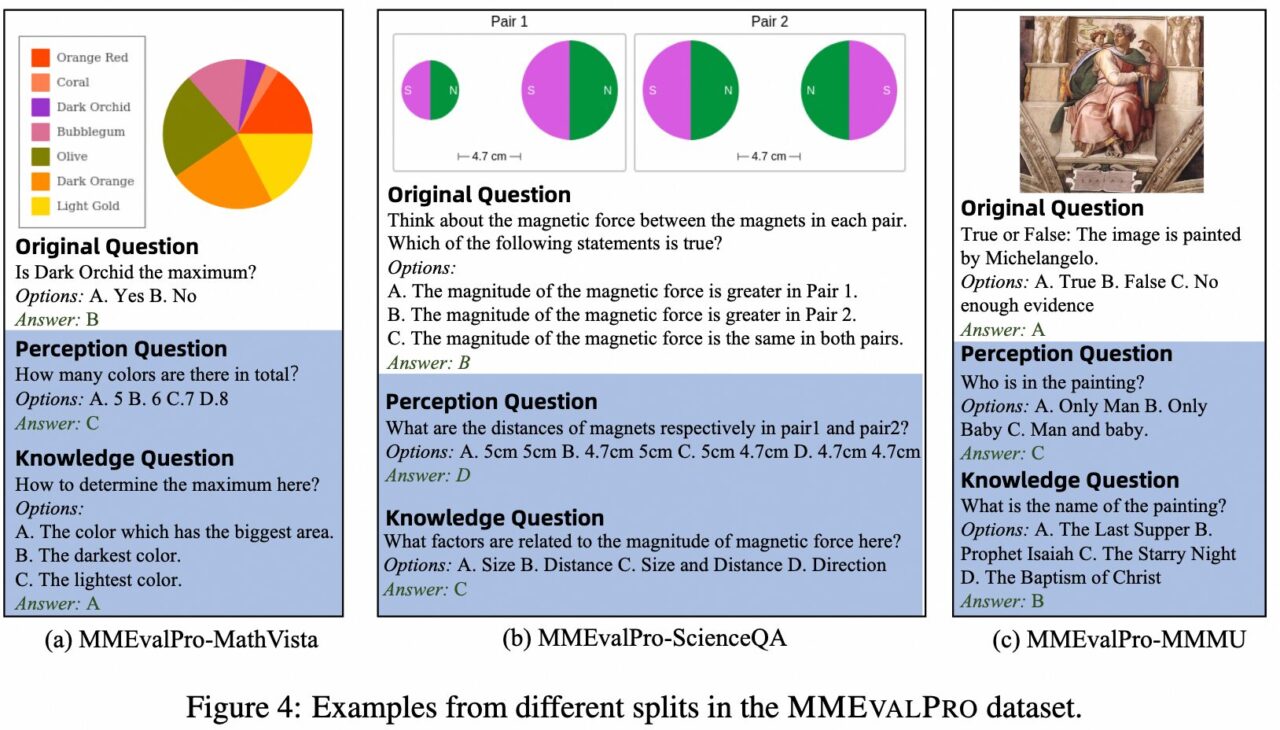

MMEvalPro는 베이징대학교, 중국 의학 아카데미, 홍콩 중국 대학교, 알리바바의 연구팀이 2024년에 제안한 다중 모드 대규모 모델(LMM) 평가 벤치마크입니다. 이 연구의 목적은 더욱 신뢰성 있고 효율적인 평가 방법을 제공하고, 기존 다중 모드 평가 벤치마크가 지닌 문제점을 해결하는 것입니다. 기존 벤치마크는 LMM을 평가하는 데 체계적인 편향을 가지고 있으며, 시각적 인식이 없는 대규모 언어 모델(LLM)조차도 이러한 벤치마크에서 사소하지 않은 성과를 달성할 수 있으며, 이는 이러한 평가의 신뢰성을 떨어뜨립니다. MMEvalPro는 두 개의 "앵커" 질문(지식 질문과 지식 질문)을 추가하여 기존 평가 방법을 개선하고, 모델의 다중 모드 이해의 다양한 측면을 테스트하는 "질문 3개"를 구성합니다.

MEvalPro의 주요 평가 지표는 "정확도"로, 모델이 점수를 받으려면 3개의 질문에 모두 올바르게 답해야 합니다. 이 과정에는 질문이 명확하고, 관련성이 있으며, 도전적인지 확인하기 위한 여러 단계의 검토와 품질 검사가 포함됩니다. 최종 벤치마크에는 2,138개의 3중 문제가 포함되어 있으며, 총 6,414개의 문제가 다양한 주제와 난이도를 다루고 있습니다.

MMEvalPro.torrent

시딩 1다운로드 중 0완료됨 155총 다운로드 횟수 175