SA-V: Meta가 가장 큰 비디오 분할 데이터 세트를 구축합니다.

* 이 데이터 세트는 온라인 사용을 지원합니다.여기를 클릭하여 이동하세요.

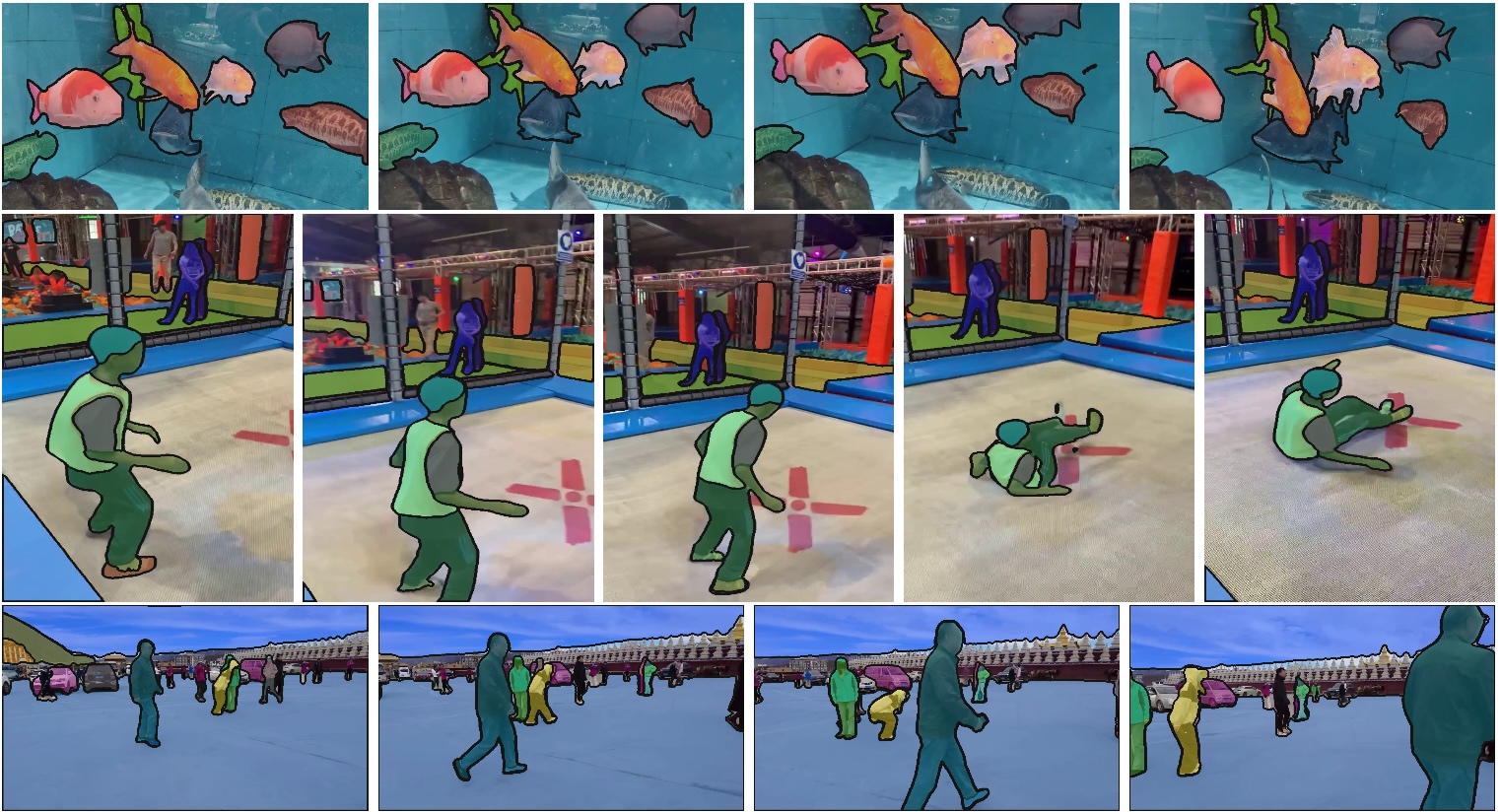

SA-V 데이터 세트는 Meta가 2024년에 구축한 대규모 비디오 분할 데이터 세트입니다. 이 데이터 세트는 Meta Segment Anything Model 2(약칭 SAM 2)를 훈련하고 평가하는 데 사용됩니다. 이 데이터 세트는 규모와 다양성 면에서 매우 크고, 약 51,000개의 실제 비디오와 643K개의 시공간 마스크릿 주석을 포함하고 있으며, 이는 다른 유사한 데이터 세트보다 크기가 약 50배 더 큽니다.

SA-V 데이터 세트는 주석자들이 SAM 2 모델을 사용하여 비디오의 마스크릿에 대화형으로 주석을 달고, 이렇게 새로 주석이 달린 데이터를 사용하여 SAM 2 모델을 업데이트하고 학습시키는 반복적 프로세스를 통해 구성되었습니다. 이러한 접근 방식은 데이터 수집의 효율성을 향상시킬 뿐만 아니라, 더 정확하고 다양한 데이터 세트를 구축하는 데에도 도움이 됩니다.

또한 SA-V 데이터 세트의 비디오는 다양한 지역과 실제 장면을 다루는 47개국에서 수집되었으며, 이는 모델이 학습하고 일반화할 수 있는 풍부한 시각적 콘텐츠를 제공합니다. 데이터 세트의 주석에는 전체 객체뿐만 아니라 사람의 모자와 같은 객체의 일부와 객체가 가려지거나 사라지거나 다시 나타나는 까다로운 인스턴스도 포함됩니다.

이 데이터 세트의 출시와 SAM 2 모델의 오픈 소스화는 연구자와 개발자에게 비디오 편집, 혼합 현실, 로봇 공학, 자율 주행, 비디오 콘텐츠 이해 등의 분야에서 새로운 응용 프로그램과 혁신을 탐색할 수 있는 강력한 도구를 제공합니다.

데이터 세트 구조

– 훈련 분할: 비디오는 MP4로 인코딩되었으며, 각 파일은 약 8G, sav_000.tar – sav_055.tar입니다. 마스크릿은 COCO 런 길이 인코딩(RLE) 형식(목록의 목록)으로 되어 있으며, 바깥쪽 목록은 비디오 프레임 위에 겹쳐져 있습니다.

– Val/Test 분할: 비디오 프레임은 JPEG 형식이며, 각 파일은 약 16G, sav_val.tar 및 sav_test.tar입니다. 마스크릿은 PNG 형식입니다.