Command Palette

Search for a command to run...

ScaleNet

ScaleNet a été proposé conjointement en octobre 2025 par une équipe de recherche de l'Institut de technologie de Pékin, du laboratoire Noah's Ark de Huawei et de l'Université de la ville de Hong Kong, entre autres institutions. Les résultats de ces recherches ont été publiés dans un article. ScaleNet : Mise à l’échelle des réseaux neuronaux pré-entraînés grâce à des paramètres incrémentaux .

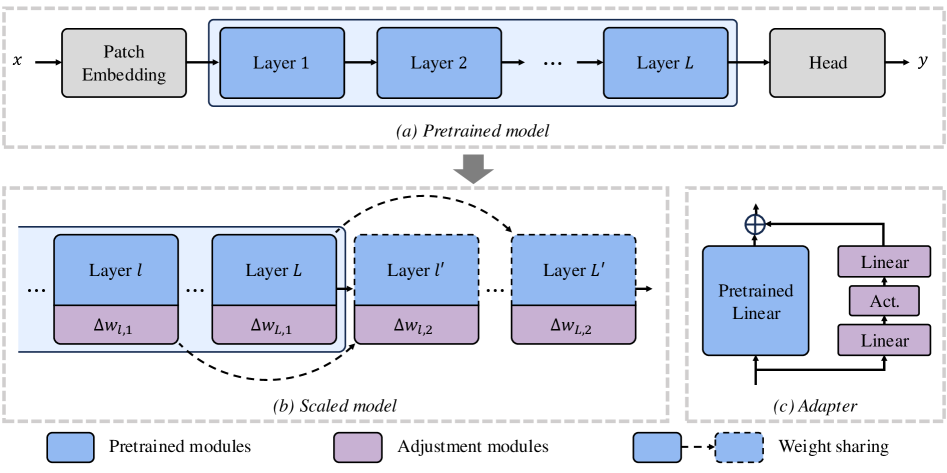

ScaleNet est une méthode efficace pour la mise à l'échelle des modèles ViT. Contrairement à l'entraînement traditionnel à partir de zéro, ce paradigme permet une mise à l'échelle rapide des modèles pré-entraînés existants avec une augmentation minimale du nombre de paramètres, offrant ainsi une solution économique. Concrètement, ScaleNet met à l'échelle les modèles en insérant des couches supplémentaires dans les ViT pré-entraînés, en utilisant le partage des poids par couche pour préserver l'efficacité des paramètres. De nombreuses expériences menées sur le jeu de données ImageNet-1K démontrent que ScaleNet surpasse significativement l'entraînement de modèles mis à l'échelle à partir de zéro, atteignant une amélioration de la précision TP3T de 7,421 sur un modèle DeiT-Base dont la profondeur a été doublée, en seulement un tiers des époques d'entraînement.

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.