Command Palette

Search for a command to run...

Hunyuan-MT-7B : Démonstration Du Modèle De Traduction

Date

Taille

1.34 GB

Licence

Other

1. Introduction au tutoriel

Hunyuan-MT-7B est un modèle de traduction léger publié par l'équipe Tencent Hunyuan en septembre 2025. Avec seulement 7 milliards de paramètres, il prend en charge la traduction entre 33 langues et cinq langues/dialectes chinois ethniques. Il a obtenu des performances exceptionnelles, remportant la première place dans 30 des 31 catégories linguistiques lors du concours WMT2025 de l'Association for Computational Linguistics (ACL). Ce modèle comprend avec précision l'argot d'Internet, la poésie chinoise classique et les conversations sociales, offrant une traduction contextualisée. Il propose un paradigme d'apprentissage complet, du pré-apprentissage à l'apprentissage par renforcement intégré. Il bénéficie d'une vitesse d'inférence rapide et ses performances sont encore améliorées par 30% après traitement avec l'outil de compression propriétaire AngelSlim de Tencent.

Ce tutoriel utilise des ressources pour une seule carte RTX 4090.

2. Exemples de projets

3. Étapes de l'opération

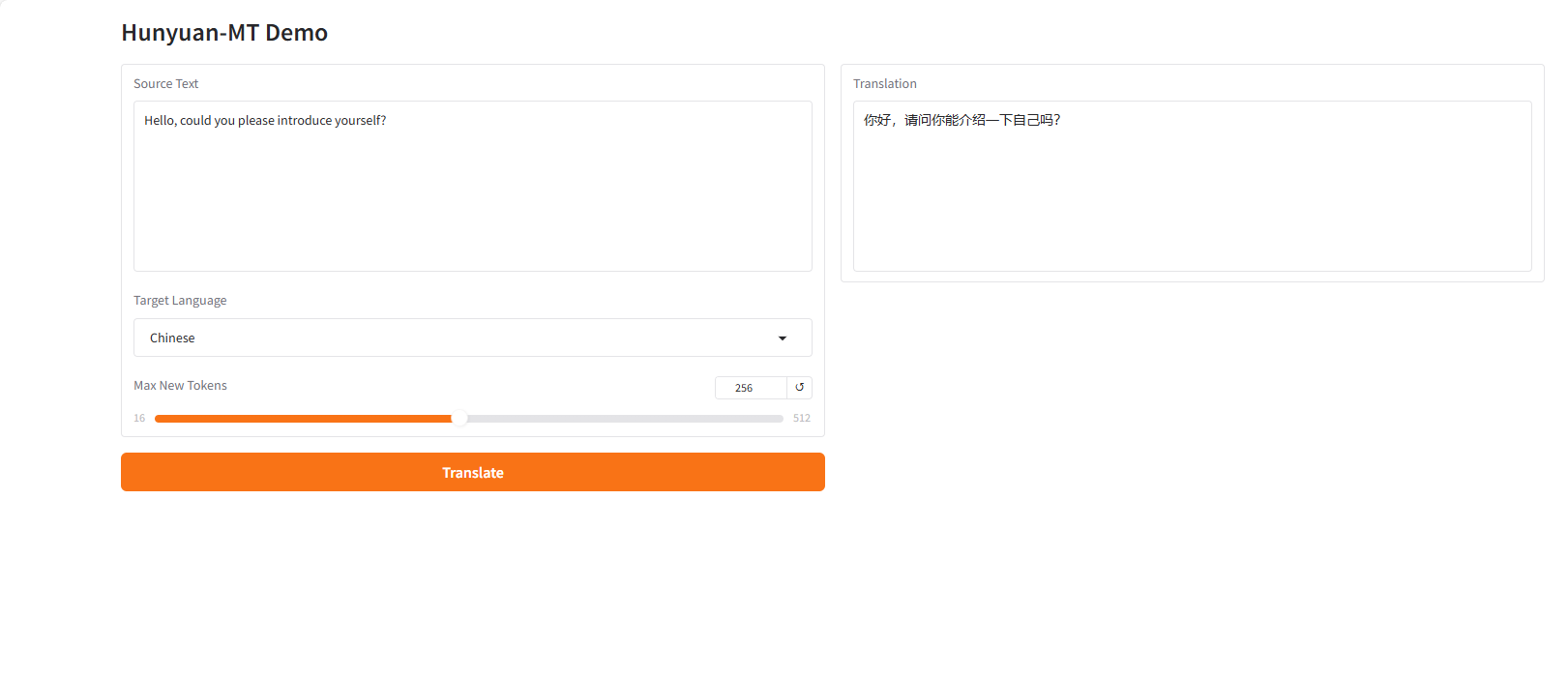

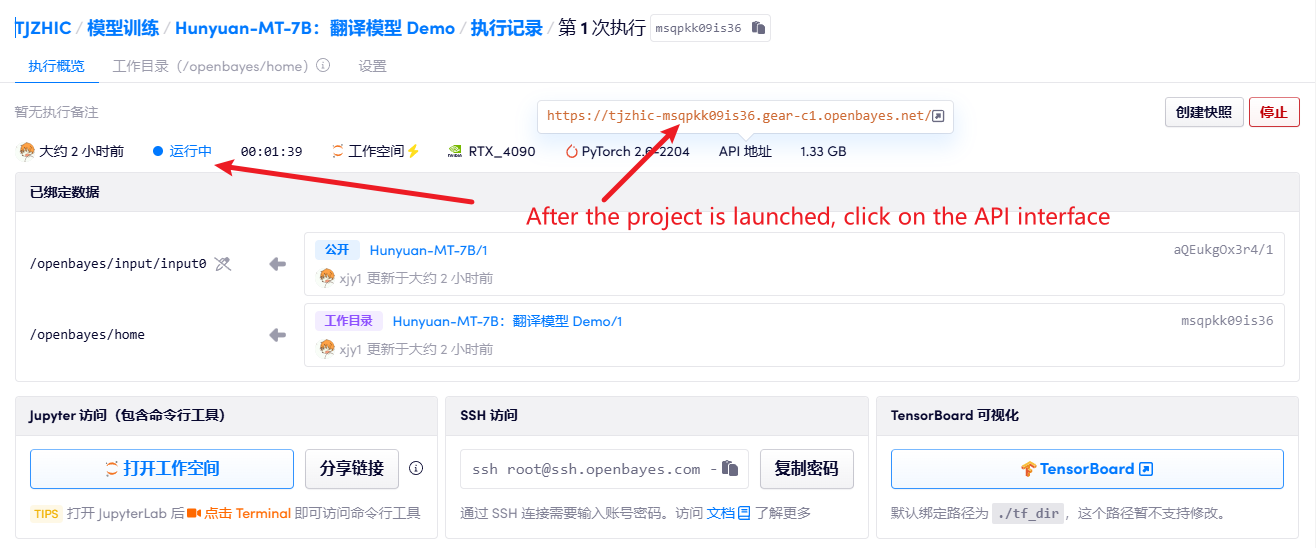

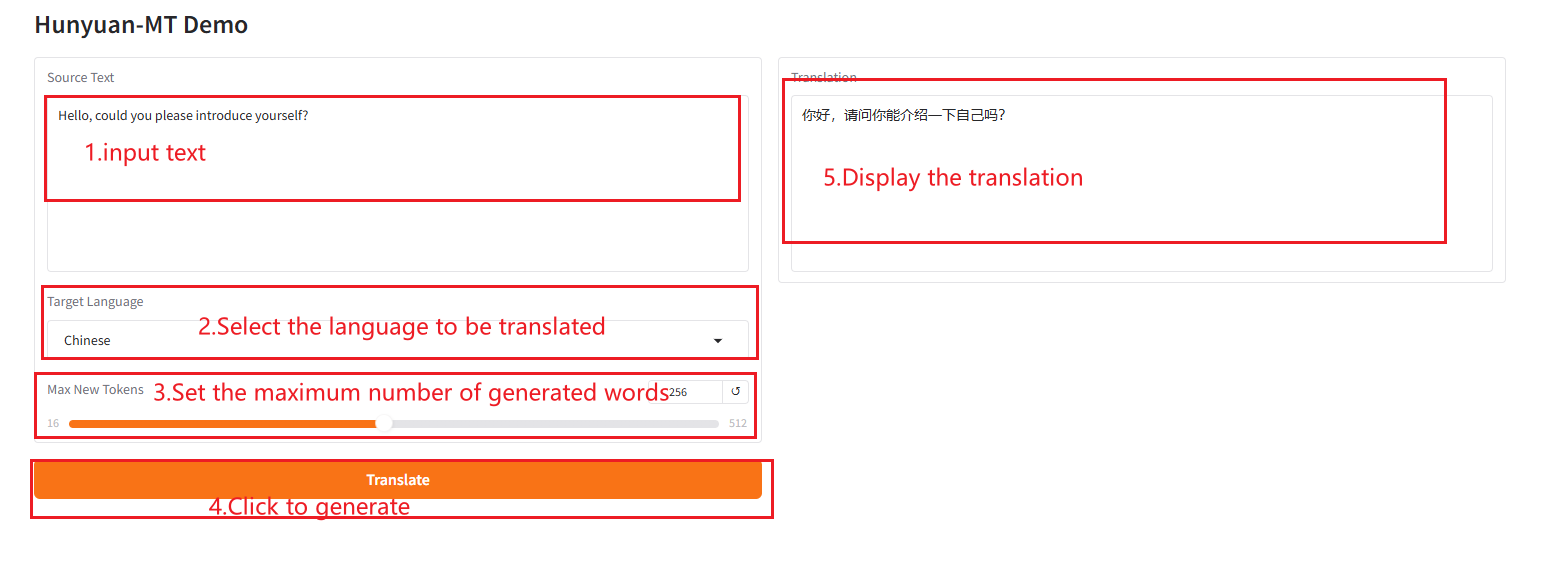

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@misc{hunyuanmt2025,

title={Hunyuan-MT Technical Report},

author={Mao Zheng, Zheng Li, Bingxin Qu, Mingyang Song, Yang Du, Mingrui Sun, Di Wang, Tao Chen, Jiaqi Zhu, Xingwu Sun, Yufei Wang, Can Xu, Chen Li, Kai Wang, Decheng Wu},

howpublished={\url{https://github.com/Tencent-Hunyuan/Hunyuan-MT}},

year={2025}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.