Command Palette

Search for a command to run...

MiniCPM-V4.0 : Modèle De Bout En Bout À Grande Échelle Extrêmement Efficace

1. Introduction au tutoriel

MiniCPM-V 4.0 est un modèle de traitement du langage naturel extrêmement performant, disponible en open source depuis août 2025, fruit d'une collaboration entre le Laboratoire de traitement du langage naturel de l'Université Tsinghua et Wallfacer Intelligence. Basé sur SigLIP2-400M et MiniCPM4-3B, il compte 4,1 milliards de paramètres. Il hérite des excellentes performances de MiniCPM-V 2.6 en matière de compréhension d'images (mono-image, multi-images et vidéo), tout en offrant une efficacité nettement supérieure. Wallfacer Intelligence a également publié simultanément des applications iOS pour iPhone et iPad. Sur le benchmark OpenCompass, les capacités de compréhension d'images de MiniCPM-V 4.0 surpassent celles de GPT-4.1-mini-20250414, Qwen2.5-VL-3B-Instruct et InternVL2.5-8B. Des articles de recherche associés sont disponibles. MiniCPM-V : un MLLM de niveau GPT-4V sur votre téléphone .

Ce tutoriel utilise une seule carte graphique RTX 4090 comme ressource de calcul. Trois exemples sont fournis à titre de test : Discussion avec une ou plusieurs images, Discussion avec vidéo et Quelques prises de vue.

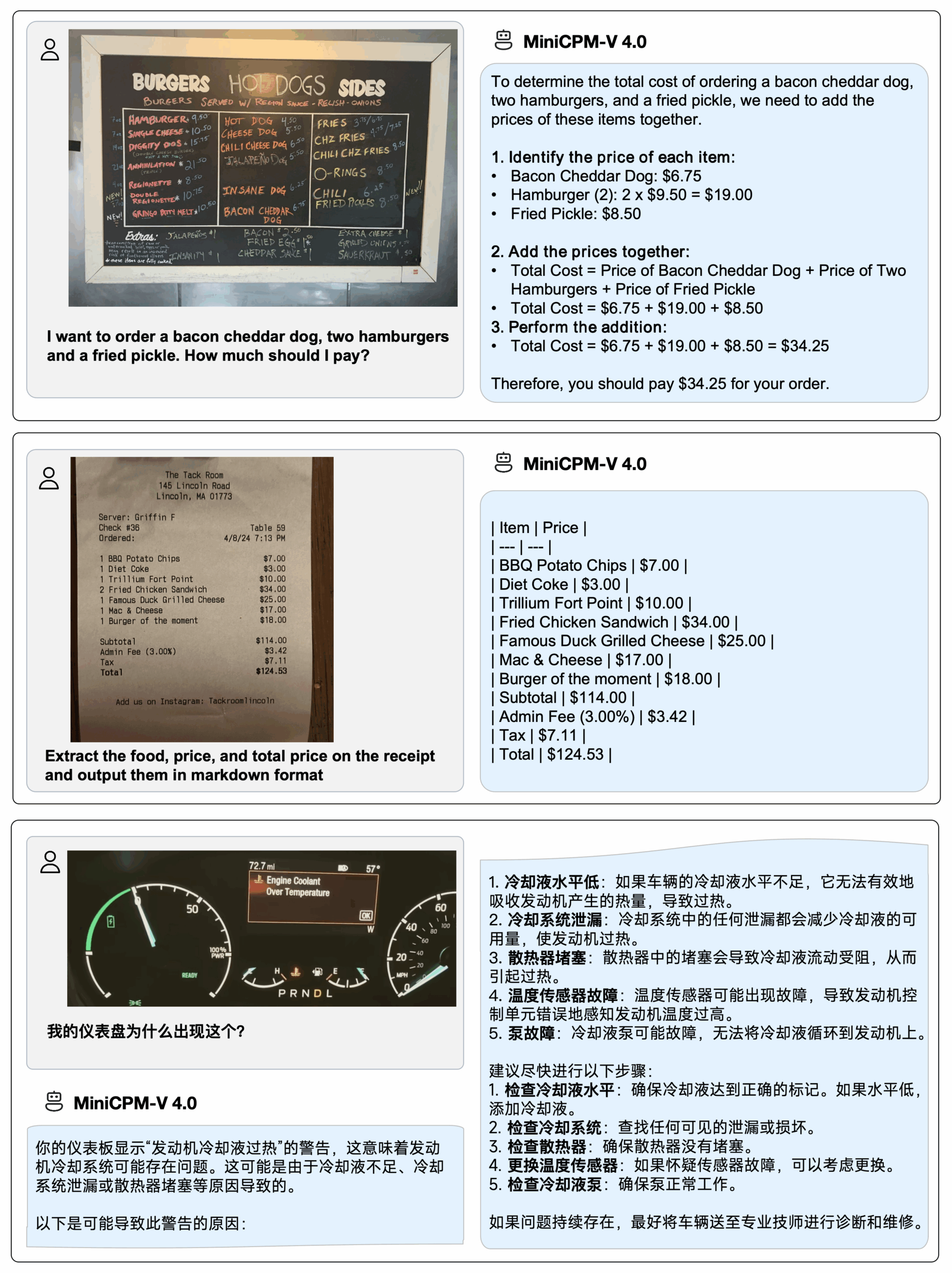

2. Affichage des effets

Déployer MiniCPM-V 4.0 sur iPhone 16 Pro Max,Démo iOSLa vidéo de démonstration est un enregistrement d'écran brut et non édité :

3. Étapes de l'opération

1. Démarrez le conteneur

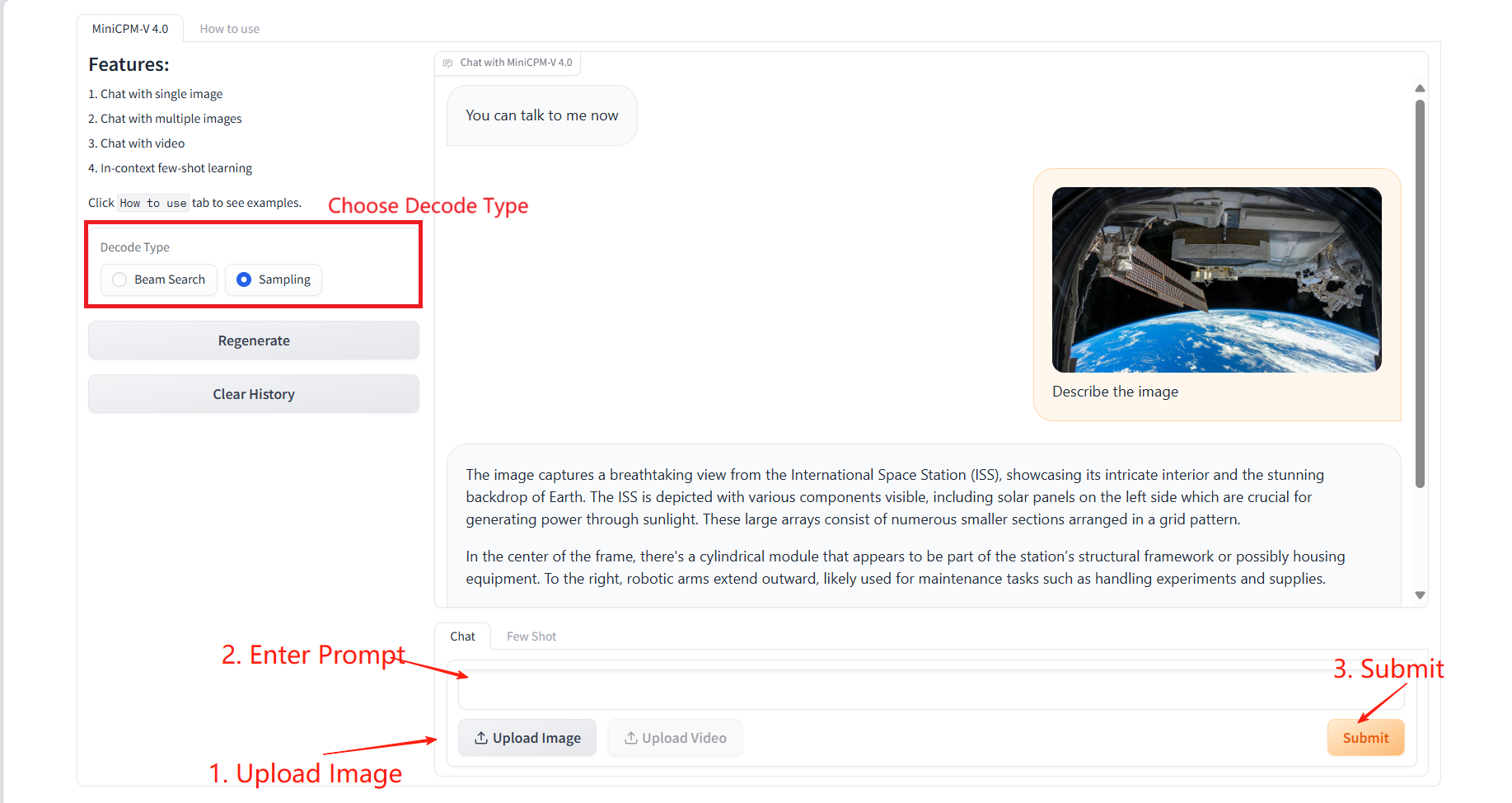

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

Cliquez sur « Comment utiliser » pour afficher le guide d’utilisation.

1. Discuter avec une ou plusieurs images

Paramètres spécifiques :

- Type de décodage :

- Recherche de faisceau : une méthode de décodage hautement déterministe qui tente de retenir les séquences candidates les plus probables. Elle est particulièrement adaptée aux scénarios exigeant des résultats précis et cohérents.

- Échantillonnage : Échantillonnage aléatoire du mot suivant selon une distribution de probabilité. Le résultat est plus créatif, mais peut être instable.

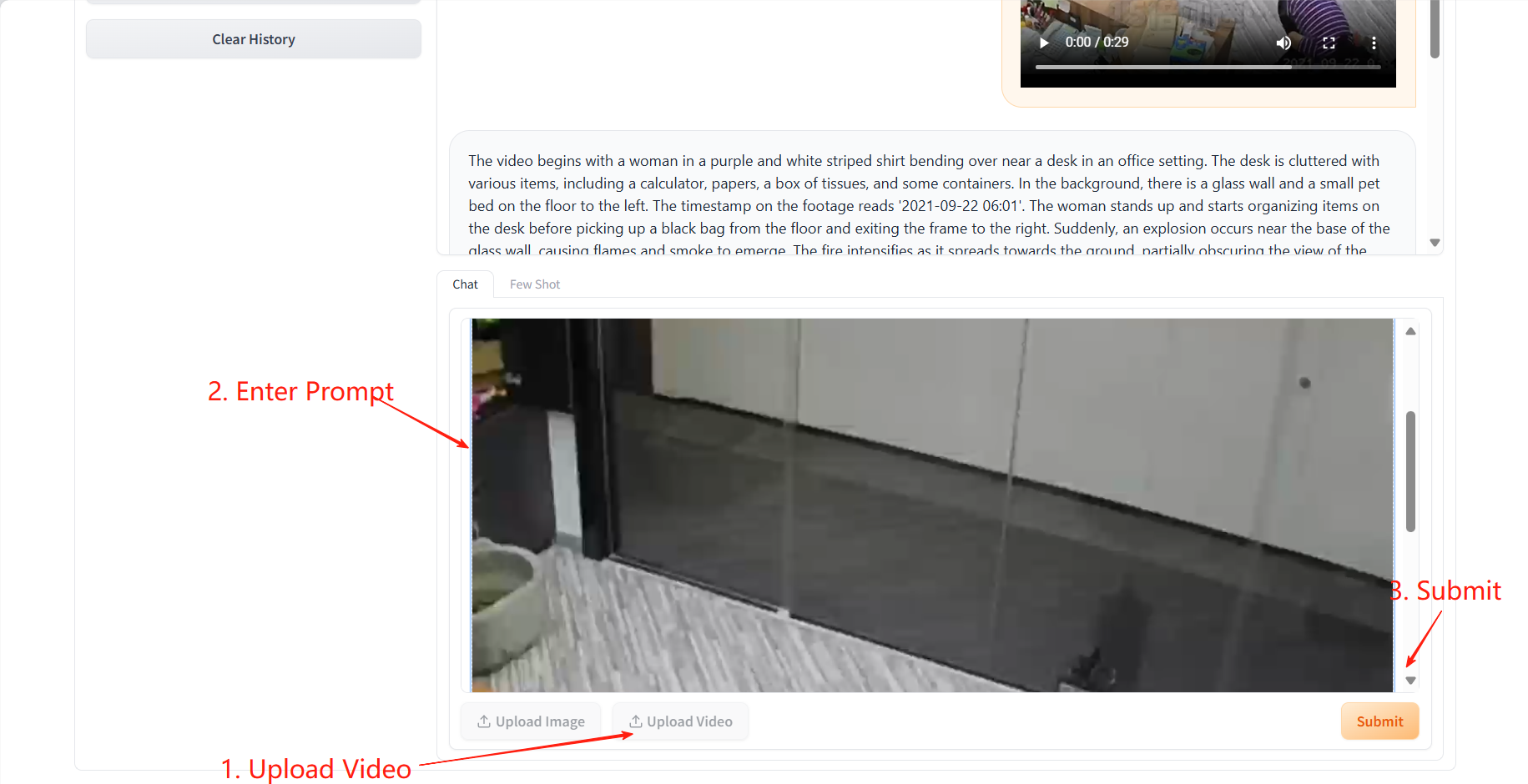

2. Chat vidéo

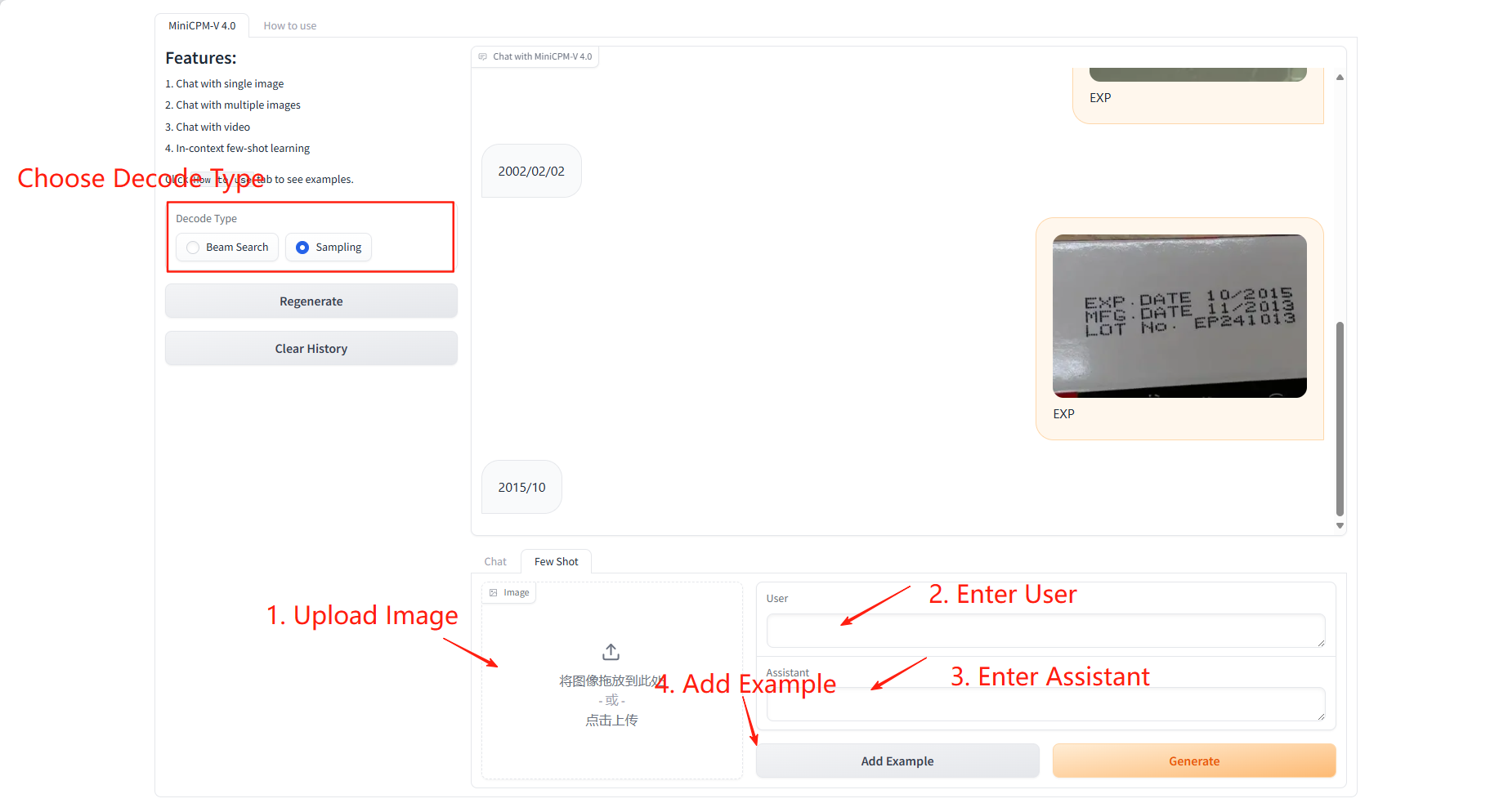

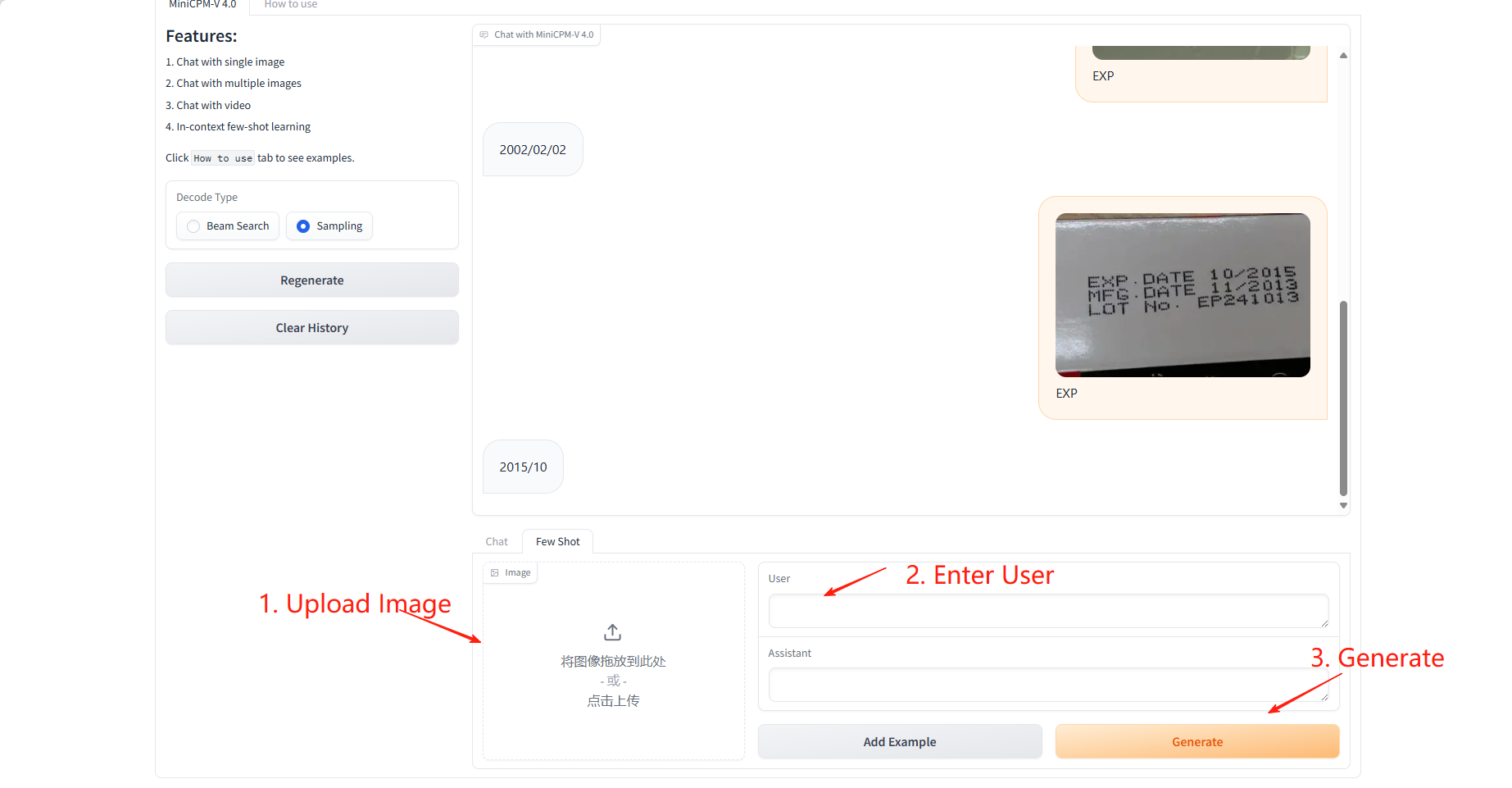

3. Quelques coups

Exemple d'apprentissage

Paramètres spécifiques :

- Utilisateur : saisissez le champ à prédire ou à apprendre pour cet échantillon.

- Assistant : Saisissez la valeur correspondant au champ à apprendre pour cet échantillon.

Prédiction des résultats

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={Nat Commun 16, 5509 (2025)},

year={2025}

}

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.