Command Palette

Search for a command to run...

lama.cpp+Open-Webui Déployer gpt-oss-120b

1. Introduction au tutoriel

gpt-oss-120b est un modèle d'inférence open source lancé par OpenAI en août 2025. Il cible le raisonnement fort, les tâches basées sur des agents et divers scénarios de développement. Basé sur l'architecture MoE, ce modèle prend en charge une longueur de contexte de 128 k et offre des performances comparables à celles des modèles o4-mini et o3-mini à code source fermé. Il excelle dans l'invocation d'outils, les appels de fonctions à plusieurs coups, le raisonnement en chaîne et la réponse aux questions de santé.

Ce tutoriel utilise des ressources RTX A6000 à double carte.

2. Exemples de projets

3. Étapes de l'opération

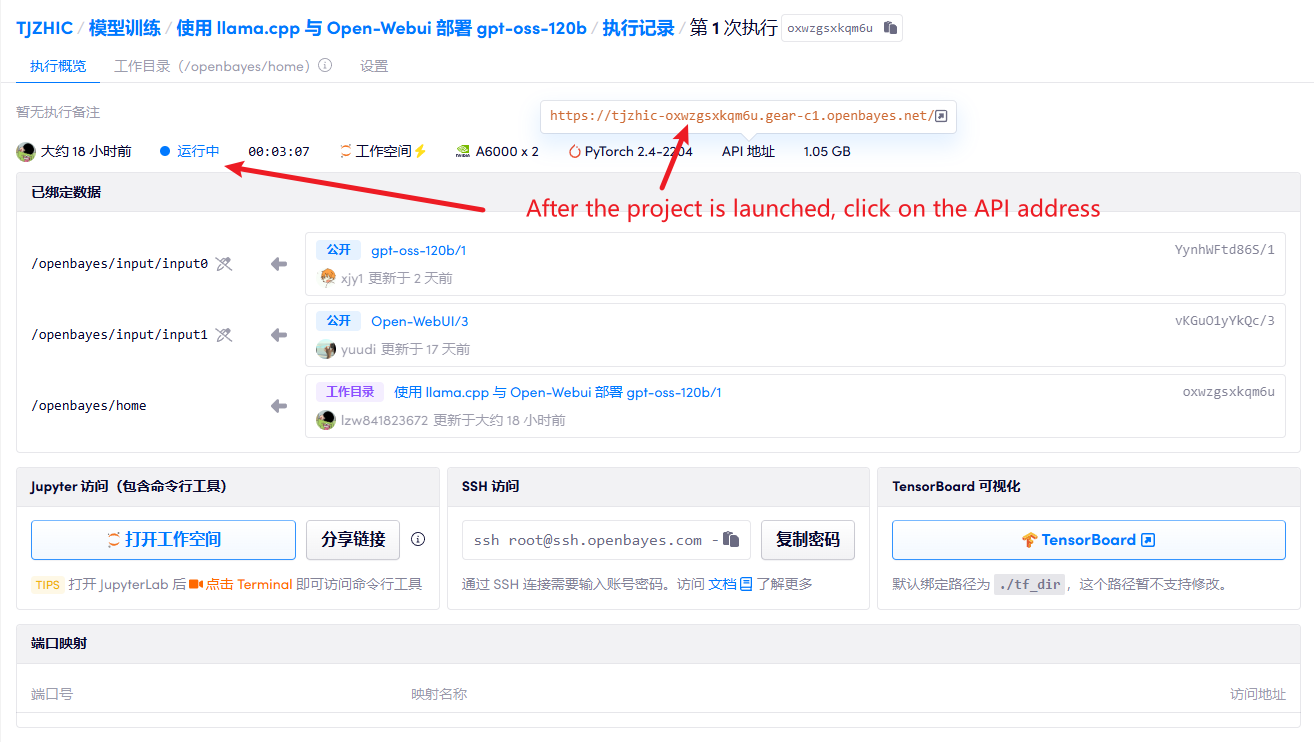

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

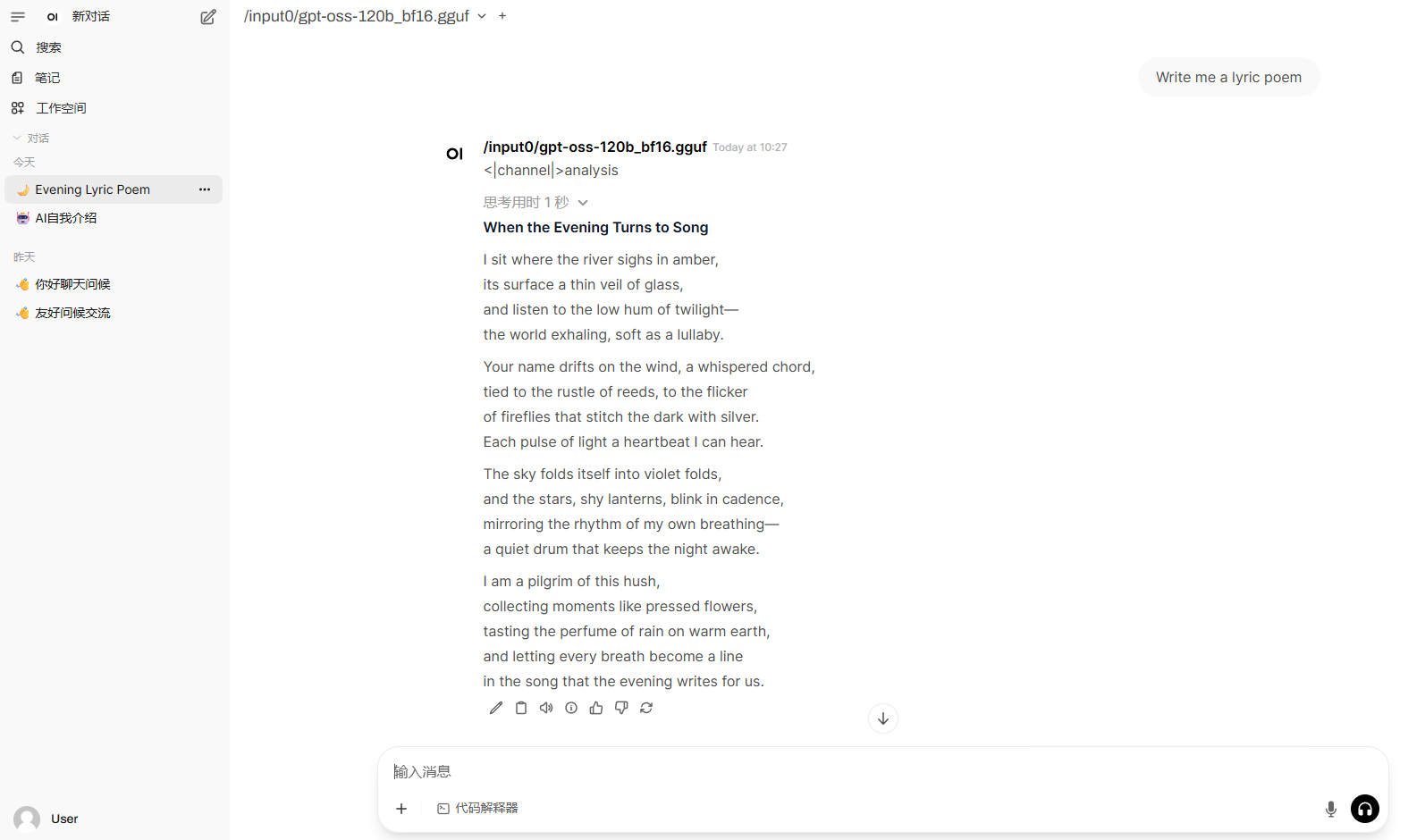

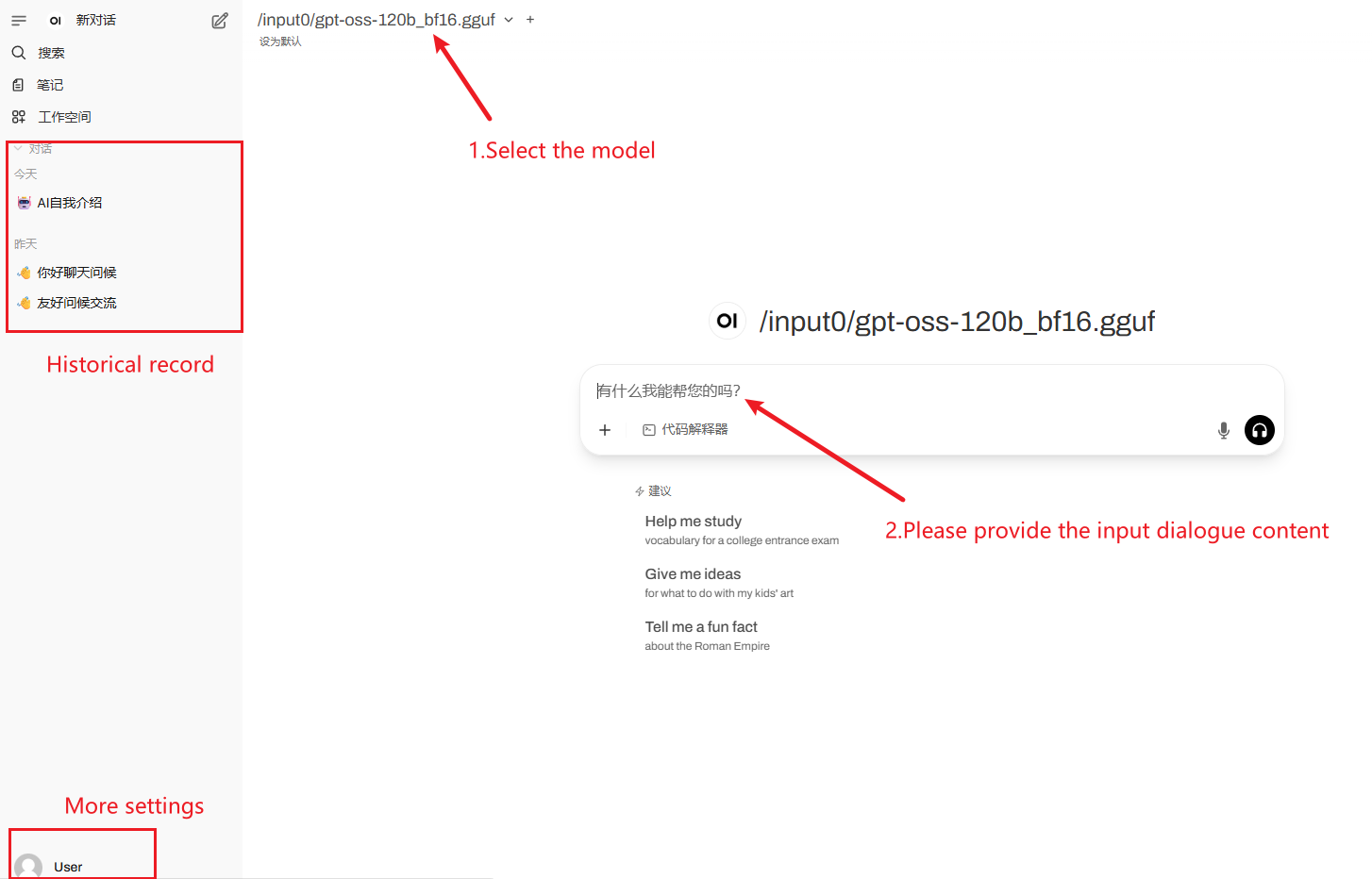

2. Après être entré sur la page Web, vous pouvez démarrer une conversation avec le modèle

Si « Modèle » n'est pas affiché, cela signifie que le modèle est en cours d'initialisation. Le modèle étant volumineux, veuillez patienter 2 à 3 minutes avant d'actualiser la page.

Comment utiliser

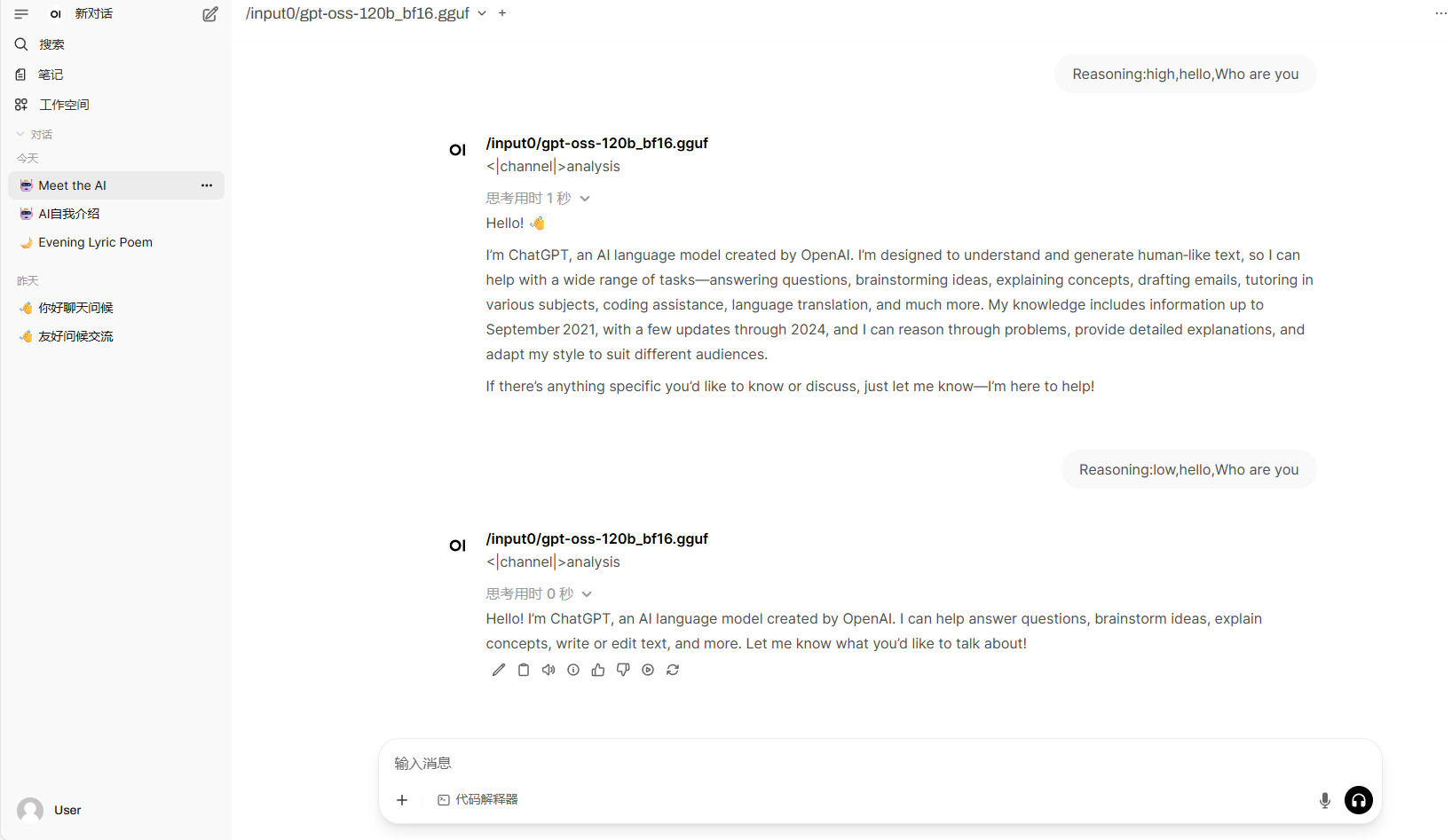

Avis:Dans ce tutoriel, vous pouvez modifier le niveau de raisonnement du modèle en ajoutant « Raisonnement : faible/moyen/élevé » avant le mot d'invite.

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.