Command Palette

Search for a command to run...

EvoSearch-codes : Cadre d'algorithme Évolutif

Date

Taille

964.11 MB

Licence

Apache 2.0

URL du document

1. Introduction au tutoriel

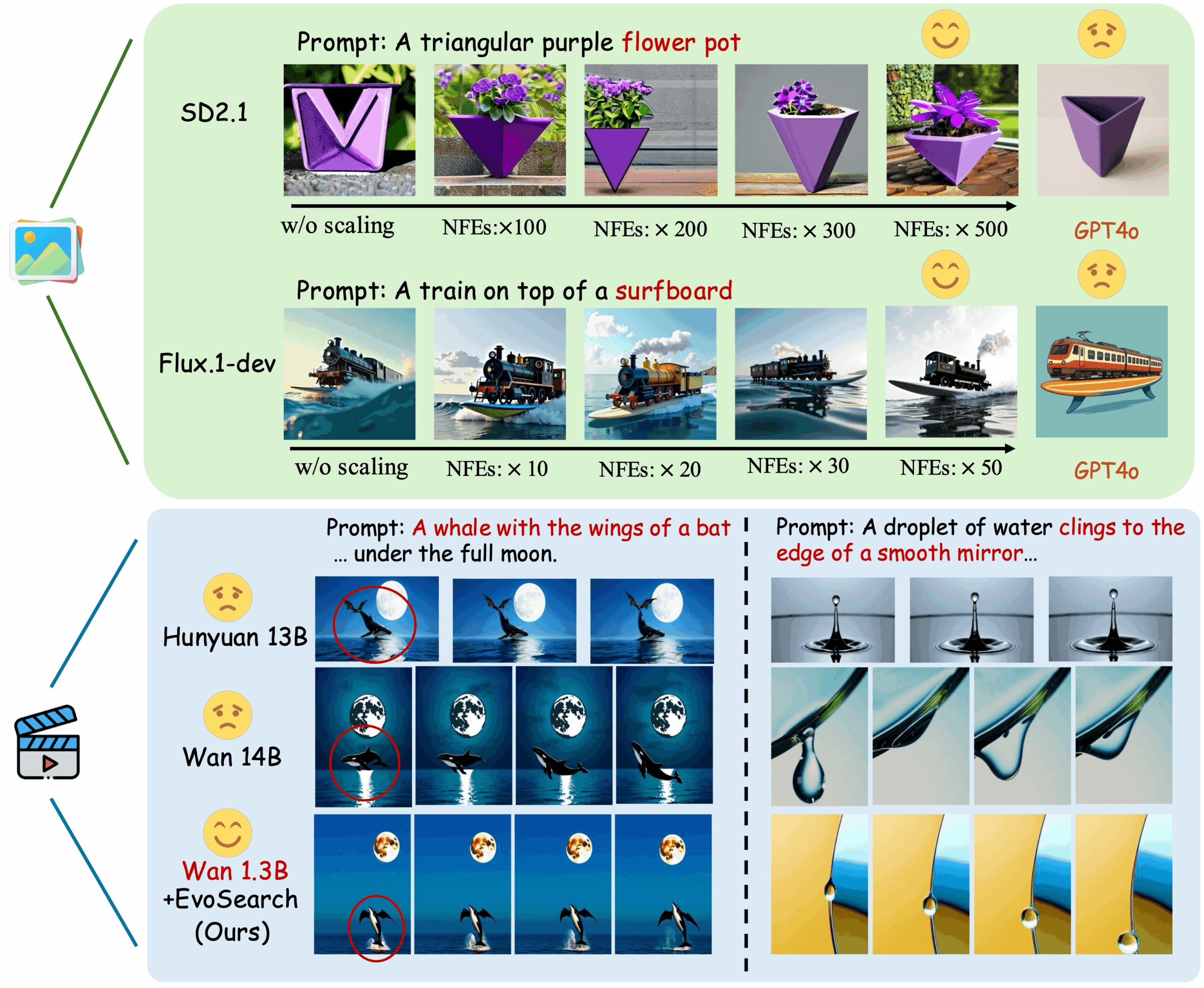

EvoSearch-codes, lancé le 1er mai 2025 par l'Université des sciences et technologies de Hong Kong et l'équipe de Kuaishou Keling, est une méthode de recherche évolutionnaire. Elle améliore significativement la qualité de génération des modèles en augmentant le coût de calcul lors de l'inférence, prend en charge la génération d'images et de vidéos et est compatible avec les modèles de pointe basés sur la diffusion et les flux. EvoSearch obtient des résultats remarquables sur un large éventail de tâches sans entraînement ni mise à jour des gradients, démontrant ainsi une bonne capacité de passage à l'échelle, de robustesse et de généralisation. Grâce à l'augmentation du temps de calcul lors des tests, EvoSearch montre que SD2.1 et Flux.1-dev ont le potentiel de rivaliser, voire de surpasser, GPT-4o. Pour la génération vidéo, Wan 1.3B surpasse également Wan 14B et Hunyuan 13B, démontrant le potentiel et les perspectives de recherche pour une mise à l'échelle lors des tests, en complément de celle lors de l'entraînement. Des articles connexes sont disponibles. Mise à l'échelle de la génération d'images et de vidéos via la recherche évolutive au moment du test .

Ce tutoriel utilise une seule carte RTX A6000 comme ressource. Il propose trois exemples de tests : génération de vidéo WAN, génération d'images SD et génération d'images FLUX.

2. Exemples de projets

3. Étapes de l'opération

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

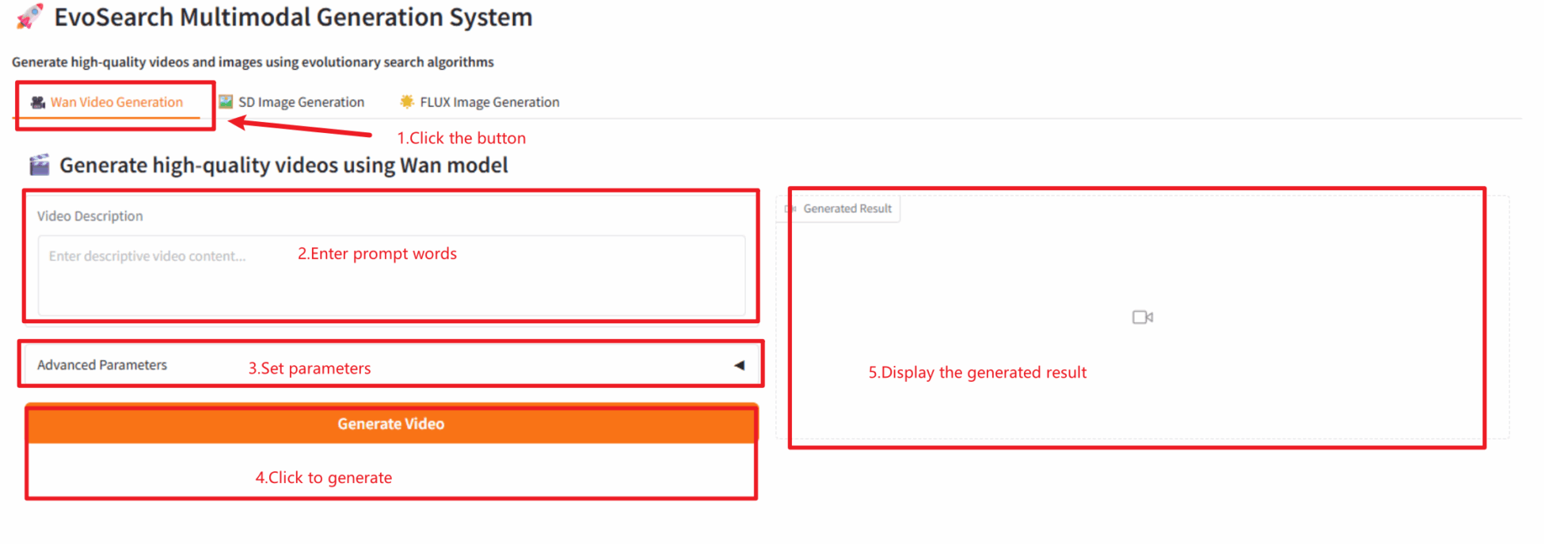

2.1 Génération de vidéo WAN

Astuce : la génération de la vidéo prendra environ 5 à 8 minutes.

Description des paramètres

- Paramètres avancés

- Graine aléatoire : Graine aléatoire.

- Hauteur : Hauteur de génération de la vidéo.

- Largeur : largeur de génération de vidéo.

- Durée de la vidéo : contrôle la durée de la vidéo.

- Étapes d'inférence : Étapes d'inférence.

- Échelle de guidage : contrôle la force de l’influence des indices textuels sur la vidéo générée.

- Itération : nombre d'itérations.

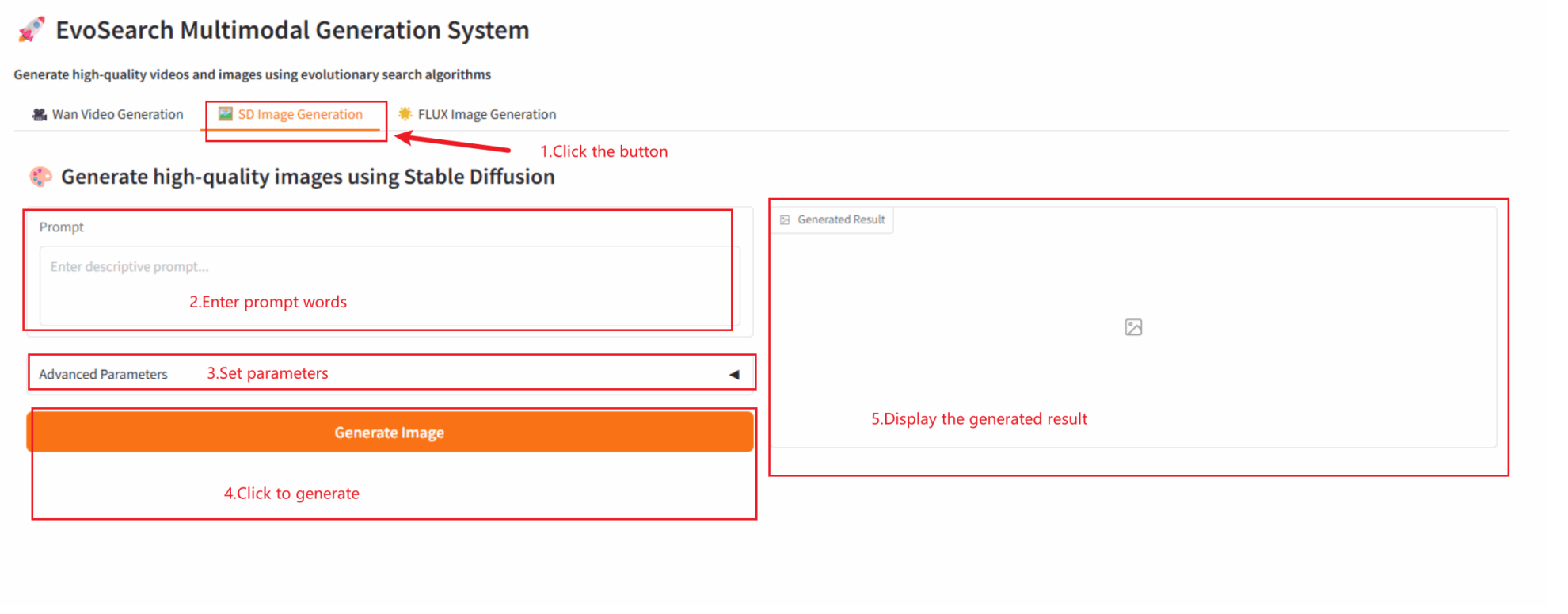

2.2 Génération d'images SD

Conseil : il est préférable d’utiliser l’anglais comme mot d’ordre.

- Paramètres avancés

- Graine aléatoire : Graine aléatoire.

- Taille de l'image : Taille de l'image.

- Étapes d'inférence : Étapes d'inférence.

- Échelle CFG : contrôle la force de l’influence des indices textuels sur l’image générée.

- Itération : nombre d'itérations.

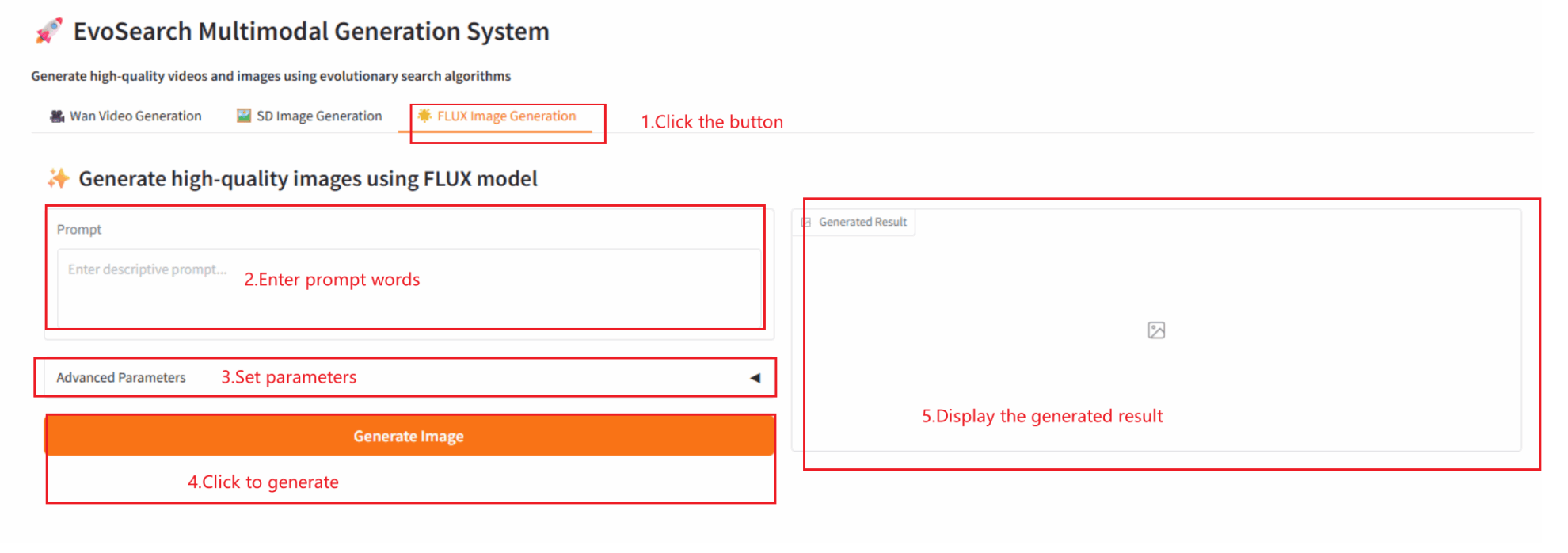

2.3 Génération d'images FLUX

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@misc{he2025scaling,

title={Scaling Image and Video Generation via Test-Time Evolutionary Search},

author={Haoran He and Jiajun Liang and Xintao Wang and Pengfei Wan and Di Zhang and Kun Gai and Ling Pan},

year={2025},

eprint={2505.17618},

archivePrefix={arXiv},

primaryClass={cs.CV}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.