Command Palette

Search for a command to run...

Déploiement vLLM+Open WebUI QwenLong-L1-32B

Date

Taille

96.23 MB

Balises

Licence

Apache 2.0

URL du document

1. Introduction au tutoriel

QwenLong-L1-32B est un modèle de raisonnement sur texte long, publié le 26 mai 2025 par Tongyi Lab et Alibaba Group. Premier modèle de ce type entraîné par apprentissage par renforcement (RL), il vise à résoudre les problèmes de mémoire insuffisante et d'incohérences logiques rencontrés par les modèles traditionnels à grande échelle face à des contextes extrêmement longs (par exemple, 120 000 jetons). Il s'affranchit des limitations contextuelles de ces modèles et offre une solution performante et économique pour des applications exigeantes comme la finance et le droit. Des articles de recherche associés sont disponibles. QwenLong-L1 : Vers des modèles de raisonnement à grande échelle et à contexte long avec apprentissage par renforcement .

Ce tutoriel utilise des ressources RTX A6000 à double carte.

2. Exemples de projets

3. Étapes de l'opération

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

Si « Modèle » n'est pas affiché, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

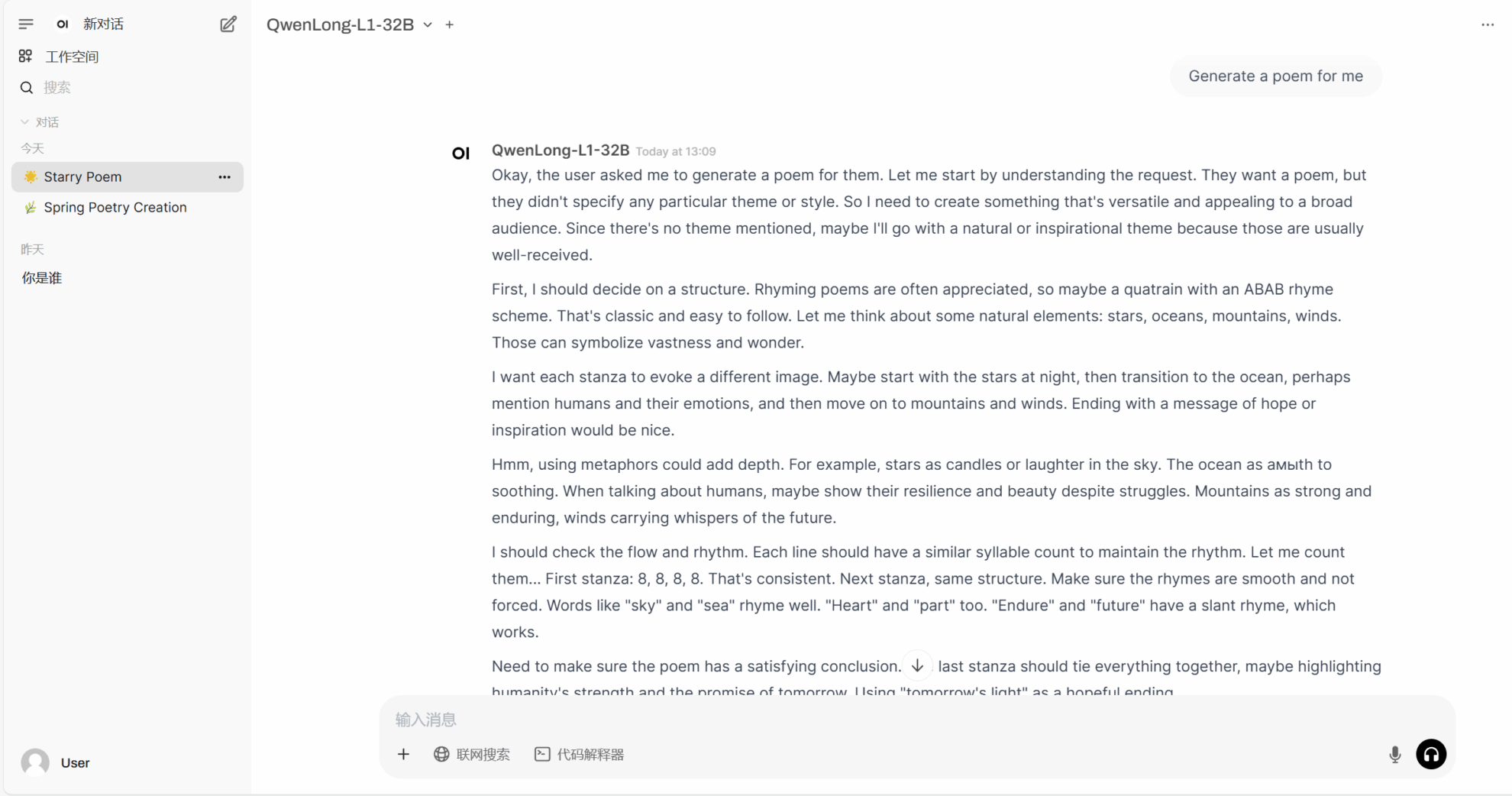

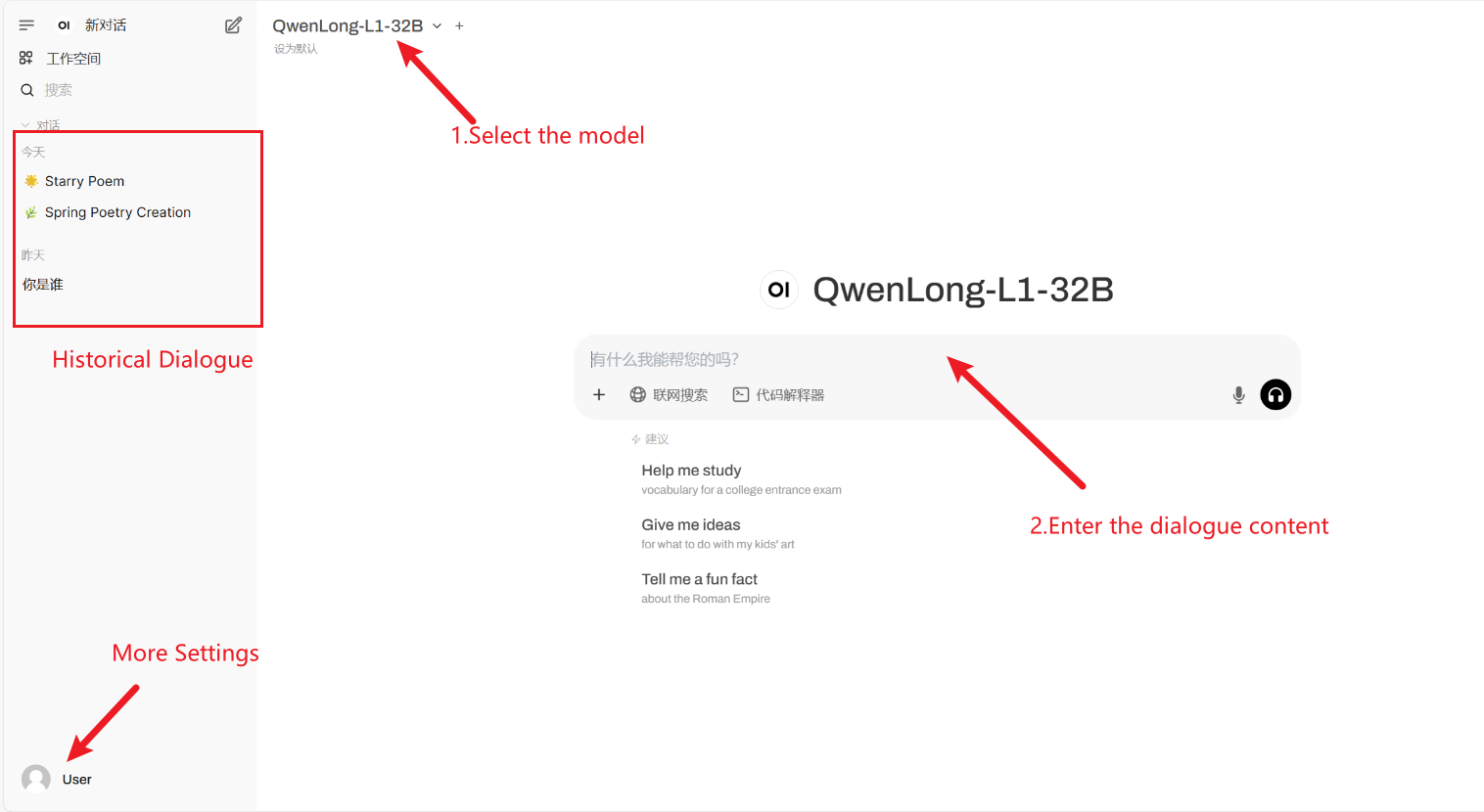

2. Après être entré sur la page Web, vous pouvez démarrer une conversation avec le modèle

Comment utiliser

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Merci à l'utilisateur Github xxxjjjyyy1 Déploiement de ce tutoriel. Les informations de citation pour ce projet sont les suivantes :

@article{wan2025qwenlongl1,

title={QwenLong-L1: : Towards Long-Context Large Reasoning Models with Reinforcement Learning},

author={Fanqi Wan, Weizhou Shen, Shengyi Liao, Yingcheng Shi, Chenliang Li, Ziyi Yang, Ji Zhang, Fei Huang, Jingren Zhou, Ming Yan},

journal={arXiv preprint arXiv:2505.17667},

year={2025}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.