Command Palette

Search for a command to run...

Tutoriel ComfyUI Wan2.1-VACE-14B Sur La Conversion d'images En Vidéos

Date

Taille

1.47 GB

Licence

Apache 2.0

GitHub

URL du document

1. Introduction au tutoriel

Wan2.1-VACE-14B est un modèle unifié de génération et de montage vidéo, open source et développé par l'équipe Tongyi Wanxiang d'Alibaba depuis le 15 mai 2025. Entraîné sur la plateforme Tongyi Wanxiang V2.1, ce modèle est actuellement le premier outil d'IA vidéo du secteur à prendre en charge des combinaisons multitâches flexibles, capable de réaliser l'intégralité du flux de travail, de la génération vidéo au montage précis, en une seule étape. Il prend en charge la conversion de texte en vidéo, d'image en vidéo et de la première/dernière image en vidéo. Des articles de recherche associés sont disponibles. Wan : modèles génératifs vidéo à grande échelle ouverts et avancés .

Ce tutoriel utilise une seule carte A6000. La génération d'une vidéo prend environ 30 minutes. Nous recommandons une puissance de calcul supérieure.

Ce didacticiel de flux de travail utilise les fichiers modèles suivants :

- wan2.1_vace_14B_fp16.safetensors

- wan_2.1_vae.safetensors

- umt5_xxl_fp8_e4m3fn_scaled.safetensors

2. Exemples de projets

3. Étapes de l'opération

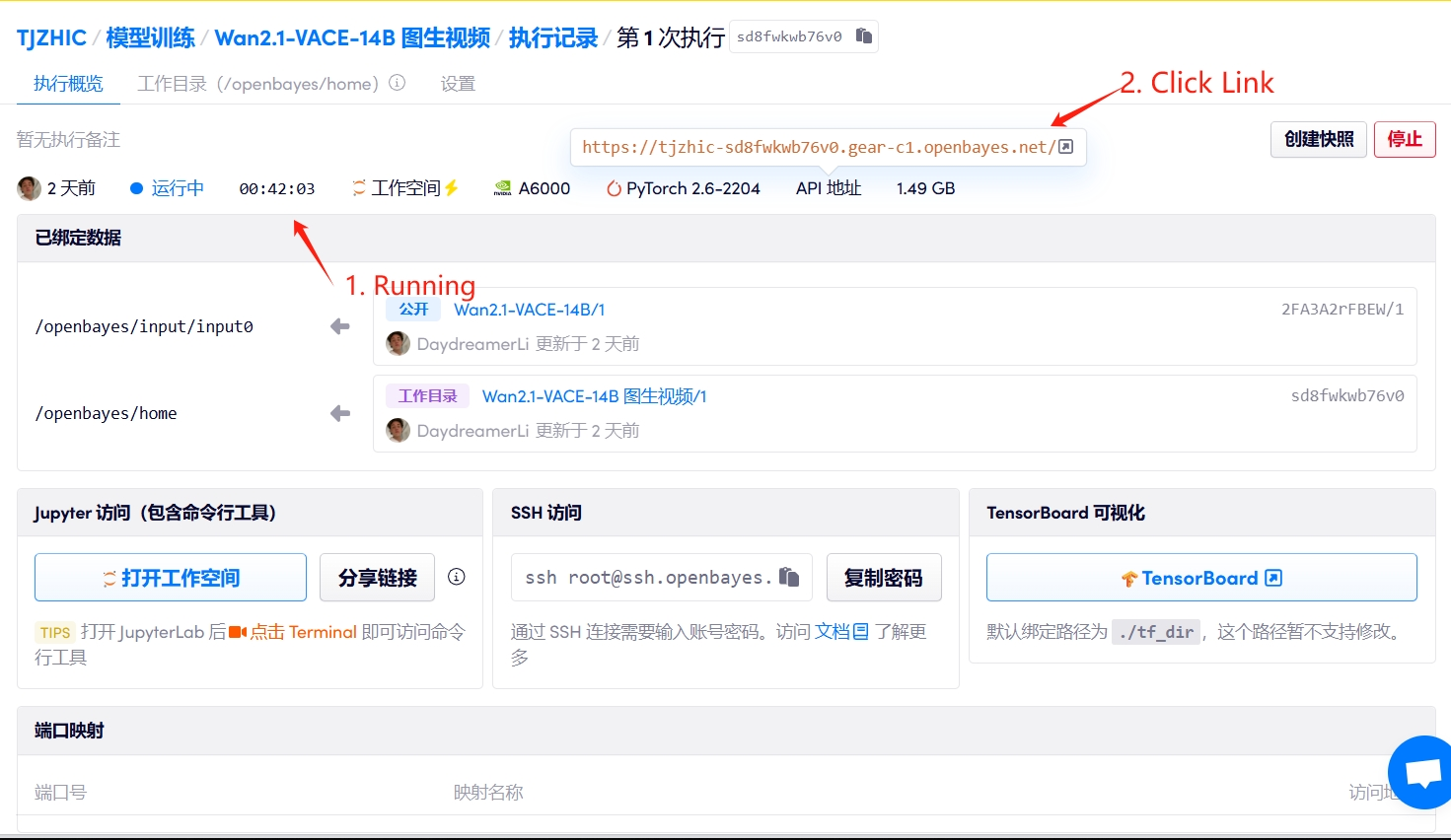

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 1 à 2 minutes et actualiser la page.

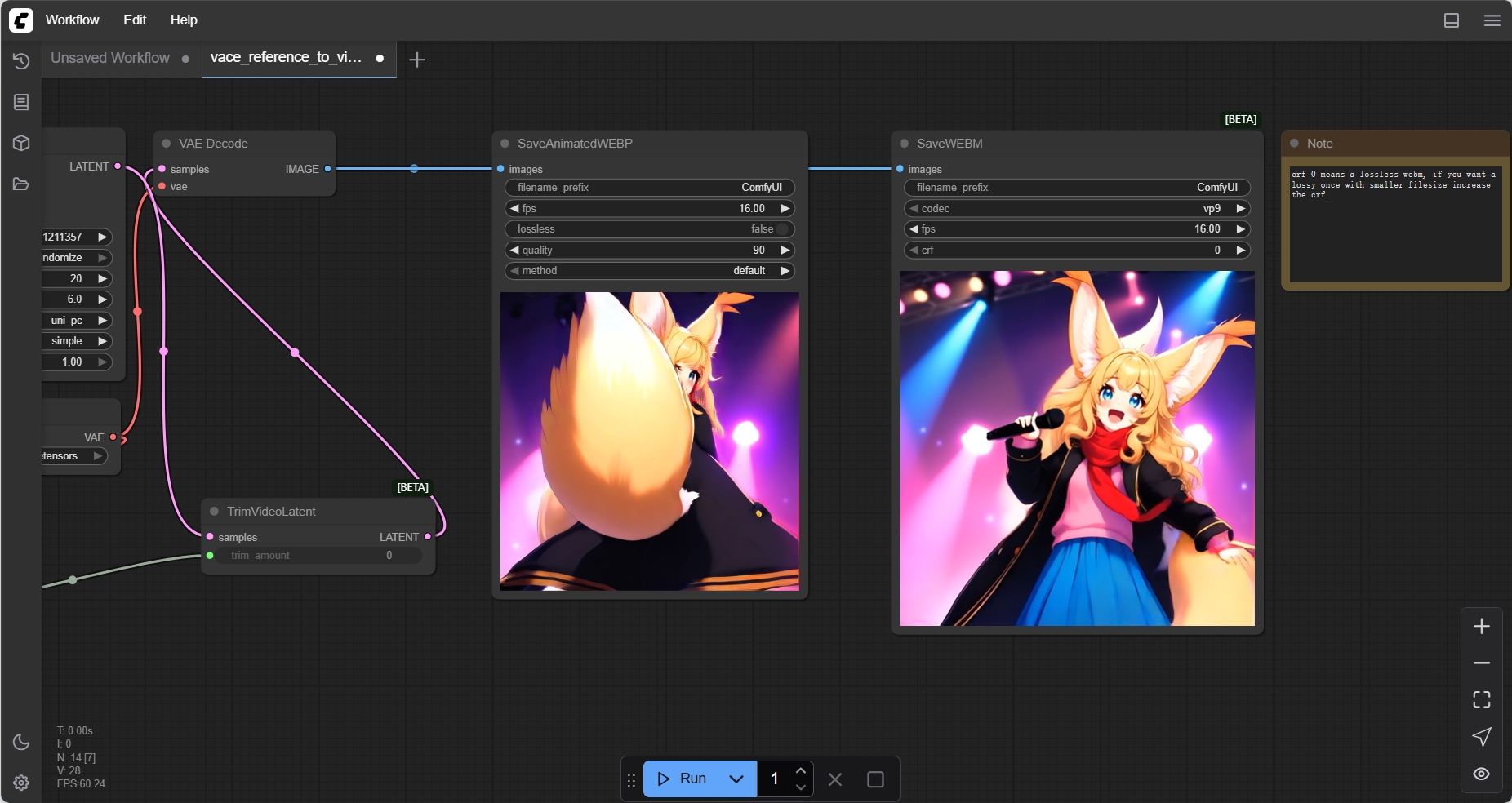

2. Démonstration fonctionnelle

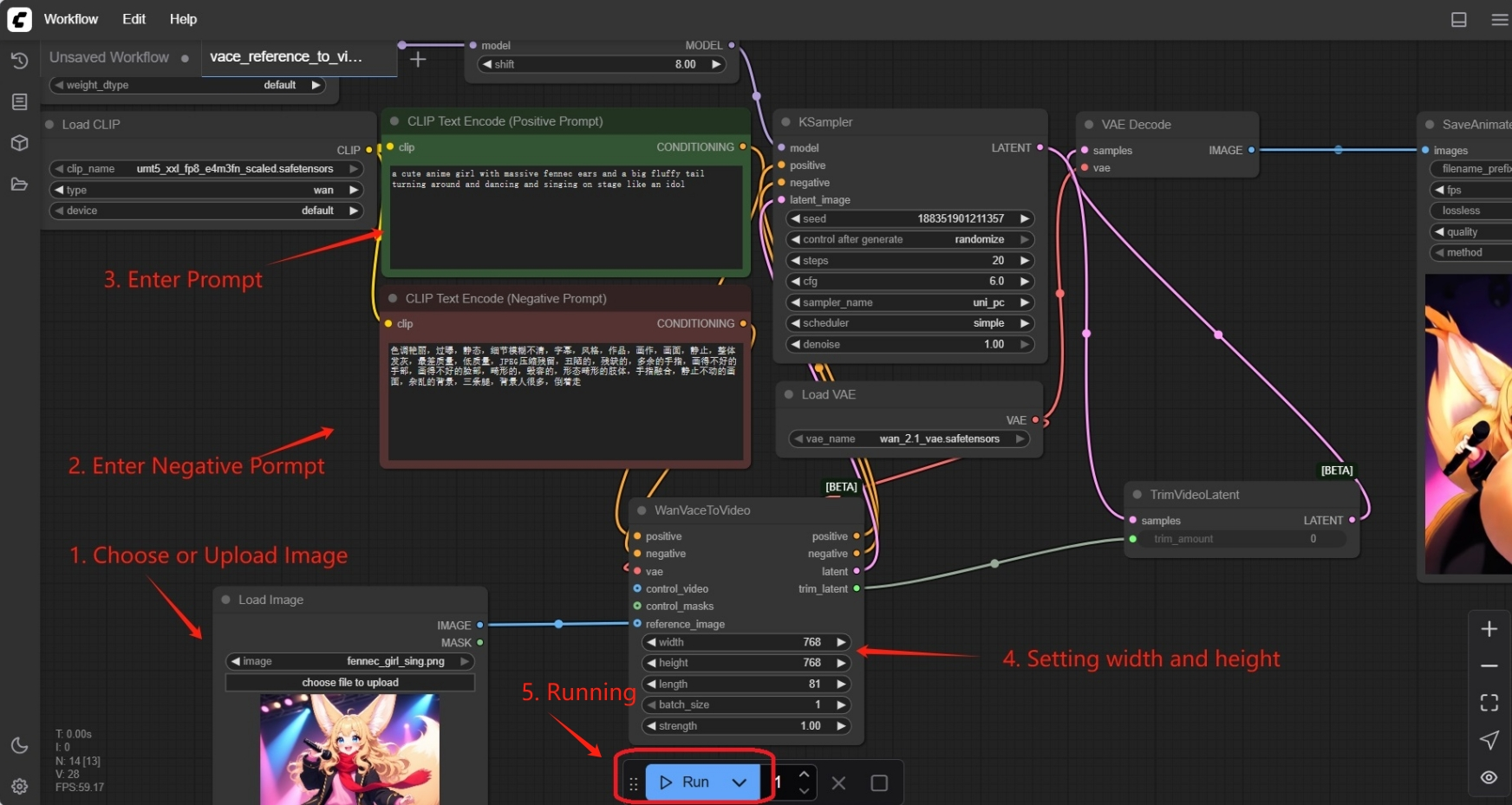

Comment utiliser

La première fois que vous clonez, vous devez ouvrir manuellement le flux de travail dans le dossier et le charger.

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Merci à l'utilisateur Github SuperYang Pour le déploiement de ce tutoriel, les informations de référence du projet sont les suivantes :

@article{wan2025,

title={Wan: Open and Advanced Large-Scale Video Generative Models},

author={Team Wan and Ang Wang and Baole Ai and Bin Wen and Chaojie Mao and Chen-Wei Xie and Di Chen and Feiwu Yu and Haiming Zhao and Jianxiao Yang and Jianyuan Zeng and Jiayu Wang and Jingfeng Zhang and Jingren Zhou and Jinkai Wang and Jixuan Chen and Kai Zhu and Kang Zhao and Keyu Yan and Lianghua Huang and Mengyang Feng and Ningyi Zhang and Pandeng Li and Pingyu Wu and Ruihang Chu and Ruili Feng and Shiwei Zhang and Siyang Sun and Tao Fang and Tianxing Wang and Tianyi Gui and Tingyu Weng and Tong Shen and Wei Lin and Wei Wang and Wei Wang and Wenmeng Zhou and Wente Wang and Wenting Shen and Wenyuan Yu and Xianzhong Shi and Xiaoming Huang and Xin Xu and Yan Kou and Yangyu Lv and Yifei Li and Yijing Liu and Yiming Wang and Yingya Zhang and Yitong Huang and Yong Li and You Wu and Yu Liu and Yulin Pan and Yun Zheng and Yuntao Hong and Yupeng Shi and Yutong Feng and Zeyinzi Jiang and Zhen Han and Zhi-Fan Wu and Ziyu Liu},

journal = {arXiv preprint arXiv:2503.20314},

year={2025}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.