Command Palette

Search for a command to run...

Démonstration Du Modèle De Diffusion Vidéo Vchitect-2.0

Date

Taille

395.28 MB

Licence

Apache 2.0

GitHub

URL du document

Aperçu du projet

Vchitect-2.0 est un système de génération vidéo de haute qualité développé par l'équipe du Laboratoire d'intelligence artificielle de Shanghai en septembre 2024. Ce modèle utilise une architecture Transformer parallèle innovante, possède 2 milliards de paramètres et est capable de générer un contenu vidéo fluide et de haute qualité à partir d'instructions textuelles. Des articles connexes ont démontré son efficacité… Vchitect-2.0 : Transformateur parallèle pour la mise à l'échelle des modèles de diffusion vidéo .

Ce tutoriel utilise des ressources pour une seule carte A6000.

Étapes de course

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 1 à 2 minutes et actualiser la page.

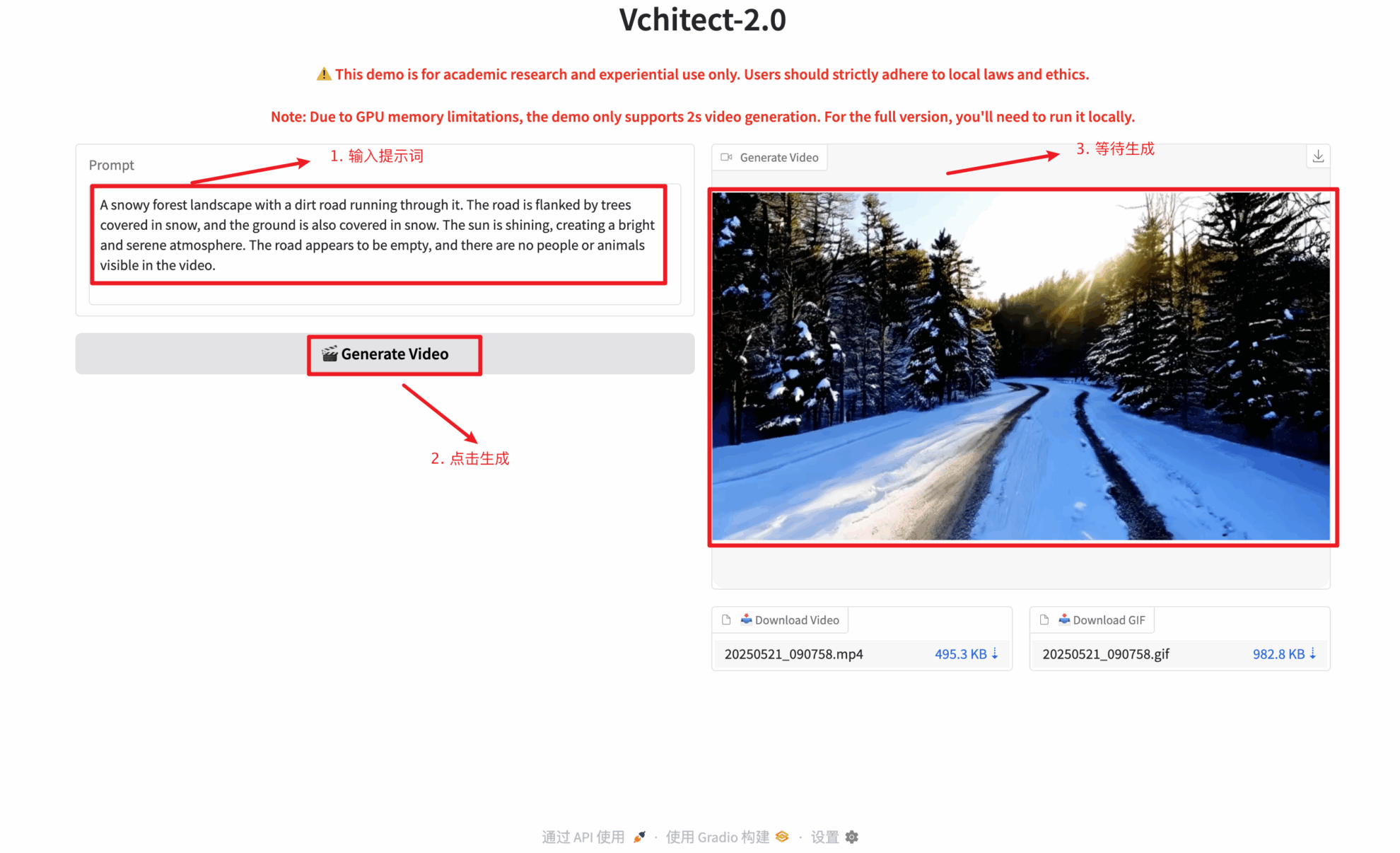

2. Une fois que vous entrez sur la page Web, vous pouvez interagir avec le modèle

Vous devez saisir un texte pour générer une vidéo. Ce texte est uniquement disponible en anglais. La longueur du texte peut varier, mais il est recommandé de ne pas dépasser 100 caractères. Dans le cas contraire, la vidéo générée risque d'être trop longue et d'affecter la qualité. La vidéo doit attendre environ 2 à 5 minutes ; merci de votre patience.

Échange et discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Merci à l'utilisateur Github zhangjunchang Pour le déploiement de ce tutoriel, les informations de référence du projet sont les suivantes :

@article{fan2025vchitect,

title={Vchitect-2.0: Parallel Transformer for Scaling Up Video Diffusion Models},

author={Fan, Weichen and Si, Chenyang and Song, Junhao and Yang, Zhenyu and He, Yinan and Zhuo, Long and Huang, Ziqi and Dong, Ziyue and He, Jingwen and Pan, Dongwei and others},

journal={arXiv preprint arXiv:2501.08453},

year={2025}

}

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.