Command Palette

Search for a command to run...

Déployer Qwen3-30B-A3B Avec vLLM+Open-webUI

1. Introduction au tutoriel

Le projet Qwen3 a été publié par l'équipe Ali Qwen en 2025. Le rapport technique correspondant est Qwen3 : Réfléchissez plus profondément, agissez plus vite .

Qwen3 est la dernière génération de grands modèles de langage de la série Qwen, fournissant des modèles denses complets et des modèles de mélange d'experts (MoE). S'appuyant sur une riche expérience de formation, Qwen3 a réalisé des progrès révolutionnaires en matière de raisonnement, de conformité aux commandes, de capacités d'agent et de support multilingue. La dernière version de Qwen3 présente les fonctionnalités suivantes :

- Modèles experts denses et mixtes pleine grandeur : 0,6B, 1,7B, 4B, 8B, 14B, 32B et 30B-A3B, 235B-A22B

- Soutenu parModèles de pensée(pour le raisonnement logique complexe, les mathématiques et le codage) et le mode non-pensée (pour une conversation générale efficace)Commutation transparente, garantissant des performances optimales dans divers scénarios.

- Capacités de raisonnement considérablement améliorées, surpassant le modèle d'instruction QwQ précédent (en mode réflexion) et Qwen2.5 (en mode non réflexion) en mathématiques, génération de code et raisonnement logique de bon sens.

- Alignement supérieur avec les préférences humaines, excelle dans l'écriture créative, les jeux de rôle, les conversations à plusieurs tours et le suivi des commandes, offrant une expérience de conversation plus naturelle, engageante et immersive.

- Excelle dans les capacités d'agent intelligent, peut intégrer avec précision des outils externes dans les modes de réflexion et de non-réflexion, et est leader dans les modèles open source dans les tâches complexes basées sur des agents.

- Il prend en charge plus de 100 langues et dialectes et dispose de puissantes capacités de compréhension multilingue, de raisonnement, de suivi de commandes et de génération.

Ce tutoriel utilise les ressources du A6000 double SIM.

👉 Ce projet fournit un modèle de :

- Modèle Qwen3-30B-A3B

2. Étapes de l'opération

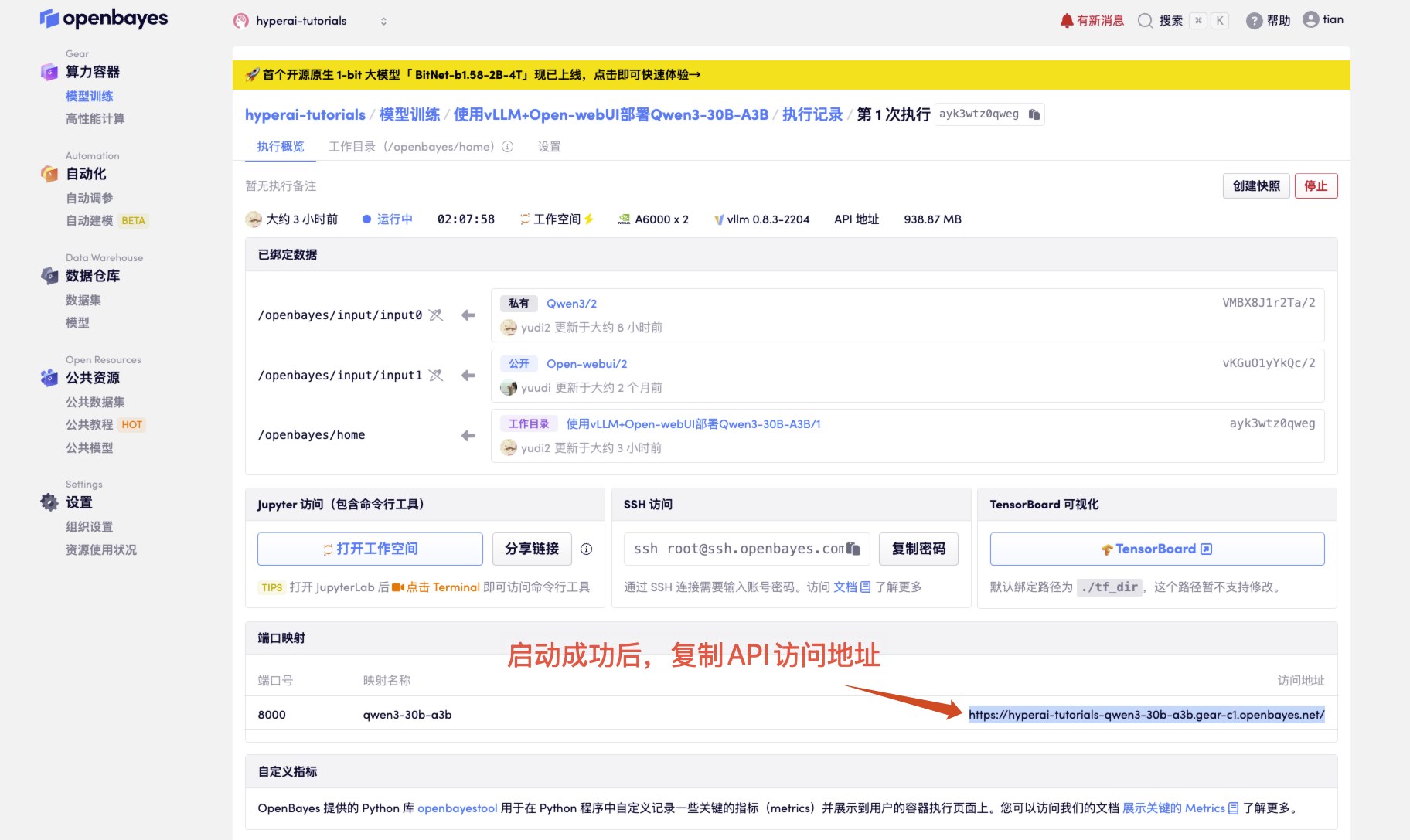

- Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

Si « Modèle » n'est pas affiché, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 1 à 2 minutes et actualiser la page.

2. Après être entré sur la page Web, vous pouvez démarrer une conversation avec le modèle

Comment utiliser

3. Guide d'appel d'API OpenAI

Ce qui suit est une description optimisée de la méthode d'appel d'API, avec une structure plus claire et des détails pratiques ajoutés :

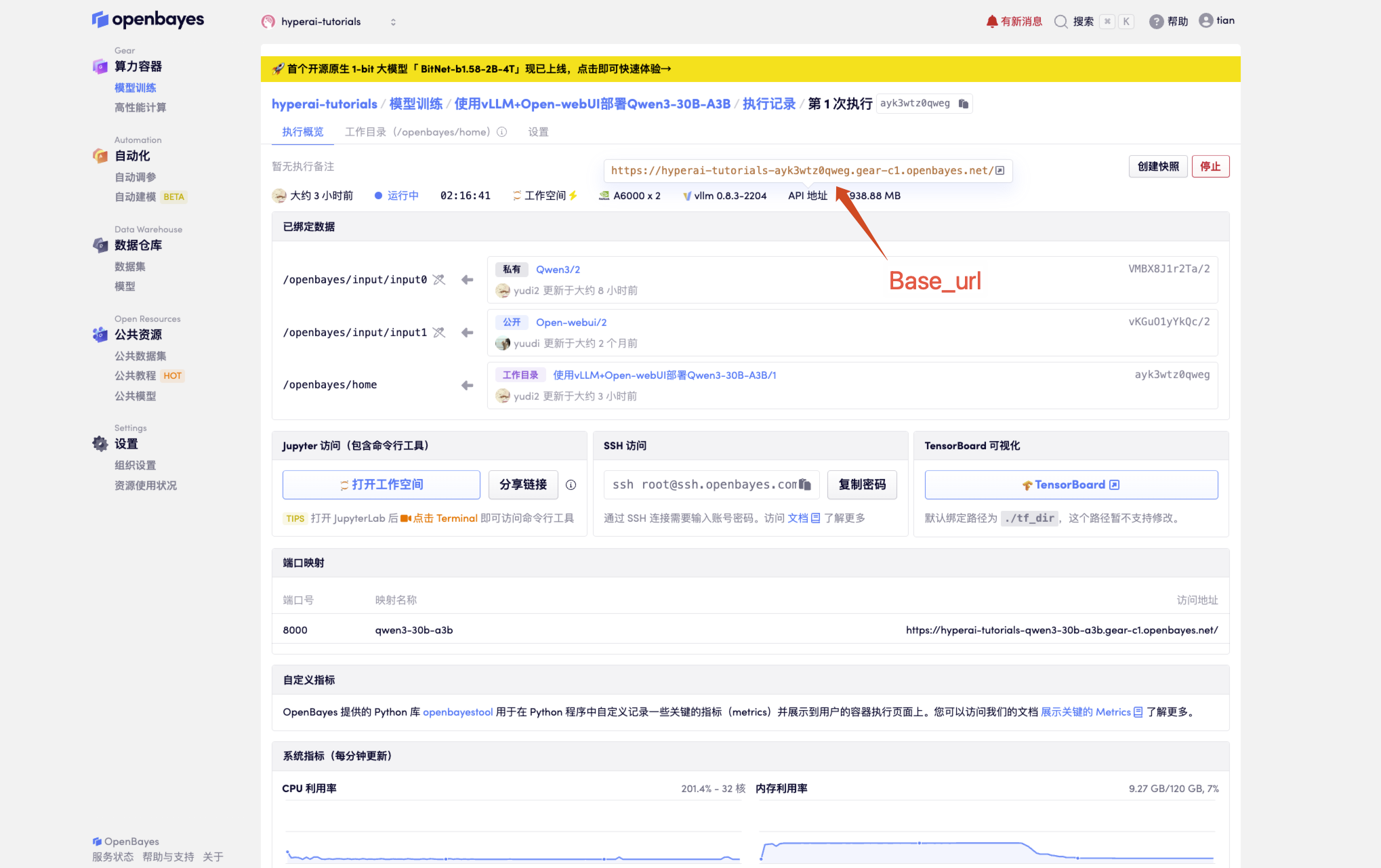

1. Obtenir la configuration de base

# 必要参数配置

BASE_URL = "<API 地址>/v1" # 生产环境

MODEL_NAME = "Qwen3-30B-A3B" # 默认模型名称

API_KEY = "Empty" # 未设置 API_KEY

Obtenir l'adresse de l'API

2. Différentes méthodes d'appel

2.1 Appel Python natif

import openai

# 创建 OpenAI 客户端实例

client = openai.OpenAI(

api_key=API_KEY, # 请替换为你的实际 API Key

base_url=BASE_URL # 替换为你的实际 base_url

)

# 发送聊天消息

response = client.chat.completions.create(

model=MODEL_NAME,

messages=[

{"role": "user", "content": "你好!"}

],

temperature=0.7,

)

# 输出回复内容

print(response.choices[0].message.content)

# 方法 2:requests 库(更灵活)

import requests

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

data = {

"model": MODEL_NAME,

"messages": [{"role": "user", "content": "你好!"}]

}

response = requests.post(f"{BASE_URL}/chat/completions", headers=headers, json=data)

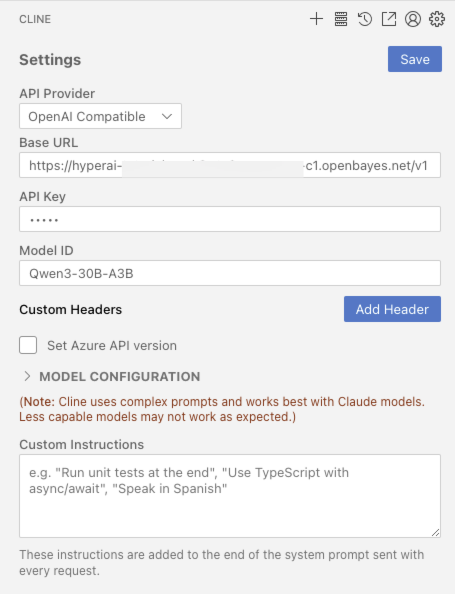

2.2 Intégration des outils de développement

Si VScode est installé officiellement CLINE Plugins

2.3 Appel cURL

curl <BASE_URL>/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": <MODEL_NAME>,

"messages": [{"role": "user", "content": "你好!"}]

}'

Échange et discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

reconnaissant ZV-Liu Pour la réalisation de ce tutoriel, les informations de référence du projet sont les suivantes :

@misc{glm2024chatglm,

title={ChatGLM: A Family of Large Language Models from GLM-130B to GLM-4 All Tools},

author={Team GLM and Aohan Zeng and Bin Xu and Bowen Wang and Chenhui Zhang and Da Yin and Diego Rojas and Guanyu Feng and Hanlin Zhao and Hanyu Lai and Hao Yu and Hongning Wang and Jiadai Sun and Jiajie Zhang and Jiale Cheng and Jiayi Gui and Jie Tang and Jing Zhang and Juanzi Li and Lei Zhao and Lindong Wu and Lucen Zhong and Mingdao Liu and Minlie Huang and Peng Zhang and Qinkai Zheng and Rui Lu and Shuaiqi Duan and Shudan Zhang and Shulin Cao and Shuxun Yang and Weng Lam Tam and Wenyi Zhao and Xiao Liu and Xiao Xia and Xiaohan Zhang and Xiaotao Gu and Xin Lv and Xinghan Liu and Xinyi Liu and Xinyue Yang and Xixuan Song and Xunkai Zhang and Yifan An and Yifan Xu and Yilin Niu and Yuantao Yang and Yueyan Li and Yushi Bai and Yuxiao Dong and Zehan Qi and Zhaoyu Wang and Zhen Yang and Zhengxiao Du and Zhenyu Hou and Zihan Wang},

year={2024},

eprint={2406.12793},

archivePrefix={arXiv},

primaryClass={id='cs.CL' full_name='Computation and Language' is_active=True alt_name='cmp-lg' in_archive='cs' is_general=False description='Covers natural language processing. Roughly includes material in ACM Subject Class I.2.7. Note that work on artificial languages (programming languages, logics, formal systems) that does not explicitly address natural-language issues broadly construed (natural-language processing, computational linguistics, speech, text retrieval, etc.) is not appropriate for this area.'}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.