Command Palette

Search for a command to run...

Démonstration De Paints-Undo De l'ensemble Du Processus De Génération d'une Peinture À Partir d'une Image

Date

Taille

1.38 GB

Balises

Licence

Apache 2.0

GitHub

Introduction au tutoriel

Ce tutoriel est une démonstration d'exécution en un clic de PaintsUndo. L'environnement et les dépendances pertinents ont été installés. Vous pouvez en faire l'expérience en le clonant et en le démarrant en un clic.

PaintsUndo est un modèle de base qui peut simuler le comportement de peinture humaine. Son objectif est de fournir un modèle de base du comportement de peinture pour les humains. Dans le même temps, on espère que les futurs modèles d’IA seront en mesure de mieux répondre aux besoins réels des artistes humains. Ce projet fournit une série de modèles qui prennent une image en entrée et produisent une séquence de dessins de cette image. Le modèle simule le comportement humain pendant le processus de dessin, y compris, mais sans s'y limiter, l'esquisse, l'encrage, l'ombrage, la transformation, le retournement à gauche et à droite, le réglage des courbes de couleur, la modification de la visibilité des calques et même la modification de l'idée globale pendant le processus de dessin. Le nom « Paints-Undo » a été inspiré par la similitude entre la sortie du modèle et l'appui répété sur le bouton « Annuler » (généralement Ctrl+Z) dans un logiciel de peinture IA.

Le projet propose actuellement deux modèles : un modèle à image unique et un modèle à images multiples.

- peintures_annuler_cadre_unique

- peintures_annuler_multi_frame

Le modèle à image unique prend une image et un en entrée et génère une image.

- Supposons que l'œuvre d'art puisse toujours être créée en dessinant manuellement 1000 fois et que l'ordre des dessins soit un entier de 0 à 999. L'ordre représenté par 0 est l'œuvre d'art finale terminée et 999 est le premier coup de pinceau peint sur la toile blanche pure. Ce modèle peut être considéré comme le modèle « Annuler » (ou Ctrl+Z).

- Entrez l'image finale et indiquez combien de fois vous souhaitez "Ctrl+Z". Après avoir appuyé sur « Ctrl+Z », le modèle générera un nombre correspondant de captures d'écran du processus de peinture. Si le nombre de fois sélectionné est 100, cela signifie que vous souhaitez simuler "Ctrl+Z" 100 fois sur cette image pour obtenir une capture d'écran après 100 fois de "Ctrl+Z".

Le modèle multi-images prend deux images en entrée et génère 16 images intermédiaires entre les deux images d'entrée.

- Par rapport au modèle à image unique, la différence entre les deux images est plus petite, mais la vitesse est également beaucoup plus lente et moins aléatoire.

- La génération d'images est limitée à 16 images.

Dans les méthodes de construction de ce projet, la méthode par défaut consiste à les utiliser ensemble. Tout d'abord, utilisez le modèle à image unique pour déduire environ 5 à 7 fois pour obtenir 5 à 7 « images clés », puis utilisez le modèle à images multiples pour « interpoler » ces images clés afin de générer réellement une vidéo relativement longue. Au final, vous pouvez généralement obtenir environ 100 images intermédiaires.

Théoriquement, le système peut être utilisé de diverses manières, même pour fournir des vidéos infiniment longues, mais en pratique, il fonctionne actuellement mieux lorsque le nombre d'images final est d'environ 100 à 500.

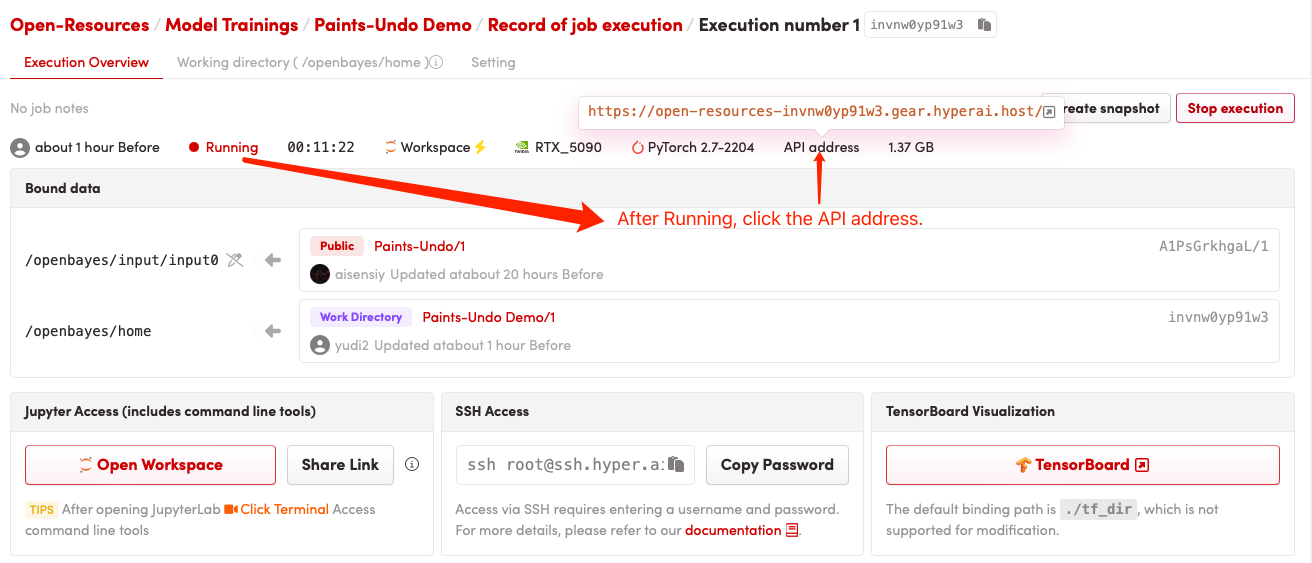

Ce tutoriel utilise une seule carte RTX 5090 comme ressource.

Affichage des effets

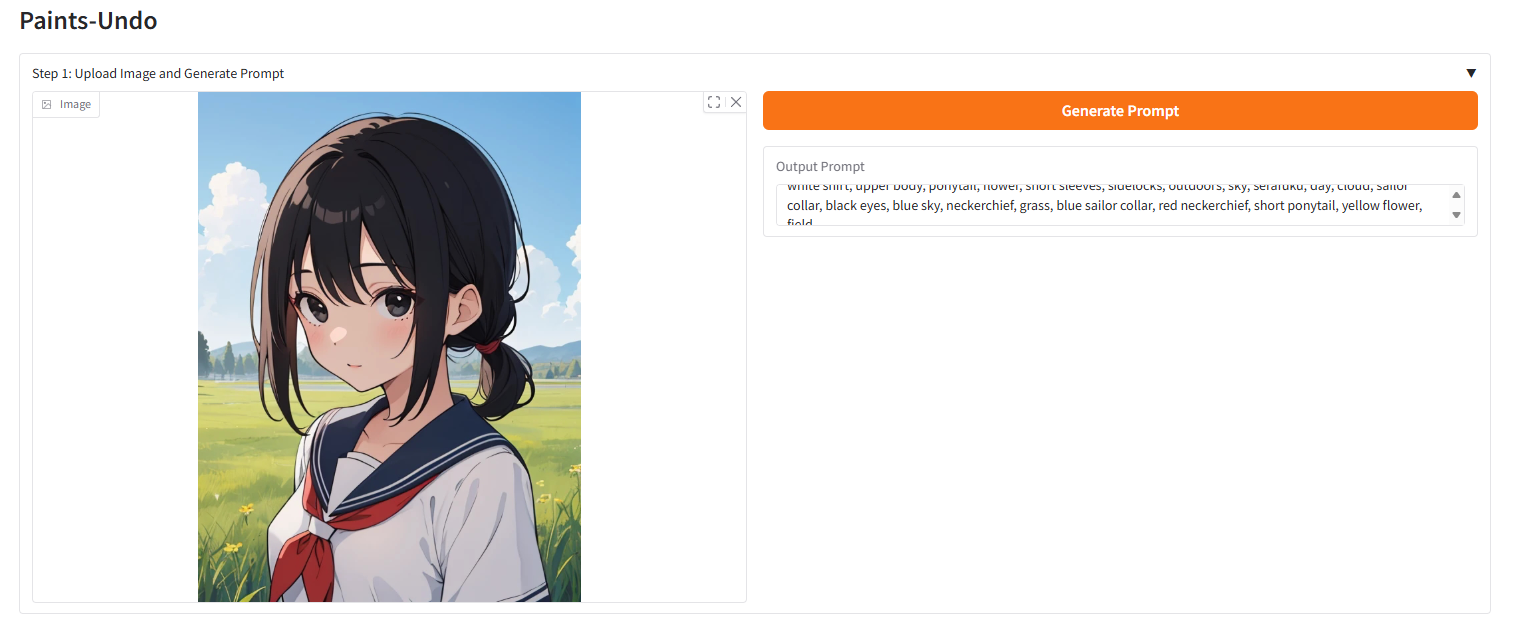

Méthode d'exécution (il faut environ 10 secondes pour initialiser après le démarrage du conteneur, puis effectuer les opérations suivantes)

1. Après avoir cloné et démarré le conteneur, copiez l'API dans votre navigateur

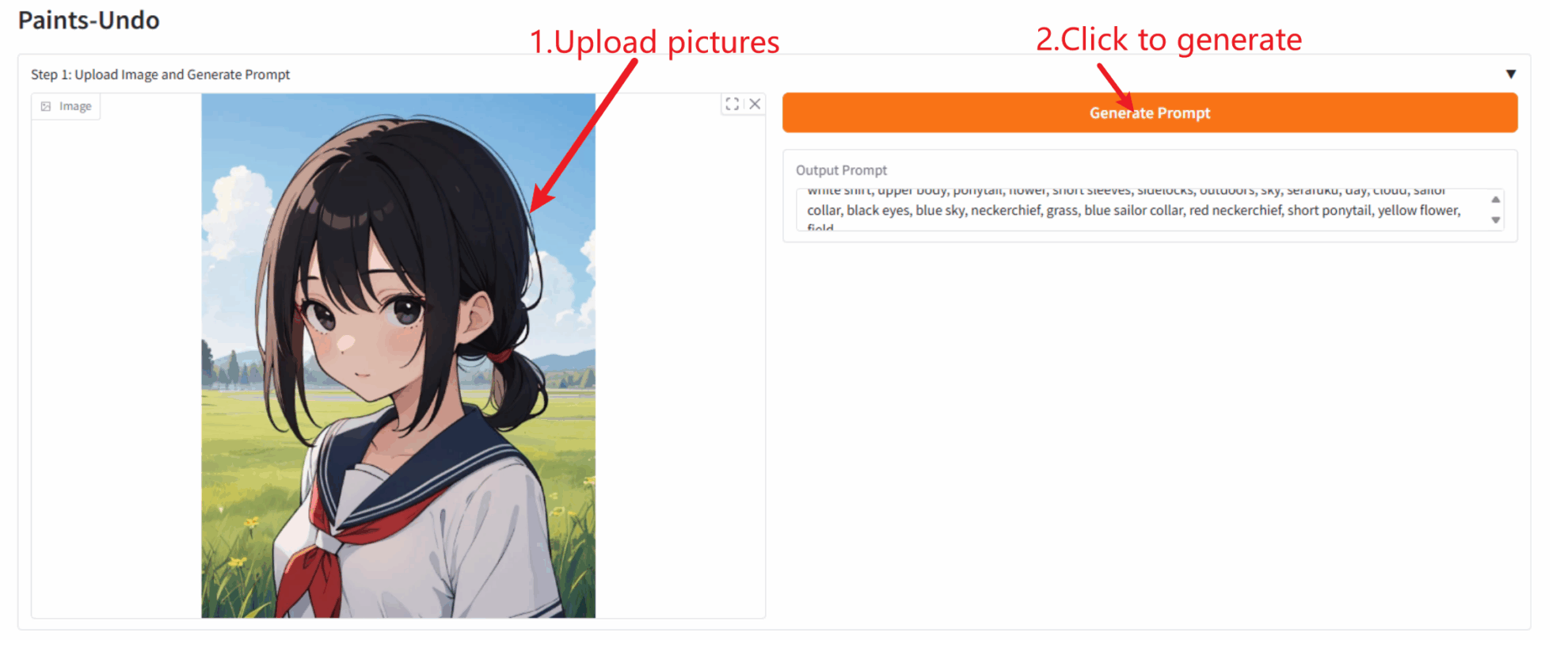

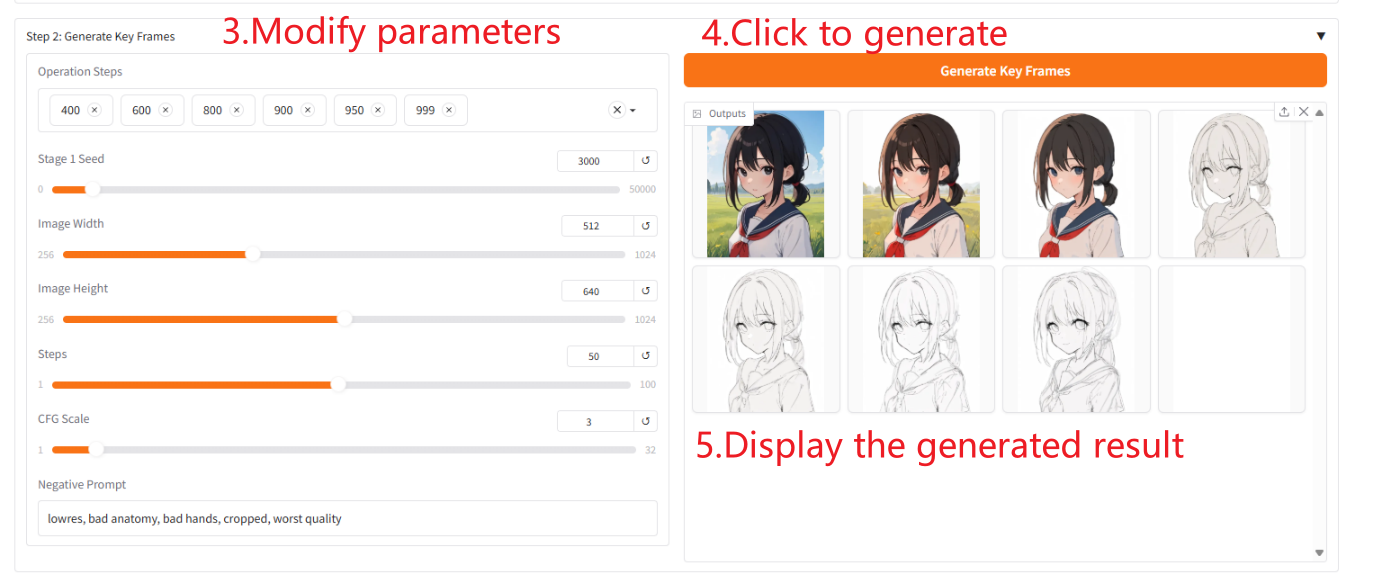

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

Sortie du modèle à image unique

Sortie totale du modèle

Description des paramètres

- « Étapes de l'opération » : vous pouvez sélectionner l'ordre des images clés à générer. Plus l'ordre que vous sélectionnez est grand, plus l'image générée sera similaire à l'image d'origine.

- « Stage 1 Seed » : vous pouvez sélectionner aléatoirement une graine pour la génération d'images clés.

- « Étapes » : vous pouvez sélectionner le nombre d'étapes que le modèle exécute par image.

- 「CFG Scale」 : Vous pouvez contrôler le caractère aléatoire de l'image générée. Plus la valeur est petite, plus le caractère aléatoire de l'image générée est élevé.

- « Invite négative » : remplissez des mots négatifs pour atténuer la situation où les images générées contiennent ces mots négatifs.

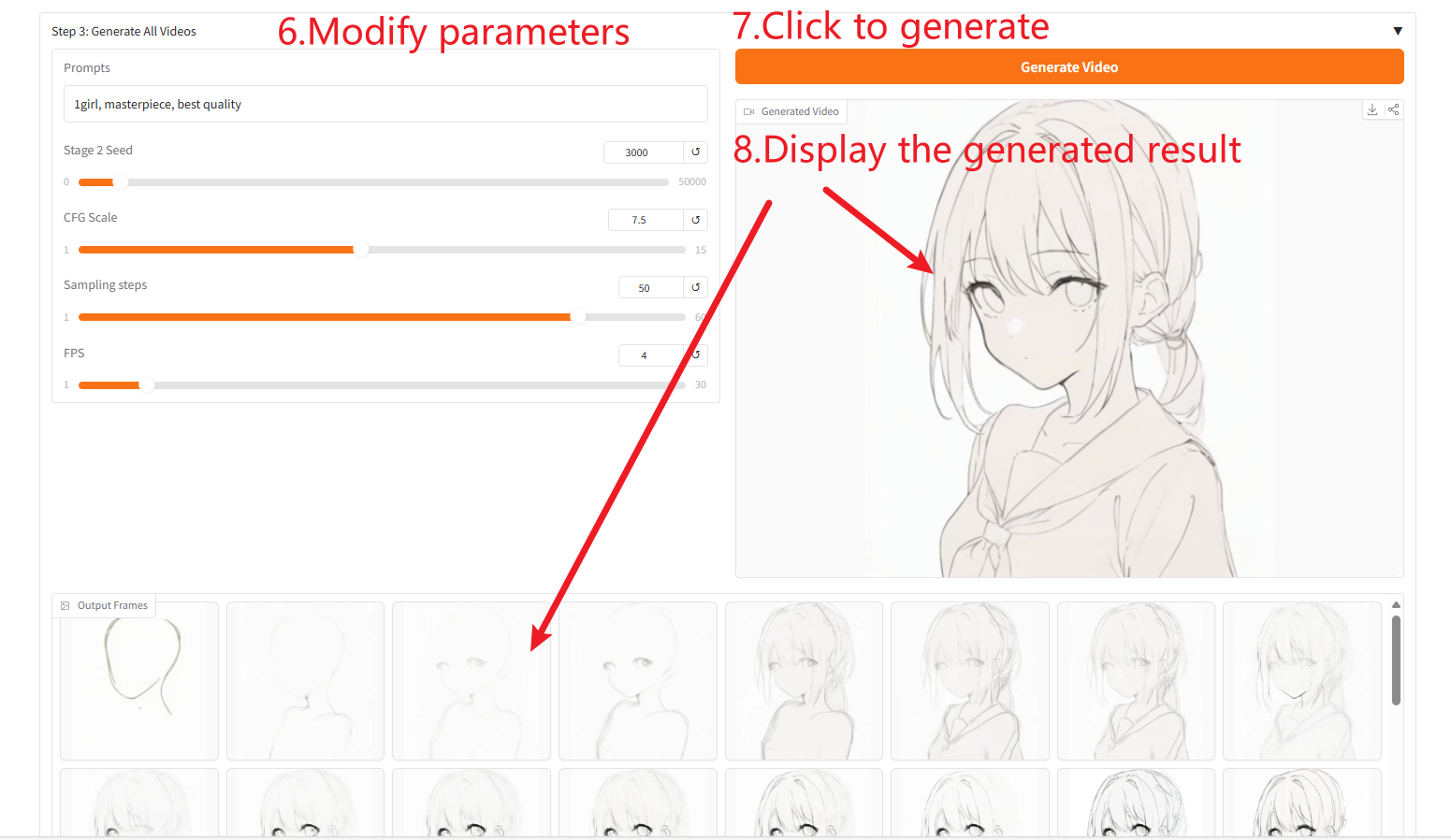

Générer une vidéo

Description des paramètres

- « Invites » : remplissez des invites positives pour améliorer la qualité et le contenu des images générées.

- « Stage 2 Seed » : vous pouvez sélectionner aléatoirement des graines pour la génération d'images.

- 「CFG Scale」 : Vous pouvez contrôler le caractère aléatoire de l'image générée. Plus la valeur est petite, plus le caractère aléatoire de l'image générée est élevé.

- « Étapes d’échantillonnage » : vous pouvez modifier le nombre d’itérations d’échantillonnage. Plus la valeur est élevée, plus l'image générée est précise.

- « FPS » : vous pouvez modifier la fréquence d'images de la vidéo générée. La valeur par défaut est de 4 images, ce qui signifie que la vidéo contient quatre images générées par seconde.

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@Misc{paintsundo,

author = {Paints-Undo Team},

title = {Paints-Undo GitHub Page},

year = {2024},

}

@article{paintsalter,

author = {Zhang, Lvmin and Yan, Chuan and Guo, Yuwei and Xing, Jinbo and Agrawala, Maneesh},

title = {Generating Past and Future in Digital Painting Processes},

journal = {ACM Transactions on Graphics (SIGGRAPH 2025)},

year = {2025},

volume = {44},

number = {4},

articleno = {127},

numpages = {13},

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.