Command Palette

Search for a command to run...

Discussion Avec Le co-auteur De l'article De Couverture De Nature Sur l'histoire De La Recherche Du Mouvement

Le 17 octobre, l'événement « D'AlphaGo à la puce Tianji, semblable à un cerveau, où va l'intelligence artificielle ? » L'événement, organisé par l'Association de l'Université Tsinghua pour la science et la technologie Spark Forum, le Centre de recherche sur l'informatique de type cérébral de l'Université Tsinghua et HyperAI, s'est tenu avec succès dans le bâtiment Meng Minwei de l'Université Tsinghua. Lors de la table ronde d'ouverture, Deng Lei, le premier doctorant de Tsinghua spécialisé dans les ordinateurs de type cérébral, a raconté son parcours avec l'informatique de type cérébral, a interprété l'informatique de type cérébral sous plusieurs angles, a répondu aux questions des étudiants et nous a donné une nouvelle compréhension du développement de l'informatique de type cérébral et de l'intelligence artificielle.

Deng Lei est le premier doctorant de l’Université Tsinghua en informatique inspirée du cerveau et chercheur postdoctoral à l’Université de Californie à Santa Barbara. La couverture du numéro du 1er août du magazine Nature montre l'articleArchitecture de puce hétérogène Tianjic pour l'intelligence artificielle générale, en tant que premier auteur, était responsable de la conception de la puce et des détails de l'algorithme.

Jeudi dernier, le Spark Forum de l'Association pour la science et la technologie de l'Université Tsinghua, en collaboration avec le Brain-Inspired Computing Research Center de l'Université Tsinghua et HyperAI, a organisé un forum sur le thème « D'AlphaGo à la puce Tianji inspirée du cerveau, où va l'intelligence artificielle ? » Deng Lei a été invité en tant qu'invité spécial et a partagé certains de ses points de vue sous la forme d'une table ronde. Cet article suivra les questions du forum et passera en revue certaines de ses idées dans le domaine de l'IA et de l'informatique de type cérébral.

Apprendre et explorer : le premier doctorant au Centre d'informatique inspirée du cerveau

Question : Comment êtes-vous entré dans le domaine de la recherche sur l’informatique de type cérébral ? En quoi consiste exactement ce sujet ?Lorsque j’étudiais pour mon doctorat en informatique cérébrale, ce n’était pas encore populaire. Je l'ai cherché à l'époque, mais je n'ai pas trouvé beaucoup d'informations utiles. Plus tard, j'ai demandé spécifiquement à mon superviseur...

En tant que premier doctorant au Brain-Inspired Computing Research Center, j'ai été témoin du développement du centre depuis le début jusqu'à ce qu'il soit là où il est aujourd'hui.Y compris plus tard la création d'une entreprise et la réalisation de recherches. Après 2017, j'ai obtenu mon diplôme et je suis parti aux États-Unis, puis je me suis tourné vers l'informatique. Nous avons maintenant 50% pour la théorie et 50% pour les puces.

J'ai étudié la mécanique au premier cycle, mais plus tard, j'ai découvert que je n'avais pas beaucoup de talent pour la mécanique, alors je me suis progressivement tourné vers la fabrication d'instruments. Plus tard, j'ai également fabriqué des robots et étudié certains matériaux et la microélectronique. Après cela, j'ai commencé à travailler sur certains algorithmes et théories de l'IA, puis je suis finalement passé aux puces et suis lentement entré dans le domaine de l'informatique de type cérébral.Le processus est probablement le suivant : continuer à avancer et continuer à apprendre en cours de route.

Remarque : Le Centre de recherche sur l'informatique inspirée du cerveau de l'Université Tsinghua a été créé en septembre 2014 et couvre plusieurs niveaux, notamment la théorie de base, les puces inspirées du cerveau, les logiciels, les systèmes et les applications. Ce centre est établi conjointement par sept écoles et départements de l'Université Tsinghua, intégrant des disciplines telles que les sciences du cerveau, l'électronique, la microélectronique, l'informatique, l'automatisation, les matériaux et les instruments de précision.

La recherche sur l’informatique de type cérébral implique l’intégration croisée de plusieurs disciplines.La source est certainementMédecine (sciences du cerveau), l’intelligence artificielle d’aujourd’hui est issue à l’origine de la psychologie et de la médecine, qui ont fourni une certaine base au modèle.

La prochaine étape estApprentissage automatiqueIls se réuniront certainement à l’avenir, mais ils sont désormais abordés séparément car l’apprentissage automatique a plus d’expérience dans le développement de produits et est généralement envisagé dans une perspective d’application.

En outrel'informatiqueIl existe désormais des problèmes que le GPU ne peut pas résoudre, c'est pourquoi Alibaba et Huawei ont commencé à fabriquer leurs propres puces dédiées. Les étudiants se spécialisant en architecture informatique peuvent également envisager de se développer dans cette direction.

Plus bas se trouvePuces et autres matérielsCela implique la microélectronique et même les matériaux, car nous devons fournir de nouveaux appareils. Nous utilisons encore aujourd’hui des unités de stockage très basiques, mais de nouveaux dispositifs apparaîtront certainement à l’avenir, tels que les nanotubes de carbone, le graphène et d’autres matériaux qui pourront être appliqués.

En outreDirection de l'automatisationDe nombreuses personnes qui s’intéressent à l’apprentissage automatique sont généralement issues des départements d’informatique et d’automatisation, car l’automatisation concerne le contrôle et l’optimisation, ce qui est similaire à l’apprentissage automatique. Dans l’informatique de type cérébral, ces disciplines sont bien intégrées.

Question : Quelle a été la force motrice ou l’opportunité qui vous a poussé à choisir cette direction ?

En un mot,Le plus grand charme de cette direction est qu’elle n’est jamais terminée.

J’ai un jour pensé à un paradoxe philosophique : l’étude de l’informatique de type cérébral est indissociable du cerveau humain, mais en utilisant le cerveau humain pour penser au cerveau humain, nous ne savons pas jusqu’où nous pouvons aller, et l’étude de celui-ci ne finira jamais. Parce que la pensée des êtres humains sur eux-mêmes existera toujours. Il y aura toujours un point culminant, puis une période de stagnation, et soudain, il y aura une percée. Cela ne s'arrêtera jamais. Cette perspective mérite d’être étudiée.

Question : Quelles sont les différences dans vos recherches au cours de votre période postdoctorale actuelle ?

Lorsque je travaillais sur les puces à l’Université Tsinghua, j’étais plus préoccupé par les aspects pratiques, pensant que je pouvais fabriquer un appareil ou un instrument. Mais après être allé aux États-Unis, j'ai considéré cette question davantage d'un point de vue disciplinaire, comme l'architecture informatique des majors en informatique et de nombreux prix ACM Turing, qui examinent tous le problème sous cet angle. Même si nous faisons la même chose, les angles de pensée sont différents.

Du point de vue de l’architecture informatique,Toute puce est composée de trois aspects : une unité de calcul, une unité de stockage et une unité de communication.Peu importe ce que vous faites, cela s’inscrit dans le cadre de ces trois choses.

Puce Tianji et informatique cérébrale : les vélos ne sont pas au centre des préoccupations

Question : Cet article dans Nature est un événement marquant. Selon vous, quels événements marquants ont eu lieu au cours des dernières décennies ? Dans le domaine de l’informatique de type cérébral, quels événements ont stimulé le développement de l’industrie ?

Le domaine de l’informatique de type cérébral est relativement complexe. Si je le décortique dans le contexte de l’intelligence artificielle, ce sera plus clair. L’intelligence artificielle n’est pas une discipline unique et peut être divisée en quatre directions.

Le premier est l’algorithme, le deuxième les données, le troisième la puissance de calcul et le dernier les outils de programmation.Les événements marquants peuvent être envisagés sous ces quatre angles.

En termes d’algorithmes, il s’agit bien sûr de réseaux neuronaux profonds, cela ne fait aucun doute ; Du point de vue des données, ImagNet est une étape importante. Sans le soutien du Big Data, les réseaux neuronaux profonds étaient presque enterrés. Du point de vue de la puissance de calcul, le GPU est une belle réussite. Les outils de programmation, tels que les applications populaires telles que TensorFlow de Google, sont un facteur important de développement.

Ces éléments favorisent l’avancement de l’IA et constituent un processus de développement itératif. Sans aucun d’entre eux, nous n’aurions pas la situation actuelle. Mais l’IA a aussi ses propres limites. Par exemple, AlphaGo ne peut effectuer qu'une seule tâche et ne peut rien faire d'autre que jouer aux échecs. C'est différent du cerveau.

Le deuxième est l’interprétabilité. Nous utilisons des réseaux neuronaux profonds pour l’ajustement, y compris l’ajout d’apprentissage par renforcement, mais on ne sait toujours pas ce qui se passe à l’intérieur d’eux. Certaines personnes tentent de visualiser ce processus ou d’en comprendre les principes.

Le troisième est la robustesse. L’IA n’est pas aussi stable que les humains. Par exemple, dans le cas de la conduite autonome, l’IA actuelle n’est utilisée que pour la conduite assistée car elle ne peut pas garantir une sécurité absolue. En raison de ces lacunes, nous devons prêter attention au développement de la science du cerveau et introduire davantage de mécanismes scientifiques dans ce domaine.À mon avis, le plus urgent est de rendre l’intelligence plus universelle.

En ce qui concerne les événements marquants, AlphaGo en fait partie. Parce que cela a amené l’IA à l’attention du public et a incité tout le monde à y prêter attention, et l’apprentissage par renforcement n’est devenu populaire qu’après. Du point de vue des puces, il existe deux types de puces : celles qui se concentrent sur les algorithmes et celles inspirées par les cerveaux biologiques. Il y a deux étapes importantes dans le développement de ces deux types de puces.

La première catégorie est l’apprentissage automatique. Les réseaux neuronaux profonds sont désormais calculés sur des GPU, mais les GPU ne sont pas les plus efficaces. Un groupe d’entreprises comme Cambrian recherche des solutions pour remplacer les GPU. C'est un événement important.

L’autre catégorie ne se limite pas à l’apprentissage automatique. Il s’agit de trouver des modèles du point de vue du cerveau et de fabriquer des puces dédiées. IBM ou Intel font mieux à cet égard.

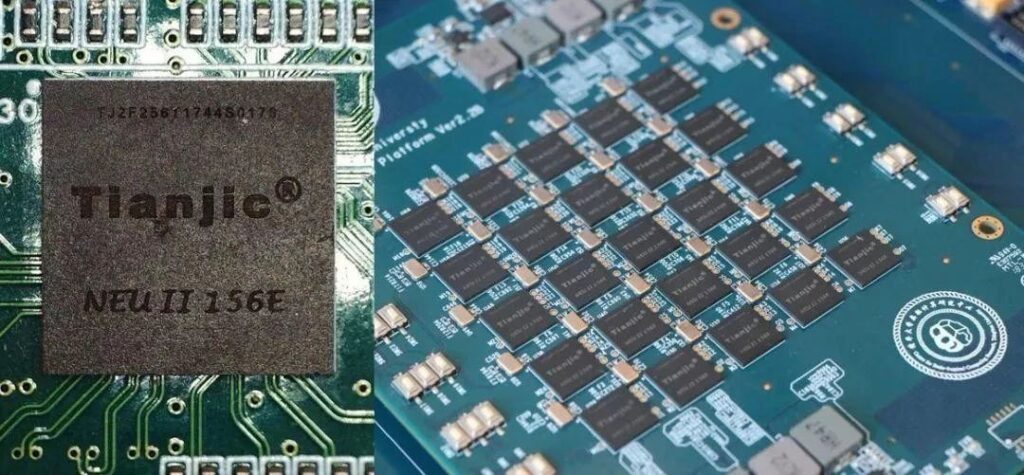

La raison pour laquelle la puce Tianji a attiré autant d’attention est qu’elle intègre les avantages respectifs de ces deux catégories dans une seule architecture.

Question : Votre équipe a publié le test de la puce Tianji sur les vélos. Pouvez-vous nous donner plus de détails à ce sujet ?

Tout le monde sur Internet était attiré par les vélos, mais notre équipe savait que les vélos n’étaient pas notre centre d’intérêt. Il s'agissait simplement d'une plateforme de démonstration, car à l'époque nous réfléchissions à trouver une bonne plateforme pour la montrer à tout le monde.

La démonstration du vélo comprend la vision, l’ouïe et le contrôle du mouvement. Le fait de pouvoir réaliser ces fonctions avec une seule puce en fait une plateforme idéale. Nous y réfléchissions à l’époque sous cet angle. Le contrôle du vélo n’est pas très difficile. Nous voulions simplement démontrer un nouveau modèle.

L'avenir de l'informatique cérébrale : briser l'architecture de von Neumann

Question : Quel est le lien entre l’intelligence artificielle future ou l’informatique de type cérébral et l’architecture von Neumann existante ? Vont-ils évoluer vers la forme du cerveau humain ?

C’est une question très importante. Il existe une tendance fondamentale dans l’industrie actuelle des semi-conducteurs, notamment le prix Turing 2018, qui a également été décerné aux chercheurs effectuant des recherches sur l’architecture informatique. Il existe deux directions pour améliorer les performances du GPU. La première consiste à rendre le transistor plus petit, c'est-à-dire à le miniaturiser physiquement, en suivant la loi de Moore. Mais au cours des deux dernières années, tout le monde s'est rendu compte que la loi de Moore commençait à échouer, que les développements connexes devenaient de plus en plus lents et qu'un jour, il ne serait plus possible de la réduire.

Une autre direction consiste à développer une architecture informatique et à essayer de faire en sorte que l'unité de calcul, l'unité de stockage et la communication fonctionnent toutes avec une grande efficacité grâce à la conception du cadre. Le cerveau humain est incroyable. Grâce à l’accumulation des connaissances, les connaissances de chaque génération augmentent. Nous devrions tirer des leçons de l’évolution de ces connaissances.

Au cours du siècle dernier, le développement des processeurs à usage général a essentiellement suivi la loi de Moore. Comme les transistors pouvaient être fabriqués de plus en plus petits, le développement de l’architecture informatique a été dans une certaine mesure enterré. Maintenant que la loi de Moore a été entravée et que des applications telles que l'IA nécessitent la recherche d'une efficacité de traitement élevée, la recherche sur l'architecture informatique a de nouveau retenu l'attention, et la prochaine décennie sera l'âge d'or des processeurs dédiés.

Lorsqu’il s’agit de recherche sur le cerveau, la question que les gens se posent le plus souvent est : que peut faire l’informatique de type cérébral ?

C’est un problème fatal. De nombreuses personnes travaillant dans le domaine de l’intelligence artificielle ou des sciences du cerveau ne comprennent pas clairement le mécanisme qui se cache derrière. Prenons l’exemple des sciences du cerveau : il existe trois niveaux qui sont actuellement assez déconnectés.

La première est de savoir comment fonctionnent exactement les cellules nerveuses. De nombreux scientifiques médicaux et biologistes mènent encore des explorations et des recherches difficiles sur cette question.

La deuxième est la façon dont les cellules nerveuses sont connectées. Il y a 10 à la puissance 11 des cellules nerveuses dans le cerveau. La manière dont ils sont connectés est également difficile à comprendre et nécessite la puissance de l’optique et de la physique.

Enfin, nous devons savoir comment ils apprennent, ce qui est aussi la question la plus difficile mais la plus importante.

Il y a un fossé dans tous les aspects, mais les difficultés ne peuvent pas être une raison pour abandonner l’exploration.Si vous ne faites rien, vous n’aurez aucune chance. Faire quelque chose à chaque niveau aboutira toujours à quelque chose de nouveau, puis continuera à itérer.

Si nous attendons que la science du cerveau soit pleinement comprise avant de procéder, il sera trop tard et d’autres nous auront sûrement devancés.

Par exemple, fabriquer un processeur n’est pas aussi simple que tout le monde le pense. Ce n’est pas que les Chinois ne sont pas intelligents. Il en va de même pour les moteurs. Tout le monde comprend les principes, mais il n’est pas facile de bien les appliquer. La difficulté d’ingénierie et l’accumulation technique ne peuvent pas être obtenues du jour au lendemain.

L’une des raisons est que de nombreuses choses ont une grande chaîne industrielle. Si vous ne le faites pas dès le début, vous perdrez de nombreuses opportunités d’essais et d’erreurs. Il n’y aura pas de percées rapides dans ce domaine et nous ne pouvons procéder que de manière pragmatique. Quant à l’avenir, l’intelligence artificielle actuelle, l’intelligence artificielle forte, l’intelligence artificielle 2.0 et l’informatique de type cérébral, je pense qu’elles finiront toutes au même endroit, car elles proviennent toutes du cerveau, mais ont simplement des directions différentes.

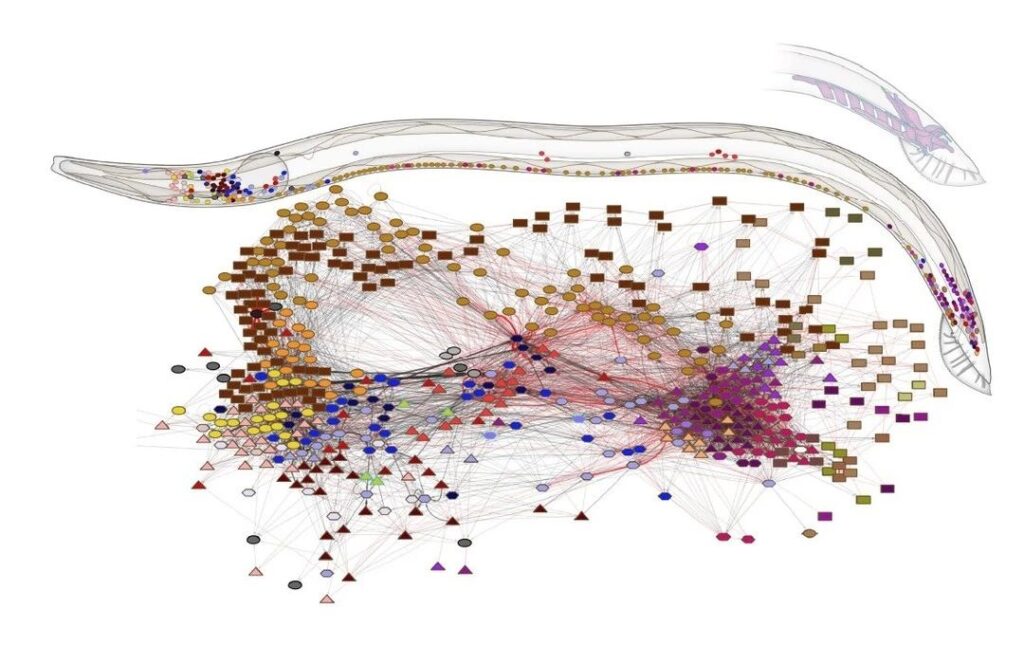

Question : Il y a quelque temps, il y avait un autre article dans Nature dans lequel les chercheurs ont dessiné une carte complète de tous les neurones des nématodes et de toutes les 7 000 connexions entre tous les neurones.

Question : Ce travail est-il lié à la recherche sur le cerveau ? Pouvons-nous utiliser la technologie existante ou le processeur de von Neumann pour simuler la tâche du nématode ? À quel genre de choses pouvons-nous nous attendre dans les 3 à 5 prochaines années ?

J'ai lu les recherches sur la structure des nématodes, et elles ont un grand impact sur la recherche sur le cerveau. En fait, les structures de connexion des modèles d’IA actuels, qu’il s’agisse d’informatique de type cérébral ou d’intelligence artificielle, sont principalement dérivées des réseaux neuronaux profonds hiérarchiques actuels, qui sont en réalité très superficiels.

Notre cerveau n’est pas un simple réseau en couches, le cerveau ressemble plutôt à un graphique. De plus, les connexions entre les différentes régions du cerveau sont très complexes. L’importance de cette étude est qu’elle nous amène à réfléchir à la question de savoir si nous pouvons apprendre de ce mode de connexion.

Il y avait un point de vue avant que dans la structure du réseau neuronal,Le rôle de la structure de connexion est en fait supérieur au poids spécifique de chaque connexion, c'est-à-dire que la signification de la connexion est supérieure à la signification de chaque paramètre.

La raison pour laquelle les réseaux neuronaux convolutifs sont plus puissants que les réseaux neuronaux précédents est que leur structure de connexion est différente, donc leur capacité à extraire des caractéristiques est plus forte. Cela montre également que la structure de connexion entraînera des changements dans les résultats.

Il est en fait un peu difficile d’obtenir ce résultat sur les processeurs traditionnels. La caractéristique la plus typique de l'architecture von Neumann est la nécessité d'une unité de stockage très claire et d'une unité de calcul très claire.

Mais il n’y a pas de limites aussi claires dans notre cerveau. Bien que nous ayons un hippocampe spécifiquement responsable de la mémoire à long terme, du point de vue du réseau neuronal, on ne sait pas clairement quel groupe de cellules du cerveau est responsable du stockage et lequel est uniquement destiné au calcul.

Le cerveau ressemble davantage à un réseau chaotique, où le calcul et le stockage sont difficiles à distinguer. De ce point de vue, il est donc difficile d’utiliser les technologies traditionnelles de puces ou de processeurs.

Nous devons donc développer de nouvelles méthodes non-Von Neumann et utiliser un nouveau support architectural pour mener des recherches similaires à celles menées sur le cerveau.

Par exemple, le prix Turing 2018 a annoncé que les puces de domaine spécialisées deviendraient de plus en plus populaires. Ce que NVIDIA promeut actuellement, c'est une architecture hétérogène, où il y a plusieurs petits cœurs IP de puces sur une seule plateforme, ce qui peut être similaire au cerveau humain.

Par conséquent, ce n’est plus comme avant où un seul processeur pouvait résoudre tous les problèmes, et il n’existe pas de puce unique capable de résoudre tous les problèmes de manière efficace. À l’avenir, diverses technologies de développement efficaces et spécialisées émergeront progressivement, ce qui constitue la tendance actuelle.

À l’heure actuelle, la compréhension des sciences du cerveau ou de l’informatique de type cérébral n’est pas aussi approfondie que celle de l’intelligence artificielle. Une raison très importante est que les investisseurs et l’industrie ne se sont pas encore vraiment impliqués. Par conséquent, la puissance de calcul des données et les outils sont difficiles à mettre en œuvre. L’informatique de type cérébral en est à ses débuts. Je crois qu’à mesure que de plus en plus d’universités et d’entreprises s’impliqueront, les choses deviendront beaucoup plus claires.

Question : Quelles sont les différences entre l’architecture des puces de type cerveau et l’architecture traditionnelle de von Neumann ?

Les puces de type cerveau peuvent être divisées en puces de type cerveau et puces informatiques. D’un point de vue cérébral, il ne s’agit pas seulement du réseau neuronal profond de l’IA, mais combine également certains calculs scientifiques du cerveau.

Du point de vue architectural, il existe un goulot d’étranglement dans le système von Neumann. L’architecture de l’ensemble de l’industrie des semi-conducteurs est en réalité confrontée à ce problème : à mesure que la capacité de stockage devient de plus en plus grande, sa vitesse devient de plus en plus lente. Si vous souhaitez étendre l’échelle et augmenter la vitesse en même temps, c’est impossible à réaliser. Fondamentalement, les personnes qui conçoivent l’architecture étudient principalement comment optimiser la hiérarchie de stockage et la rendre plus rapide.

Tianji est différent des autres architectures et n'utilise pas de mémoire nécessitant une extension.La puce Tianji ressemble davantage à un cerveau, qui équivaut à des cellules connectées en de nombreux petits circuits, qui à leur tour s'étendent en de nombreux réseaux, et forment finalement des zones et des systèmes fonctionnels.Il s’agit d’une structure facilement évolutive, contrairement à un GPU.

L'architecture décentralisée multicœur de la puce Tianji détermine qu'elle peut être facilement étendue à un grand système sans les contraintes des murs de stockage. Il s’agit en fait d’une architecture non-von Neumann qui intègre le stockage et le calcul. C’est la plus grande différence entre lui et les processeurs existants au niveau architectural. La précédente est la différence au niveau du modèle, qui sont fondamentalement les différences entre ces deux catégories.