Command Palette

Search for a command to run...

Articles IJCAI 2019 : Les Équipes Chinoises Représentent 38%, l'Université De Pékin Et l'Université De Nanjing Sont Sur La Liste

La conférence de haut niveau sur l'IA IJCAI 2019 s'est conclue avec succès le 16 août. Au cours de cet événement technologique de sept jours, les participants ont découvert les scénarios d'application de la technologie de l'IA dans divers domaines lors d'ateliers, écouté des discours liminaires prononcés par des vétérans de l'IA et ont eu l'occasion de découvrir les histoires historiques du développement de l'IA ainsi que les derniers progrès et tendances lors de tables rondes. De plus, les articles inclus dans la conférence constituent sans aucun doute le contenu le plus populaire. Nous avons spécialement compilé un certain nombre d’articles sélectionnés par domaine à partager avec vous.

Les principales conférences sur l'IA IJCAI 2019 L'événement s'est tenu à Macao, en Chine, du 10 au 16 août et s'est terminé avec succès.

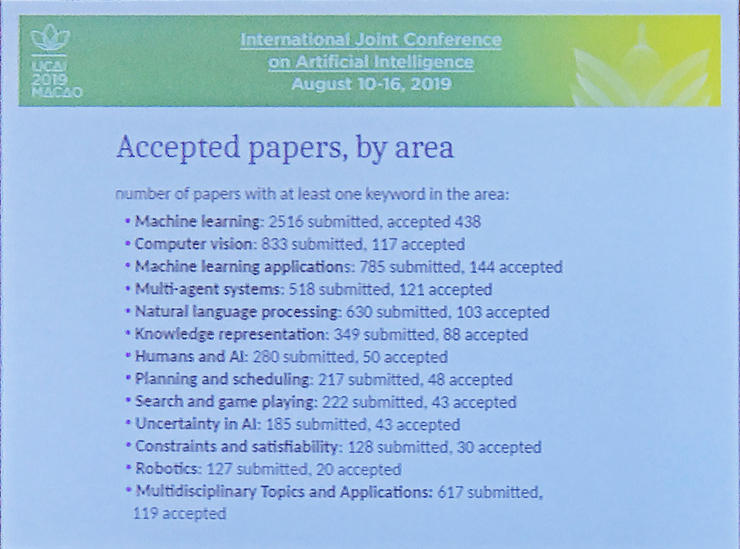

Lors de la cérémonie d’ouverture du 13 août, les organisateurs de la conférence ont examiné les articles inclus dans la conférence. Le président de la conférence, Thomas Eiter, a annoncé les informations suivantes : Cette année, l'IJCAI a reçu un total de 4 752 soumissions d'articles, et le nombre final d'articles inclus a atteint un niveau record. 850 articles,Le taux d'acceptation est de 17,9%.

Ensuite, Sarit Kraus, présidente du comité du programme de la conférence, a donné une explication détaillée du statut des communications. Par rapport aux 3 470 articles inclus l'année dernière, le taux de croissance cette année est de 37%. Parmi les 850 articles inclus,Il y a 327 articles en provenance de Chine, représentant 38%.

Sur le sujet du papier,L’apprentissage automatique reste le domaine le plus en vogue.Le nombre d'articles inclus est de 438, soit plus de la moitié,De plus, le domaine avec le plus grand nombre d’articlesIl s’agit de la vision par ordinateur, des applications d’apprentissage automatique et du traitement du langage naturel.

Cette année, un total de 73 présidents de secteur, 740 membres principaux du comité de programme et 2 696 membres du comité de programme ont participé à l’examen des articles. Quels sont les articles remarquables qu'ils ont examinés ?

Un article unique et primé

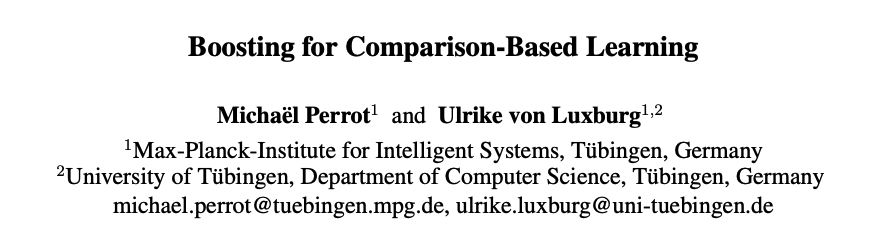

L'IJCAI 2019 a sélectionné un article parmi 850 articlesArticles remarquables(Document distingué) :

Résumé : Les auteurs ont étudié unProblèmes de classification basés sur des conditions de contraste.Ce type de problème est généralement le suivant : étant donné un ensemble, nous ne pouvons obtenir qu'une triple information, qui est la comparaison de trois cibles. Par exemple, si la distance entre x_i et x_j est inférieure à la distance entre x_i et x_k, comment classons-nous x_i ? Dans cet article, les chercheurs ont proposé TripletBoostUn algorithme peut apprendre un classificateur à partir de telles données triplets. L'idée principale de l'article est que les informations de distance apportées par le triplet sont entrées dans un classificateur faible, qui peut être progressivement mis à niveau vers un classificateur fort de manière sérielle.

Ces méthodes comprennentDeux avantages :Tout d’abord, cette méthode peut être appliquée dans différents espaces matriciels. De plus, cette méthode permet de résoudre les triples informations qui ne peuvent être obtenues que de manière passive ou qui sont bruyantes dans de nombreux domaines. Dans leur article, les chercheurs ont vérifié théoriquement la faisabilité de cette méthode et ont proposé une limite inférieure au nombre de triplets à obtenir. Grâce à des expériences, ils affirment que cette méthode est meilleure que les méthodes existantes et qu'elle est plus résistante au bruit.

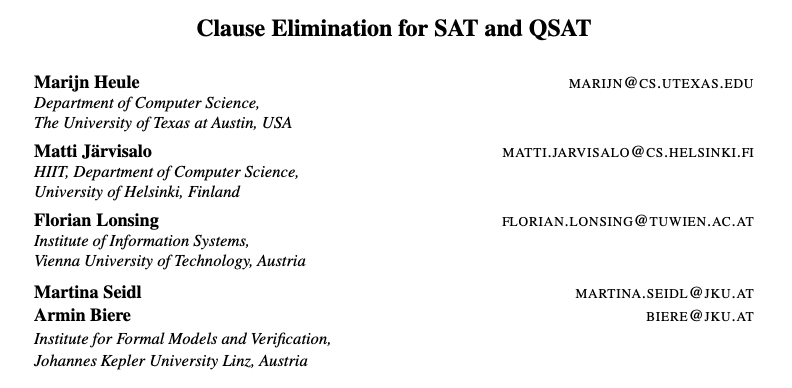

Obtenir IJCAI-JAIR Meilleur articleLe meilleur papier est :

Remarque : Ce prix est décerné aux articles publiés dans JAIR au cours des cinq dernières années.

Résumé : L'article affirme que le problème NP-complet le plus typique, la satisfiabilité booléenne (SAT) et sa généralisation PSPACE-complète, la satisfiabilité booléenne quantifiée (QAT), sont au cœur du paradigme de programmation déclarative.Il peut résoudre efficacement divers cas réels de problèmes informatiques complexes.Le succès dans ce domaine est obtenu grâce à SAT et QSAT Ceci est réalisé grâce à une avancée dans la mise en œuvre pratique des procédures de décision, à savoir les solveurs SAT et QSAT. Dans cet article, les chercheurs développent et analysent une procédure d’élimination de clauses pour le prétraitement et le post-traitement. Le processus d'élimination des clauses forme un ensemble de techniques de simplification formelle (P)CNF, de sorte que les clauses avec certaines propriétés redondantes peuvent être supprimées en temps polynomial tout en maintenant la satisfiabilité de la formule.

En plus de ces articles primés, en tant que l'une des conférences les plus en vogue dans le domaine de l'intelligence artificielle, l'IJCAI s'est classée parmi les meilleures conférences en termes de nombre de soumissions et d'acceptations d'articles au fil des ans, et de nombreux excellents articles y sont produits.

Par conséquent, Super Neuro de cette conférence IJCAIChaud 3Dans chaque numéro, nous sélectionnons un ou deux articles sélectionnés et donnons une brève introduction, afin d'avoir un aperçu de la situation générale de l'IJCAI.

Domaine le plus en vogue : Apprentissage automatique

Articles sélectionnés sur l'apprentissage automatique 1

Résumé : La tâche de réponse aux questions vidéo ouvertes consiste à générer automatiquement des réponses textuelles à partir du contenu vidéo de référence en fonction d'une question donnée.

Actuellement, les méthodes existantes adoptent souvent des réseaux d’encodeurs-décodeurs récurrents multimodaux, mais elles manquent de modélisation de dépendance à long terme, ce qui les rend inefficaces pour répondre à de longues questions vidéo.

Pour résoudre ce problème, les auteurs ont proposé uneRéseau d'encodeur-décodeur convolutionnel hiérarchique rapide à auto-attention (HCSA).En utilisant un encodeur d'auto-attention avec des convolutions en couches,Modélisez efficacement du contenu vidéo long.

HCSA construit une structure hiérarchique de séquences vidéo et capture les dépendances à long terme tenant compte des questions du contexte vidéo. De plus, un décodeur d'attention multi-échelle est conçu, qui fusionne plusieurs couches de représentation pour générer la réponse, évitant la perte d'informations de la couche de codage supérieure.

Les résultats expérimentaux montrent que cette méthode fonctionne bien sur plusieurs ensembles de données.

Articles sélectionnés sur l'apprentissage automatique 2

Résumé : L’application de l’apprentissage automatique est souvent limitée par la quantité de données étiquetées efficaces, et l’apprentissage semi-supervisé peut résoudre efficacement ce problème.

Cet article propose un algorithme d'apprentissage semi-supervisé simple et efficace.Formation à la cohérence de l'interpolation(Formation à la cohérence d'interpolation, TIC).

L'ICT rend les prédictions interpolées pour les points non étiquetés cohérentes avec les prédictions interpolées pour ces points.Dans les problèmes de classification, les TIC déplacent la limite de décision vers les régions à faible densité de la distribution des données. Il n'utilise presque aucun calcul supplémentaire et ne nécessite pas la formation d'un modèle génératif, et même sans réglage étendu des hyperparamètres, il fonctionne très bien lorsqu'il est appliqué aux architectures de réseaux neuronaux standard sur les ensembles de données de référence CIFAR-10 et SVHN.Des performances de pointe atteintes.

Domaine le plus en vogue Hot 2 : la vision par ordinateur

Articles sélectionnés en vision par ordinateur 1

Résumé : Les caractéristiques de plusieurs échelles peuvent grandement aider la tâche de détection des contours sémantiques. Cependant, les méthodes courantes de détection des contours sémantiques appliquent une stratégie de fusion à poids fixe, où les images avec des sémantiques différentes sont obligées de partager les mêmes poids, ce qui conduit à des poids de fusion universels pour toutes les images et tous les emplacements, indépendamment de leurs sémantiques différentes ou de leurs contextes locaux.

Ce travail propose uneNouvelle stratégie de fusion de fonctionnalités dynamiques,Attribuez de manière adaptative différents poids de fusion à différentes images et emplacements d'entrée. Ceci est réalisé grâce à l'apprenant de poids proposé pour déduire les poids de fusion appropriés pour une entrée spécifique avec des fonctionnalités à plusieurs niveaux à chaque position de la carte des fonctionnalités.

De cette façon, l'hétérogénéité des contributions apportées par les différents emplacements des cartes de caractéristiques et des images d'entrée peut être mieux prise en compte, facilitant ainsi la génération deDes prévisions plus précises et plus précises.

Articles sélectionnés en vision par ordinateur 2

Résumé : L’estimation de la profondeur monoculaire est une tâche importante dans la compréhension de la scène. Les objets et les structures sous-jacentes des objets dans des scènes complexes sont essentiels pour des cartes de profondeur récupérées avec précision et visuellement attrayantes. La structure globale reflète la disposition de la scène et la structure locale reflète les détails de la forme. Les méthodes d’estimation de profondeur basées sur CNN développées ces dernières années ont considérablement amélioré les performances de l’estimation de la profondeur. Cependant, peu d’entre eux prennent en compte les structures multi-échelles dans les scènes complexes.

Cet article propose uneRéseau pyramidal résiduel sensible à la structure pour une prédiction de précision profonde à l'aide de structures multi-échelles(SARPN), un décodeur pyramidal résiduel (RPD) est proposé, qui représente la structure de la scène globale dans la couche supérieure pour représenter la disposition, et la structure locale dans la couche inférieure pour représenter les détails de forme ; à chaque couche, un module de raffinement résiduel (RRM) de la carte résiduelle prédite est proposé pour ajouter progressivement des structures plus fines sur la structure grossière prédite dans la couche supérieure ; afin d'exploiter pleinement les caractéristiques des images multi-échelles, un module de fusion adaptative de caractéristiques denses (ADFF) est proposé, qui fusionne de manière adaptative les caractéristiques effectives de chaque échelle pour l'inférence de la structure de chaque échelle. Les résultats expérimentaux sur l’ensemble de données NYU-Depth v2 montrent que la méthode proposée atteint des performances de pointe en matière d’évaluation qualitative et quantitative.La précision a atteint 0,749, le taux de rappel a atteint 0,554 et le score F1 a atteint 0,630.

Domaine le plus en vogue Hot 3 : Traitement du langage naturel (TALN)

Articles sélectionnés sur la PNL 1

Résumé : Les réseaux neuronaux récurrents (RNN) sont largement utilisés dans le domaine du traitement du langage naturel (TAL), notamment la classification de textes, la réponse aux questions et la traduction automatique. Normalement, les RNN ne peuvent réviser que du début à la fin et ont une faible capacité à traiter des textes longs. Dans les tâches de classification de texte, un grand nombre de mots dans de longs documents ne sont pas pertinents et peuvent être ignorés. Face à cette situation, l’auteur de cet article proposeLSTM amélioré :Saut-LSTM.

Leap-LSTM peut lire du texteSautez entre les mots de manière dynamique.À chaque étape, Leap-LSTM utilise plusieurs encodeurs de fonctionnalités pour extraire des informations du texte précédent, du texte suivant et du mot actuel, puis décide d'ignorer ou non le mot actuel. Sur cinq ensembles de données de référence, dont AGNews, DBPedia, Yelp F. Yelp P. et Yahoo,L'effet de prédiction du Leap-LSTM est supérieur à celui du LSTM standard, et le Leap-LSTM a une vitesse de lecture plus élevée.

Articles sélectionnés sur la PNL 2

Résumé : Cet article étudieProblème d'alignement d'entités basé sur l'intégration de graphes de connaissances.Les travaux précédents se concentrent principalement sur la structure relationnelle des entités, et certains intègrent en outre d’autres types de fonctionnalités, telles que des attributs, pour les affiner.

Cependant, un grand nombre de fonctionnalités d’entité ne sont toujours pas traitées de manière égale, ce qui nuit à la précision et à la robustesse de l’alignement d’entités basé sur l’intégration.

Cet article propose un nouveau cadre.Il unifie plusieurs vues d'entités pour apprendre les incorporations alignées sur les entités.Plus précisément, cet article utilise plusieurs stratégies combinées pour intégrer des entités en fonction des vues des noms d’entités, des relations et des attributs.

De plus, cet article conçoit certaines méthodes de raisonnement sur des graphes de connaissances croisées pour améliorer l’alignement entre deux graphes de connaissances. Les expériences sur des ensembles de données réels montrent que les performances de ce cadre sont nettement meilleures que celles de la méthode d'alignement d'entités basée sur l'intégration la plus avancée. Les vues sélectionnées, le raisonnement graphique croisé et les stratégies de combinaison contribuent tous à l'amélioration des performances.

-- sur--