Command Palette

Search for a command to run...

Une Avancée Majeure Dans La Géolocalisation d'images ! L'Université Du Maine, Google, OpenAI Et d'autres Ont Proposé Le Cadre LocDiff, Permettant Un Positionnement Global Précis Sans Avoir Besoin De Grilles Ni De Bibliothèques De référence.

La technologie de décodage de localisation, qui déduit la position géographique à partir d'informations contextuelles, est largement utilisée pour la synthèse de trajectoires, la segmentation des contours de bâtiments et la géolocalisation d'images. Parmi ces applications, la géolocalisation d'images, qui associe le contenu visuel à des coordonnées géographiques, est devenue un axe de recherche majeur. Elle prédit les coordonnées de latitude et de longitude en analysant les caractéristiques de l'image et convient à des types de données tels que la surveillance de la faune sauvage et les vues de rues urbaines.

Cependant, contrairement aux tâches de classification d'images classiques, la géolocalisation d'images est confrontée à des problèmes de cartographie non linéaire complexes, ce qui rend la modélisation précise difficile. Les premières études utilisaient des modèles de régression pour associer directement les caractéristiques des images à la latitude et à la longitude, mais ces modèles présentaient une faible stabilité et des erreurs de prédiction atteignant souvent des centaines de kilomètres à l'échelle mondiale. Pour pallier ce problème, les chercheurs ont proposé la méthode de « transduction par discrétisation », transformant la tâche de géolocalisation en un problème de classification ou de recherche. Toutefois, ces méthodes présentent encore des limitations en termes de résolution spatiale et de couverture géographique.

Ces dernières années, les techniques génératives, notamment les modèles de diffusion, ont ouvert de nouvelles perspectives à la recherche en géolocalisation grâce à leur excellente capacité à modéliser les distributions de données continues. C’est sur ce constat qu’une équipe conjointe des universités du Maine, du Texas, de Géorgie, du Maryland, de Google, d’OpenAI et de Harvard a proposé une approche novatrice.Ils ont découvert que la raison fondamentale de l'échec des méthodes de génération traditionnelles réside dans le fait que les propriétés spatiales des coordonnées géographiques diffèrent de celles des données conventionnelles : les coordonnées se situent dans une variété riemannienne plongée plutôt que dans un espace euclidien, et l'application directe de bruit entraîne une distorsion de la projection ; par ailleurs, les coordonnées originales manquent d'informations spatiales multi-échelles, ce qui rend difficile la modélisation de distributions complexes.Pour résoudre ces deux problèmes majeurs, l'équipe a proposé la méthode « Spherical Harmonics Dirac Delta (SHDD) » et le cadre intégré LocDiff. En concevant une méthode d'encodage et une architecture de diffusion adaptées à la géométrie sphérique, elle a obtenu un positionnement précis sans recourir à des grilles prédéfinies ni à des bibliothèques d'images externes, ouvrant ainsi une voie technique novatrice dans ce domaine.

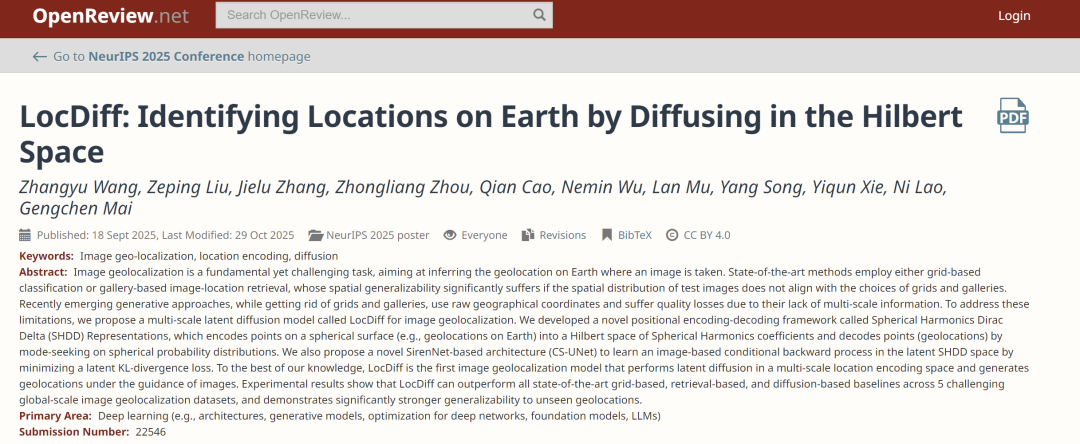

Les résultats de recherche associés, intitulés « LocDiff : Identification de lieux sur Terre par diffusion dans l'espace de Hilbert », ont été inclus dans NeurIPS 2025.

Adresse du document :

https://openreview.net/forum?id=ghybX0Qlls

Suivez notre compte WeChat officiel et répondez « LocDiff » en arrière-plan pour obtenir le PDF complet.

Autres articles sur les frontières de l'IA :

https://hyper.ai/papers

Jeux de données : Basé sur GeoCLIP, ce jeu de données s’appuie sur trois grands jeux de données de géolocalisation d’images typiques à l’échelle mondiale.

Afin de garantir la comparabilité et la fiabilité des résultats de la recherche, les chercheurs ont suivi les paramètres de référence du modèle GeoCLIP, largement utilisé dans le domaine de la géolocalisation d'images.La phase d'entraînement a utilisé l'ensemble de données MP16 (MediaEval Placing Tasks 2016), qui contient 4,72 millions d'images avec des annotations géographiques précises, fournissant un support de données suffisant pour l'entraînement du modèle.Au cours de la phase de test, trois ensembles de données de géolocalisation d'images à l'échelle mondiale typiques ont été sélectionnés : Im2GPS3k, YFCC26k et GWS15k.

Il convient de noter que les ensembles de test Im2GPS3k et YFCC26k sont très similaires à l'ensemble d'entraînement MP16 en termes de distribution des données, et que certaines images peuvent se chevaucher. Cette caractéristique confère aux méthodes de recherche (telles que GeoCLIP) un avantage certain lors du processus de mise en correspondance, ce qui contribue à améliorer leur précision de recherche.Lors de la phase d'inférence du modèle, les chercheurs ont adopté la stratégie utilisée par les modèles courants tels que GeoCLIP et SimCLR, générant 16 versions améliorées pour chaque image de test et utilisant le centre géographique de ses multiples échantillons comme emplacement prédit final.Cette stratégie améliore considérablement les performances du modèle. Par exemple, lors d'expériences comparatives, si les étapes d'amélioration de l'image et de moyennage des résultats sont supprimées, la précision de positionnement de GeoCLIP à l'échelle d'un kilomètre sur l'ensemble de données Im2GPS3k chute de 14% à moins de 10%.

Afin d'évaluer de manière exhaustive les capacités de positionnement du modèle à différentes échelles spatiales, cette étude a défini cinq niveaux d'évaluation : rue (1 km), ville (25 km), région (200 km), pays (750 km) et continent (2 500 km). La performance du modèle a été quantifiée en prédisant statistiquement la proportion d'échantillons situés à proximité de la position réelle.

LocDiff : Modèle de diffusion latente pour la génération de positions sphériques

L'objectif principal du modèle LocDiff est de construire un cadre de diffusion latente adapté à la génération de positions sphériques. Son idée centrale est de bâtir un espace de codage de position capable de surmonter les problèmes de rareté et de non-linéarité. Concrètement, ceci est réalisé grâce à l'intégration poussée du cadre de codage-décodage par fonction de Dirac harmonique sphérique (SHDD), de l'architecture Siren-UNet conditionnelle (CS-UNet) et de stratégies de calcul efficaces.

Afin de clarifier l'orientation technique, cette recherche définit mathématiquement les propriétés fondamentales que doit posséder un espace de codage de position idéal : soit C une sphère unité plongée dans l'espace euclidien tridimensionnel, paramétrée par les coordonnées angulaires (θ, φ) ; l'encodeur de position idéal PE doit être une fonction injective de C vers l'espace de grande dimension ℝᵈ (garantissant l'unicité du codage), tandis que le décodeur PD doit être une fonction surjective de ℝᵈ vers C (garantissant l'intégrité du décodage). Plus important encore, l'espace de codage doit être densément rempli par une métrique de différence continue ℰ, et le décodeur doit satisfaire à la condition de stabilité selon laquelle « de petites perturbations dans l'espace de codage n'entraînent que de petites variations des coordonnées sphériques » ; ces deux propriétés sont essentielles pour surmonter les limitations techniques actuelles.

Cependant, les méthodes existantes se heurtent à un double dilemme pour atteindre les objectifs susmentionnés : si l’espace d’encodage de la localisation est clairsemé, le modèle de diffusion aura des difficultés à y mener un processus de diffusion stable, ce qui entraîne directement des difficultés de convergence de l’entraînement et une faible précision de décodage ; si un espace d’intégration de localisation dense est utilisé à la place, bien qu’il puisse permettre une progression fluide du processus de diffusion, la forte non-linéarité de la correspondance entre l’encodage de la localisation et l’espace des coordonnées conduira à une impasse la tâche consistant à « inférer les coordonnées géographiques correctes à partir des résultats d’intégration » : minimiser la distance dans l’espace d’intégration ne correspond souvent pas à minimiser la distance dans l’espace géographique.

Pour surmonter ce défi, les chercheurs ont proposé le schéma d'encodage SHDD.Cette approche novatrice consiste d'abord à transformer un point sphérique (θ₀, φ₀) en une fonction de Dirac harmonique sphérique δ_(θ₀, φ₀), puis à encoder cette fonction dans un vecteur de coefficients harmoniques sphériques, formant ainsi la représentation SHDD. En pratique, en fixant l'ordre maximal L de la fonction harmonique sphérique, le vecteur de coefficients, théoriquement de dimension infinie, peut être réduit à une représentation compacte de dimension (L+1)². De plus, plus la valeur de L est élevée, plus l'information spatiale capturée par la représentation est précise, offrant ainsi une prise en charge flexible des exigences de positionnement multi-échelle.

L'espace de codage SHDD est intrinsèquement dense : chaque point e de cet espace correspond de manière unique à une fonction sphérique Fₑ. La différence entre cette fonction et la fonction harmonique sphérique de Dirac δ_(θ₀, φ₀) correspondant à la position réelle est quantifiée par l'inverse de la divergence de Kullback-Leibler. Cette mesure de différence ℰ est la métrique continue requise pour l'étude.Plus important encore, la divergence SHDD KL et la distance de Wasserstein-2 ont une relation de contrainte claire, qui garantit mathématiquement la cohérence entre les différences dans l'espace de codage et les différences dans la distribution de probabilité sphérique, jetant ainsi les bases de la stabilité du décodage.Par ailleurs, l'encodage SHDD résout efficacement le problème de non-linéarité des méthodes traditionnelles. La comparaison des cartes thermiques montre que, par rapport aux méthodes d'intégration classiques, la distance sphérique mesurée par SHDD est plus régulière. Cette régularité réduit considérablement le risque de propagation d'erreurs lors du décodage et garantit un positionnement précis.

En se basant sur les caractéristiques de la représentation SHDD, les chercheurs ont conçu un décodeur de recherche de modalité pour obtenir un décodage efficace.Ce décodeur exploite la nature modale de la divergence KL inverse pour effectuer l'inversion de coordonnées en identifiant la région présentant la plus forte concentration de probabilité des fonctions sphériques. L'hyperparamètre ρ permet d'équilibrer la résolution et la stabilité du décodage : une valeur de ρ élevée rend le résultat moins sensible aux pics locaux, mais au détriment de la précision ; à l'inverse, une valeur de ρ faible améliore la précision, mais le rend plus sensible au bruit local. Cette conception sans paramètre présente un double avantage : elle évite l'introduction de pertes supplémentaires lors du décodage et élimine toute dépendance à des partitions sphériques prédéfinies ou à des bibliothèques d'images de référence externes, s'affranchissant ainsi des limitations d'application des méthodes traditionnelles.

L'architecture CS-UNet, réseau dorsal de génération conditionnelle de LocDiff (voir figure ci-dessous), utilise SirenNet comme module de base. Ce choix se justifie par le fait que les coefficients des fonctions harmoniques sphériques sont essentiellement une superposition de fonctions sinus et cosinus, et que la fonction d'activation sinusoïdale de SirenNet maintient efficacement le flux de gradient, s'adaptant ainsi aux exigences de propagation des caractéristiques harmoniques sphériques. L'unité centrale de CS-UNet, C-Siren, réalise un débruitage conditionnel efficace grâce à un mécanisme sophistiqué de fusion de caractéristiques : après l'entrée du vecteur latent x, de l'embedding conditionnel de l'image e_I et du pas de diffusion t, x et e_I sont d'abord projetés sur des vecteurs cachés. Ensuite, le pas de temps de diffusion discret t est transformé en vecteurs d'échelle et de décalage pour effectuer le débruitage inconditionnel. Enfin, les conditions de l'image et les caractéristiques débruitées sont fusionnées, et les caractéristiques ajustées sont transmises au module de niveau suivant, formant une chaîne de guidage conditionnel complète.

Le processus d'entraînement de LocDiff suit le cadre DDPM standard, utilisant les paires « image-position sphérique » comme exemples d'entraînement : l'image est d'abord convertie en une représentation d'intégration de dimension fixe e_I via un encodeur CLIP figé, et la position sphérique correspondante (θ, φ) est encodée sous forme de représentation SHDD et stockée pour une utilisation ultérieure. Lors de la phase de propagation avant, du bruit est progressivement ajouté à la fonction de Dirac harmonique sphérique jusqu'à sa transformation en un vecteur de bruit gaussien pur. Lors de la phase de rétropropagation, CS-UNet, guidé par l'intégration de l'image e_I, reconstruit progressivement la représentation SHDD originale à partir du vecteur de bruit. La fonction de perte utilisée pour l'entraînement est la divergence KL SHDD qui, comparée à la perte MSE sphérique traditionnelle, est non seulement plus stable numériquement, mais préserve également efficacement l'information spatiale multi-échelle, aidant ainsi le modèle à apprendre les caractéristiques globales et locales.

Lors de la phase d'inférence, le modèle est initialisé avec un bruit gaussien aléatoire et, guidé par les caractéristiques intrinsèques de l'image d'entrée, génère progressivement des vecteurs de coefficients SHDD via CS-UNet. Ces vecteurs sont ensuite transformés en coordonnées sphériques (θ, φ) par un décodeur de recherche de modalité. En pratique, le calcul de la divergence KL SHDD et l'intégration de la recherche de modalité sont approchés par la sommation d'un ensemble discret de points d'ancrage sphériques. Durant l'entraînement, les points d'ancrage sont échantillonnés aléatoirement globalement afin d'éviter le surapprentissage.

En se concentrant sur trois dimensions clés, LocDiff obtient des résultats exceptionnels dans la plupart des scénarios de test.

Afin d'évaluer systématiquement les performances du modèle LocDiff, cette étude a mené des expériences selon trois axes : la précision de la localisation, la capacité de généralisation et l'efficacité de calcul. Toutes les expériences ont été réalisées conformément aux paramètres standards du domaine afin de garantir des comparaisons équitables.

Les expériences montrent que, comme l'illustre le tableau ci-dessous, LocDiff offre d'excellentes performances dans la plupart des scénarios de test. Afin d'améliorer encore les performances à fine résolution, les chercheurs ont conçu un modèle hybride, LocDiff-H, qui combine efficacement les avantages des deux méthodes en limitant la zone de recherche de GeoCLIP à un rayon de 200 kilomètres autour de la position générée par LocDiff. LocDiff-H obtient des résultats exceptionnels sur Im2GPS3k et YFCC26k, mais ses performances sont inférieures à celles de LocDiff sur GWS15k, notamment à fine résolution. Ceci est principalement dû à la différence significative de distribution entre GWS15k et l'ensemble d'entraînement, ce qui a un impact négatif sur le biais inductif de GeoCLIP.

Comme le montre le tableau ci-dessous, en comparaison avec des modèles génératifs similaires, LocDiff surpasse DiffR³, FMR³ et d'autres modèles comparables sur les ensembles de données OSM-5M et YFCC-4k, validant ainsi les avantages de la méthode de diffusion latente multi-échelle.

L'analyse de généralisation révèle la valeur unique des méthodes génératives. GeoCLIP, une méthode de recherche basée sur la cartographie, dépend fortement de la couverture spatiale du référentiel cartographique : ses performances se dégradent considérablement lorsque la distribution de l'ensemble de test ne correspond pas à celle de l'ensemble d'entraînement ; même en utilisant des millions de points de grille uniformes comme emplacements candidats, ses performances à des échelles de 200 kilomètres et plus sont bien inférieures à celles obtenues avec le référentiel cartographique original. Ceci illustre la faible adaptabilité de cette méthode aux emplacements non observés lors de l'entraînement.

À l'inverse, LocDiff fait preuve d'une grande capacité de généralisation. Comme le montre le tableau ci-dessous, les résultats expérimentaux indiquent que les performances de LocDiff restent stables, que les points d'ancrage utilisent les emplacements de la bibliothèque MP16 ou des points de grille uniformes, et que leur nombre augmente de 21 000 à 1 million, confirmant ainsi sa robustesse.

En termes d'efficacité de calcul, LocDiff offre des performances exceptionnelles. L'encodage/décodage SHDD, opération déterministe et analytique, présente une complexité temporelle quasi constante et une complexité spatiale linéaire. Lors de l'entraînement, l'encodage SHDD peut être précalculé sous forme de table de correspondance, et le décodage est implémenté grâce à des multiplications matricielles et des opérations argmax efficaces. Plus précisément, les représentations SHDD multi-échelles accélèrent considérablement la convergence du processus de diffusion : LocDiff converge sur le jeu de données YFCC en seulement 2 millions d'étapes environ, tandis que le modèle de référence en requiert 10 millions.

Avancées académiques et émergence industrielle dans le domaine de la géolocalisation d'images

La technologie de géolocalisation d'images, en tant que pont important reliant l'information visuelle au monde physique, a réalisé des progrès significatifs ces dernières années, tant dans la recherche académique que dans les applications pratiques.

Dans le milieu universitaire, une équipe de recherche du Laboratoire d'informatique et d'intelligence artificielle (CSAIL) du MIT a réalisé une avancée majeure dans le domaine du codage de position sphérique. Face au défi que représente la cartographie non linéaire des méthodes traditionnelles, elle a proposé un schéma amélioré basé sur la diffusion de variétés, combinant fonctions harmoniques sphériques et apprentissage de variétés. Cette innovation améliore considérablement les performances de positionnement du modèle dans les régions où les données sont rares, telles que les régions polaires et les océans, augmentant la précision de 231 TP3T à une échelle de 100 km. La recherche introduit également un mécanisme d'ajustement d'échelle adaptatif, améliorant ainsi la capacité de généralisation du modèle dans différents contextes interrégionaux.

Titre de l'article :LocDiffusion : Identification de lieux sur Terre par diffusion dans l'espace delta de Dirac des harmoniques sphériques

Lien vers l'article :https://arxiv.org/abs/2503.18142

Parallèlement, l'Université numérique des Émirats arabes unis a proposé GeoCoT, un nouveau paradigme de raisonnement multi-étapes conçu pour améliorer les capacités de géolocalisation des grands modèles de vision. GeoCoT améliore significativement les performances de positionnement en intégrant progressivement les informations contextuelles et les indices spatiaux grâce à la simulation du processus cognitif humain de géolocalisation. Des expériences basées sur la métrique GeoEval montrent que ce cadre améliore la précision de la géolocalisation jusqu'à 25% tout en préservant une bonne interprétabilité.

Titre de l'article :Géolocalisation à partir de données de jeu réelles : un ensemble de données à grande échelle et un cadre de raisonnement similaire à celui de l’humain

Lien vers l'article :https://arxiv.org/pdf/2502.13759

Ces concepts théoriques se traduisent rapidement en applications concrètes, stimulant ainsi les pratiques innovantes dans l'industrie. La plateforme d'intelligence géospatiale développée par PRISM Intelligence, lauréate du NASA Startup Challenge 2023, en est un parfait exemple. Cette plateforme utilise la technologie des champs de rayonnement pour transformer des images de télédétection bidimensionnelles en environnements numériques tridimensionnels haute fidélité et combine la segmentation sémantique pilotée par l'IA et des algorithmes d'optimisation dynamique pour permettre une interaction en langage naturel avec les données géospatiales.

L'équipe Google Earth a utilisé un modèle génératif, entraîné sur d'immenses quantités de données Street View mondiales, pour prédire avec précision la localisation grâce aux images et compléter automatiquement les informations manquantes dues aux conditions météorologiques, aux travaux et à d'autres facteurs. Cette technologie a triplé l'efficacité des mises à jour Street View de Google Earth et étendu sa couverture à des zones plus reculées.

Ces pratiques industrielles valident non seulement la valeur appliquée de la recherche universitaire, mais offrent également de nouvelles orientations pour l'innovation théorique grâce aux retours d'expérience tirés de scénarios réels, faisant progresser continuellement la technologie de géolocalisation d'images vers une plus grande précision, une plus grande efficacité et une plus grande accessibilité.

Liens de référence :

1.https://science.nasa.gov/science-research/science-enabling-technology/technology-highlights/entrepreneurs-challenge-winner-prism-is-using-ai-to-enable-insights-from-geospatial-data/

2.https://ai.google.dev/competition/projects/prism