Command Palette

Search for a command to run...

Tutoriel En Ligne : Cadre De Création Vidéo Collaborative Multimodale HuMo-1.7B : Créer Une Expérience Vidéo Avec Des Graphiques, Du Texte Et De l'audio Intégrés

De nos jours, les vidéos générées par l'IA sont de plus en plus réalistes. Elles sont souvent impressionnantes au premier abord, mais à y regarder de plus près, quelque chose semble étrange. Cet effet de « vallée de l'étrange », entre le vrai et le faux, est à la fois étonnant et inévitable.

Imaginez un scénario courant en création. Si le client ne propose qu'une idée vague, le produit final ne répond souvent pas aux attentes. Ce n'est qu'en affinant les exigences en termes de style, de personnages, de ton et d'atmosphère que le résultat se rapprochera de l'idéal. Il en va de même pour la création vidéo. Contrairement aux images et aux textes, les vidéos véhiculent de multiples informations, comme le son, les personnages et les actions.Cela signifie que le modèle doit non seulement « comprendre » la sémantique du texte, mais également « coordonner » les expressions visuelles et auditives.

Cependant, la plupart des modèles actuels reposent sur une seule modalité d'entrée. Les tentatives récentes de contrôle multimodal peinent souvent à assurer une collaboration efficace entre la voix, l'expression et le mouvement. Permettre à ces différentes modalités de collaborer véritablement et de générer des vidéos réalistes, naturelles et réalistes, reste un défi de taille.

Compte tenu de cela,L'Université Tsinghua et ByteDance Intelligent Creation Lab ont publié conjointement le framework HuMo. HuMo propose le concept de « génération conditionnelle multimodale coopérative », incorporant du texte, des images de référence et de l'audio dans le même modèle génératif, et grâce à une stratégie de formation progressive et un mécanisme de guidage adaptatif dans le temps, ajustant dynamiquement les poids de guidage dans l'étape de débruitage.Il réalise non seulement des avancées majeures dans le maintien de la cohérence de l'apparence des personnages, de l'audio et de la vidéo, mais fait également passer la génération vidéo de « l'épissage en plusieurs étapes » à la « génération à guichet unique ».

Adresse du document :

https://arxiv.org/abs/2509.08519

Entrepôt d'origine :

https://github.com/phantom-video/humo

De plus, les performances de HuMo dans plusieurs sous-tâches telles que le suivi de texte et la cohérence des images ont atteint SOTA.Le projet propose deux modèles, 1.7B et 17B, légers, jouables, professionnels et propices à la recherche, et adaptés aux différents besoins des créateurs et développeurs. Examinons l'effet généré par le modèle 17B :

« HuMo-1.7B : Cadre de génération de vidéos multimodales » et « HuMo-17B : Création collaborative trimodale » sont désormais disponibles dans la section « Tutoriels » du site officiel d'HyperAI (hyper.ai). Pourquoi ne pas les essayer ? En leur fournissant plus d'informations, le modèle pourra-t-il produire une vidéo satisfaisante ?

Lien du tutoriel :

HuMo-1,7B :https://go.hyper.ai/BGQT1

HuMo-17B :https://go.hyper.ai/RSYA

Essai de démonstration

1. Sur la page d'accueil de hyper.ai, sélectionnez la page Tutoriels, choisissez HuMo-1.7B : Multimodal Video Generation Framework et cliquez sur Exécuter ce tutoriel en ligne.

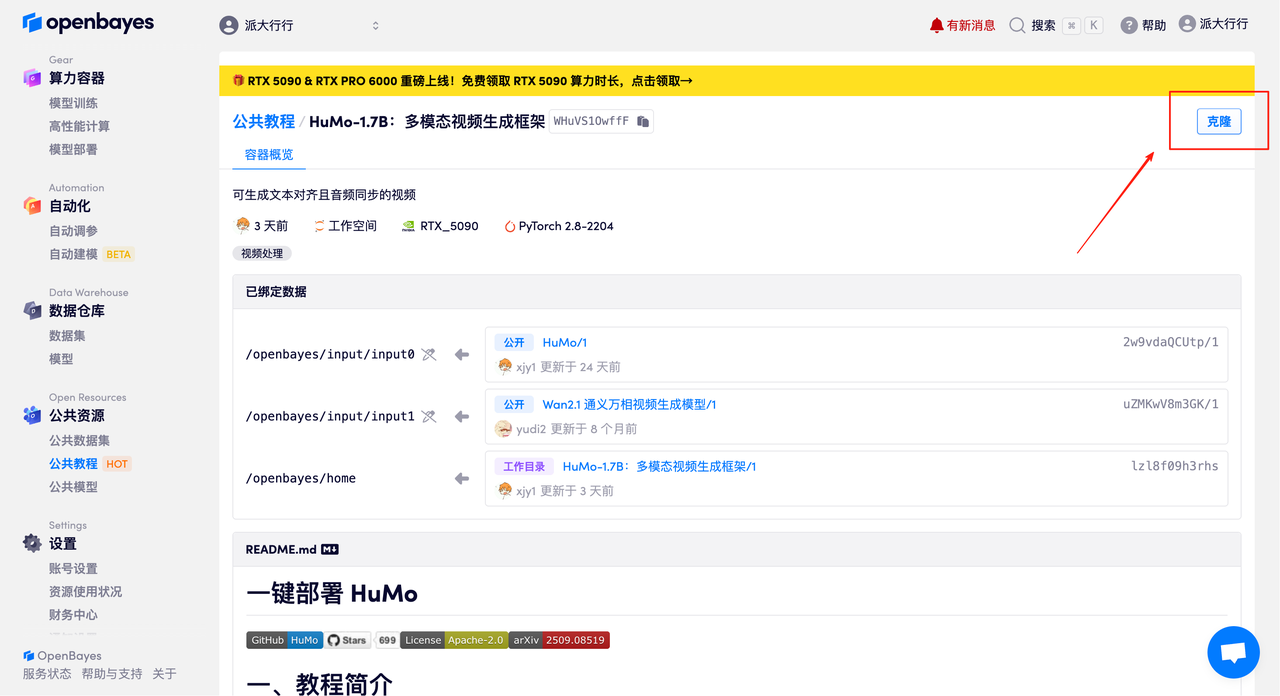

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

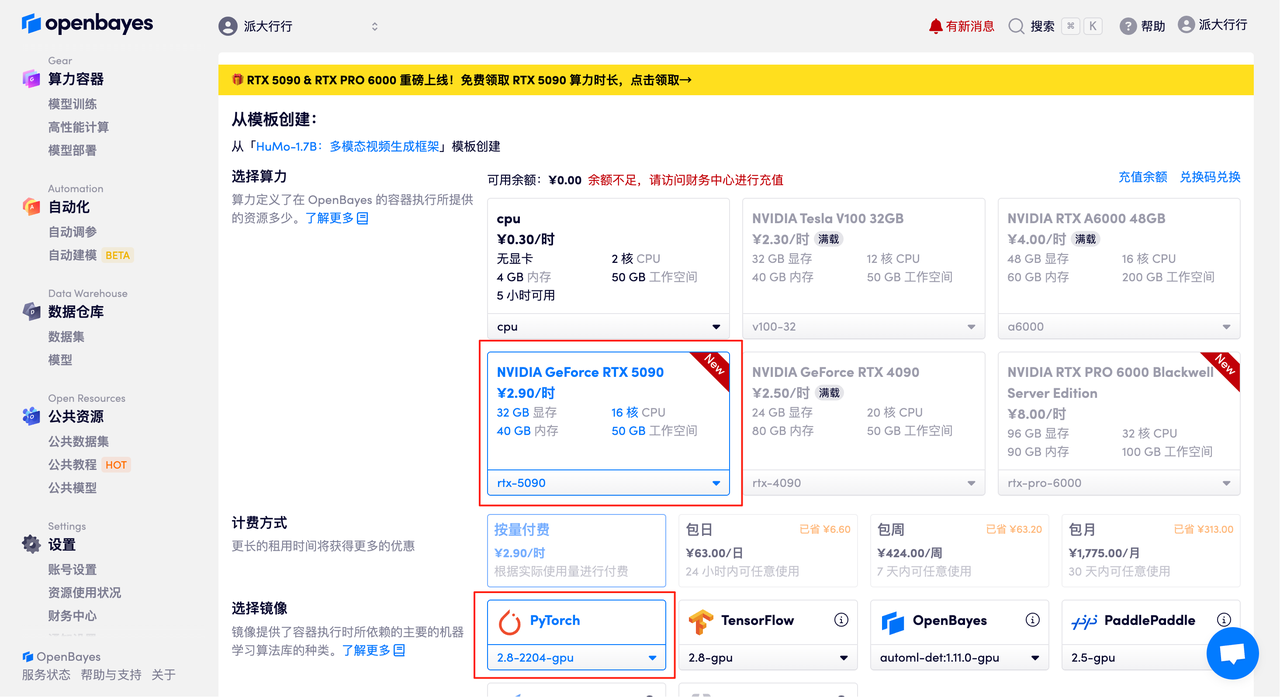

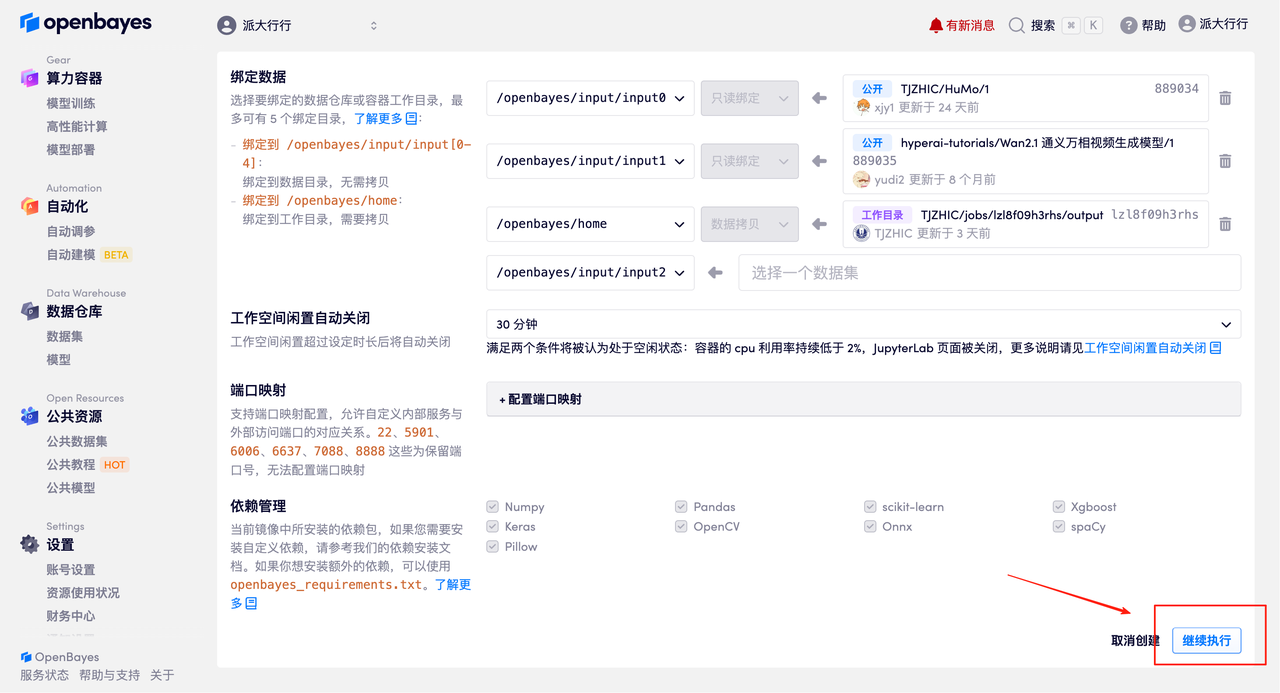

3. Sélectionnez les images NVIDIA GeForce RTX 5090 et PyTorch, puis cliquez sur « Continuer ». La plateforme OpenBayes propose quatre options de facturation : paiement à l'utilisation ou forfait journalier, hebdomadaire ou mensuel. Les nouveaux utilisateurs peuvent s'inscrire via le lien d'invitation ci-dessous pour recevoir 4 heures de RTX 5090 et 5 heures de temps processeur gratuits !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :

https://openbayes.com/console/signup?r=Ada0322_NR0n

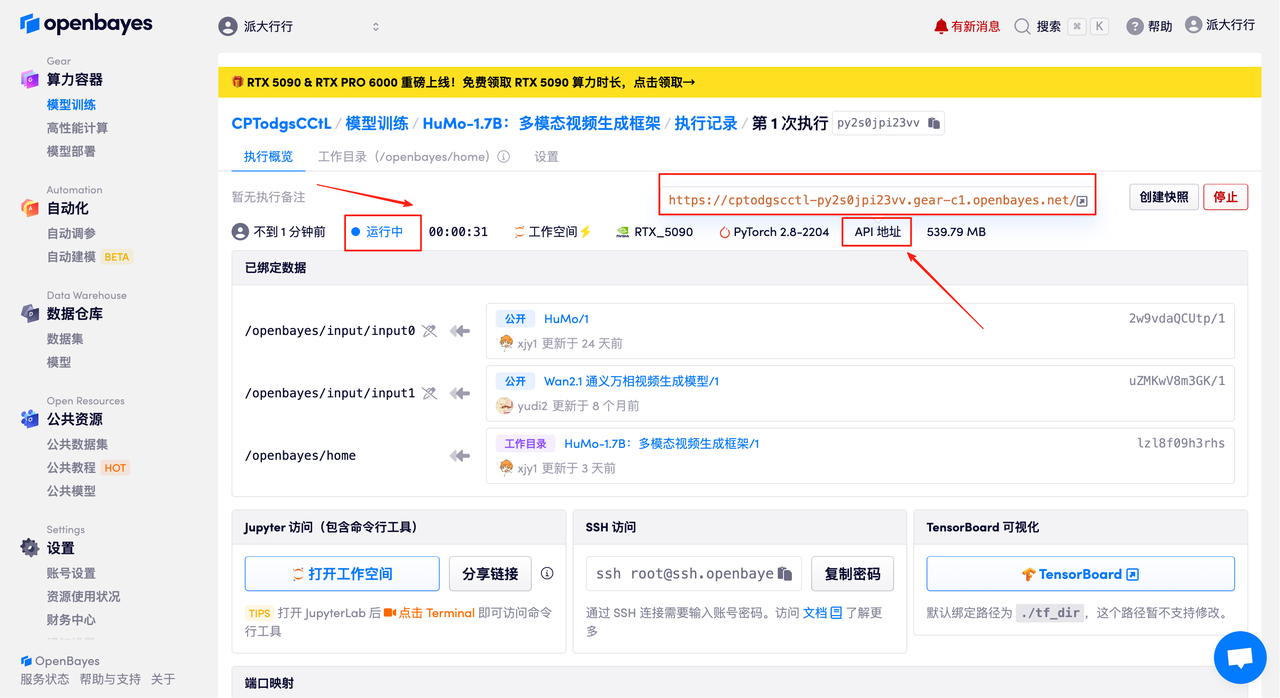

4. Attendez que les ressources soient allouées. Le premier clonage prendra environ 2 minutes. Lorsque le statut passe à « En cours d'exécution », cliquez sur « Ouvrir l'espace de travail » pour accéder à la page de démonstration.

Démonstration d'effet

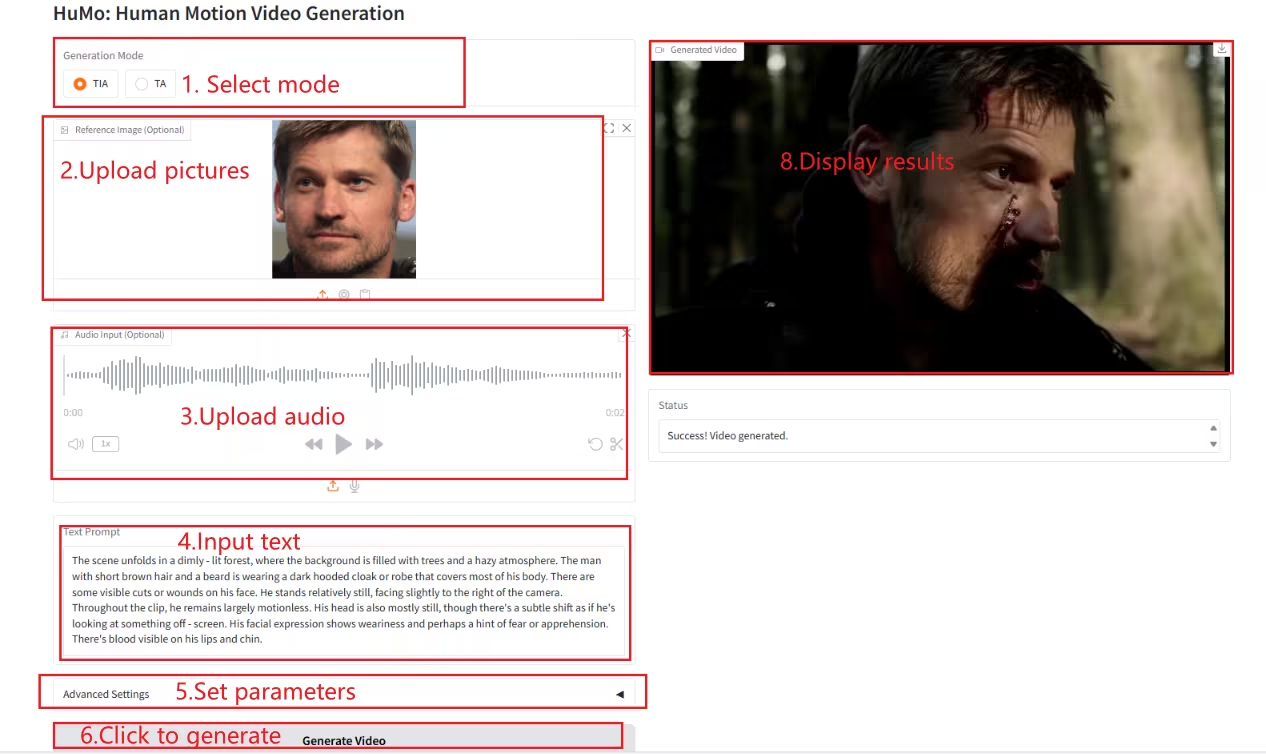

Une fois sur la page de démonstration, saisissez une description dans la zone de texte, importez les images et l'audio, ajustez les paramètres selon vos besoins, puis cliquez sur « Générer la vidéo » pour générer la vidéo. (Remarque : avec un nombre d'étapes d'échantillonnage de 10, la génération de la vidéo prend environ 3 à 5 minutes.)

Générer un exemple

Le tutoriel ci-dessus est celui recommandé par HyperAI cette fois-ci. Bienvenue à tous pour le découvrir !

Lien du tutoriel :

HuMo-1,7B :https://go.hyper.ai/BGQT1

HuMo-17B :https://go.hyper.ai/RSYAje