Command Palette

Search for a command to run...

NeurIPS 2025 : L'Université Des Sciences Et Technologies De Huazhong Et d'autres Universités Publient OCRBench v2. Gemini Remporte La Première Place Du Classement De La Langue Chinoise, Mais Obtient Seulement La Mention « passable ».

Au cours des dernières décennies, le positionnement et la valeur de la technologie de reconnaissance optique de caractères (OCR) ont connu une évolution considérable, passant d'un outil traditionnel de reconnaissance d'images à une fonctionnalité essentielle des systèmes d'information intelligents. Initialement, elle extrayait principalement du texte imprimé ou manuscrit des images et le convertissait en données textuelles intelligibles par ordinateur. Aujourd'hui, avec le développement de l'apprentissage profond et des modèles multimodaux, stimulés par des exigences diverses, les limites de la technologie OCR ne cessent de se développer. Elle reconnaît non seulement les caractères, mais comprend également la structure et la sémantique des documents.Analysez avec précision les tableaux, les mises en page et les textes et graphiques mixtes dans des scénarios complexes.

De plus, lors d'un pré-entraînement multimodal à grande échelle, le modèle est exposé à une grande quantité de données image contenant du texte, telles que des captures d'écran de pages web, des interfaces utilisateur, des affiches, des documents, etc., et les capacités d'OCR apparaissent naturellement lors du processus d'apprentissage non supervisé. Le modèle de grande taille ne dépend donc plus de modules OCR externes.Au lieu de cela, il peut directement compléter la reconnaissance, la compréhension et la réponse dans le processus de raisonnement de bout en bout.Plus important encore, la technologie OCR devient indispensable aux tâches intelligentes de haut niveau. Ce n'est que lorsque le modèle est capable de reconnaître précisément le texte dans les images qu'il peut effectuer l'analyse de graphiques, la réponse aux questions, l'extraction de connaissances et même la compréhension du code.

On peut affirmer que la performance aux tâches d'OCR est également un indicateur important pour évaluer les capacités des grands modèles multimodaux. Les besoins actuels vont depuis longtemps au-delà de la simple lecture de texte. Tableaux, graphiques, notes manuscrites, mises en page complexes dans les documents, positionnement des images et raisonnement textuel sont autant de défis complexes que les modèles doivent relever.Cependant, la plupart des tests d’évaluation OCR traditionnels comportent des tâches uniques et des scénarios limités, ce qui conduit à une saturation rapide des scores des modèles et rend difficile de refléter véritablement leurs capacités dans des applications complexes.

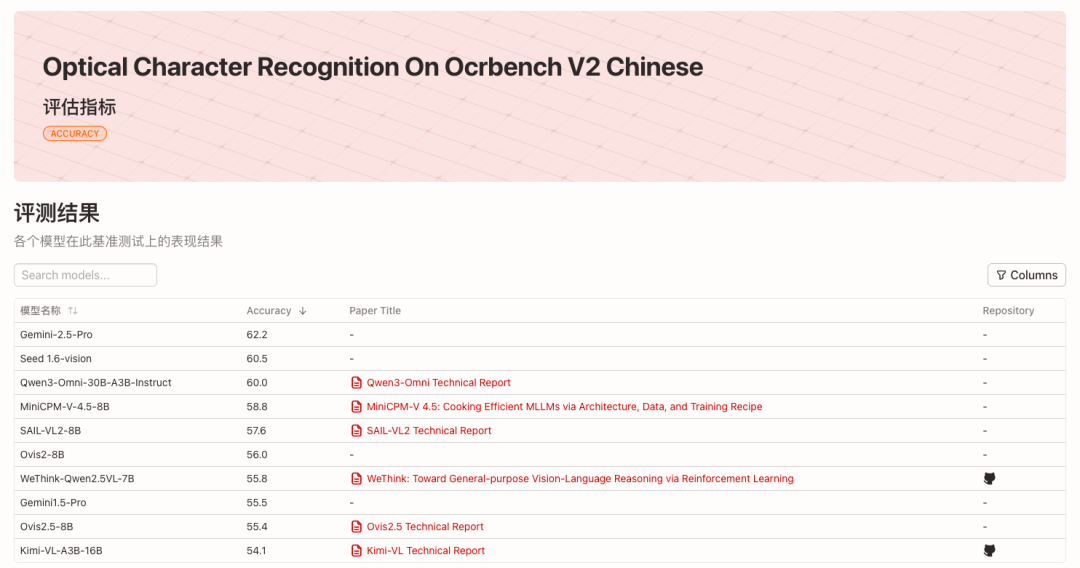

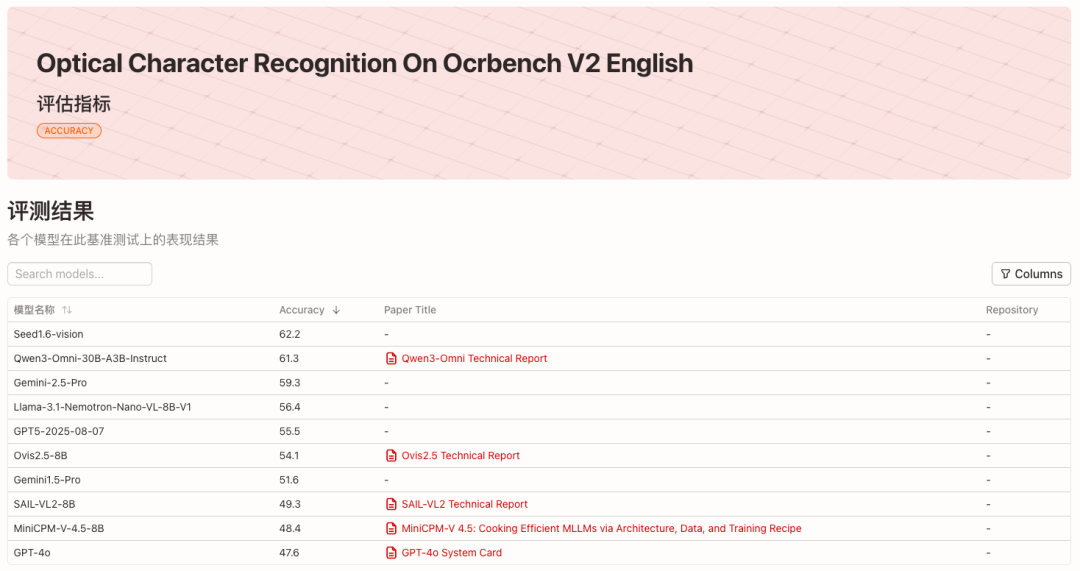

Compte tenu de cela,L'équipe de Bai Xiang de l'Université des sciences et technologies de Huazhong, en collaboration avec l'Université de technologie de Chine du Sud, l'Université d'Adélaïde et ByteDance, a lancé le benchmark OCR de nouvelle génération OCRBench v2.Nous avons évalué 58 modèles multimodaux courants de 2023 à 2025, en chinois et en anglais. Les 10 meilleurs modèles de chaque classement sont présentés dans la figure ci-dessous :

* Voir le classement anglais :

* Voir la liste chinoise :

* Adresse open source du projet :

https://github.com/Yuliang-Liu/MultimodalOCR

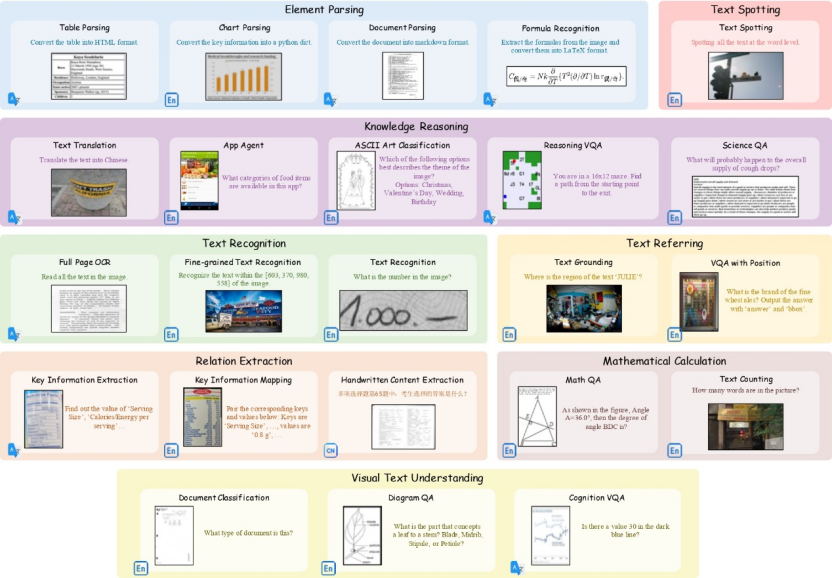

23 sous-tâches couvrant divers scénarios

OCRBench v2 couvre 23 sous-tâches et 8 dimensions de capacités principales.——Reconnaissance de texte, positionnement de texte, détection et reconnaissance de texte, extraction de relations, analyse d’éléments, calcul mathématique, compréhension visuelle de texte et raisonnement cognitif.

Le jeu de données public d'OCRBench v2 comprend 10 000 QA de haute qualité provenant de plus de 80 bases de données académiques et de données propriétaires. Ces données ont été vérifiées manuellement afin de garantir la couverture de divers scénarios dans des applications OCR réelles. De plus, OCRBench v2 inclut des données privées indépendantes, composées de 1 500 QA collectées et annotées manuellement. Les paramètres des tâches et la couverture des scénarios sont cohérents avec le jeu de données public.

* Adresse de téléchargement du jeu de données :

https://go.hyper.ai/VNHSX

Les expériences menées par l’équipe ont révélé que les classements des données publiques et des données privées sont très cohérents.Cela prouve la rationalité de la conception des tâches, de la construction des données et des indicateurs d'évaluation d'OCRBench v2.Cela démontre sa valeur importante dans la mesure des limites existantes des grands modèles multimodaux.

Le document de recherche associé, intitulé « OCRBench v2 : une référence améliorée pour l'évaluation de grands modèles multimodaux sur la localisation et le raisonnement de texte visuel », a été inclus dans le NeurIPS 2025 (Datasets and Benchmarks Track).

* Adresse du papier :

https://go.hyper.ai/VNHSX

Les modèles traditionnels sont généralement biaisés, le score le plus élevé étant à peine satisfaisant.

Dans la dernière liste d'évaluation publiée par OCRBench v2,Gemini-2.5-Pro a remporté la première place dans la liste chinoise et la troisième place dans la liste anglaise, tandis que Seed1.6-vision a remporté la première place dans la liste anglaise et la deuxième place dans la liste chinoise.Dans le camp open source, Qwen3-Omni-30B-A3B-Instruct s'est classé deuxième sur la liste anglaise et troisième sur la liste chinoise respectivement.

En analysant les performances des fonctionnalités clés des modèles, nous constatons que ces grands modèles multimodaux présentent généralement un phénomène de « biais ». Rares sont les modèles performants dans toutes les fonctionnalités clés.Même les modèles les mieux classés n'ont obtenu qu'un score moyen d'environ 60 sur 100 dans les tâches d'anglais et de chinois.De plus, chaque modèle présente des atouts légèrement différents. Par exemple, les modèles commerciaux comme Gemini-2.5-Pro présentent un net avantage dans les problèmes de calcul, démontrant leurs solides capacités de raisonnement logique. Llama-3.1-Nemotron-Nano-VL-8B-V1, avec ses puissantes capacités de localisation de texte, a obtenu la quatrième place du classement anglais.

Si la plupart des modèles sont plutôt performants en reconnaissance de texte de base, ils obtiennent généralement de mauvais résultats dans les tâches exigeant une perception spatiale fine et une compréhension structurée, telles que la référence, le repérage et l'analyse. Par exemple, même le modèle Seed1.6-vision, classé premier, n'a obtenu qu'un score de 38,0 en repérage, ce qui limite son efficacité dans des situations réelles comme les scènes textuelles et les documents contenant à la fois du texte et des images.

De plus, en comparant les listes chinoises et anglaises,On constate que les capacités multilingues de nombreux modèles sont inégales.Par exemple, Llama-3.1-Nemotron-Nano-VL-8B-V1 se classe quatrième sur la liste anglaise (score moyen 56,4), mais seulement 31e sur la liste chinoise (score moyen 40,1), ce qui indique qu'il a un plus grand avantage dans les scénarios anglais, ce qui peut être lié à la distribution des données ou à la stratégie de formation.

Parallèlement, bien que les modèles à code source fermé conservent leur avance, d'excellents modèles à code source ouvert sont devenus très compétitifs. Parmi ceux-ci, les modèles à code source fermé tels que la série Gemini, GPT5 et Seed1.6-vision offrent de meilleures performances globales, tandis que les modèles à code source ouvert tels que Qwen-Omni, InternVL, SAIL-VL et Ovis sont devenus très compétitifs.Cinq des dix premiers modèles de la liste anglaise sont des modèles open source, tandis que sept des dix premiers modèles de la liste chinoise sont des modèles open source.Les modèles open source peuvent également atteindre des performances de pointe dans des tâches telles que la localisation de texte, l’extraction d’éléments et la compréhension visuelle de texte.

Les classements OCRBench v2 seront mis à jour trimestriellement et HyperAI continuera de suivre les derniers résultats d'évaluation.