Command Palette

Search for a command to run...

Tutoriel En Ligne : Wan2.2-S2V-14B, Un Modèle De Génération De Vidéo De Qualité Cinématographique, Génère Des Vidéos Humaines Numériques d'une Minute En Utilisant Uniquement Des Images Statiques Et De l'audio.

HyperAI a récemment partagé un tutoriel en ligne sur Wan2.2, le modèle de génération vidéo IA open source du laboratoire Tongyi Wanxiang d'Alibaba. Premier modèle vidéo au monde basé sur le modèle d'expérience utilisateur (MoE), Wan2.2 nous a impressionnés par sa qualité cinématographique et sa grande efficacité de calcul. Qu'en pensez-vous ? N'hésitez pas à partager vos impressions dans les commentaires.

En août dernier, l'équipe de Tongyi Wanxiang a réalisé de nouveaux progrès. En s'appuyant sur le modèle de base de conversion texte-vidéo Wan2.2, elle a construit le Wan-14B.Sur cette base, un modèle open source de génération de vidéo pilotée par audio Wan2.2-S2V-14B a été lancé.Le modèle ne nécessite qu'une image statique et un clip audio.Il peut générer des vidéos humaines numériques avec une qualité de niveau cinématographique, d'une durée allant jusqu'à quelques minutes, et prend en charge une variété de types d'images et de cadres.L'équipe de recherche a mené des expériences en le comparant aux modèles de pointe existants, et les résultats ont montré que Wan2.2-S2V-14B présente des améliorations significatives à la fois en termes d'expressivité et d'authenticité du contenu généré.

Pour soutenir la qualité de génération du modèle dans des scénarios complexes, l’équipe de recherche a adopté une stratégie à deux volets pour compiler un ensemble de données de formation plus complet.D'une part, l'équipe a analysé automatiquement les données issues de vastes bases de données open source comme OpenHumanViD. D'autre part, les chercheurs ont également sélectionné et personnalisé manuellement des échantillons de données de haute qualité. Les deux ensembles de données ont été filtrés uniformément par plusieurs méthodes, notamment le suivi de la posture, l'évaluation de la clarté et de l'esthétique, et la détection de la synchronisation audiovisuelle, pour finalement constituer un ensemble de données de têtes parlantes. Grâce à une stratégie d'apprentissage parallèle hybride, ils ont obtenu une exploration efficace des performances du modèle.

« Wan2.2-S2V-14B : Génération vidéo cinématographique pilotée par l'audio » est désormais disponible dans la section « Tutoriels » du site officiel d'HyperAI (hyper.ai). Venez créer votre propre humain numérique !

Lien du tutoriel :

Essai de démonstration

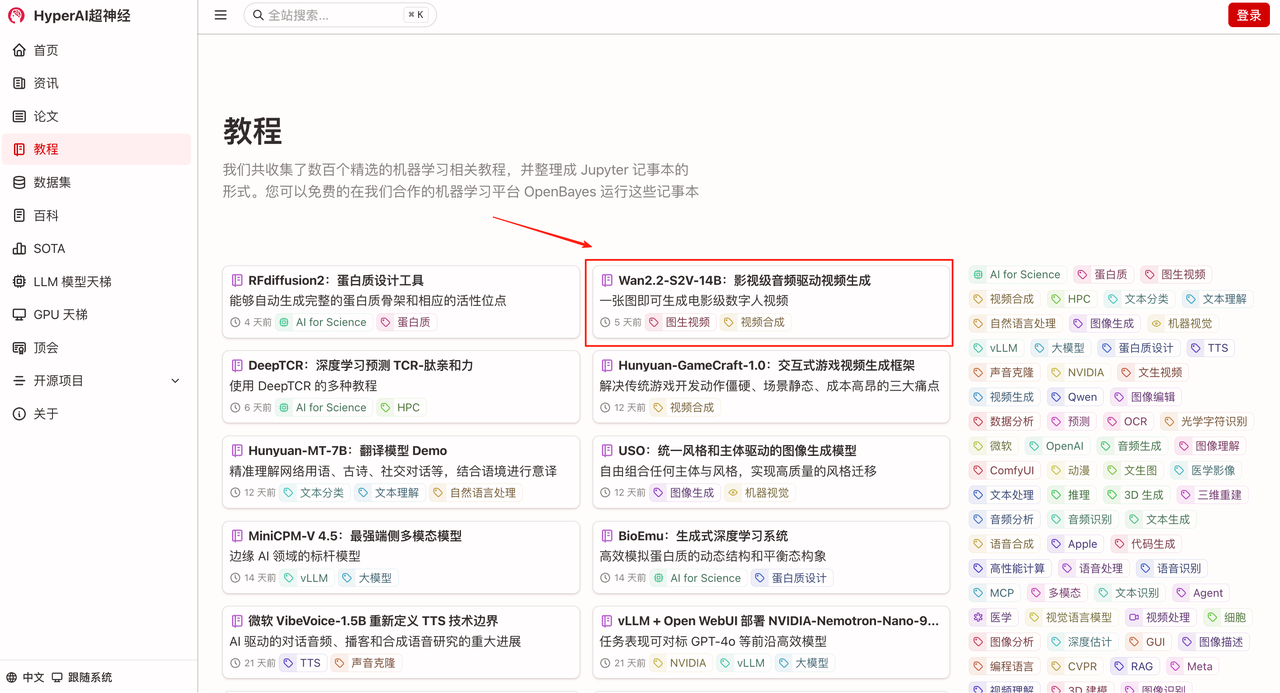

1. Sur la page d'accueil de hyper.ai, sélectionnez la page Tutoriels, choisissez Wan2.2-S2V-14B : Génération de vidéo pilotée par audio de qualité cinématographique, puis cliquez sur Exécuter ce didacticiel en ligne.

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

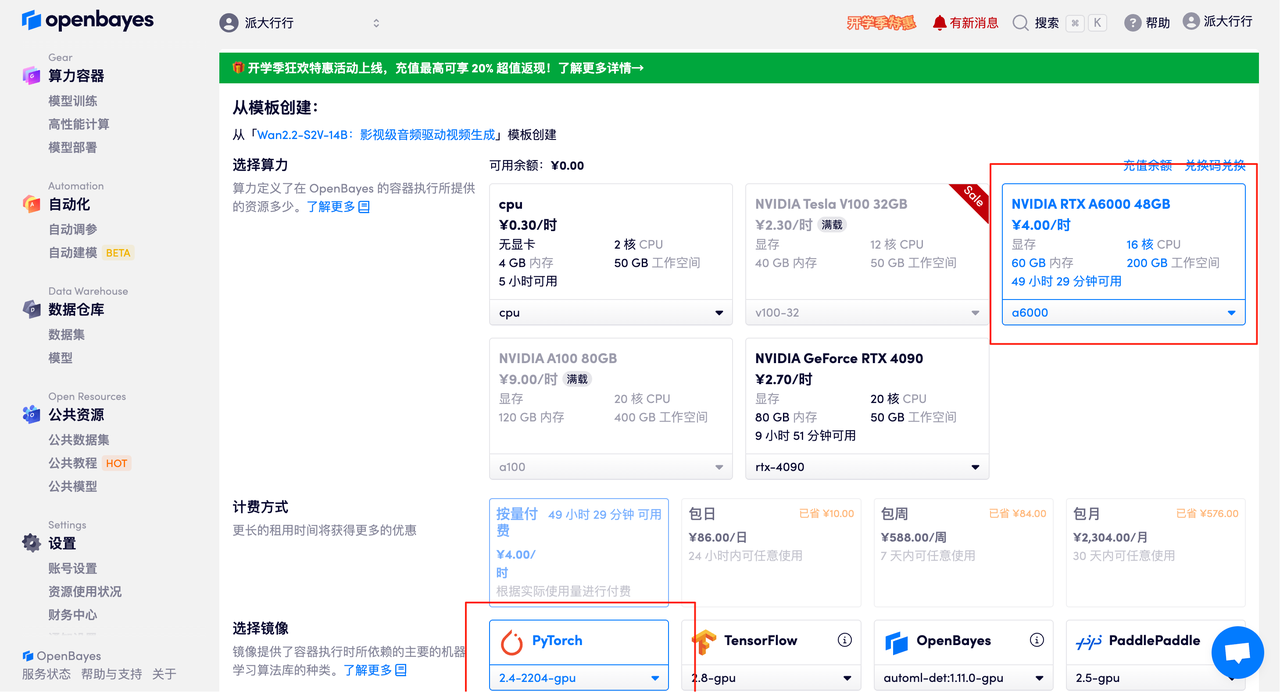

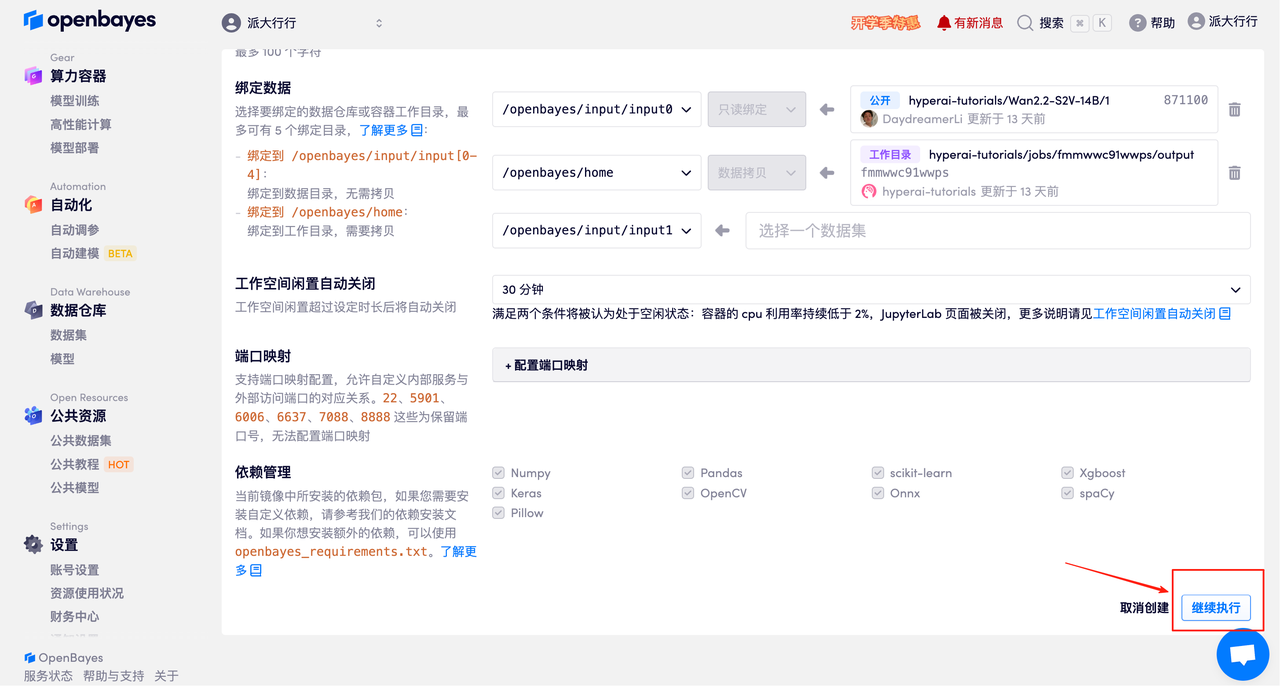

3. Sélectionnez les images NVIDIA RTX A6000 48 Go et PyTorch, puis cliquez sur Continuer. La plateforme OpenBayes propose quatre options de facturation : paiement à l'utilisation ou forfait journalier, hebdomadaire ou mensuel. Les nouveaux utilisateurs peuvent s'inscrire via le lien d'invitation ci-dessous pour recevoir 4 heures de carte graphique RTX 4090 et 5 heures de temps processeur gratuits !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :

https://openbayes.com/console/signup?r=Ada0322_NR0n

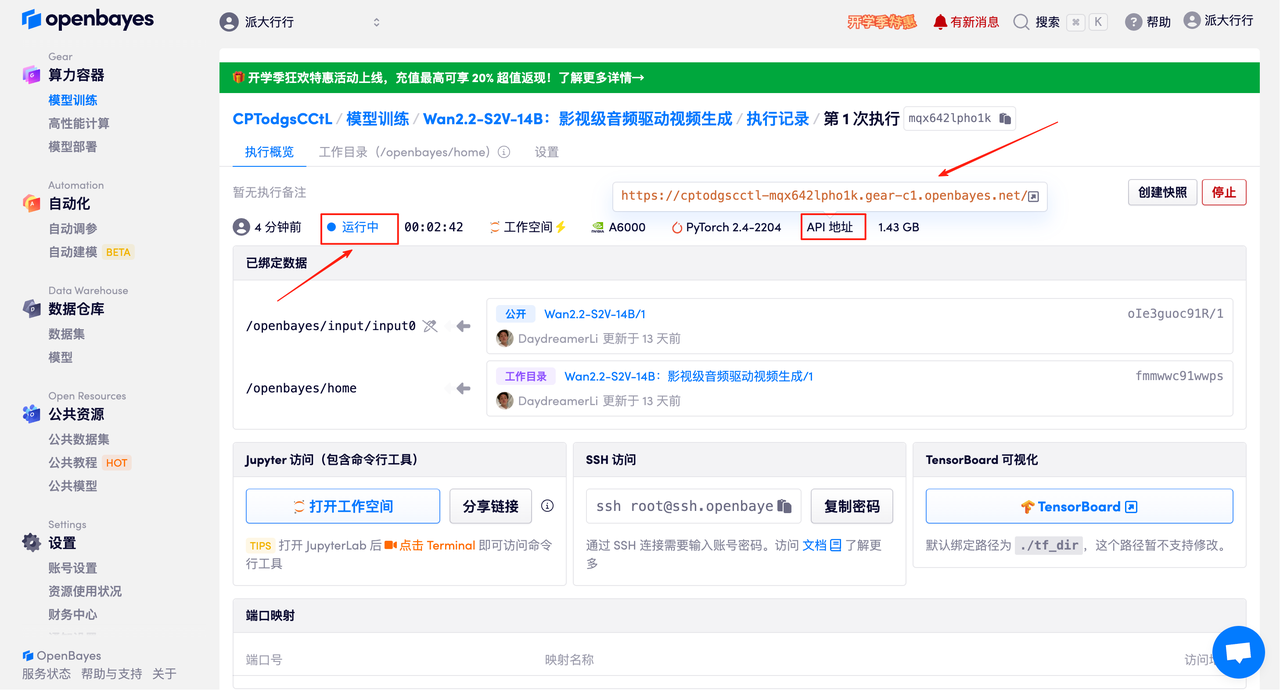

4. Attendez que les ressources soient allouées. Le premier clonage prendra environ 3 minutes. Lorsque le statut passe à « En cours d'exécution », cliquez sur la flèche à côté de « Adresse API » pour accéder à la page de démonstration. Veuillez noter que les utilisateurs doivent s'authentifier avec leur nom réel avant d'utiliser l'adresse API.

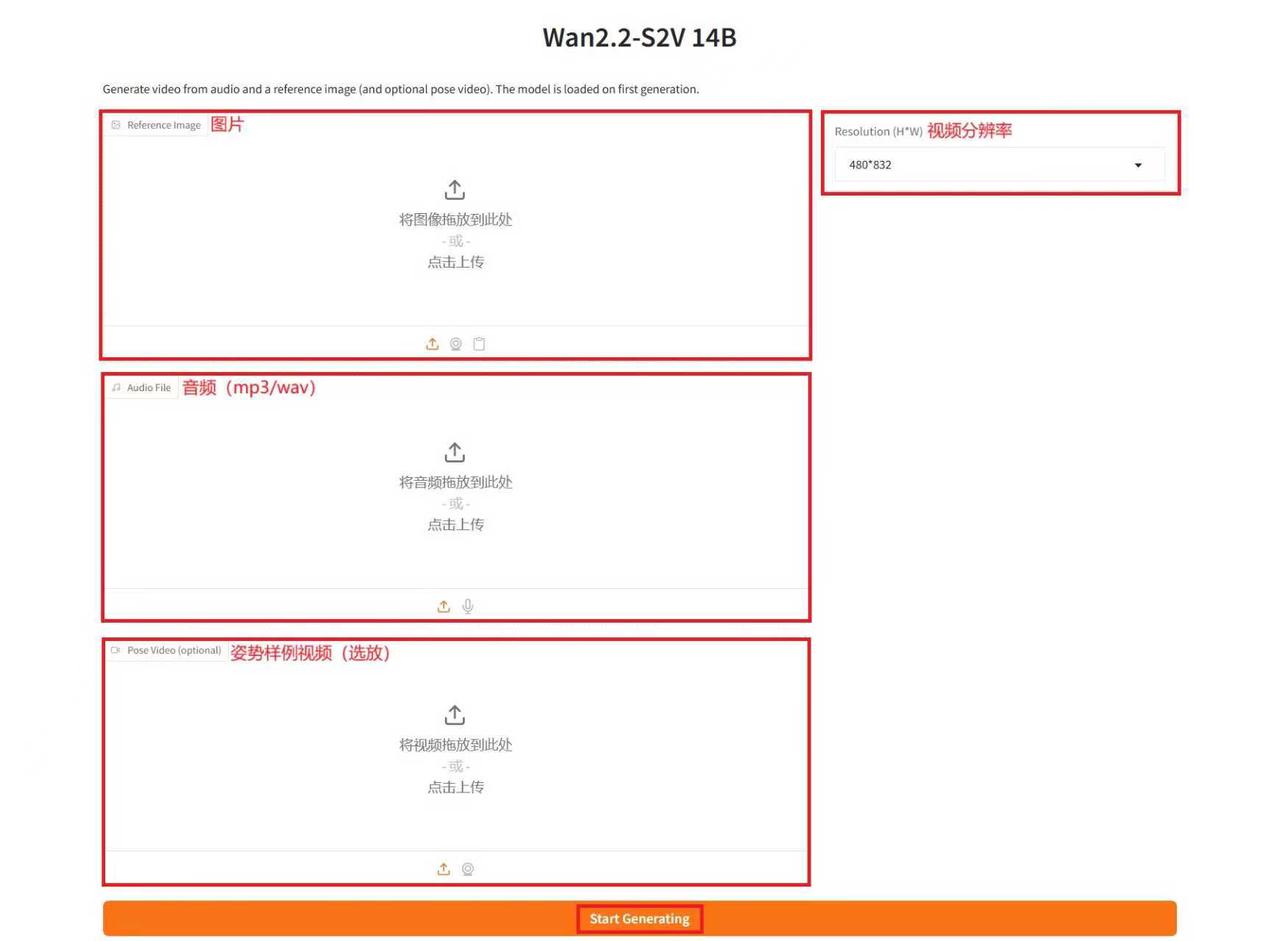

Démonstration d'effet

Après avoir accédé à la page de démonstration, saisissez une description dans la zone de texte, importez les images et l'audio, ajustez les paramètres selon vos besoins, puis cliquez sur « Démarrer la génération » pour générer la vidéo. (Remarque : un nombre élevé d'étapes d'inférence produit de meilleurs résultats, mais la génération est également plus longue. Veillez à définir le nombre d'étapes d'inférence de manière appropriée. Par exemple, avec 10 étapes d'inférence, la génération d'une vidéo prend environ 15 minutes.)

Générer un exemple

Le tutoriel ci-dessus est celui recommandé par HyperAI cette fois-ci. Bienvenue à tous pour le découvrir !

Lien du tutoriel :