Command Palette

Search for a command to run...

HyperAI Super Neural X Apache|Community Over Code Asia 2025 AI Special

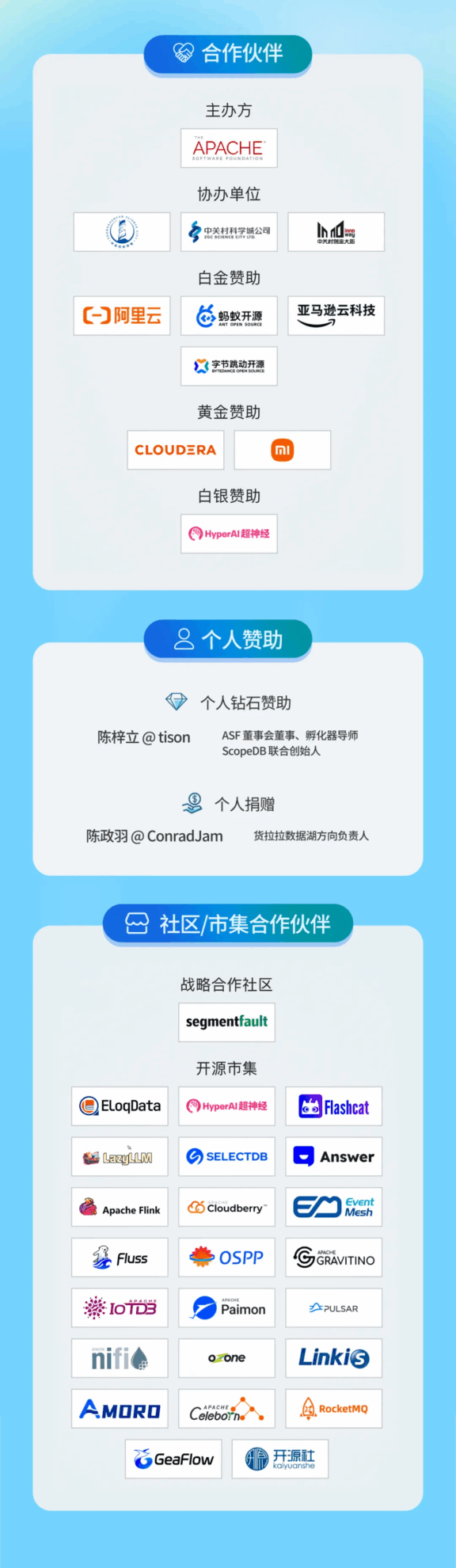

Du 25 au 27 juillet, Community Over Code Asia 2025, la série mondiale officielle de conférences de l'Apache Software Foundation (ASF), s'ouvrira au centre de conférences de la zone nationale de démonstration d'innovation indépendante de Zhongguancun à Pékin !

Le thème de cette conférence, consacré à l'IA, sera présenté conjointement par Wang Chenhan, fondateur et PDG d'OpenBayes Bayesian Computing, Tan Zhongyi, membre de l'Apache Software Foundation, et Du Junping, fondateur et PDG de Datastrato, en tant que producteurs experts. Ils vous présenteront également les dernières informations et pratiques de pointe en matière de construction et de développement de la communauté Apache, du 25 juillet de 14h00 à 17h15. HyperAI participera à cet événement en tant que communauté coopérative et installera un stand. Venez jouer !

Thème spécial

Le forum IA est une plateforme de communication professionnelle axée sur la combinaison de l'intelligence artificielle (IA) et des projets open source Apache. Il vise à réunir développeurs, chercheurs et utilisateurs industriels du monde entier pour discuter de l'application et du développement de l'IA dans l'écosystème open source, présenter des technologies de pointe, partager des expériences pratiques et promouvoir la mise en œuvre de solutions d'IA open source dans divers secteurs.

Les sujets appropriés pour ce forum sont :

- Projets liés à l'IA sous la direction de la Fondation Apache (par exemple, axés sur les frameworks d'IA open source et les projets de bibliothèque de base tels qu'Apache TVM, Mahout, Singa, SystemML, etc.)

- Optimisation des projets uniques Apache dans les scénarios d'IA (tels que Spark MLib, Flink ML, etc.)

- Solutions d'IA pour les scénarios industriels basées sur la combinaison de plusieurs projets Apache, comme la méthode de construction d'entreprise d'IA d'une certaine entreprise

Producteur

Wang Chenhan

Fondateur et PDG d'OpenBayes Bayesian Computing, l'un des traducteurs de documents chinois Apache TVM et directeur adjoint du Centre de recherche conjoint en informatique bayésienne de l'Université de Tianjin. Il a travaillé pour des entreprises technologiques telles que Walt Disney Interactive Media Group et AVOS Systems, et a été secrétaire général de la Fondation CLUE Benchmarks, une organisation open source.

Tan Zhongyi

Secrétaire général adjoint du COPU, vétéran de l'open source depuis plus de 20 ans, membre de l'Apache Software Foundation.

Du Junping

Fondateur et PDG de Datastrato, directeur de la Fondation LF AI & DATA, membre de l'Apache Software Foundation, expert en technologies Big Data et Open Source, membre de l'Apache Open Source Foundation, committer et PMC d'Apache Hadoop, OZone, YuniKorn et d'autres projets, mentor d'Apache Gravitino, NuttX et d'autres projets. Ancien président du comité Open Source des entreprises du Fortune 500, directeur R&D des plateformes Big Data, directeur général de l'activité Open Source, ancien responsable de l'équipe informatique Hadoop de Hortonworks, etc.

Points saillants de l'ordre du jour

📅 25 juillet 14h00 – 17h15

Sujet de la conférence : Optimiser l'utilisation hétérogène des GPU grâce au cloud | Exploiter la puissance de HAMi

Moment de partage : 25 juillet, 14h00-14h30

Introduction : Avec la popularité croissante de l’IA, Kubernetes est devenu la norme de facto pour les infrastructures d’IA. Cependant, la multiplication des clusters contenant plusieurs appareils d’IA (tels que NVIDIA, Intel, Huawei Ascend, Haiguang, Muxi, Cambrian, Tianshu Zhixin, Suiyuan, etc.) a engendré des défis majeurs. Les appareils d’IA sont coûteux. Comment optimiser l’utilisation des ressources ? Comment mieux s’intégrer aux clusters K8 ? Comment gérer uniformément des appareils d’IA hétérogènes, prendre en charge des stratégies de planification flexibles et garantir l’observabilité ? Tous ces défis sont nombreux. Le projet HAMi a vu le jour. Cette présentation comprend :

- Comment Kubernetes gère les appareils d'IA hétérogènes (planification unifiée, observabilité)

- Améliorer l'utilisation des appareils grâce au partage du GPU

- Assurer la qualité de service pour les tâches hautement prioritaires dans les scénarios de partage de GPU

- Prend en charge les politiques de planification GPU flexibles (affinité/anti-affinité NUMA, emballage/dispersion, etc.)

- Intégration avec d'autres projets (tels que Volcano, scheduler-plugin, etc.)

- Partage de cas réels d'utilisateurs de niveau production

- Défis actuels et projets futurs

Intervenants :

Xiao Zhang, fondateur de dynamia.ai, passionné du cloud natif et mainteneur de communauté, se concentrant sur l'infrastructure de l'IA

Xiao Zhang est le fondateur de dynamia.ai (axé sur l'infrastructure, l'IA, la gestion multi-cluster, la gestion du cycle de vie des clusters (LCM) et l'Open Container Initiative (OCI)). Il contribue activement à la communauté et est passionné par les technologies cloud natives. Il est actuellement membre du groupe d'intérêt spécial Kubernetes/Kubernetes (Kubernetes-sigs) et assure la maintenance des projets Karmada, Kubean et Cloudtty. Il est également co-sponsor et mainteneur du projet CNCF HAMi, dont l'identifiant GitHub est wawa0210.

Yu Yin, Product Owner @dynamia.ai, Responsable Open Source @HAMi, Pilote la virtualisation GPU et l'innovation en matière d'infrastructure IA sur Kubernetes

Yu Yin est le responsable produit de dynamia.ai et le principal mainteneur de HAMi, un projet open source dédié à la virtualisation GPU et au calcul hétérogène sur Kubernetes. Fort d'une expérience pratique dans la création d'infrastructures d'IA, Yu se concentre sur le partage évolutif des GPU, la mise en commun des appareils et la planification intelligente pour les environnements multi-architectures. Il a aidé des utilisateurs d'entreprise des secteurs de la logistique, des télécommunications et de la finance à adopter une gestion hétérogène des ressources en production. Parallèlement, M. Yu est un fervent défenseur des applications open source en Chine et pilote l'internationalisation de la communauté HAMi.

Sujet du discours : L'exploration et la pratique d'Apache Doris dans le domaine de l'IA

Moment de partage : 25 juillet, 14h30-15h00

Introduction au sujet : En tant que base de données d'analyse OLAP en temps réel populaire, Apache Doris a développé ou prévoit de développer davantage de fonctions et de composants périphériques liés à l'IA, tels que la récupération vectorielle, MCP, RAG et d'autres modules fonctionnels, dans le contexte actuel d'évolution rapide de l'IA. Cette présentation présentera les progrès actuels de Doris dans le domaine de l'IA par la communication et la démonstration.

Intervenants :

YiJia Su|Commitrateur Apache Doris, architecte de solutions SelectDB, sponsor PowerData

Apache Doris Committer, évangéliste de la communauté Apache Doris, contributeur Doris-MCP, architecte de solutions senior SelectDB, initiateur de la communauté PowerData, a aidé des centaines d'entreprises de la communauté Apache Doris à mener à bien la construction et l'évolution de l'optimisation de l'entrepôt de données en temps réel.

Sujet de la conférence : Apache Gravitino | Solutions de gestion des métadonnées à l'ère de l'IA

Moment de partage : 25 juillet, 15h00-15h30

Introduction au sujet :

La gestion des métadonnées est devenue la pierre angulaire de l'ère de l'IA. Cette conférence explorera comment Apache Gravitino permet de gérer des données et des modèles non structurés à grande échelle, et comment Xiaomi utilise Gravitino pour le traitement des données des modèles de langage volumineux (LLM) et la gestion du cycle de vie des modèles.

Plan du discours :

1. Défis de la gestion des ensembles de données et des modèles dans les flux de travail d'IA, et comment Gravitino aborde ces problèmes grâce à son catalogue de fichiers (gouvernance structurée des ensembles de données d'IA) et son catalogue de modèles (gestion unifiée du cycle de vie des modèles)

2. Maximisez l'efficacité opérationnelle et la conformité de la gouvernance en tirant parti du système de marquage, du suivi de la lignée et des capacités de gestion des informations d'identification de Gravitino

3. La pratique de Fileset dans le traitement des données de Xiaomi : dans les scénarios d'IA, le traitement des données implique plusieurs étapes, telles que le téléchargement, l'extraction, le filtrage, la déduplication et l'apprentissage. L'utilisation de Fileset améliore l'efficacité du pipeline entre les données et les moteurs d'IA, met en œuvre une gestion de bout en bout des ensembles de données et établit une vue unifiée des métadonnées.

4. Pratique de gestion des grands modèles d'IA de Xiaomi : comment Xiaomi gère les métadonnées des grands modèles, déploie les services de modèles et nos projets futurs d'intégration avec Gravitino

Intervenants :

Xiaojing Fang|Ingénieur logiciel Apache Gravitino PPMC et Datastrato

Membre d'Apache Gravitino PPMC, axé sur les systèmes d'infrastructure de données et d'IA.

Han Zhang|Ingénieur R&D logiciel chez Xiaomi

Contributeur Apache Gravitino, responsable de la recherche et du développement de la plateforme de développement Xiaomi AI.

Sujet de la conférence : Le catalogue comme contexte | Utiliser les métadonnées pour piloter et gérer la prochaine vague de développement de l'IA

Moment de partage : 25 juillet, 15h45-16h15

Introduction au sujet : Le développement d’outils d’IA performants est notre thème de cette année. Les agents intelligents et les modèles de base ont réalisé des progrès significatifs dans divers domaines. Mais les questions fondamentales demeurent : comment fournir à ces applications des données efficaces ? Comment atteindre l’échelle de l’entreprise ? Quel est l’essence du contexte ? Cette conférence explorera l’état actuel de l’écosystème du Big Data, les défis auxquels sont confrontées les plateformes de données d’IA et les raisons pour lesquelles les catalogues de données et les métadonnées constituent la seule voie viable vers un développement d’IA efficace et contrôlable. Nous utiliserons l’exemple du framework open source Apache Gravitino pour expliquer pourquoi ces solutions doivent rester neutres vis-à-vis des fournisseurs.

Intervenants :

Jerry Shao|Datastrato, directeur technique

Jerry Shao est cofondateur et directeur technique de Datastrato. Il travaille dans le domaine du Big Data open source depuis plus de dix ans. Membre d'Apache, il est contributeur et membre du PMC d'Apache Spark et d'Apache Inlong, et fondateur du projet Apache Gravitino (en cours d'incubation).

Sujet de la conférence : Des données à l'IA | Création d'une plateforme d'analyse unifiée basée sur Apache Cloudberry

Moment de partage : 25 juillet, 16h15-16h45

Introduction au sujet :

Aujourd'hui, les entreprises peinent à exploiter pleinement le potentiel de l'IA en raison de la fragmentation des systèmes de données, de l'inefficacité des flux de traitement et du fossé entre l'analytique et l'apprentissage automatique. Apache Cloudberry, un entrepôt de données MPP open source, redéfinit ce paradigme en intégrant en profondeur les capacités de traitement des données et d'IA, supprimant ainsi les obstacles et accélérant l'innovation.

Cette conférence montrera comment Cloudberry peut :

- Exécution unifiée : exécutez des modèles d'IA/ML natifs (tels que PyTorch, Scikit-learn) directement sur l'entrepôt de données

- Analyse multimodale : Traitement de données structurées et non structurées (PDF, images, etc.) dans un cadre unifié

- Applications de données intelligentes : création de systèmes de questions-réponses améliorés par RAG, de BI conversationnelle et de recherche multimodale

Vous apprendrez à faire converger les données et l’intelligence dans une plateforme unifiée pour simplifier votre architecture tout en faisant évoluer les charges de travail de l’IA.

Intervenants :

Chuanxin Bian|HashIngénieur Data, Data & AI

Le Dr Chuanxin Bian est un data scientist et mathématicien appliqué spécialisé en apprentissage profond, traitement du langage naturel et modélisation de séries chronologiques. Il est titulaire d'un doctorat en mathématiques appliquées de l'Université polytechnique de Hong Kong. Il travaille actuellement chez HashData, où il dirige le développement d'outils d'IA tels que HashML et ChatData, ainsi que d'applications AIGC. Il était ingénieur R&D senior chez Baidu, où il a participé au développement du grand modèle Wenxin, construit un modèle de séries chronologiques basé sur PaddleTS et promu la mise à niveau du système de portraits utilisateurs. Il maîtrise Python et les frameworks d'apprentissage profond, et sait parfaitement relier la théorie à la pratique pour promouvoir l'innovation en IA.

Sujet du discours : Analyse de la technologie de recherche hybride Apache Doris

Moment de partage : 25 juillet, 16h45-17h15

Introduction au sujet :

La fonction de recherche hybride d'Apache Doris combine la recherche plein texte traditionnelle (recherche par dictionnaire par mots-clés) et la recherche vectorielle (recherche sémantique) pour fournir des résultats plus précis. Cette fonctionnalité est particulièrement adaptée aux scénarios de recherche complexes nécessitant à la fois la correspondance des mots-clés et la compréhension sémantique, comme le e-commerce, la recommandation de contenu et la recherche dans les bases de connaissances.

1. Principes fondamentaux de la récupération hybride

La recherche hybride tire pleinement parti des avantages des deux méthodes de recherche :

- Recherche plein texte (BM25) : Basée sur l'index inversé et la correspondance par mots-clés, elle permet de trouver précisément les termes de requête saisis par l'utilisateur. Doris utilise l'algorithme BM25 (par défaut) pour calculer le score de pertinence entre le document et la requête, ce qui est adapté à la recherche textuelle structurée.

- Récupération de vecteurs (recherche sémantique) : En convertissant le texte en vecteurs (incorporation), un modèle d'apprentissage automatique est utilisé pour calculer la similarité sémantique entre la requête et le document. Il permet de comprendre l'intention et le contexte de la requête.

- Mécanisme de fusion : utiliser des techniques de notation et de classement spécifiques (telles que la fusion de rang réciproque/RRF ou la combinaison convexe/CC) pour intégrer les résultats de recherche des deux méthodes et équilibrer la pertinence lexicale et la pertinence sémantique.

2. Architecture de mise en œuvre technique

La recherche hybride Doris s'appuie sur les composants techniques et les flux de travail suivants :

1. Prise en charge du type de champ

- Champ de texte : générer un index inversé via un segmenteur de mots pour prendre en charge la recherche en texte intégral

- Champ vectoriel : utilisez le modèle pour convertir du texte en stockage de type vectoriel

2. Indice composite

- Prend en charge le stockage de champs de texte et de vecteurs

- Activer la fonctionnalité de requête hybride

3. Processus d'exécution de la requête

- Requête de dictionnaire : utilisez la requête de correspondance pour récupérer les documents correspondant aux mots-clés (basé sur l'algorithme BM25)

- Requête vectorielle : utilisez une requête knn ou un index ANN pour récupérer des documents sémantiquement similaires (basés sur la similarité cosinus, etc.)

- Requête hybride : exécuter deux requêtes en parallèle et combiner les résultats via un algorithme de fusion

4. Stratégie de fusion des résultats

- RRF (Reverse Ranking Fusion) : calcule un score complet basé sur le classement du document dans différents résultats de requête, en mettant l'accent sur les documents bien classés dans plusieurs méthodes de recherche

- CC (combinaison convexe) : intégrez les scores de requête BM25 et vectoriels via une sommation pondérée et ajustez manuellement l'équilibre des pondérations

- Prend en charge une optimisation supplémentaire du classement des résultats via script_score ou le modèle Rerank

Intervenants :

Lee Happen|SelectDB Senior-RD

Membre du PMC Apache Doris

📅 26 juillet 14h00 – 16h45

Sujet de la conférence : Intégration de grands modèles de langage dans les pipelines CI/CD | Cas pratiques pour améliorer la qualité du code des projets Apache

Moment de partage : 26 juillet, 14h00-14h30

Introduction au sujet : Cette présentation explorera comment intégrer systématiquement les grands modèles de langage (LLM) dans GitHub Actions afin d'améliorer la qualité du code et la sécurité des projets Apache. Le contenu est basé sur le cas réel d'apache/brpc#2911. Il est particulièrement adapté aux développeurs et mainteneurs qui recherchent des stratégies concrètes et peu coûteuses pour concevoir, implémenter et déployer des agents d'IA afin de garantir la qualité du code.

Nous guiderons le public à réfléchir aux aspects suivants :

- Collaboration homme-machine : comparaison du modèle traditionnel de « copilote » (piloté par l'homme, synchrone) avec les flux de travail asynchrones des agents d'IA dans les pipelines, mettant en évidence les gains d'efficacité et les compromis

- Pratique : Apprenez à utiliser les LLM pour effectuer des tâches ciblées telles que l'analyse de la robustesse du code et la détection CVE sous des contraintes de ressources - sans dépendre de RAG, de réglage fin ou de MCP

Intervenants :

Yi Yuan|développeur de logiciels

Responsable du projet Kepler CNCF, principalement responsable des travaux liés au pipeline du projet.

Sujet du discours : Lance | Formats de données à la pointe de l'IA multimodale

Moment de partage : 26 juillet, 14h30-15h00

Introduction au sujet : L'entraînement de pointe des modèles multimodaux nécessite le traitement de données d'IA multimodales de niveau PB, notamment des vidéos, des images et des textes longs. La complexité et l'ampleur des nouvelles données d'IA posent des défis à l'infrastructure de données existante.

Le format Lance, sous licence Apache, repose sur Apache Arrow et Apache Datafusion. Son cœur est écrit en Rust. L'équipe de développement est composée de membres du PMC d'Apache Hadoop, Apache HBase, Apache Iceberg, Apache Arrow et Delta Lake. Le format Lance est un nouveau format de stockage en colonnes et un format de table axés sur l'IA, profondément inspirés des projets Apache Parquet, Apache Iceberg et Apache Hudi. Ses principales caractéristiques sont l'accès aléatoire et l'évolution de schémas sans coût, deux fonctionnalités plébiscitées par les ingénieurs en IA. Ces caractéristiques distinguent Lance d'Apache Parquet, Apache ORC ou Apache Iceberg, le rendant plus adapté à l'ingénierie des fonctionnalités et à l'entraînement de l'IA multimodale.

Le format Lance a été adopté par de nombreuses sociétés d'IA de premier plan telles que MidJourney, WorldLabs, Runway ML, Character AI, etc.

Cette conférence sera présentée conjointement par Xu Lei, CTO de LanceDB (membre d'Apache Hadoop PMC) et Yang Hua, expert de ByteDance Volcano Engine (membre d'Apache Hudi PMC) :

- Défis d'infrastructure pour soutenir les charges de travail des entreprises d'IA multimodales de pointe

- Les principes de conception fondamentaux du format Lance

- Comment ByteDance Volcano Engine construit le lac de données Lance basé sur le format Lance et prend en charge les plus grandes entreprises d'IA au monde

Intervenants :

Lei Xu, directeur technique chez LanceDB

Directeur technique de LanceDB. Membre du PMC Apache Hadoop/HDFS. Auparavant, il dirigeait l'équipe chargée de la plateforme d'apprentissage automatique et de l'infrastructure de données chez Cruise Automation.

Vino Yang : Expert technique en moteurs volcaniques, Lance Committer.

Expert technique de Volcano Engine, Lance Committer. Membre du PMC Apache Hudi/Kyuubi.

Sujet du discours : IA quantique | L'aube de l'ère de la superintelligence

Moment de partage : 26 juillet, 15h00-15h30

Introduction au sujet : L’intégration de l’informatique quantique et de l’intelligence artificielle est sur le point de repousser les limites de l’informatique classique et d’inaugurer l’ère de la superintelligence. Lorsque les modèles quantiques améliorés pourront atteindre un apprentissage exponentiel, résoudre des problèmes complexes en quelques secondes et redéfinir le processus décisionnel, entrerons-nous dans une nouvelle ère où l’IA dépassera le champ de compréhension humaine ?

Cette conférence explorera la prochaine frontière de l'intelligence artificielle, en se concentrant sur :

Apprentissage automatique quantique (QML) : comment l'IA peut utiliser la mécanique quantique pour atteindre des capacités de résolution de problèmes sans précédent

Réseaux de neurones quantiques : l’IA peut-elle apprendre à une échelle inimaginable ?

Superposition et parallélisme quantiques : l’IA va-t-elle évoluer du raisonnement séquentiel vers la pensée multidimensionnelle ?

Inspiration théorique : l’IA quantique deviendra-t-elle la pierre angulaire de la superintelligence artificielle (ASI) ?

Alors que nous nous dirigeons vers la découverte scientifique basée sur l’IA, l’intelligence posthumaine et une singularité potentielle de la connaissance, cette conférence remettra en question les paradigmes traditionnels de l’IA et explorera les possibilités lorsque l’IA ne pense plus comme les humains, mais pense bien mieux que les humains.

Intervenants :

Prakul Hiremath|UNIVERSITÉ TECHNOLOGIQUE DE VISVESVARAYA, ÉTUDIANT DE PREMIER CYCLE EN B.TECH ET BIOLOOP, PDG ET FONDATEUR

Prakul Hiremath est un chercheur, technologue et innovateur de la VTU Belagavi, en Inde. Ses travaux portent sur l'intelligence artificielle, la cybersécurité et l'optimisation des systèmes. Passionné par l'intelligence artificielle, les systèmes informatiques et les technologies du futur, il participe activement à la recherche sur la cybersécurité basée sur l'IA, l'analyse des signaux médicaux et les innovations de l'Industrie 4.0.

Ses travaux portent sur la détection des menaces par l'IA, l'analyse prédictive et le calcul haute performance, avec pour objectif de repousser les limites des systèmes intelligents et de la prise de décision autonome. Il explore également la vie améliorée par l'IA, l'intelligence posthumaine et l'évolution des connaissances, et s'engage à contribuer à des avancées majeures dans les technologies du futur.

Outre ses recherches en IA et en cybersécurité, Prakul participe activement à Bioloop, un projet de recherche innovant qui associe biotechnologie et intelligence artificielle pour développer des solutions de pointe dans les domaines du développement durable, de la santé et de l'automatisation industrielle. Bioloop vise à révolutionner les systèmes de bio-IA en créant une nouvelle génération d'écosystèmes intelligents optimisant les processus biologiques et technologiques.

Lors de Community Over Code Asia 2025, Prakul discutera de l'essor inéluctable de l'IA, des défis qu'elle pose et de ses profondes implications pour l'avenir de la technologie, du développement social et de l'intelligence humaine.

Sujet : Utiliser ou non MCP ? Concevoir des systèmes d'IA composables à l'aide de protocoles ouverts.

Moment de partage : 26 juillet, 15h45-16h15

Introduction au sujet : Avec le développement diversifié des applications d’IA, l’intégration point à point d’outils et de services personnalisés a engendré des problèmes de fragmentation et des coûts de maintenance élevés. En tant que protocole ouvert, le protocole MCP (Model Context Protocol) établit une méthode de connexion unifiée entre les agents d’IA et les outils externes grâce à des processus de découverte, d’appel et d’interaction standardisés. Ce partage présentera les défis de l’interopérabilité dans l’écosystème actuel de l’IA. Prenant l’exemple de Llama-Nexus, il montrera comment assurer la composabilité et l’orchestration flexible des systèmes d’IA grâce à des services MCP développés en natif. Enfin, l’importance stratégique des protocoles ouverts pour favoriser l’interconnexion et l’interopérabilité des systèmes d’IA, réduire la complexité de l’intégration et promouvoir l’innovation, ainsi que l’orientation future du développement de l’écosystème de l’IA composable, seront abordées. github.com/LlamaEdge/llama-nexus

Intervenants :

Miley Fu|Ambassadrice du CNCF, membre fondateur du runtime open source WasmEdge

Miley est une évangéliste du développement, passionnée par l'encouragement des développeurs à créer et à contribuer à des projets open source. Elle est coprésidente et conférencière principale du KubeCon+Open Source Summit 2024 et d'AI Dev China 2024. Membre fondatrice de l'environnement d'exécution WasmEdge dans le sandbox CNCF, elle travaille sur le projet depuis plus de 6 ans et est intervenue lors d'événements tels que KubeCon, KCD, CloudDay Italie, DevRelCon, Japan Open Source Summit, AWS User Group, Global AI Note, KubeDay Singapour, etc. Miley rédige du contenu technique et organise des événements pour développeurs, notamment les rencontres KCD Pékin, KCD Shenzhen, WebAssembly & Rust Taipei, Singapour, etc.

Sujet du discours : Pourquoi avons-nous besoin d’une passerelle IA open source ?

Moment de partage : 26 juillet, 16h15-16h45

Introduction au sujet : À l'ère de l'explosion des applications d'IA, le trafic des API a explosé, mais des défis tels que la maîtrise des coûts, la conformité en matière de sécurité et la gestion multi-modèles persistent. Apache APISIX, la passerelle API open source la plus active au monde, lancera officiellement ses fonctionnalités de passerelle d'IA en 2025 afin d'offrir aux développeurs et aux entreprises une solution unique.

Pourquoi choisir APISIX AI Gateway ?

Gestion unifiée des services d'IA : proxy transparent des demandes pour les grands modèles grand public tels qu'OpenAI, Deepseek et QWen, évitez le verrouillage des fournisseurs et optimisez les coûts/performances grâce à une orchestration dynamique du trafic.

Sécurité et conformité : les plug-ins de protection IA intégrés (tels que ai-prompt-guard pour filtrer les entrées malveillantes et ai-rate-limiting pour mettre en œuvre une limitation de débit basée sur des jetons) garantissent la confidentialité et la conformité des données.

Expérience axée sur le développeur : plugins de rechargement à chaud, prise en charge multilingue (Java/Python/Go) et intégration native avec les microservices et l'écosystème Kubernetes.

Que vous soyez un développeur ou une entreprise, APISIX AI Gateway peut accélérer la mise en œuvre d'applications d'IA et libérer le potentiel d'innovation.

Intervenants :

Yuansheng Wang|API7.ai, directeur technique

Membre d'Apache APISIX PMC Membre de la Fondation Apache.

🌟 Cliquez sur le code QR ci-dessous pour scanner et acheter des billets

La quantité est limitée, venez participer 👆