Command Palette

Search for a command to run...

Tutoriel En Ligne | L'Université Nationale De Singapour Présente Le Modèle OmniConsistency Pour Un Transfert d'image plug-and-play

La stylisation d'images vise à transformer une image d'un style à un autre tout en préservant son contenu sémantique grâce à un modèle stylisé. Ces dernières années, avec l'émergence des modèles de diffusion, les méthodes de stylisation d'images les plus répandues sont passées des réseaux neuronaux profonds à des méthodes affinées par adaptation de bas rang (LoRA). Combinées à des modules de cohérence d'images, elles ont permis d'améliorer considérablement la qualité de la stylisation.

Bien que le modèle de stylisation d'image ait reçu de bons retours du marché,Cependant, les méthodes actuelles de stylisation d’images sont toujours confrontées à trois défis majeurs :Premièrement, il existe une cohérence limitée entre la sortie stylisée et l'entrée - bien que les modules existants puissent assurer un alignement structurel global, ils ont du mal à conserver les détails et les informations sémantiques dans des scènes complexes ; deuxièmement, il existe un problème de dégradation de style dans les scénarios d'image à image - la fidélité de style de LoRA et IPAdapter dans ce paramètre est généralement inférieure à celle des images générées par du texte ; troisièmement, le contrôle de la mise en page n'est pas suffisamment flexible - les méthodes qui reposent sur des conditions rigides (telles que les bords, les croquis, les postures) ont du mal à prendre en charge des changements structurels créatifs tels que les transformations de version Q.

Pour combler cette lacune,Le 28 mai 2025, le Show Lab de l'Université nationale de Singapour a publié OmniConsistency, un plug-in de cohérence universel qui utilise le transformateur massivement diffus (DiT).Il s'agit d'une conception entièrement plug-and-play, compatible avec tout style de LoRA sous le framework Flux, et basée sur le mécanisme d'apprentissage de cohérence des paires d'images stylisées pour obtenir une généralisation robuste.

Des expériences montrent qu’OmniConsistency améliore considérablement la cohérence visuelle et la qualité esthétique.Il atteint des performances comparables à celles du GPT-4o, comblant ainsi l'écart de performances entre les modèles open source et les modèles commerciaux en termes de cohérence de style.Il offre une solution économique et hautement contrôlable pour la création d'IA. De plus, sa compatibilité et ses fonctionnalités plug-and-play facilitent son utilisation par les développeurs et les créateurs.

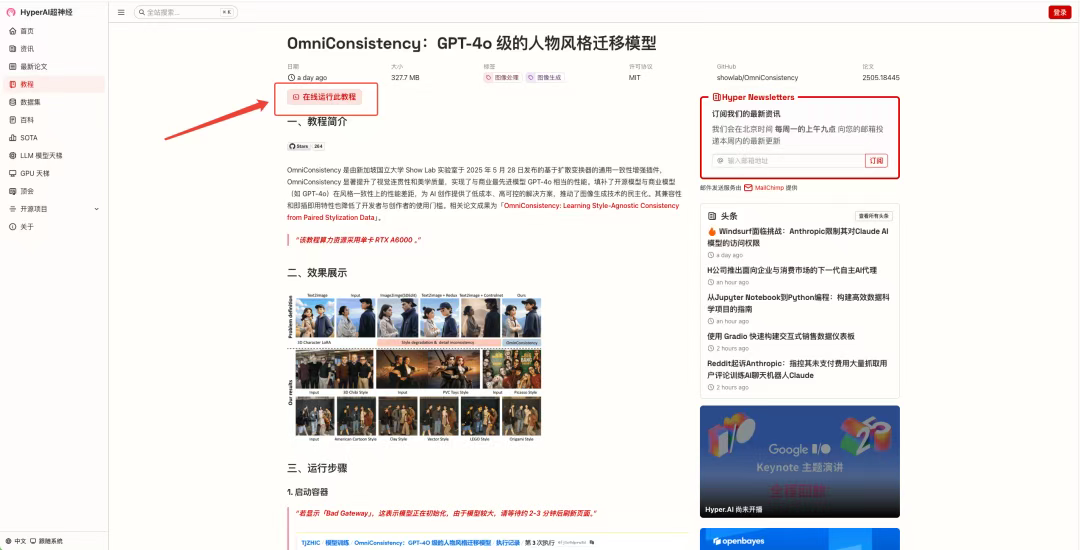

à l'heure actuelle,« OmniConsistency : un modèle de transfert de style de personnage de niveau GPT-4o » a été lancé dans la section « Tutoriels » du site Web officiel d'HyperAI.Cliquez sur le lien ci-dessous pour découvrir le tutoriel de déploiement en un clic ⬇️

* Adresse du tutoriel :https://go.hyper.ai/3mCyv

Nous avons également préparé des avantages surprises pour les nouveaux utilisateurs inscrits. Utilisez le code d'invitation « OmniConsistency » pour vous inscrire sur la plateforme OpenBayes et bénéficier de 4 heures d'utilisation gratuite de la carte graphique RTX A6000 (valable 1 mois). Quantité limitée, premier arrivé, premier servi !

Essai de démonstration

1. Après avoir accédé à la page d'accueil de hyper.ai, sélectionnez la page « Tutoriel », sélectionnez « OmniConsistency : modèle de transfert de style de caractère de niveau GPT-4o » et cliquez sur « Exécuter ce tutoriel en ligne ».

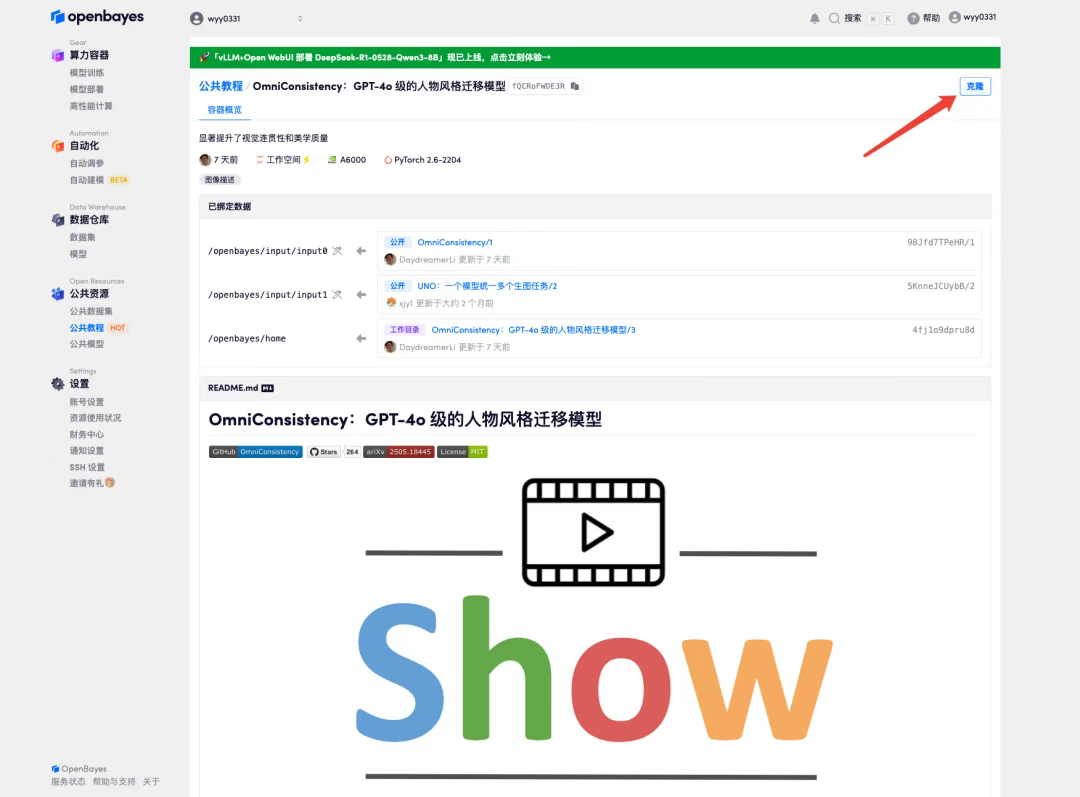

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

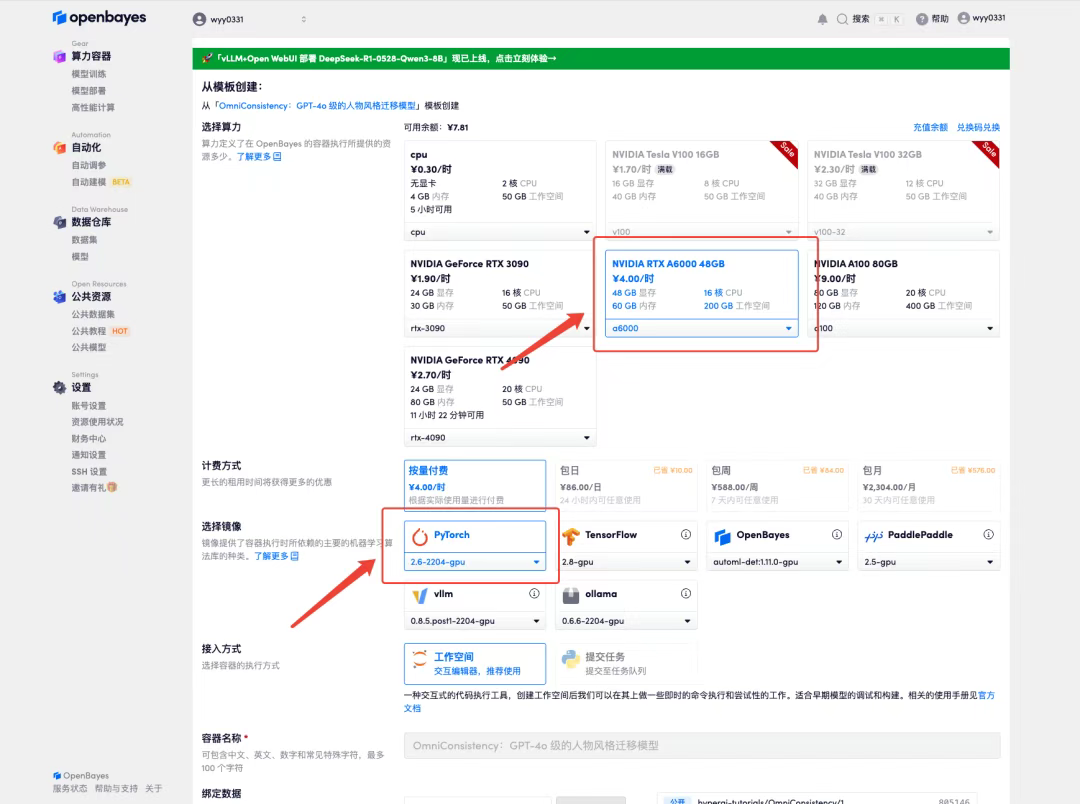

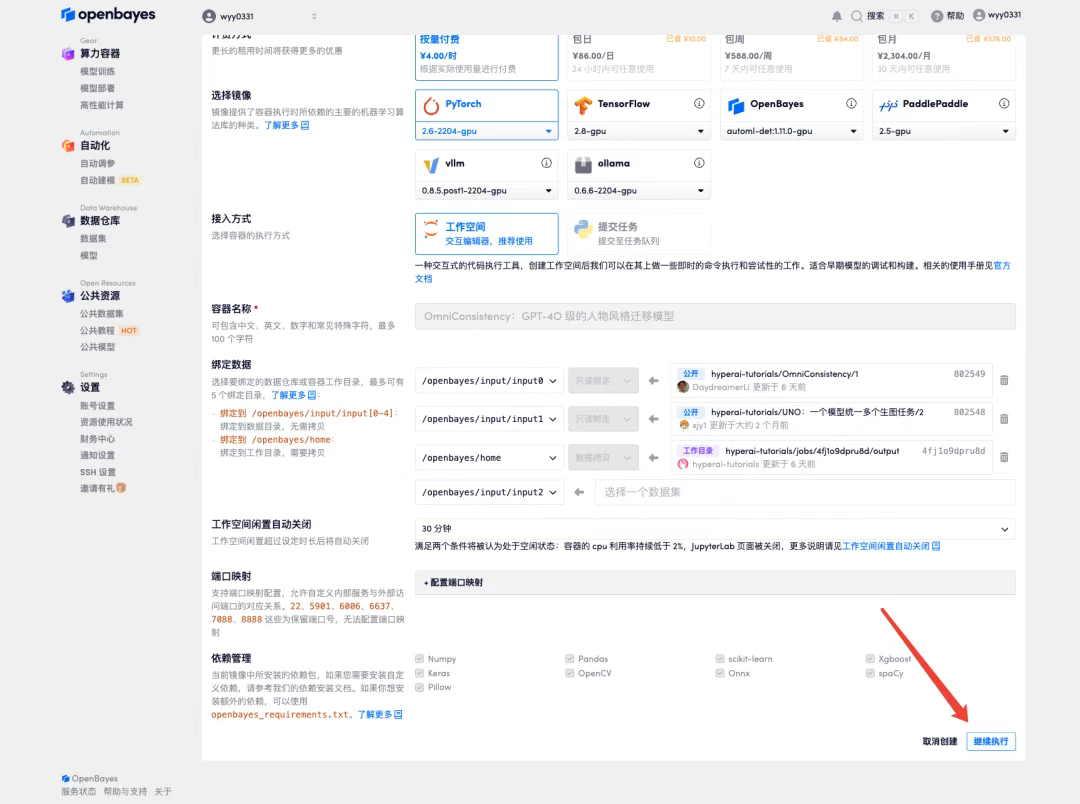

3. Sélectionnez les images « NVIDIA RTX A6000 48 Go » et « PyTorch ». La plateforme OpenBayes propose quatre modes de facturation : « Paiement à l'utilisation » ou « Journalière/Hebdomadaire/Mensuelle » selon vos besoins. Cliquez sur « Continuer ». Les nouveaux utilisateurs peuvent s'inscrire via le lien d'invitation ci-dessous pour obtenir 4 heures de RTX 4090 et 5 heures de temps processeur gratuit !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :

https://openbayes.com/console/signup?r=Ada0322_NR0n

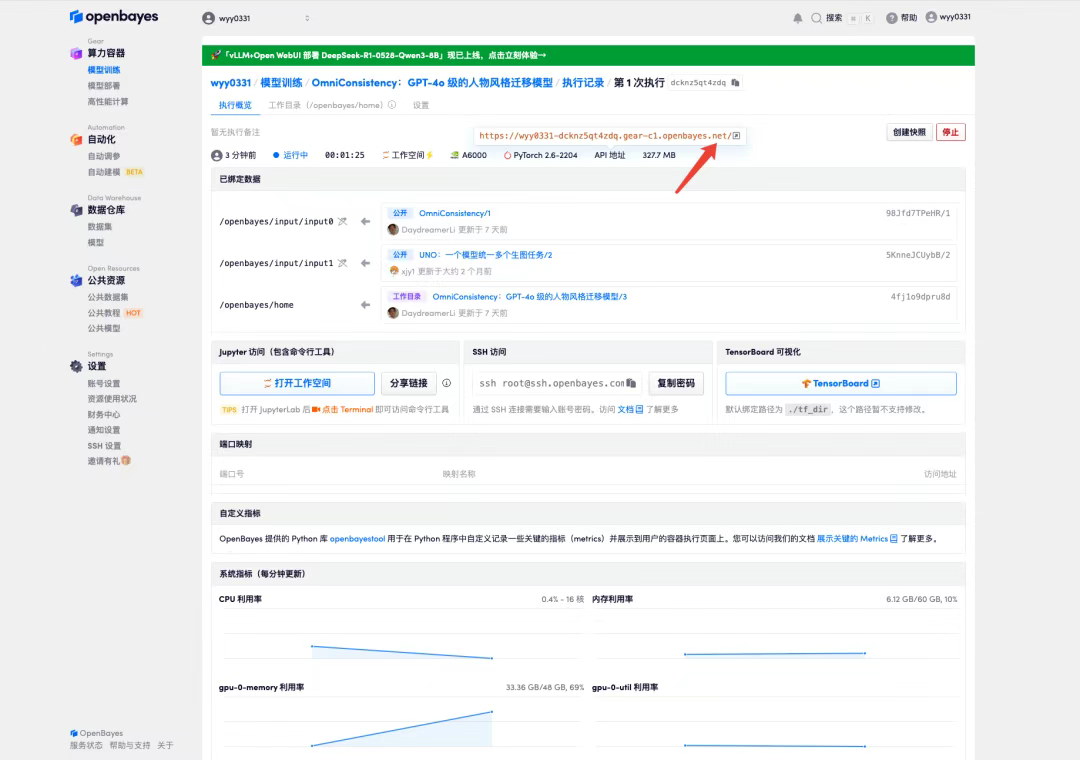

4. Attendez que les ressources soient allouées. Le premier processus de clonage prend environ 2 minutes. Lorsque le statut passe à « En cours d'exécution », cliquez sur la flèche de saut à côté de « Adresse API » pour accéder à la page de démonstration. Étant donné que le modèle est volumineux, il faut environ 3 minutes pour afficher l'interface WebUI, sinon « Bad Gateway » s'affichera. Veuillez noter que les utilisateurs doivent effectuer l'authentification par nom réel avant d'utiliser la fonction d'accès à l'adresse API.

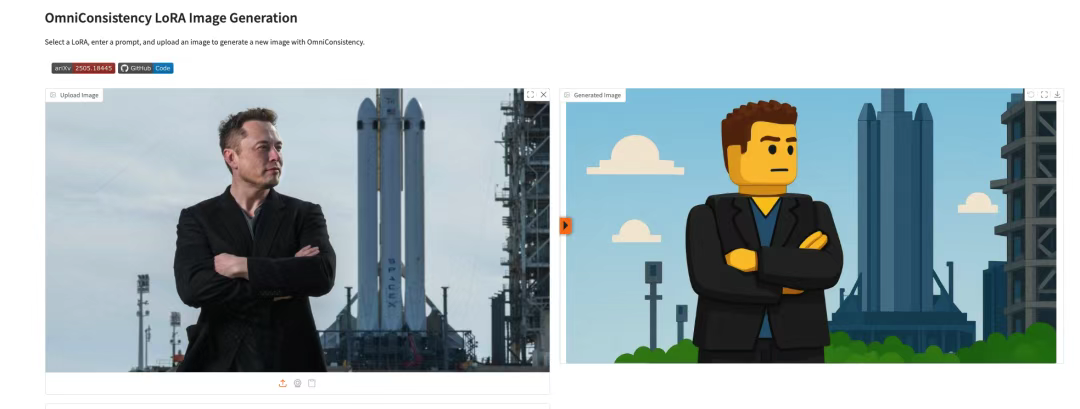

Démonstration d'effet

J'ai téléchargé une photo portrait, et le paramètre « Sélectionner LoRA intégré » est LEGO. L'effet est illustré dans la figure ci-dessous.