Command Palette

Search for a command to run...

La Capacité De Génération Pilotée Par Plusieurs Agents Atteint SOTA, Et Le Modèle Byte UNO Peut Gérer Une Variété De Tâches De Génération d'images

De nos jours, la génération pilotée par sujet est largement utilisée dans le domaine de la génération d'images, mais elle est toujours confrontée à de nombreux défis en matière d'évolutivité des données et d'évolutivité des sujets. Par exemple, il est particulièrement difficile de passer d’un ensemble de données mono-sujet à un ensemble de données multi-sujet et de l’étendre. La direction de recherche actuelle est celle du sujet unique, qui donne de mauvais résultats face aux tâches de génération multi-sujets.

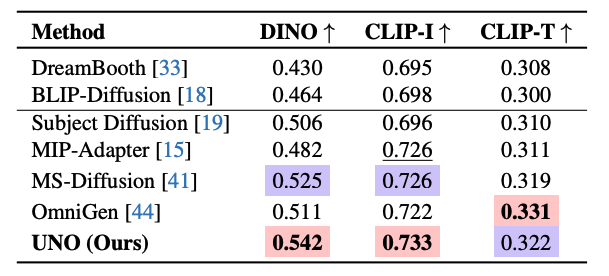

Compte tenu de cela,L'équipe de création intelligente de ByteDance, une société chinoise de technologie Internet, a utilisé la capacité de génération de contexte du modèle de diffusion Transformer pour générer des données appariées multi-agents hautement cohérentes et a proposé le modèle UNO basé sur FLUX, qui peut gérer différentes conditions d'entrée dans les tâches de génération d'images.Il utilise le nouveau paradigme de « coévolution modèle-données » pour enrichir les données de formation et améliorer la qualité et la diversité des images générées tout en optimisant les performances du modèle. Les chercheurs ont mené des expériences approfondies sur DreamBench et des benchmarks de génération pilotés par plusieurs agents. UNO a obtenu les scores DINO et CLIP-I les plus élevés dans les deux tâches, démontrant ses excellentes performances en matière de similarité de sujet et de contrôlabilité de texte, atteignant le niveau SOTA.

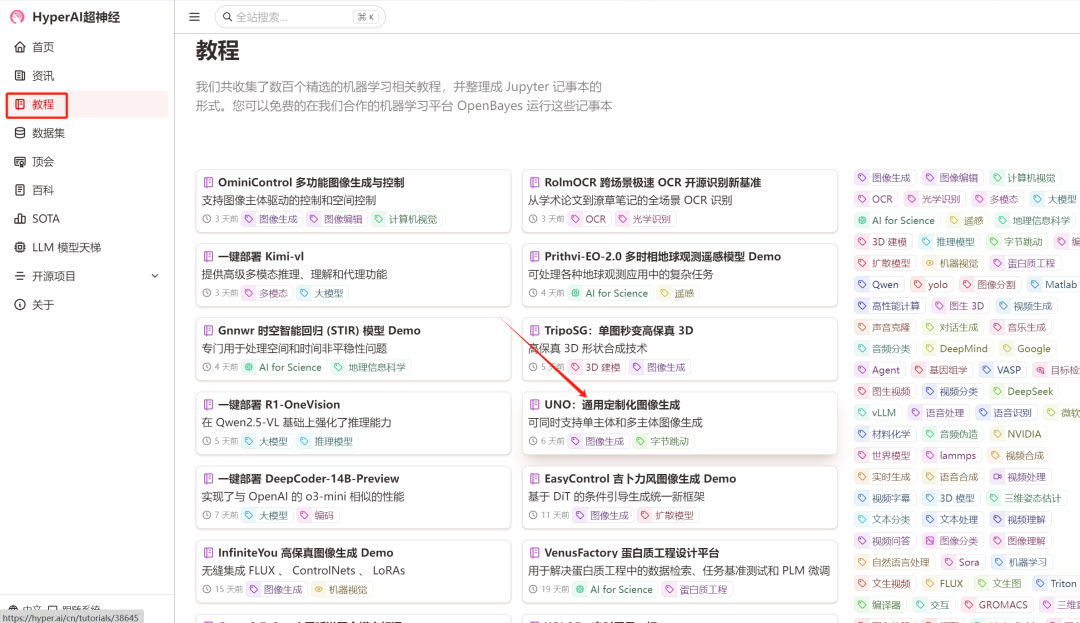

Actuellement, le tutoriel « UNO : Universal Customized Image Generation » a été lancé dans la section tutoriel du site officiel d'HyperAI.Cliquez sur le lien ci-dessous pour en faire rapidement l'expérience↓

Lien du tutoriel :https://go.hyper.ai/XELg5

Essai de démonstration

1. Connectez-vous à hyper.ai, sur la page Tutoriels, sélectionnez UNO : Génération d'images personnalisées universelles, puis cliquez sur Exécuter ce tutoriel en ligne.

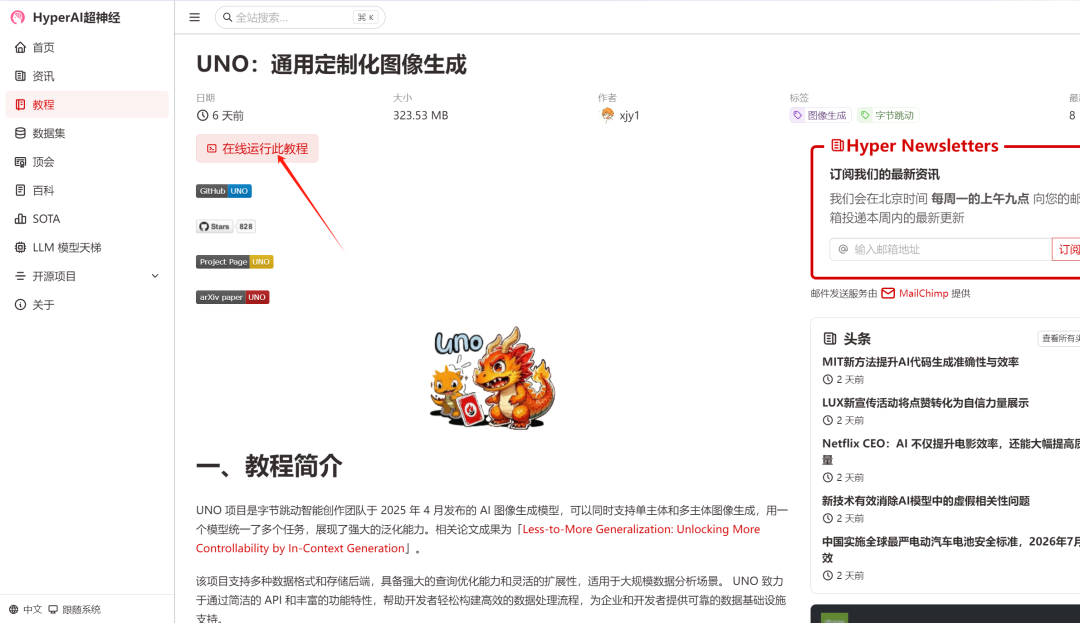

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

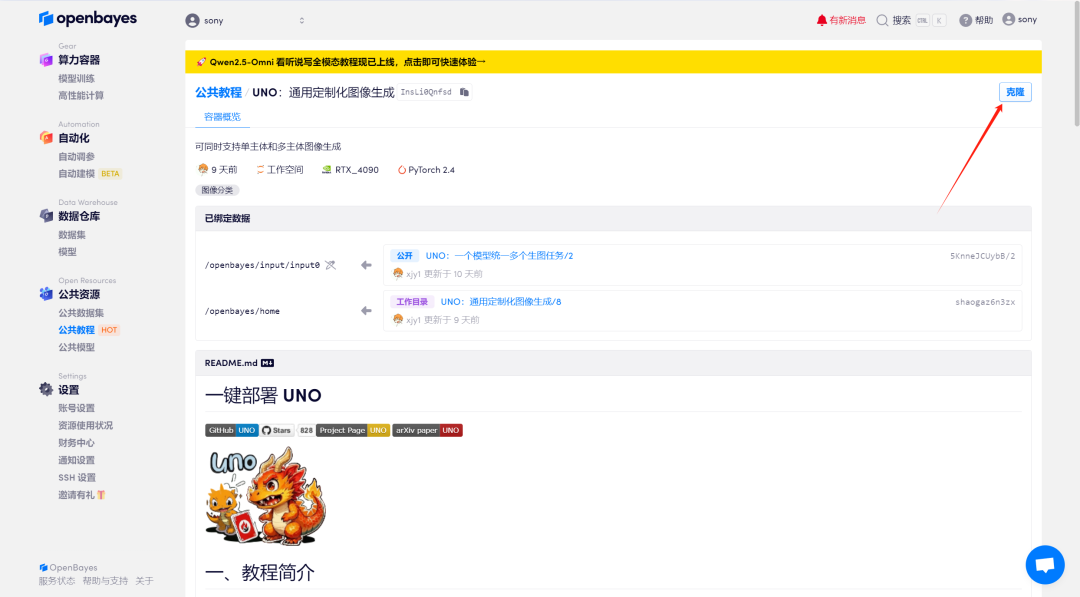

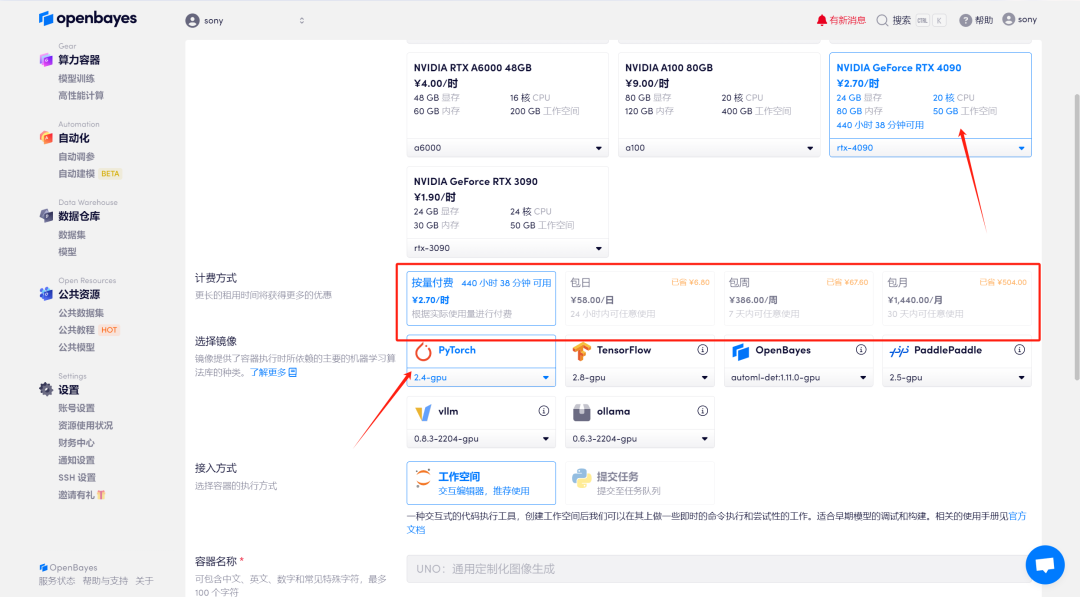

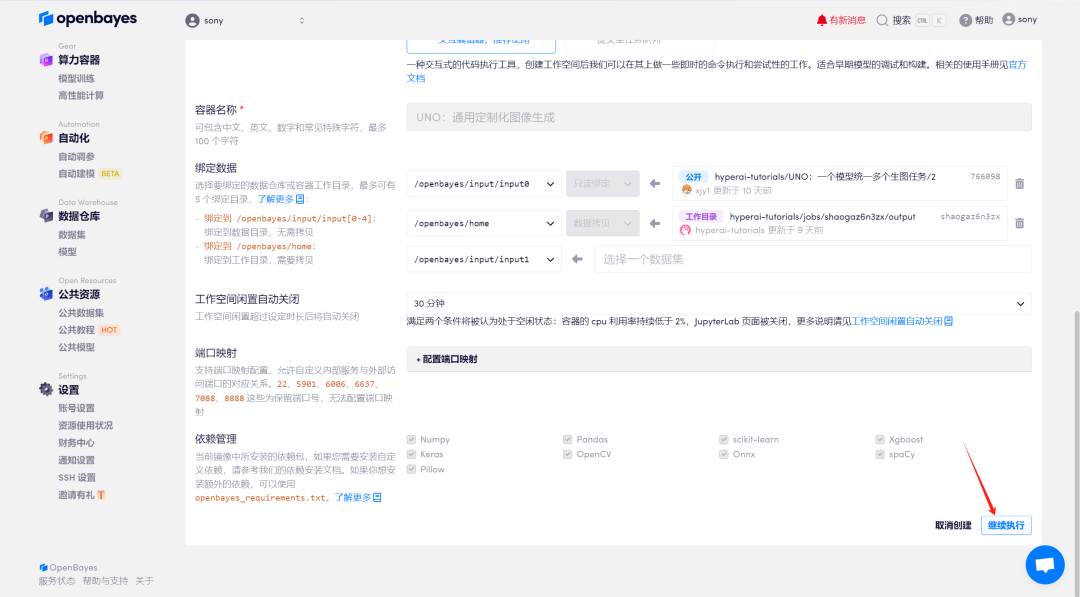

3. Sélectionnez les images « NVIDIA GeForce RTX 4090 » et « PyTorch ». La plateforme OpenBayes propose quatre méthodes de facturation. Vous pouvez choisir « Payer au fur et à mesure » ou « Quotidien/Hebdomadaire/Mensuel » selon vos besoins. Cliquez sur « Continuer ». Les nouveaux utilisateurs peuvent s'inscrire en utilisant le lien d'invitation ci-dessous pour obtenir 4 heures de RTX 4090 + 5 heures de temps CPU gratuit !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :

https://openbayes.com/console/signup?r=Ada0322_NR0n

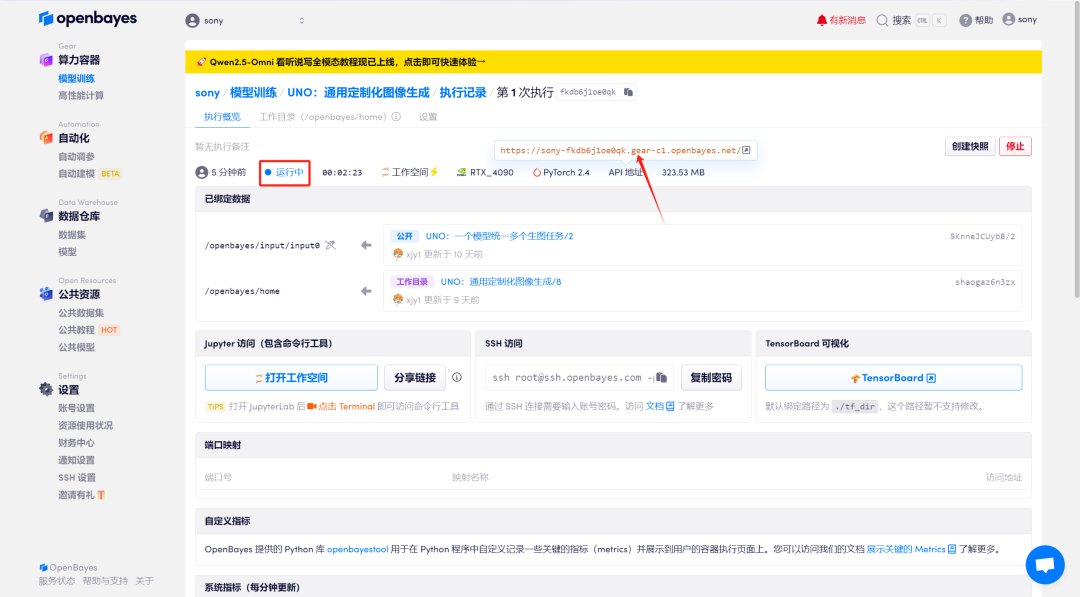

4. Attendez que les ressources soient allouées. Le premier processus de clonage prend environ 2 minutes. Lorsque le statut passe à « En cours d'exécution », cliquez sur la flèche de saut à côté de « Adresse API » pour accéder à la page de démonstration. Veuillez noter que les utilisateurs doivent effectuer l'authentification par nom réel avant d'utiliser la fonction d'accès à l'adresse API.

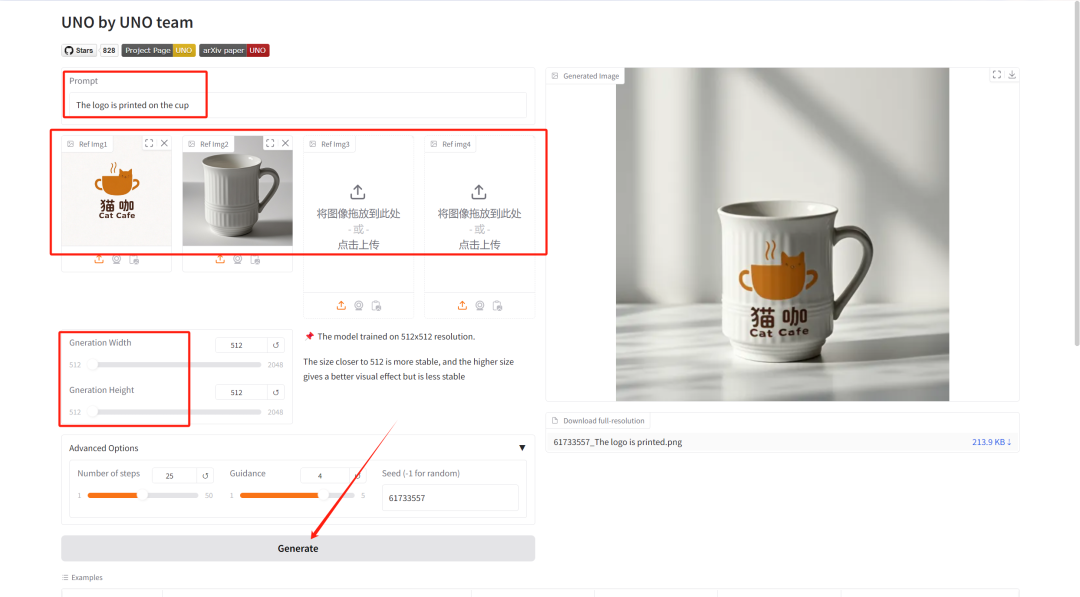

Démonstration d'effet

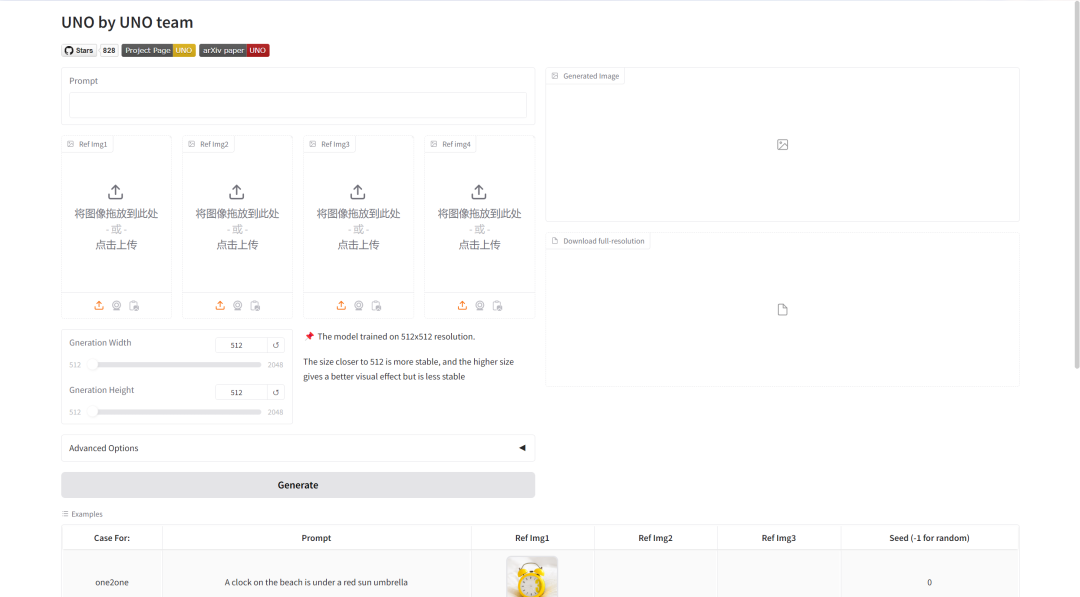

Saisissez le texte décrivant l'image générée dans « Invite », puis téléchargez le contenu de l'image générée dans « Ref Img ». Ajustez « Largeur/Hauteur de génération » pour sélectionner la longueur/largeur de l'image générée, puis cliquez enfin sur « Générer ».

Introduction au réglage des paramètres :

- Nombre d'étapes : Représente le nombre d'itérations du modèle ou le nombre d'étapes du processus d'inférence, représentant le nombre d'étapes d'optimisation que le modèle utilise pour générer le résultat. Un nombre plus élevé d’étapes produit généralement des résultats plus précis, mais peut augmenter le temps de calcul.

- Conseils: Il est utilisé pour contrôler le degré auquel les entrées conditionnelles (telles que le texte ou les images) dans les modèles génératifs affectent les résultats générés. Des valeurs de guidage plus élevées permettront aux résultats générés de correspondre plus étroitement aux conditions d'entrée, tandis que des valeurs plus faibles conserveront plus de caractère aléatoire.

- Graine: Il s'agit de la graine de nombre aléatoire, utilisée pour contrôler le caractère aléatoire du processus de génération. La même valeur Seed peut produire les mêmes résultats (à condition que les autres paramètres soient les mêmes), ce qui est très important pour reproduire les résultats.

Ici, nous avons téléchargé un logo et une photo d'une tasse, et la description textuelle est : Le logo est imprimé sur la tasse. Vous pouvez voir que le modèle a traité l’image pour nous avec beaucoup de précision.