Command Palette

Search for a command to run...

Les Dix « Meilleurs » ! Un Aperçu Des Principaux Événements De l'IA En 2024, Révélant Les Tendances Cachées Et Les Défis Du Secteur

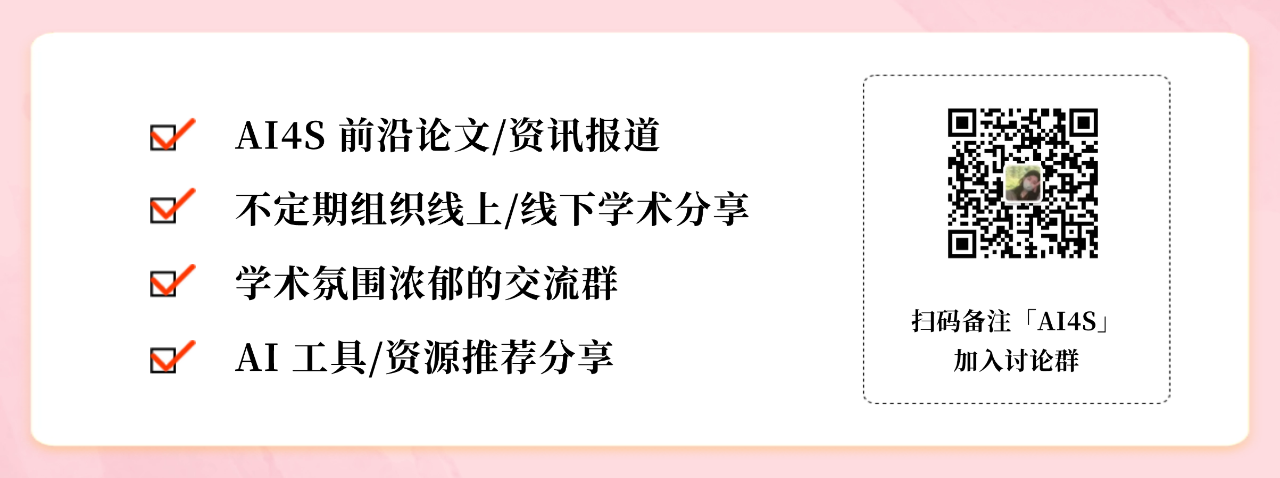

En 2024, la vague de l'IA continue de progresser avec acharnement, ne montrant aucun signe de déclin, remodelant tranquillement les contours du monde et écrivant des événements innovants qui battent des records.

Cette année, les fournisseurs d’infrastructures tels que NVIDIA et Broadcom, ainsi que les fournisseurs de services cloud tels que Microsoft, ont enregistré une forte croissance de leurs revenus liés à l’IA. Cette année, Nvidia a dépassé Apple et Microsoft à plusieurs reprises pour devenir l'entreprise la plus valorisée au monde. Les données de recherche du cabinet d'études de marché IoT Analytics sur le marché GenAI montrent que les revenus des GPU des centres de données de Nvidia augmenteront de 142% en 2024, portant sa valeur marchande à plus de 3,5 billions de dollars.

C'est également l'année où OpenAI et xAI ont tous deux levé plus de 6 milliards de dollars lors de cycles de financement, et l'indice Nasdaq, à forte composante technologique, a franchi pour la première fois la barre des 20 000 points…

Observant l'augmentation continue de l'enthousiasme pour le développement de l'IA, le cabinet d'études de marché IoT Analytics a sélectionné les dix principaux événements dans ce domaine qui méritent d'être suivis en 2024 :

01 ,Les événements les plus marquants en matière de cybersécurité de l'IA

Les pirates informatiques des États-nations utilisent les LLM pour améliorer leurs capacités d'attaque

14 février 2024Microsoft a annoncé que des pirates informatiques d’États-nations de Russie, de Chine, de Corée du Nord et d’Iran utilisaient les outils d’OpenAI pour améliorer leurs capacités d’attaque.

Microsoft a déclaré que ces organisations utilisent l’IA de différentes manières. Par exemple, le GRU russe utilise régulièrement des modèles de langage à grande échelle (LLM) pour étudier « diverses technologies de satellites et de radars qui pourraient être pertinentes pour les opérations militaires conventionnelles en Ukraine ». Entre-temps, des rapports ont fait état de pirates informatiques nord-coréens utilisant des LLM pour générer du contenu pour des campagnes de spear-phishing, tandis que des pirates informatiques iraniens ont utilisé ces modèles pour créer des e-mails plus convaincants.

02 ,Les réglementations les plus influentes en matière d'IA

Loi européenne sur l'IA

Le 13 mars 2024, le Parlement européen a adopté la loi européenne sur l’IA, qui entrera en vigueur le 1er août 2024.

En tant que première réglementation formelle et complète au monde sur l'IA, elle divise l'IA en quatre catégories de risques en fonction des dommages potentiels que l'abus de l'IA peut causer, établissant ainsi des règles pour l'utilisation de l'IA au sein de l'UE :

1. Risque inacceptable

Les systèmes d’IA sont utilisés dans des scénarios explicitement interdits, notamment, mais sans s’y limiter :

* Comportement subconscient, manipulateur ou trompeur visant à déformer le comportement ou à compromettre la prise de décision ;

* exploiter les vulnérabilités liées à l’âge, au handicap ou au statut socioéconomique ;

* Classification biométrique pour déduire des attributs sensibles (tels que la race ou les opinions politiques) : n'inclut pas le marquage et le filtrage des données biométriques obtenues légalement par les forces de l'ordre ;

* la notation sociale, telle que l’évaluation ou la catégorisation de personnes ou de groupes en fonction de caractéristiques sociales ou personnelles, ce qui peut entraîner un traitement injuste de ces personnes ;

* Déduire des émotions sur le lieu de travail ou dans un contexte scolaire, sauf pour des raisons médicales ou de sécurité.

2. Risque élevé

Le niveau de risque le plus élevé autorisé, la plupart des législations de l'UE en matière d'IA se concentrent sur la réglementation de cette catégorie de systèmes, qui comprend, sans s'y limiter :

* utilisé comme composant de sécurité ou dans des produits couverts par les lois de l'UE énumérées à l'annexe I de la directive IA de l'UE et qui doivent faire l'objet d'une évaluation de conformité par un tiers en vertu de ces lois ;

*Scénarios d’utilisation répertoriés à l’annexe III de la directive IA de l’UE, tels que les opérations biométriques autorisées et les infrastructures critiques.

*Annexe I :

https://artificialintelligenceact.eu/annex/1

*Annexe III :

https://artificialintelligenceact.eu/annex/3

Les fournisseurs d’IA à haut risque doivent répondre à des exigences opérationnelles, telles que la mise en place de systèmes de gestion des risques, la conduite d’une gouvernance des données et la fourniture d’une documentation technique pour démontrer la conformité.

3. Risque limité

Cette catégorie occupe moins de place dans le projet de loi et ses exigences en matière de transparence sont moins strictes. En bref, les développeurs et les fournisseurs de ces systèmes doivent s’assurer que les utilisateurs finaux savent qu’ils interagissent avec l’IA.

4. Risque minimal

Ces applications ne sont pas réglementées et incluent la plupart des applications d’IA sur le marché de l’UE, telles que les jeux vidéo d’IA et les filtres anti-spam.

Bien que la loi sur l’IA de l’UE ait été saluée comme la première du genre, d’autres pays ont déjà lancé le processus législatif visant à réglementer l’IA ou ont fourni des lignes directrices cohérentes avec les lois existantes, mais qui ne sont pas destinées à être aussi contraignantes que la loi sur l’IA de l’UE.

Par exemple,Le gouvernement japonais a publié les « Business Artificial Intelligence Guidelines 1.0 » en avril 2024.Il s’agit d’une ligne directrice volontaire basée sur la législation existante pour encourager le développement et l’utilisation responsables de l’IA. en même temps,Le Sénat brésilien a proposé le projet de loi n° 2338/2024 en mai 2024.Il s'agit du premier projet de loi du pays visant à réglementer l'intelligence artificielle, y compris la conception des algorithmes et les normes techniques, et il a été adopté en décembre 2024.

Aux États-Unis, bien que les lois réglementaires au niveau fédéral n’aient pas encore été introduites, en 2024, au moins 24 États américains, Porto Rico, les îles Vierges américaines et Washington, D.C. ont proposé des projets de loi liés à l’IA. Au moins 31 États, Porto Rico et les îles Vierges américaines ont adopté et mis en œuvre ces résolutions.

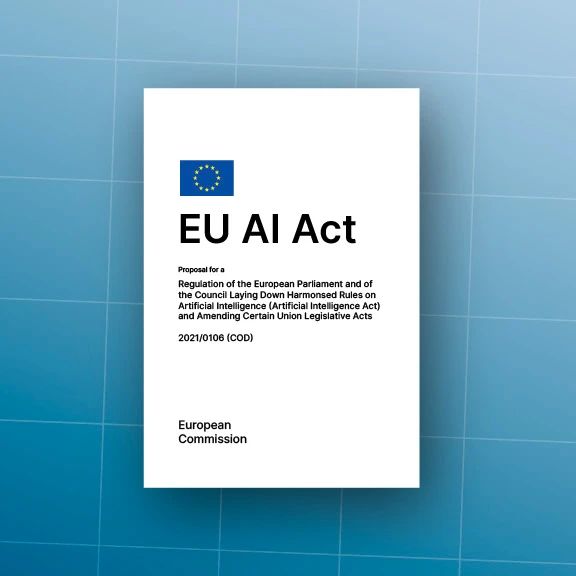

03 ,Le développement matériel d'IA le plus influent

La série Nvidia Blackwell et sa sortie retardée

Le 18 mars 2024, NVIDIA a annoncé sa nouvelle architecture GPU Blackwell au GTC 2024 et a sorti 3 GPU : B100, B200 et GB200 (combinant un CPU Grace et 2 B200).

Nvidia promet que la série Blackwell permettra d'obtenir d'énormes améliorations en termes de performances et d'efficacité énergétique, et devrait connaître des améliorations de performances significatives par rapport à la série H, notamment une augmentation de 6 fois du nombre de requêtes traitées par seconde et une augmentation de 30 fois du nombre de jetons générés par seconde par GPU.

Cependant, il y a eu des retards dans la sortie de la série Blackwell. En août 2024, Nvidia aurait déclaré aux fournisseurs de services cloud queLa très attendue puce IA B200, initialement prévue pour le quatrième trimestre 2024, sera retardée jusqu'en 2025.La raison était un défaut de conception découvert « inhabituellement tard dans le processus de production ».

Bien que la directrice financière de Nvidia, Colette Kress, ait assuré aux investisseurs lors de la conférence téléphonique sur les résultats trimestriels de novembre 2024 que les GPU étaient en pleine production, et que les rapports indiquent que Nvidia est sur la bonne voie pour sortir le B200 en décembre 2024, aucune nouvelle d'une sortie du B200 ou du B100 n'est apparue publiquement à ce jour (au 8 janvier 2025).

04 ,Les fusions et acquisitions les plus influentes

Microsoft et Inflection AI

Le 19 mars 2024, Microsoft a créé une nouvelle division d'IA grand public appelée Microsoft AI. Lorsque le département a été créé,Microsoft a embauché Mustafa Suleyman et Karén Simonyan, cofondateurs de la startup américaine d'IA Inflection AI, ainsi que la majeure partie de l'équipe d'Inflection AI.En outre, Microsoft a conclu un certain nombre d’accords commerciaux avec Inflection AI, notamment une licence non exclusive d’utilisation de la propriété intellectuelle d’Inflection AI (entre autres transactions).

Essentiellement, selon l’Autorité britannique de la concurrence et des marchés (CMA), Microsoft a acquis la plupart des actifs d’Inflection AI, et la CMA a considéré qu’une telle transaction relevait de sa compétence en matière de contrôle des fusions, même si Inflection AI continuait d’exister en tant qu’entité distincte (juste avec une nouvelle direction et de nouveaux employés). Toutefois, la CMA a ajouté que même si certains avaient qualifié l'accord de « quasi-fusion », il ne créait pas « le potentiel d'une diminution substantielle de la concurrence », tout en notant qu'elle procéderait à un examen réglementaire si des situations similaires soulevaient des problèmes de concurrence.

Les régulateurs se demandent si de tels accords pourraient créer un environnement de marché injuste. L’acquisition d’Inflection AI par Microsoft n’est qu’une d’entre elles. Début 2024,La Federal Trade Commission (FTC) a annoncé qu'elle enquêterait sur les investissements de plusieurs milliards de dollars d'Amazon dans Anthropic, de Google dans Anthropic et de Microsoft dans OpenAI (chacun d'entre eux ayant abouti à l'acquisition par une grande entreprise d'une participation importante dans une plus petite entreprise).L’objectif est de déterminer si ces sociétés ont pris le contrôle effectif d’entités sans fusion ni acquisition directe, évitant ainsi tout contrôle réglementaire et créant une situation de concurrence déloyale sur le marché.

Bien que les quasi-fusions et acquisitions ne soient pas des concepts nouveaux, elles semblent apparaître de plus en plus fréquemment à mesure que la course à l’IA continue de s’intensifier, et les régulateurs mondiaux, sans bloquer ces accords (jusqu’à présent), semblent en prendre note.

05 ,Le développement de grands modèles le plus important

Le méta-modèle open source LLaMA 3.1 bat le modèle fermé

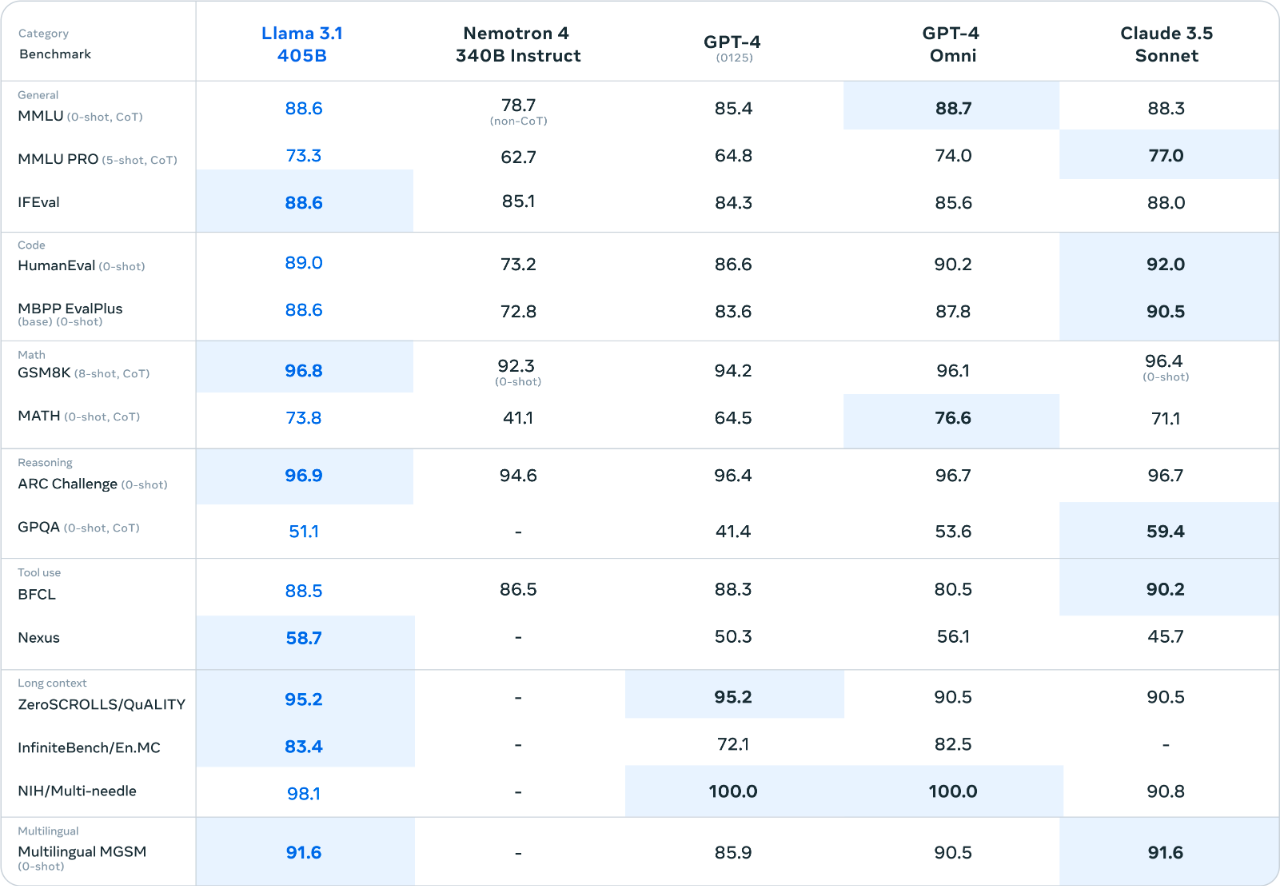

LLaMa 3.1 est comparable voire meilleur que ChatGPT et Claude. Le 13 juillet 2024, Meta a lancé une version mise à jour de LLaMA 3.1 et a publié les résultats de comparaison de référence du modèle avec les modèles grand public d'entreprises telles qu'OpenAI, Anthropic et Mistral.

Selon Meta, LLaMA 3.1 405B a surpassé les modèles GPT-4, GPT-4o et Claude 3.5 Sonnet d'OpenAI dans sept des 15 benchmarks (le modèle Claude, en comparaison, a dominé dans six). Dans les tests où il n'a pas obtenu les scores les plus élevés, les performances du LLaMA 3.1 étaient généralement comparables à celles des autres modèles haut de gamme.

Dans des tests similaires des modèles LLaMA 3.1 à 8 milliards de paramètres et à 70 milliards de paramètres (LLaMA 3.1 8B et LLaMA 3.170B, respectivement), les deux modèles ont surpassé les modèles concurrents de Google, Mistral et OpenAI dans 11 des 12 tests. Il convient de noter que même si Meta a effectué les mêmes 15 tests sur les deux modèles plus petits que sur la version 405B, trois de ces tests n'incluaient pas les données des autres modèles de comparaison.

* Utilisez Open WebUI pour déployer le modèle Llama 3.1 405B en un clic :

https://hyper.ai/cn/tutorials/33221

06 ,Les licenciements les plus notables liés à l'IA

Klarna

Le 27 août 2024, la société de paiement suédoise Klarna a annoncé avoir supprimé des centaines d'emplois et a déclaré qu'à mesure que l'IA prend le contrôle des activités de consultation des clients, elle s'attend à ce que l'ampleur des licenciements s'étende encore à l'avenir. La raison pour laquelle cet incident est considéré comme le cas le plus typique d'IA remplaçant le travail humain est principalement parce que l'entreprise a clairement déclaré queSon chatbot basé sur l'IA peut compléter la charge de travail de 700 employés et réduire le temps moyen de résolution des problèmes de 11 minutes à 2 minutes. Dans ce cas, l’IA a complètement remplacé le travail humain.En outre, Klarna a également annoncé qu'elle suspendrait le recrutement pour tous les postes, à l'exception des ingénieurs, pendant un certain temps.

Cependant, Klarna n’est pas seul.

Juillet 2024La société américaine de logiciels fiscaux Intuit a annoncé qu'elle licencierait 1 800 employés pour se concentrer sur le développement d'outils d'IA tels que « Intuit Assist ».Il a également précisé que ces licenciements n’étaient pas dus à des considérations d’économie. Dans le même temps, Intuit a déclaré qu'elle embaucherait au moins un nombre égal d'employés dans les domaines de l'ingénierie, des produits et des clients tels que les ventes et le marketing pour soutenir ses initiatives d'IA 2025. Bien que les licenciements d’Intuit aient été plus importants, l’entreprise ne faisait que se réorienter stratégiquement vers l’IA, et Klarna a déjà mis en œuvre le remplacement de l’IA.

Les professionnels de la technologie qui ne possèdent pas de compétences en IA sont également confrontés à la pression de la transformation de l’industrie. Les deux cas ci-dessus montrent que l’IA peut prendre en charge des postes non techniques tels que le service client. Dans le même temps, les grandes entreprises technologiques ont également procédé à des réductions significatives de postes techniques dans le cadre de leur recentrage sur l’activité d’IA. Le taux de chômage dans le secteur technologique a continué de fluctuer en 2024. Après avoir atteint un sommet de quatre ans à 3,7% en juin, il est retombé en septembre et est resté autour de 2,5%.

Les principales suppressions d’emplois dans le secteur technologique en 2024 comprennent :

* Janvier

Le géant mondial de la technologie Google a licencié plus de 1 000 employés dans plusieurs équipes, notamment celles du matériel et de Google Assistant, pour se concentrer davantage sur ses produits d'IA tels que Gemini GenAI (anciennement Bard). Le PDG de Google, Sundar Pichai, a noté que davantage de licenciements sont attendus tout au long de 2024, alors que Google continue de réaffecter des ressources à l'IA (en décembre 2024, Pichai a annoncé la suppression de 101 postes de direction TP3T).

* 6 mois

Microsoft, le géant mondial des logiciels et des services cloud, a annoncé qu'il allait licencier plus de 1 000 employés dans ses divisions de réalité mixte et Azure. Jason Zander, vice-président exécutif de la mission stratégique et de la technologie de Microsoft, a déclaré dans un courriel de l'entreprise que cette décision visait à consacrer davantage d'énergie à la définition de la « vague de l'IA et à aider ses clients à réussir à appliquer l'IA ».

* Août

Cisco, une multinationale spécialisée dans le matériel et les logiciels de réseau, a licencié environ 71 employés de TP3T et a réorienté ses investissements vers l'IA, notamment la construction de réseaux d'IA pour les applications cloud et l'infrastructure d'IA. Il s’agit d’une nouvelle vague de licenciements après ceux de près de 4 000 personnes en février 2024.

Davantage de licenciements liés à l'IA sont attendus en 2025. Selon une étude d'IoT Analytics réalisée début 2024, l'IA et la GenAI sont devenues les compétences les plus recherchées par les employeurs. En outre, une enquête menée en 2024 auprès de plus de 900 dirigeants d'entreprises américaines par Staffing Industry Analysts a révélé que30% des entreprises ont remplacé certains employés par l'IA, et parmi les entreprises prévoyant d'utiliser l'IA en 2025, 38% ont déclaré qu'elles prévoyaient de remplacer leurs employés par cette technologie au cours de l'année prochaine.

Cependant, l’IA pourrait bien n’être qu’un bouc émissaire pour certaines entreprises. Il convient de noter que de nombreuses entreprises peuvent utiliser l’IA comme excuse pour procéder à des licenciements. Les attribuer à l’IA semble moins négatif que de simplement admettre que les licenciements ont été effectués pour réduire les coûts ou augmenter les bénéfices. De plus, attribuer les licenciements à l’IA peut motiver les investisseurs car cela signifie une efficacité et une productivité accrues.

En février 2024, Mark Zuckerberg, PDG du géant technologique américain Meta, a partagé son point de vue selon lequel les licenciements sont le reflet de la réalité de l'ère post-épidémique. Pendant l'épidémie, l'entreprise s'est « sur-développée » en réponse à l'incertitude et tente désormais de rationaliser l'entreprise pour améliorer l'efficacité opérationnelle.

07 , Les plus grands défis auxquels sont confrontées les entreprises d'IA

Impossible d'améliorer les performances du LLM

Les grands projets de R&D du LLM n’ont pas répondu aux attentes. En septembre 2024, OpenAI a terminé la première série de formations pour un nouveau grand modèle linguistique, appelé Orion au sein de l'entreprise. OpenAI espère que ce sera un bond en avant comme l'a fait le GPT-4o sorti en mai 2024 par rapport au GPT-4 Turbo. Cependant, selon les rapports,Le modèle ne répond pas actuellement aux attentes et l’écart de performance avec les modèles existants n’est pas aussi important que celui entre GPT-4o et GPT-4 Turbo, ou entre GPT-4 et GPT-3.5.

OpenAI n’est cependant pas la seule entreprise à subir des revers. Google et Anthropic semblent également ne pas avoir réussi à répondre aux attentes du marché concernant les mises à jour de leurs modèles Gemini et Claude, ce qui a retardé la sortie de leurs nouvelles versions.

De nouvelles contraintes de données entraînent un changement de paradigme dans le développement du LLM. Ces dernières années, les attentes des grandes entreprises de modèles linguistiques quant à des avancées majeures dans leurs modèles sont principalement basées sur des « lois d'échelle »Autrement dit, une puissance de calcul accrue, des ensembles de données plus volumineux et des modèles plus grands entraîneront un bond en avant dans les capacités de l’IA.

Cependant,Un nouveau problème se pose en 2024 :Il existe peu de nouvelles informations (humaines) disponibles pour former les LLM.Les premiers LLM s’appuyaient principalement sur des sources telles qu’Internet pour l’apprentissage, s’appuyant sur des décennies de connaissances humaines. Cependant, relativement peu de nouvelles informations fiables générées par l’homme ont été ajoutées au cours des deux dernières années.

Un autre problème est devenu plus évident depuis la sortie publique de LLM : le cannibalisme de l’IA.L'IA générative (GenAI) a été largement utilisée dans la création de contenu en ligne, permettant au LLM d'ingérer progressivement du contenu généré par l'IA. Cet apport circulaire non seulement réduit et dilue davantage le contenu humain original, mais peut également affecter la précision des informations apprises par le modèle.

Certains remettent en question les limites de l’IA, tandis que d’autres repensent le sens du progrès. Face à des problèmes tels que des avancées limitées en matière de LLM et l’insuffisance de nouvelles données, les institutions de recherche en IA semblent accepter le fait que les « lois d’échelle » ne sont pas véritablement universelles. Certains acteurs du domaine de l’IA estiment que divers modèles approchent progressivement les limites de leurs capacités. Cependant, il existe également des optimistes qui pensent que les « lois d'échelle » doivent être considérées comme dynamiques et doivent s'adapter aux nouveaux paradigmes de développement, de sorte que de nouvelles stratégies doivent être adoptées dans le processus de formation et de développement de l'IA, telles que la « mise à l'échelle du temps de test ».

La nouvelle fonctionnalité compense les progrès limités du LLM. Même si le développement du LLM stagne, les entreprises d’IA s’efforcent toujours d’ajouter de la valeur aux modèles existants. Par exemple, OpenAI a lancé un aperçu des modèles o1 et o1-mini en septembre 2024 et les a officiellement publiés en décembre de la même année, tout en annonçant le prochain modèle o3. Bien que le modèle o1 prenne plus de temps pour traiter les requêtes, il utilise une approche de « chaîne de pensée » pour créer et corriger les réponses avant de répondre (de la même manière que les humains décomposent les idées lorsqu'ils résolvent des problèmes complexes), améliorant ainsi la capacité de raisonnement et la précision des réponses.

De plus, en octobre 2024, OpenAI a publié ChatGPT Search, qui permet à ChatGPT d'effectuer des recherches sur le Web. Les utilisateurs peuvent trouver des informations via l'interface ChatGPT et obtenir des résultats avec des citations de sources. Enfin, en décembre 2024, OpenAI et Google ont lancé respectivement Sora (basé sur DALL-E 3) et Veo2, élargissant encore les capacités de génération vidéo.

08 ,Les plus importantes réalisations de la recherche en IA

Deux prix Nobel

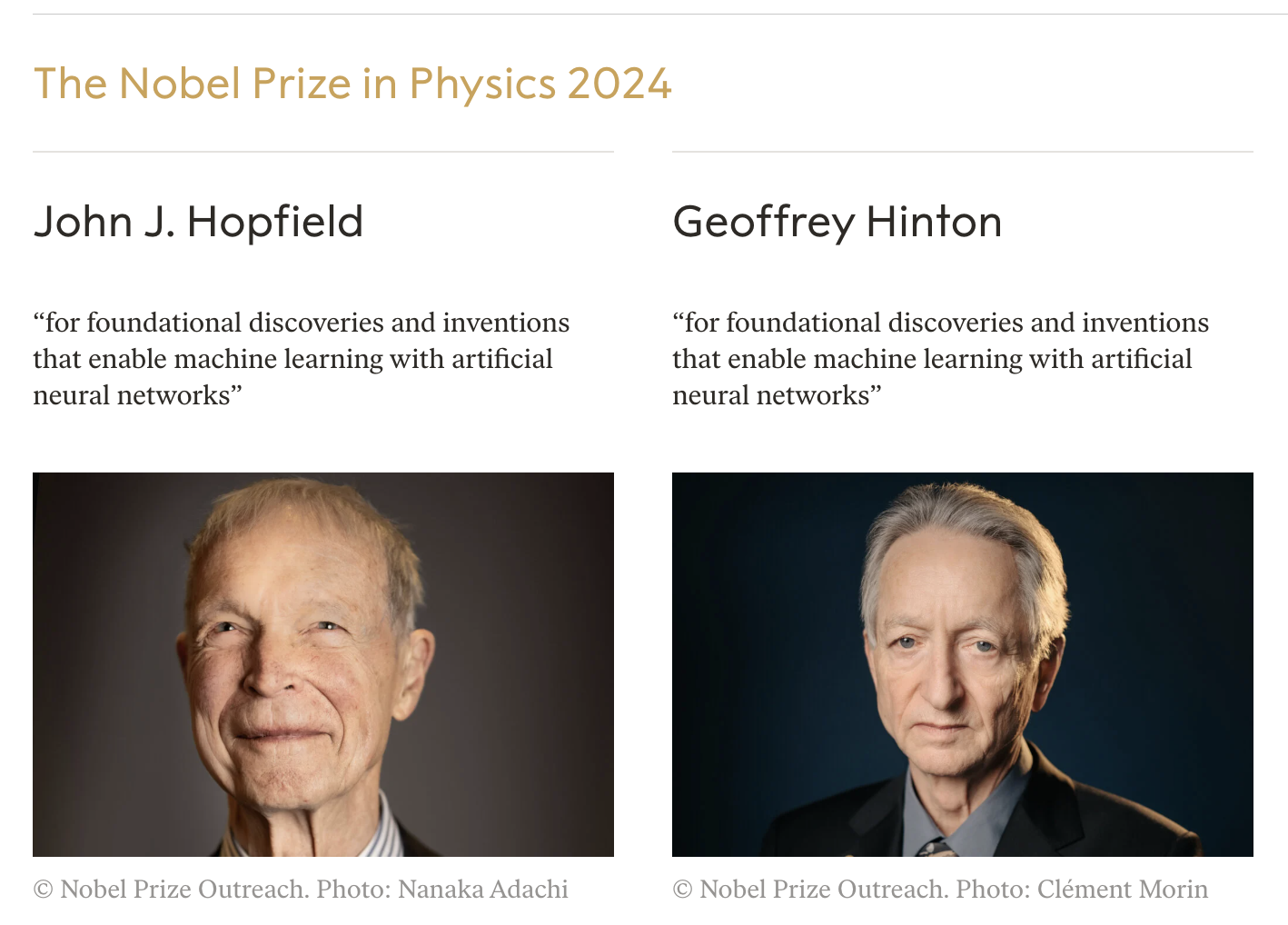

Les 8 et 9 octobre 2024, les prix Nobel de physique et de chimie ont été décernés pour la première fois à des recherches liées à l’IA. Le prix Nobel de physique 2024 a été décerné à John J. Hopfield, physicien et professeur émérite à l'Université de Princeton, et à Geoffrey Hinton, professeur émérite à l'Université de Toronto et ancien chercheur chez Google, pour leur développement de techniques d'apprentissage automatique utilisant des réseaux de neurones artificiels.

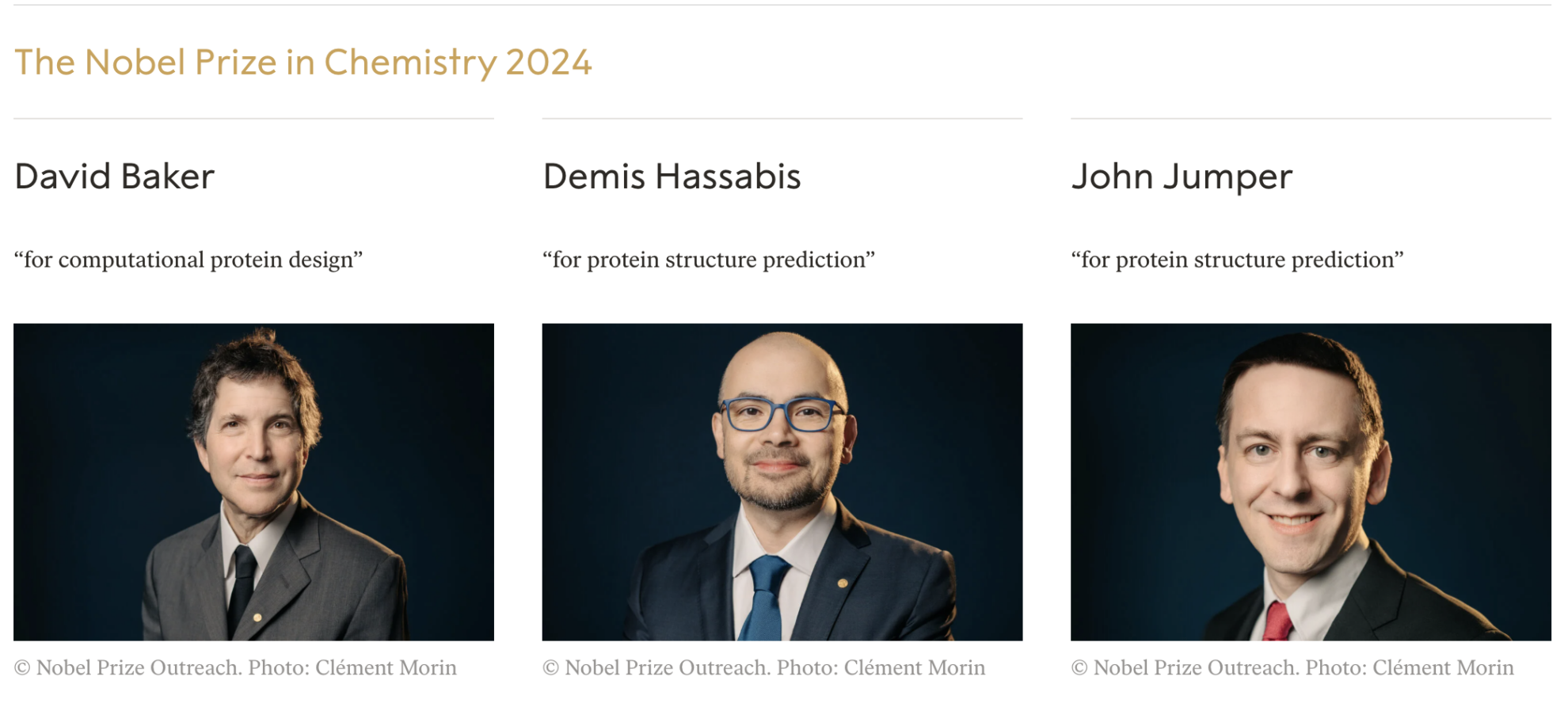

Dans le même temps, Sir Demis Hassabis, PDG et cofondateur de Google DeepMind, et John M. Jumper, directeur de recherche chez Google DeepMind et co-développeur d'AlphaFold, ont remporté le prix Nobel de chimie 2024 en reconnaissance de leur développement d'un algorithme d'IA capable de prédire avec précision la structure des protéines, résolvant avec succès le problème de prédiction de la structure des protéines qui tourmente la communauté scientifique depuis 50 ans.

09 ,Le plus grand investissement en IA au niveau de l'entreprise

Amazone

Amazon investit massivement dans les centres de données et l’IA. Lors d'une conférence téléphonique sur les résultats le 31 octobre 2024, le PDG Andy Jassy a déclaré :Les dépenses d'investissement (CAPEX) de l'entreprise atteindront 75 milliards de dollars en 2024, AWS et l'IA représentant la part la plus importante.À ce jour, les dépenses d'Amazon en matière d'expansion des centres de données (y compris les biens et équipements) ont atteint 22,6 milliards de dollars américains, soit une augmentation de 811 TP3T de dollars américains en glissement annuel.

Amazon n’est pas le seul à investir dans les centres de données. On estime que d’ici 2024, le total des dépenses d’investissement de géants tels qu’Amazon, Microsoft, Alphabet et Meta dépassera les 200 milliards de dollars américains. Ces grandes entreprises technologiques ont également annoncé qu’elles prévoyaient de continuer à augmenter leurs CAPEX,Morgan Stanley, une importante banque d'investissement américaine, prédit que les dépenses d'investissement des entreprises à grande échelle dépasseront les 300 milliards de dollars américains en 2025.Bien que la plupart de ces dépenses soient destinées aux GPU haut de gamme et aux centres de données massifs construits pour les héberger, il existe également des coûts de support, tels que les coûts énergétiques nécessaires au fonctionnement des serveurs.

Ces entreprises technologiques liées à l’IA travaillent dur pour convaincre les investisseurs que les dépenses correspondantes sont des investissements initiaux dans des technologies disruptives, similaires au modèle « si vous le construisez, les utilisateurs viendront » - c’est-à-dire que l’infrastructure doit d’abord être en place pour soutenir le fonctionnement de futurs produits rentables (par exemple, les trains doivent être posés sur les rails avant de pouvoir circuler). Des doutes subsistent toutefois quant à savoir si les recettes seront à la hauteur des coûts.

Par exemple, même si la construction d’un centre de données (y compris les installations, les serveurs, etc.) et les dépenses énergétiques continues peuvent être prises en compte dans les calculs de retour sur investissement (ROI), les centres de données ne restent pas toujours les mêmes. Les fabricants de GPU continueront de développer des puces plus puissantes, et les entreprises devront peut-être continuellement mettre à niveau leurs équipements pour rester compétitives et faire face à des besoins informatiques d'IA plus avancés. En outre, l’augmentation de la puissance de calcul entraînera également une consommation d’énergie plus élevée, augmentant encore les coûts d’exploitation.

10 ,Le plus grand financement lié à l'IA

Databricks, OpenAI et xAI

17 décembre 2024Databricks, une plateforme de données cloud d'IA dont le siège social est aux États-Unis, a annoncé la finalisation d'un financement de série J de 10 milliards de dollars.Il s'agira du plus gros investissement en capital-risque en 2024. Après ce tour de financement, la valorisation de Databricks a atteint 62 milliards de dollars américains.

OpenAI et xAI ont également reçu d’énormes investissements. En octobre 2024, OpenAI a annoncé la finalisation de son financement de série B, levant 6,6 milliards de dollars américains et sa valorisation post-financement a atteint 157 milliards de dollars américains. Il s'agissait du plus gros tour de capital-risque en 2024 jusqu'à ce que Databricks remporte ce titre.

Auparavant, xAI d'Elon Musk avait finalisé son financement de série B en mai 2024, levant 6 milliards de dollars, ce qui est brièvement devenu le plus gros tour de financement de l'année. Par la suite, en novembre 2024, xAI a annoncé la finalisation de son financement de série C, levant 6 milliards de dollars américains et portant la valorisation de la société à 50 milliards de dollars américains.

Références :

https://iot-analytics.com/ai-2024-10-most-notable-stories