Command Palette

Search for a command to run...

Tutoriel En Ligne | YOLOv11 En Action ! Un Outil Puissant De Détection d'objets Alliant Rapidité Et Précision

Le modèle YOLO a toujours été un choix classique pour la détection d’objets. YOLOv11 est une nouvelle génération de modèle de détection de cible.Il maintient non seulement la haute efficacité et les performances en temps réel de sa série, mais améliore également considérablement la précision de détection et la capacité d'adaptation à des scénarios complexes, apportant une précision plus forte, une vitesse plus rapide et des performances de raisonnement plus intelligentes.

YOLOv11 peut effectuer plusieurs tâches visuelles en même temps : de la détection d'objets de base et de la classification d'objets à la segmentation d'instances à granularité fine, et même analyser les mouvements de personnes ou d'objets grâce à l'estimation de la posture. Dans le même temps, YOLOv11 est également performant dans la détection d’objets de positionnement. Il peut localiser et identifier avec précision les cibles dans les images pour répondre aux besoins de scénarios plus complexes. Par exemple, dans la conduite autonome, il peut non seulement identifier avec précision les véhicules et les piétons devant, mais également localiser avec précision les lignes de voie et les panneaux de signalisation pour garantir la sécurité de conduite.

La section Tutoriel HyperAI HyperNeural est désormais en ligne avec « Déploiement en un clic de YOLOv11 ». Le tutoriel a mis en place l'environnement pour tout le monde. Vous n'avez pas besoin de saisir de commandes. Cliquez simplement sur Cloner pour explorer rapidement les puissantes fonctions de YOLOv11 !

Adresse du tutoriel :

https://go.hyper.ai/ycTq1

Essai de démonstration

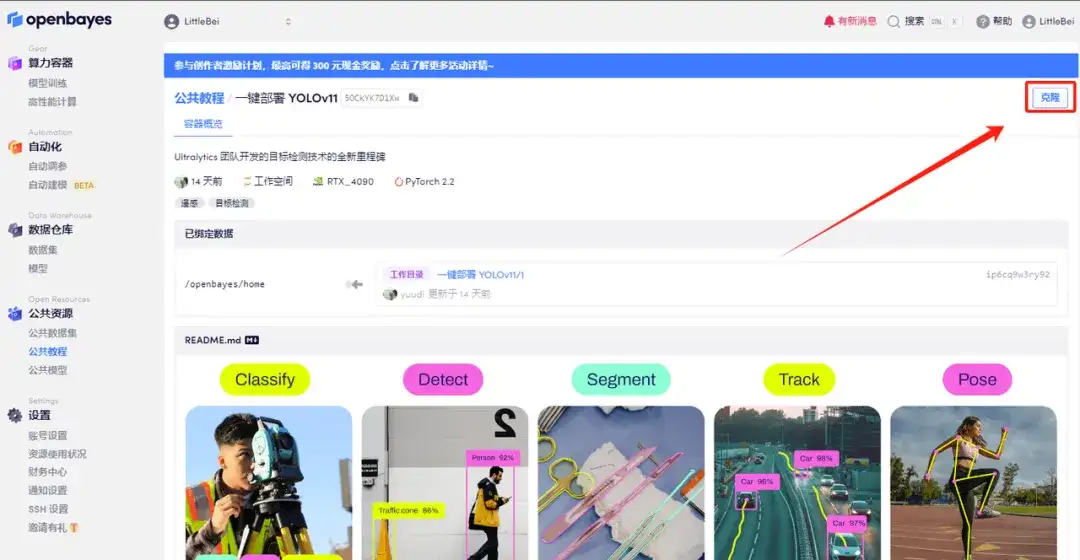

1. Connectez-vous à hyper.ai, sur la page Tutoriel, sélectionnez Déploiement en un clic de YOLOv11, puis cliquez sur Exécuter ce tutoriel en ligne.

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

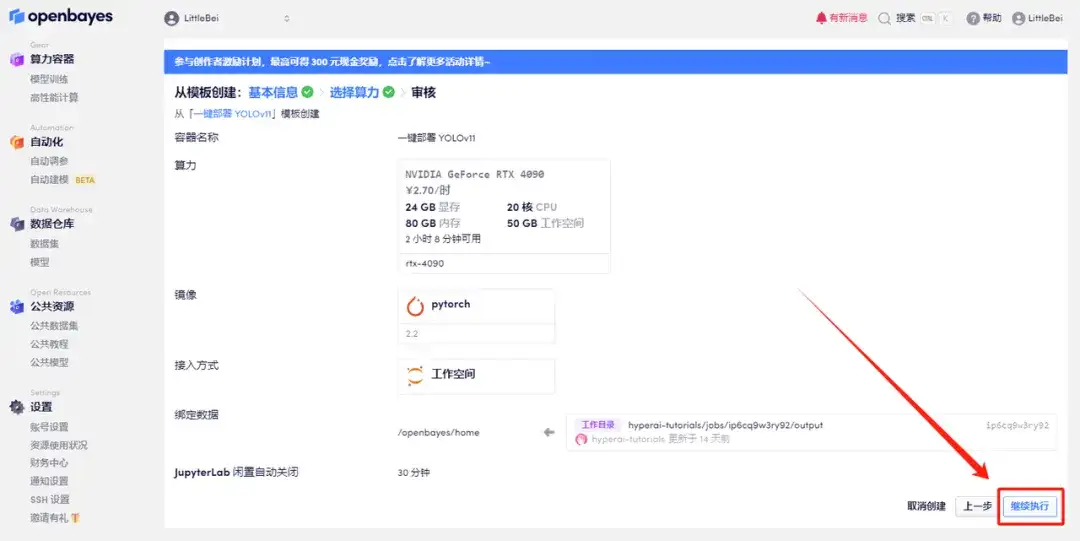

3. Cliquez sur « Suivant : sélectionner le taux de hachage » dans le coin inférieur droit.

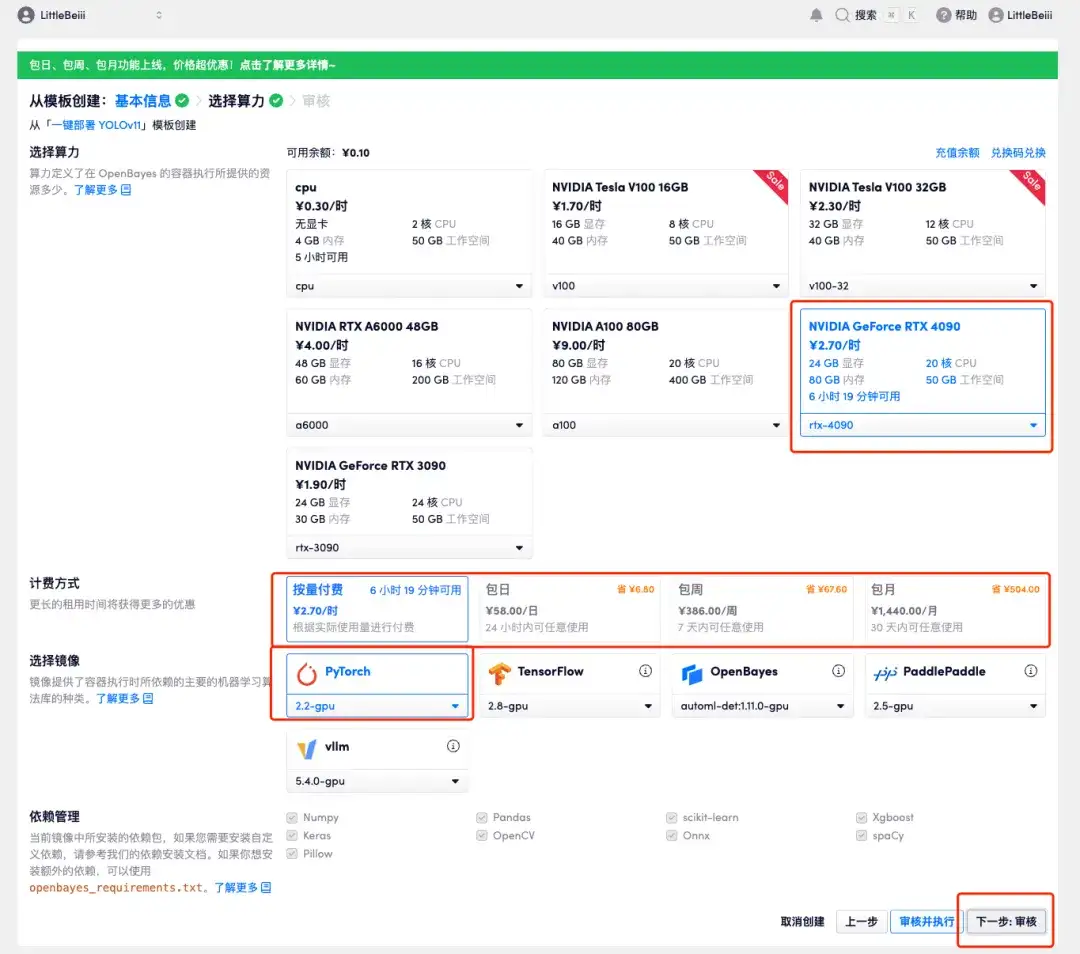

4. Une fois la page affichée, sélectionnez l'image « NVIDIA RTX 4090 » et « PyTorch ». Les utilisateurs peuvent choisir « payer à l'utilisation » ou « payer à l'utilisation » en fonction de leurs besoins. « Quotidien/Hebdomadaire/Mensuel », après avoir terminé votre sélection, cliquez sur « Suivant : Réviser ».Les nouveaux utilisateurs peuvent s'inscrire en utilisant le lien d'invitation ci-dessous pour obtenir 4 heures de RTX 4090 + 5 heures de temps CPU gratuit !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :

https://openbayes.com/console/signup?r=Ada0322_QZy7

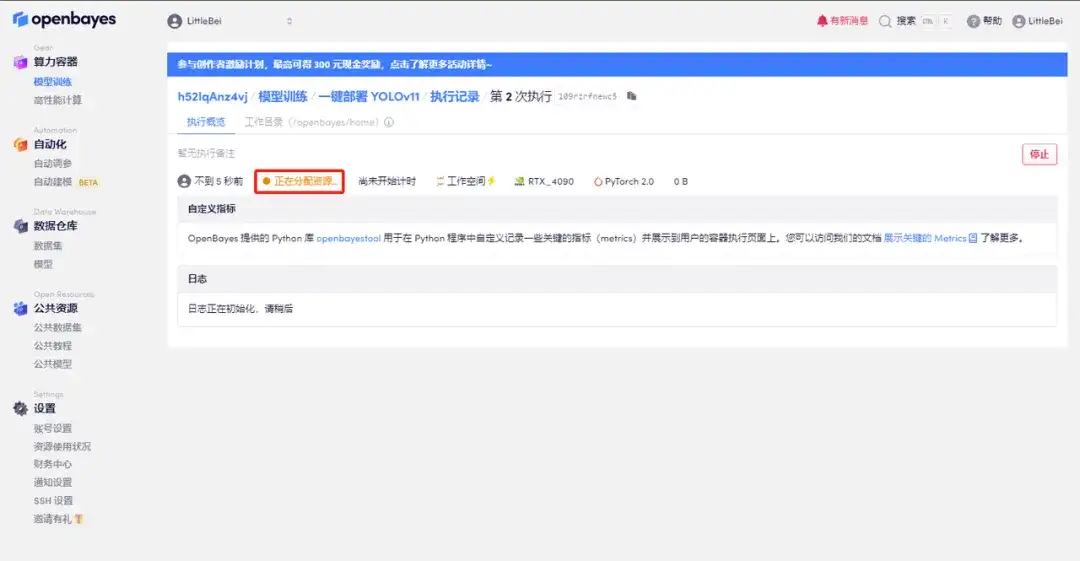

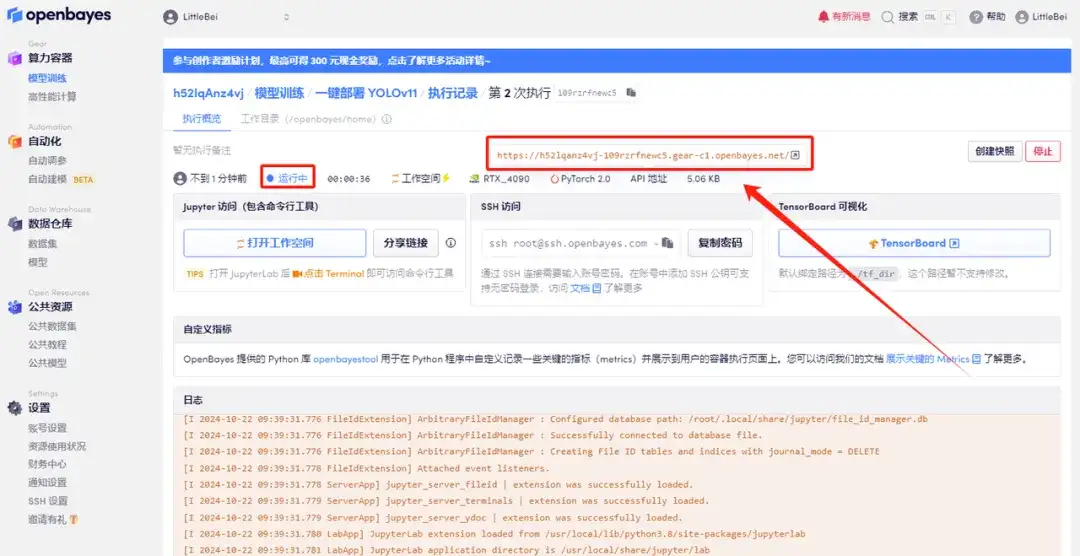

5. Après confirmation, cliquez sur « Continuer » et attendez que les ressources soient allouées. Le premier processus de clonage prendra environ 2 minutes. Lorsque le statut passe à « En cours d'exécution », cliquez sur la flèche de saut à côté de « Adresse API » pour accéder à la page de démonstration.Veuillez noter que les utilisateurs doivent effectuer l'authentification par nom réel avant d'utiliser la fonction d'accès à l'adresse API.

Démonstration d'effet

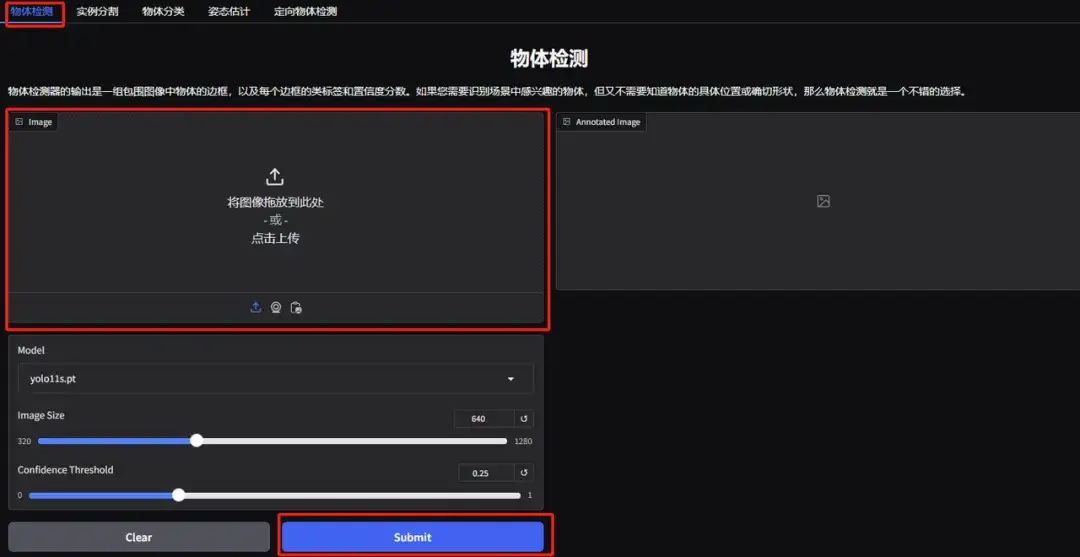

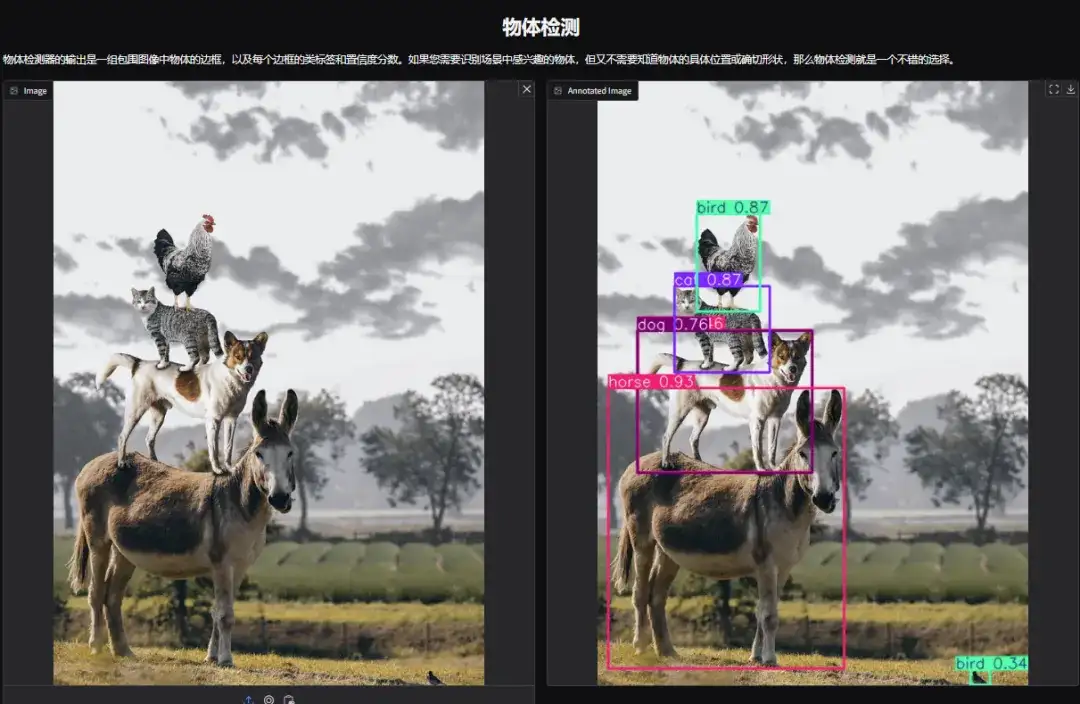

1. Ouvrez la page de démonstration de détection d’objets YOLOv11. J'ai téléchargé une photo d'animaux empilés, ajusté les paramètres et cliqué sur « Soumettre ». Vous pouvez voir que YOLOv11 a détecté avec précision tous les animaux sur la photo. Il s’avère qu’il y a un petit oiseau caché dans le coin inférieur droit ! Avez-vous remarqué ?

Les paramètres suivants représentent :

* Modèle:Fait référence à la version du modèle YOLO sélectionnée pour utilisation.

* Taille de l'image :La taille de l'image d'entrée. Le modèle redimensionnera l'image à cette taille lors de la détection.

* Seuil de confiance :Le seuil de confiance signifie que lorsque le modèle effectue une détection de cible, seuls les résultats de détection dont la confiance dépasse cette valeur définie seront considérés comme des cibles valides.

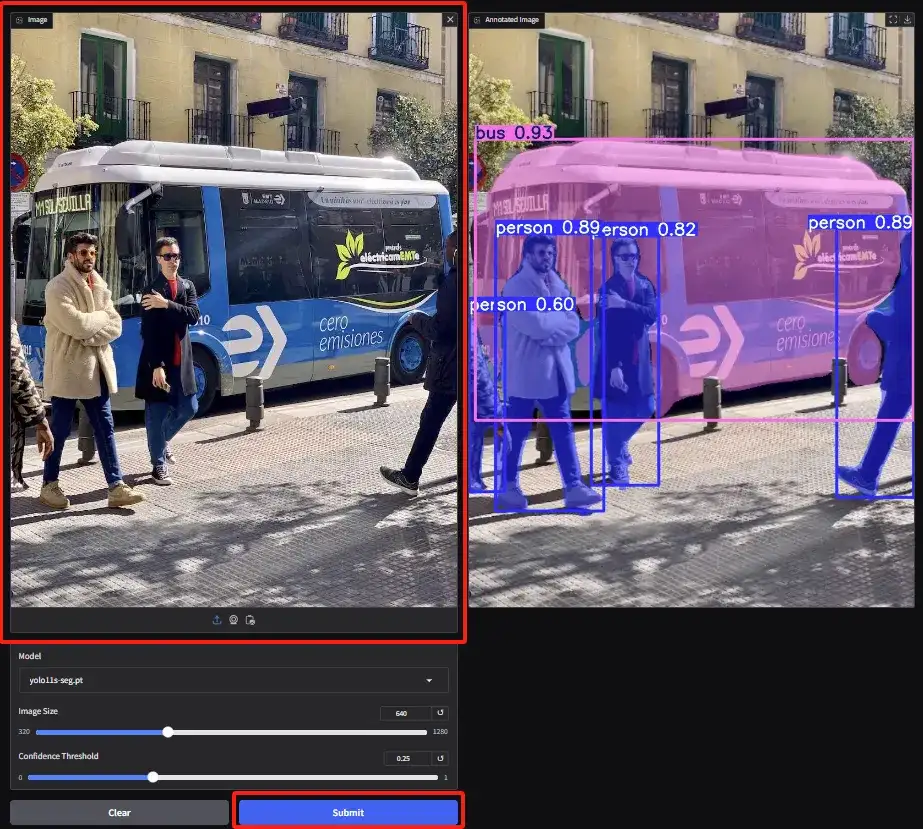

2. Accédez à la page de démonstration de segmentation d'instance, téléchargez l'image et ajustez les paramètres, puis cliquez sur « Soumettre » pour terminer l'opération de segmentation. Même avec des occlusions, YOLOv11 fait un excellent travail en segmentant avec précision les personnes et en décrivant le bus.

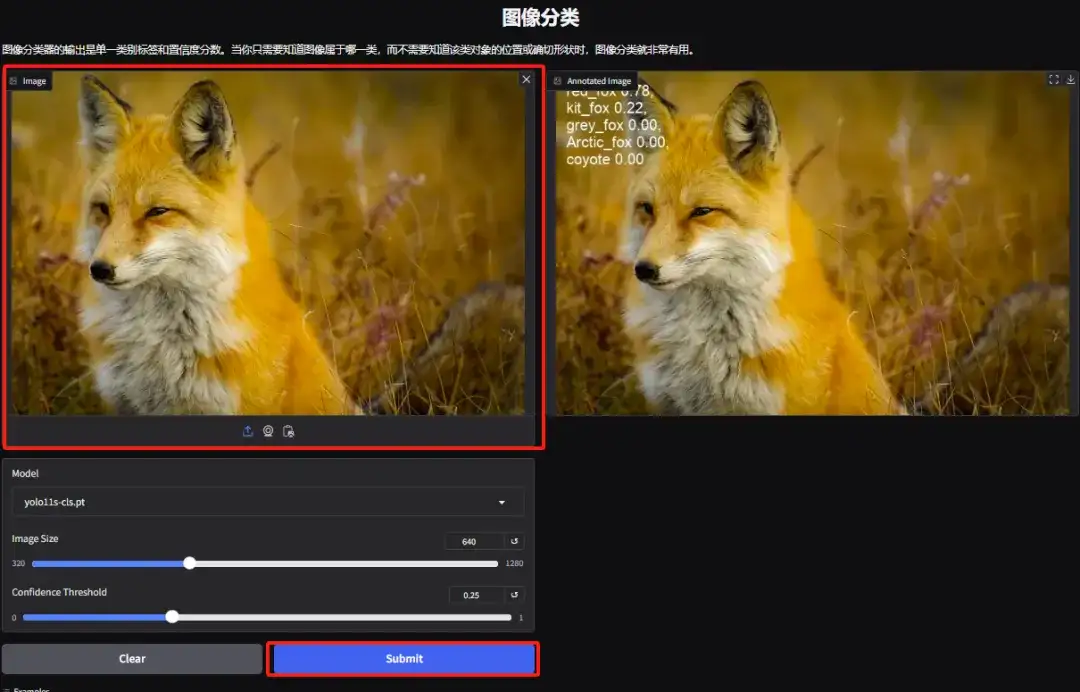

3. Accédez à la page de démonstration de classification d'objets. L'éditeur a téléchargé une photo d'un renard. YOLOv11 peut détecter avec précision l'espèce spécifique du renard sur la photo comme étant un renard roux.

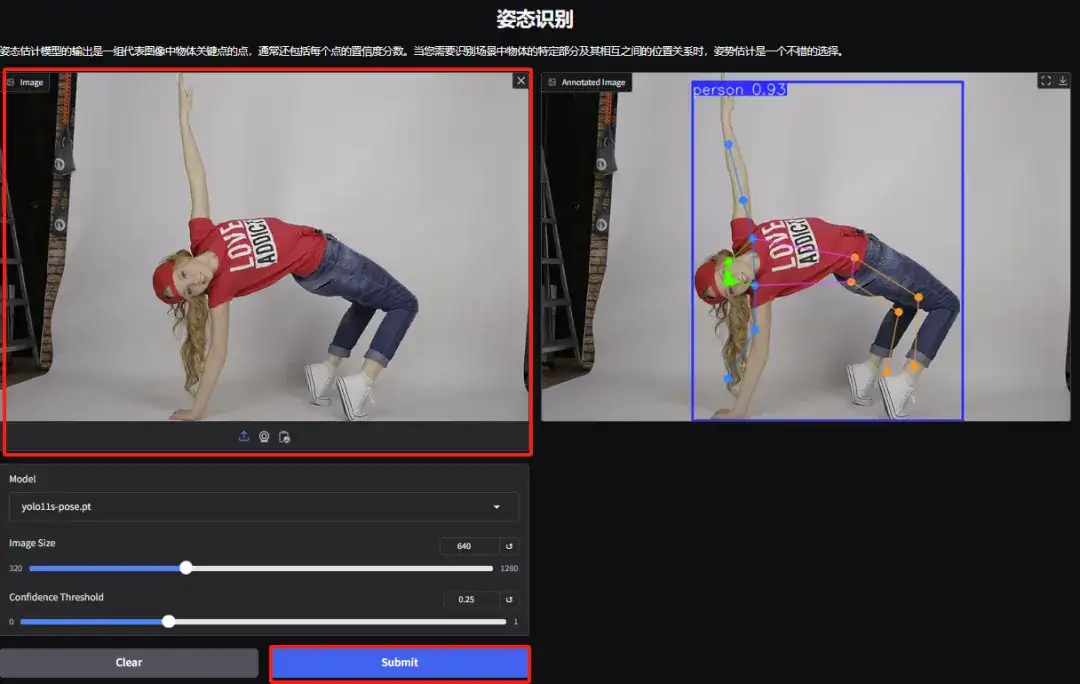

4. Accédez à la page de démonstration de reconnaissance des gestes, téléchargez l'image, ajustez les paramètres en fonction de l'image et cliquez sur « Soumettre » pour terminer l'analyse du mouvement des gestes. Vous pouvez voir qu'il analyse avec précision les mouvements corporels exagérés du personnage.

5. Sur la page de démonstration de détection d’objets dirigés, téléchargez une image et ajustez les paramètres, puis cliquez sur « Soumettre » pour identifier l’emplacement spécifique et la classification de l’objet.