Command Palette

Search for a command to run...

Llama 3.2 Est Là, Multimodal Et Open Source ! Huang Renxun Est Le Premier À Expérimenter Les Lunettes AR, Et Le Prix Du Casque Quest 3S Est Ridiculement Bas

Si ChatGPT d'OpenAI a lancé la « guerre des 100 modèles »,Les lunettes intelligentes Ray-Ban Meta de Meta sont sans aucun doute le déclencheur de la « guerre des cent miroirs ».Depuis ses débuts à la conférence des développeurs Meta Connect 2023 en septembre dernier, Ray-Ban Meta s'est vendue à plus d'un million d'exemplaires en quelques mois seulement, non seulementMark ZuckerbergOn l'a appelé « Amazing », ce qui a incité de grandes entreprises nationales et étrangères telles que Google, Samsung et ByteDance à rejoindre le marché !

Un an plus tard, Meta a de nouveau lancé un nouveau produit de lunettes intelligentes, Orion, lors de la Connect Developer Conference.Il s’agit des premières lunettes AR holographiques de la société.Zuckerberg les a qualifiées de lunettes les plus avancées au monde, qui changeront la façon dont les gens interagissent avec le monde à l'avenir.

De plus, comme d'habitude, Meta lance généralement de nouveaux produits de casques Quest lors de la conférence Connect, et cette année ne fait pas exception. Compte tenu de la sortie de Meta l'année dernière Quête 3 Les utilisateurs se plaignent généralement que le prix est trop élevé.Cette année, Meta a lancé un nouveau casque, le Quest 3S, qui offre des performances similaires à celles du Quest 3 mais est plus abordable.Ce casque est considéré comme le meilleur appareil de réalité mixte du marché actuel, offrant une excellente expérience d'hyper-réalité.

Bien entendu, en tant que l'une des technologies de base les plus attendues de Meta, le modèle Llama a également subi une mise à jour majeure lors de cette conférence de presse.Multimodalité Llama 3.2 peut comprendre à la fois les images et le texte, et les téléphones mobiles peuvent également exécuter de grands modèles, ajoutant ainsi des avantages supplémentaires à son écosystème open source.

Le rêve de réalité augmentée de Meta devient réalité, les lunettes Orion ouvrent une nouvelle ère d'interaction

En avril de cette année, pour célébrer le 10e anniversaire de Reality Labs, Meta a publié un article décrivant l'historique du développement du département et a présenté en avant-première son prochain produit phare : les premières lunettes AR. Meta a déclaré que Quest 3 permet aux utilisateurs d'interagir de manière immersive avec le contenu numérique dans le monde physique, les lunettes Ray-Ban Meta permettent aux utilisateurs de profiter de la praticité et du divertissement de Meta AI, et les nouvelles lunettes AR combineront les avantages des deux pour obtenir la meilleure fusion technologique.

À l'approche de Meta Connect 2024, de plus en plus de voix sur le marché spéculent que ces lunettes AR seront lancées lors de cette conférence. Comme prévu,Aujourd'hui, Meta a sorti ses premières lunettes AR, Orion.

Zuckerberg a déclaré qu'Orion s'engage à changer la façon dont les gens interagissent avec le monde. Il s'agit des lunettes AR les plus avancées jamais conçues et leur développement a pris 10 ans. Il dispose de l'écran AR le plus avancé, de puces de silicium personnalisées, de lentilles en carbure de silicium, de guides d'ondes complexes, de projecteurs uLED, etc.Une combinaison de technologies permet de réaliser de puissantes expériences de réalité augmentée sur une paire de lunettes, tout en ne consommant qu'une fraction de la puissance et du poids d'un casque MR.

En termes simples,Ces lunettes AR utilisent une nouvelle architecture d'affichage.utiliserPicoprojecteurLa lumière est projetée dans le guide d'ondes, puis à différentes profondeurs et tailles deHologrammeLe monde est projeté devant l’utilisateur et est alimenté par une batterie logée dans la branche des lunettes. Par exemple, si les utilisateurs souhaitent rencontrer des amis qui sont loin, ils apparaîtront dans le salon sous forme d’hologrammes, comme s’ils étaient réellement là.

Il convient de mentionner qu'Orion en possède 7 intégrés dans le bord du cadre.Mini caméraet des capteurs, combinés au suivi de la voix, des yeux et des gestes, équipés d'un bracelet EMG, les utilisateurs peuvent facilement glisser, cliquer et faire défiler. Par exemple, si vous souhaitez prendre une photo pendant votre course matinale, Orion peut figer l’instant d’un simple toucher du doigt. De plus, vous pouvez invoquer des divertissements tels que des jeux de cartes, des échecs ou du ping-pong holographique d'un simple toucher du doigt.

Fondateur et PDG de Nvidia Jen-Hsun HuangJ'ai hâte de l'essayer !

Meilleur appareil de réalité mixte : Quest 3S, excellent rapport qualité-prix

Suite à l'annonce par Meta du premier casque de réalité mixte au monde, Meta Quest 3, lors de la conférence Connect l'année dernière,Meta a lancé une version simplifiée de Quest 3 cette année : Quest 3S.

Zuckerberg a déclaré :« Le Quest 3S offre non seulement un excellent rapport qualité-prix, mais c'est aussi le meilleur appareil de réalité mixte que vous puissiez acheter sur le marché ! »Il possède des fonctions de base similaires à celles du Quest 3, à savoir une réalité mixte haute résolution et en couleur, permettant aux utilisateurs de « voyager de manière transparente » entre les mondes physique et virtuel et de s'engager dans une gamme d'activités telles que le divertissement, le fitness, les jeux et les expériences sociales. La différence est que le Quest 3S a amélioré les objectifs et optimisé la pile technologique, la résolution et la latence effectives, et son logiciel de suivi des mains en réalité mixte fonctionne mieux.

La magie de la réalité mixte est qu’elle apporte un espace réalisteMétavers, offrant aux utilisateurs une sensation immersive et leur permettant de basculer librement entre différentes expériences. Par exemple, les utilisateurs peuvent choisir le mode cinéma pour agrandir l'écran dans une salle de cinéma et obtenir la meilleure expérience de visionnage au cinéma.

Lors d'une démonstration en direct, Zuckerberg a montré une expérience immersive depuis une application mobile 2D vers un PC de bureau distant, où les utilisateurs peuvent ouvrir l'écran et le placer n'importe où pour former un immenseAffichage virtuel, et faire le travail. Il a mentionné que Meta travaillait avec Microsoft pour mettre à niveau la fonctionnalité Bureau à distance et qu'il pourrait bientôt être en mesure de se connecter aux ordinateurs Windows 11.

Il convient de mentionner que Meta Quest 3S offre une expérience hyper réaliste à un prix incroyable, à partir de seulement 299,99 $ et sera disponible le 15 octobre. Achetez cet automne Quête 3S Les utilisateurs recevront également une expérience VR gratuite pour le jeu Batman : Arkham Shadow.

Le premier modèle Llama à prendre en charge les tâches visuelles, multimodal et open source

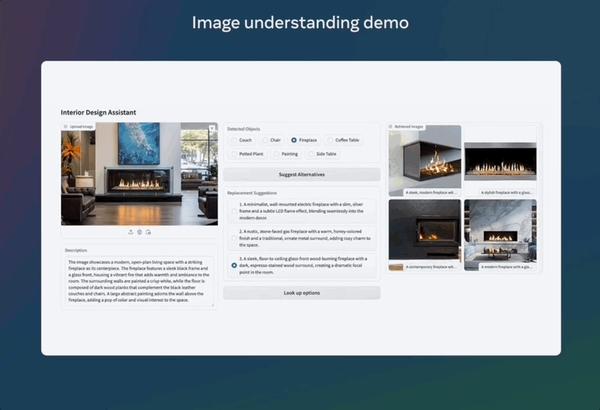

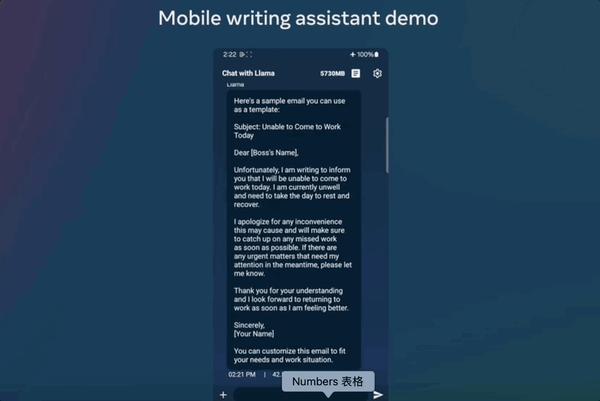

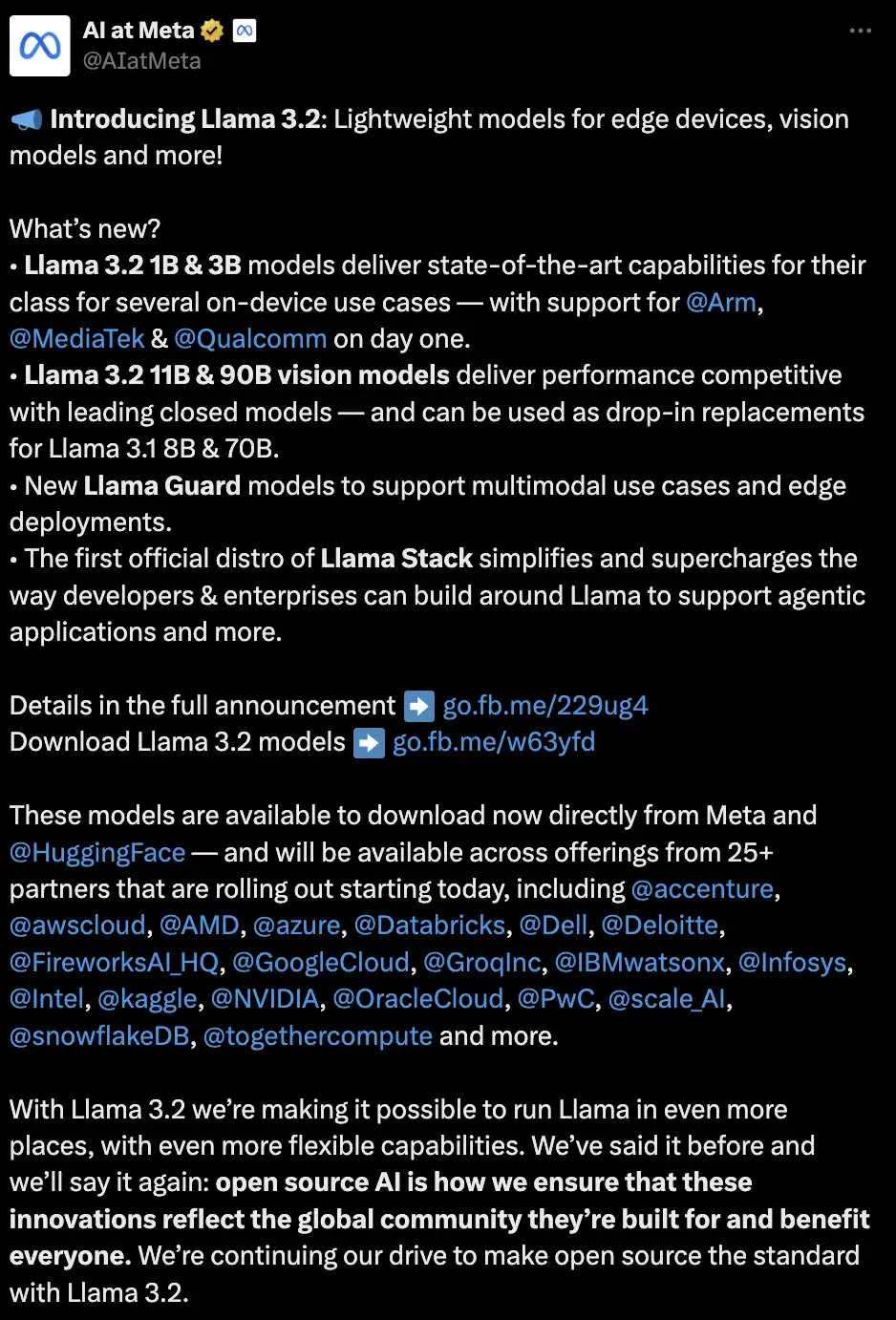

En plus de la sortie matérielle majeure, Zuckerberg a également apporté une mise à jour à Llama, en lançant le modèle Llama 3.2. En tant que premier modèle Llama à prendre en charge les tâches de vision, Llama 3.2 est capable de comprendre à la fois les images et le texte. Il s'agit notamment de modèles de vision de petite et moyenne taille (11B et 90B) et de modèles de texte brut légers (1B et 3B) adaptés aux appareils mobiles et de pointe, les deux catégories comprenant des versions pré-entraînées et affinées par les instructions. Il convient de mentionner que ces modèles de spécifications différentes peuvent être testés via Meta AI.

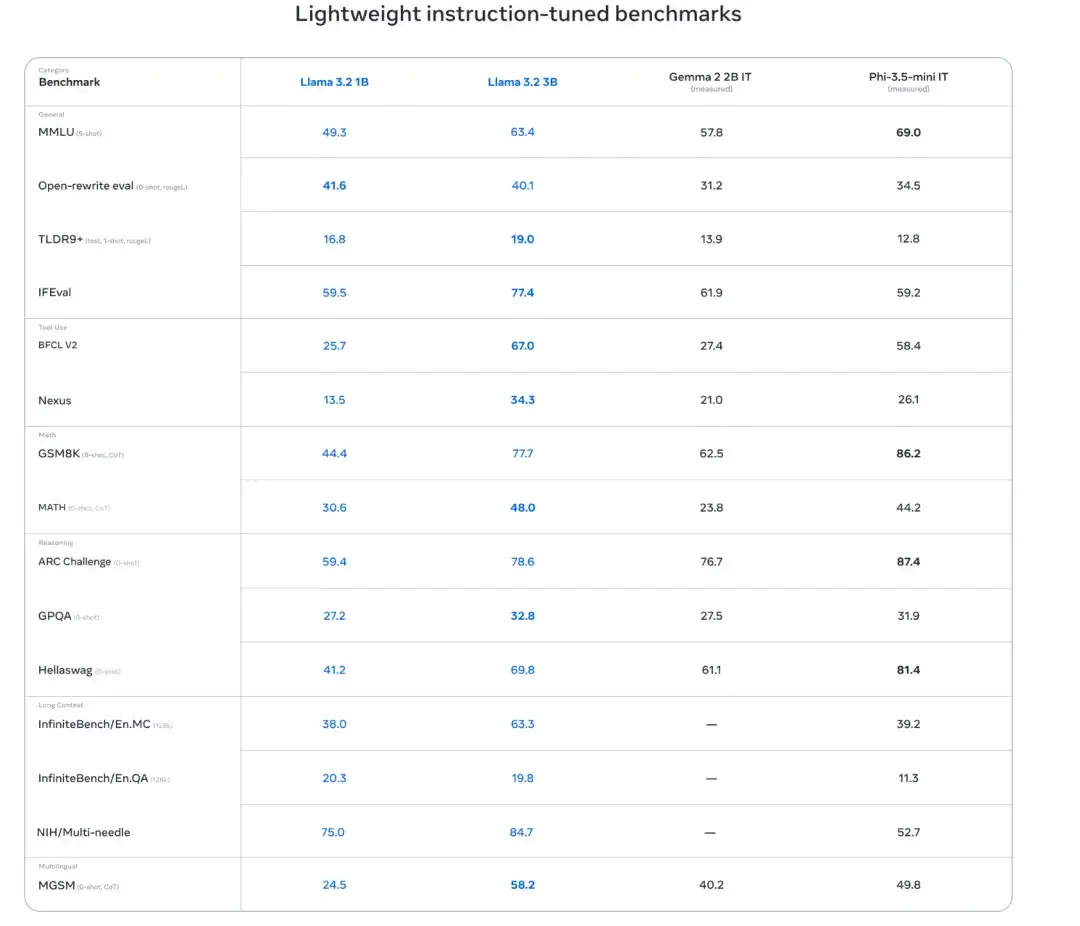

Évaluation des performances du modèle

Les chercheurs ont mené une enquête interlinguistique auprès de plus de 150Ensembles de données de référenceÉvaluer les performances du modèle. Les résultats montrent que les modèles Llama 3.2 1B et 3B prennent en charge une longueur de contexte de 128 000 jetons. Dans des tâches telles que le suivi des instructions, le résumé, la réécriture rapide et l'utilisation d'outils, le modèle 3B surpasse les modèles Gemma 2 2,6B et Phi 3,5-mini, tandis que le modèle 1B peut rivaliser avec le modèle Gemma.

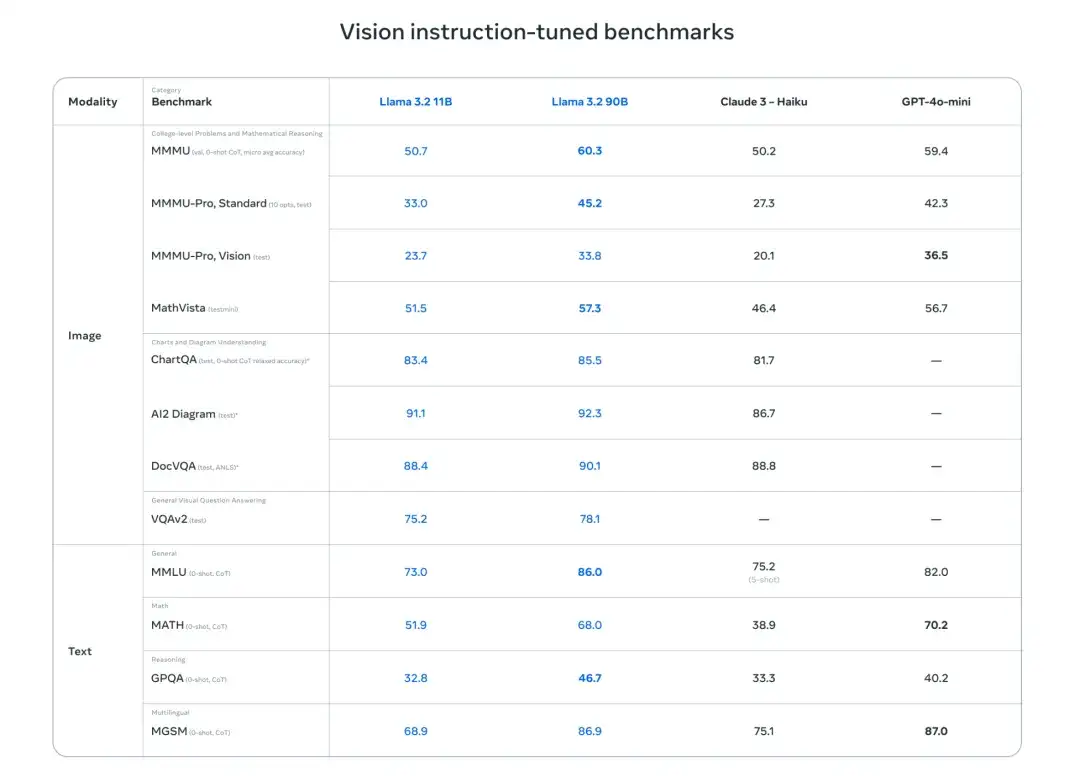

De plus, les chercheurs ont évalué les performances du modèle sur les critères de compréhension d’images et de raisonnement visuel. Les résultats montrent que les modèles de vision Llama 3.2 11B et 90B peuvent remplacer de manière transparente les modèles de texte correspondants, tout en surpassant les modèles à source fermée tels que Claude 3 Haiku sur les tâches de compréhension d'images.

Entraînement de modèles légers

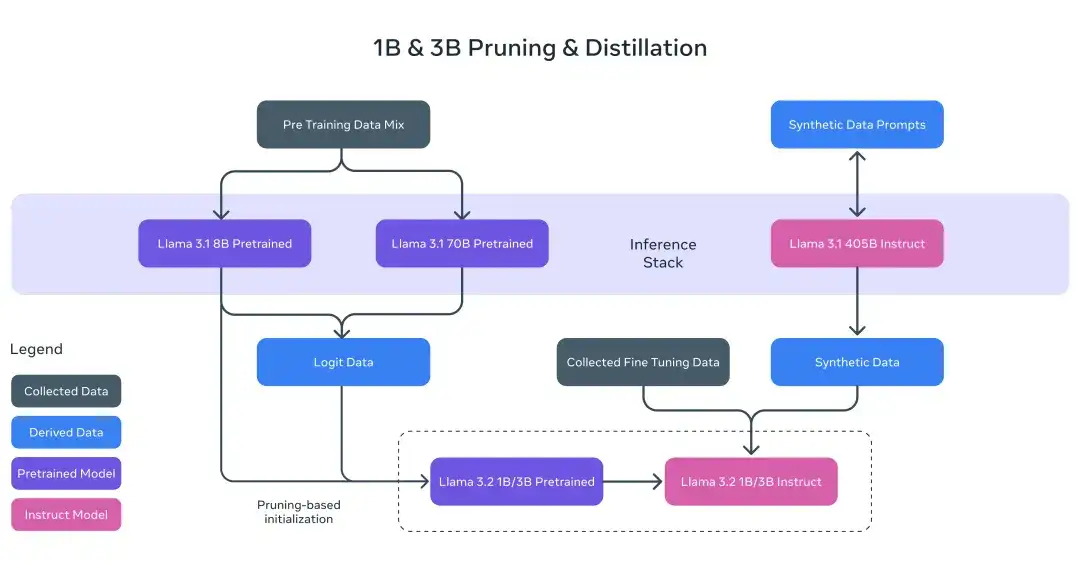

Pour les modèles Llama 3.2 1B et 3B, les chercheurs ont utilisé des méthodes d’élagage et de distillation pour extraire des modèles 1B/3B efficaces des modèles 8B/70B.

Plus précisément, les chercheurs ont incorporé la date Logit des modèles 8B et 70B de Llama 3.1 dans la phase de pré-formation et ont utilisé les sorties de ces modèles plus grands (date logit) comme cibles au niveau du jeton pour l'élagage structuré. Après la taille, les chercheurs ont utiliséDistillation des connaissancespour restaurer les performances du modèle.

Formation sur modèle visuel

Le processus de formation de Llama 3.2 est divisé en plusieurs étapes. Tout d’abord, commencez par le modèle de texte Llama 3.1 pré-entraîné. Ensuite, les chercheurs ont ajouté un adaptateur d’image et un encodeur et les ont pré-entraînés sur des données appariées bruyantes à grande échelle (image, texte). Ensuite, il est formé sur une quantité moyenne de données appariées de haute qualité dans le domaine et enrichies en connaissances (image, texte).

Dans les étapes ultérieures de la formation, les chercheurs ont adopté une approche similaire à celle du modèle de texte, en utilisant plusieurs cycles d’alignement pour un réglage fin supervisé, un échantillonnage de rejet et une optimisation directe des préférences. Les chercheurs ont utilisé le modèle Llama 3.1 pour générer des données synthétiques, des questions et réponses filtrées et améliorées pour les images du domaine, et ont utilisé un modèle de récompense pour classer toutes les réponses candidates, garantissant ainsi des données de réglage fin de haute qualité.

De plus, les chercheurs ont introduit des données d’atténuation de sécurité pour créer un modèle à la fois hautement sécurisé et pratique. Enfin, le modèle Llama 3.2, capable de comprendre à la fois les images et le texte, est né, marquant une autre étape importante pour le modèle Llama sur la voie de capacités d'agent plus riches.

Les modèles de déploiement locaux sont opportuns et sécurisés

Les chercheurs soulignent deux avantages majeurs à l’exécution locale du modèle Llama 3.2. Tout d’abord, en termes de vitesse de réponse, puisque tout le traitement est effectué localement, la vitesse des invites et des réponses peut être proche de l’instantané.

Deuxièmement, en termes de confidentialité et de sécurité, l’exécution du modèle localement ne nécessite pas d’envoyer des données telles que des messages et des calendriers vers le cloud, ce qui protège la confidentialité des utilisateurs et rend l’application plus privée. Grâce au traitement local, les applications peuvent contrôler explicitement les requêtes qui restent sur l’appareil et celles qui sont traitées par des modèles plus grands dans le cloud.

tenez bonOpen SourceIntention initiale : le déploiement du modèle est plus simple et plus efficace

Meta a toujours adhéré à l’intention originale de l’open source. Afin de simplifier considérablement le processus des développeurs utilisant les modèles Llama dans différents environnements (y compris le nœud unique, le déploiement sur site, le cloud et les appareils),Amélioration de la rechercheMeta a annoncé qu'il partagerait les premières distributions officielles de Llama Stack, offrant un déploiement en un clic des applications RAG et prises en charge par des outils avec des fonctionnalités de sécurité intégrées.

Selon l'introduction officielle, le modèle Llama 3.2 sera http://llama.com et Hugging Face, et fournira un support de développement immédiat sur les plateformes partenaires, notamment AMD, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud, Snowflake et autres.

En tant que fervent défenseur de l'open source, Zuckerberg a déclaré un jour lors d'une conversation avec Huang Renxun que « Meta a bénéficié de l'écosystème open source et a économisé des milliards de dollars. » Llama est sans aucun doute un outil important pour construire un écosystème open source. Llama 3.2 s'étend davantage aux tâches visuelles et atteint la multimodalité, ce qui ne manquera pas d'ajouter des avantages à son écosystème open source.