Command Palette

Search for a command to run...

Publié Conjointement Par CUHK, Tencent Et d'autres ! DynamiCrafter : N'importe Quelle Image Peut Être Transformée En Vidéo Dynamique En Quelques Secondes, Avec Une ultra-haute Définition Transparente

En 1986, Calabash Brothers, diffusé sur CCTV-1, a reçu un large succès dès sa sortie et est devenu un précieux souvenir d'enfance pour d'innombrables personnes nées dans les années 1980 et 1990. Cependant, cette animation classique,En fait, il est composé d’environ 200 000 images dessinées par le personnel.

Selon le développement de l'intrigue, le personnel assemblera les articulations du personnage pour poser et filmer sous forme de vidéo à 24 images par seconde.Cela crée une différence visuelle pour le public.C'est-à-dire qu'on pense que le personnage peut bouger.

En fait,La vidéo dynamique est lue en continu, image par image.Au début, les gens dessinaient des images sur du papier à dessin et donnaient vie aux images en retournant rapidement le papier ; plus tard, les ordinateurs et les caméras ont pu conserver plus de 24 images en 1 seconde, créant ainsi un effet visuel dynamique rapide et continu. À ce jour, la technologie vidéo a fait de grands progrès dans la simulation de la dynamique aléatoire de scènes naturelles (comme les nuages et les fluides) ou du mouvement dans des zones spécifiques (comme les mouvements du corps humain).

Cependant, qu'il s'agisse d'une scène réelle capturée ou d'une animation virtuelle ou d'un dessin animé, la présentation d'une vidéo dynamique nécessite le support de supports d'images continus. Par exemple, pour montrer le cycle complet de la floraison des fleurs, les gens doivent vraiment attendre que les fleurs fleurissent et les enregistrer image par image.

L’émergence de l’IA brise cette limitation.Par CUHK, Tencent Laboratoire d'IA Le modèle DynamiCrafter lancé conjointement par les deux sociétés utilise la technologie de diffusion vidéo préalable pour simuler des modèles de mouvement du monde réel.Combiné avec des commandes de texte, vous pouvez convertir des images en vidéos dynamiques. Il peut traiter presque tous les types d'images statiques, y compris les paysages, les personnes, les animaux, les véhicules, les sculptures, etc. Les vidéos dynamiques générées sont en haute définition, super fluides et transparentes, avec chaque détail capturé parfaitement !

DynamiCrafter est encore plus puissant dans les scénarios d'application. Les cas d’application spécifiques incluent, sans s’y limiter :

Médias de divertissement : créez des arrière-plans dynamiques et des animations de personnages pour les films, les jeux et les environnements de réalité virtuelle.

Éducation culturelle : Convertir des photos historiques en formes dynamiques pour offrir de nouvelles façons d’interagir avec le patrimoine culturel ; créer des vidéos éducatives qui animent des images pour expliquer des concepts complexes ; convertir des données ou des modèles scientifiques en dynamiques intuitives pour réduire les barrières de communication dans la recherche scientifique.

Marketing social : générer des graphiques animés attrayants et de courtes vidéos pour la publicité et l'image de marque sur les réseaux sociaux ; Racontez des histoires à travers des graphiques animés et ajoutez un impact visuel à la promotion de livres et de livres électroniques.

Afin d'aider tout le monde à mieux découvrir DynamiCrafter,HyperAI a lancé le tutoriel « DynamiCrafter AI Video Generation Tool » !Ce tutoriel a créé l'environnement pour vous. Vous n’avez plus besoin d’attendre que le modèle soit téléchargé et formé. Cliquez simplement sur Cloner pour le démarrer en un clic et des vidéos fluides peuvent être produites instantanément !

Adresse du tutoriel :https://hyper.ai/tutorials/31974

Le didacticiel ci-dessus est basé sur WebUI, qui est simple et facile à utiliser, mais dispose d'un contrôle de précision local limité. ComfyUI est basé sur une interface et un flux de travail basés sur des nœuds. Différents effets peuvent être obtenus en changeant les nœuds, offrant aux utilisateurs une plus grande liberté et un espace créatif. donc,HyperAI a également lancé le tutoriel « ComfyUI DynamiCrafter Image-to-Video Workflow ».Pour plus de détails sur le didacticiel, veuillez consulter le prochain article publié par HyperAI aujourd'hui.

Essai de démonstration

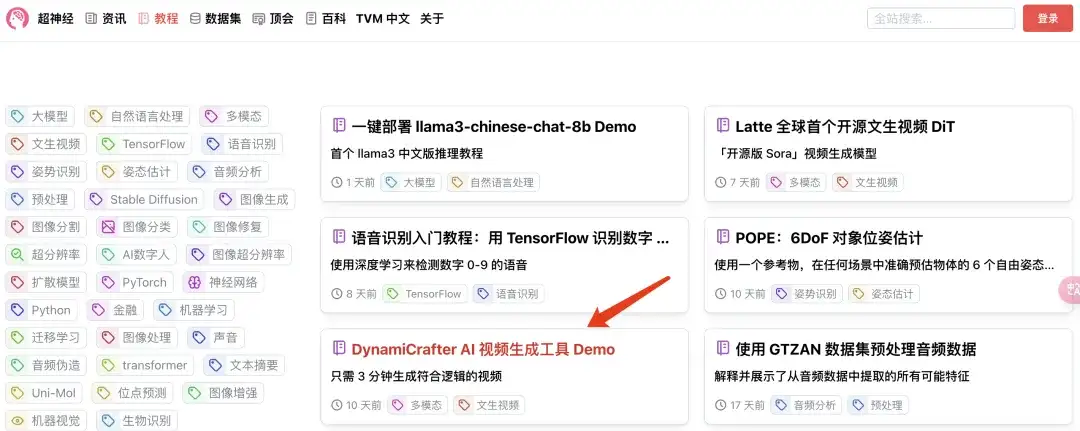

1. Connectez-vous à hyper.ai, sur la page Tutoriels, sélectionnez DynamiCrafter AI Video Generation Tool et cliquez sur Exécuter ce tutoriel en ligne.

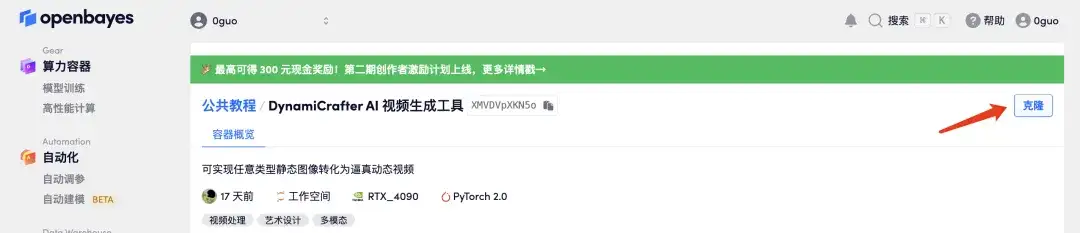

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

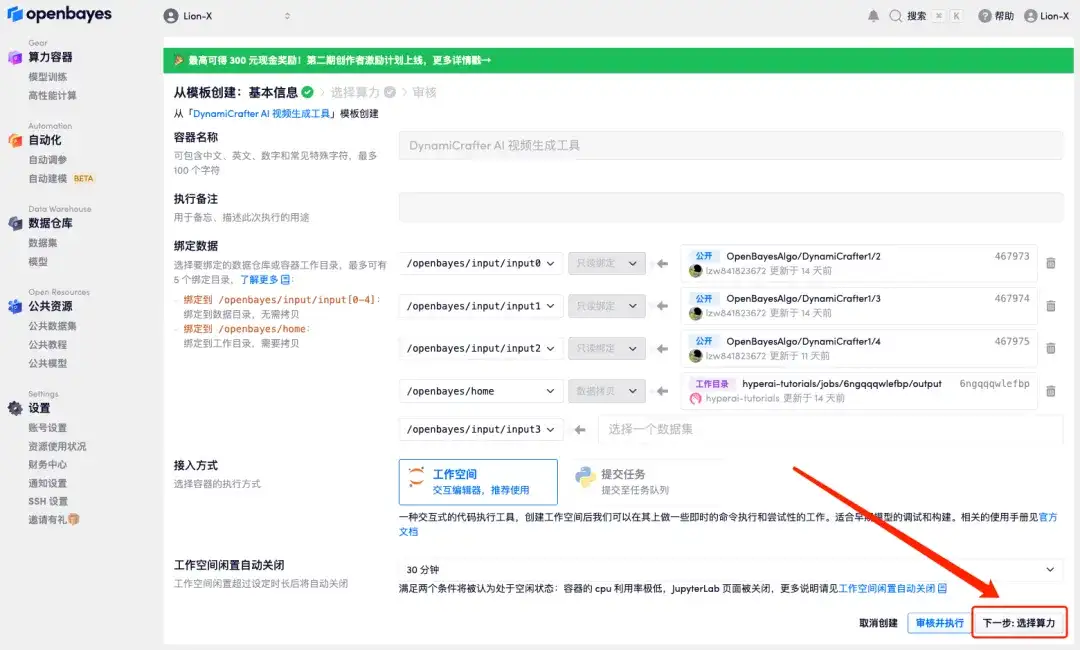

3. Cliquez sur « Suivant : sélectionner le taux de hachage » dans le coin inférieur droit.

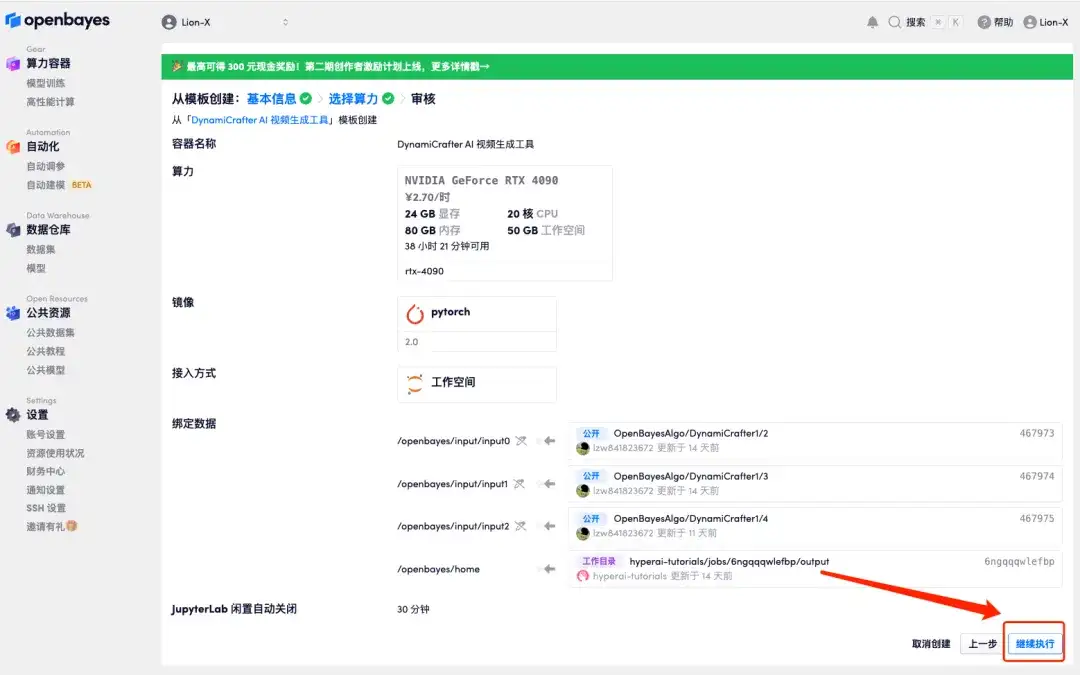

4. Après le saut, sélectionnez « NVIDIA GeForce RTX 4090 » et cliquez sur « Suivant : Réviser ».Les nouveaux utilisateurs peuvent s'inscrire en utilisant le lien d'invitation ci-dessous pour obtenir 4 heures de RTX 4090 + 5 heures de temps CPU gratuit !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

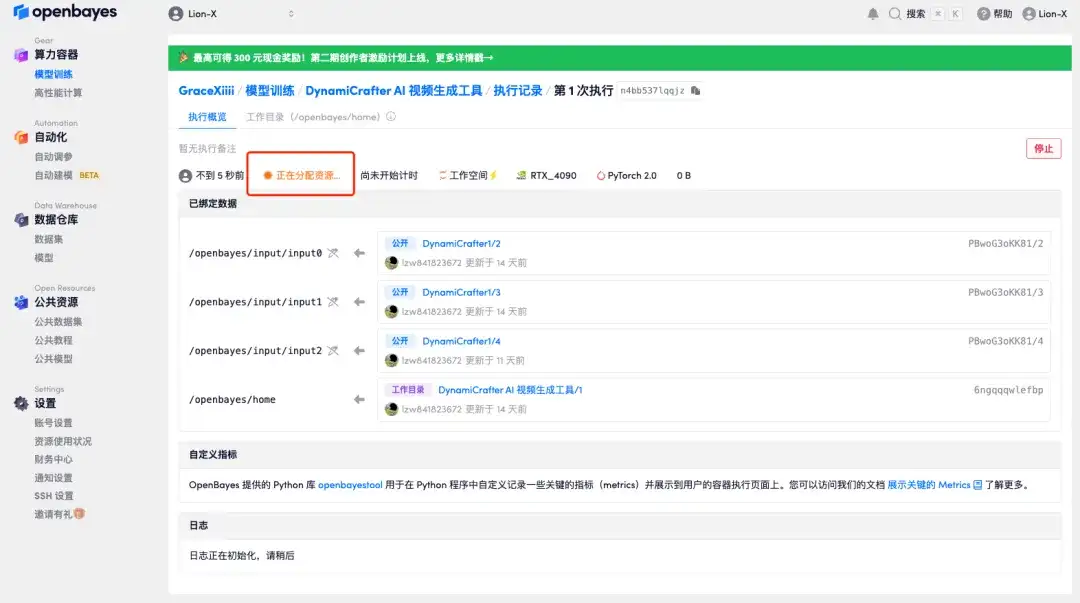

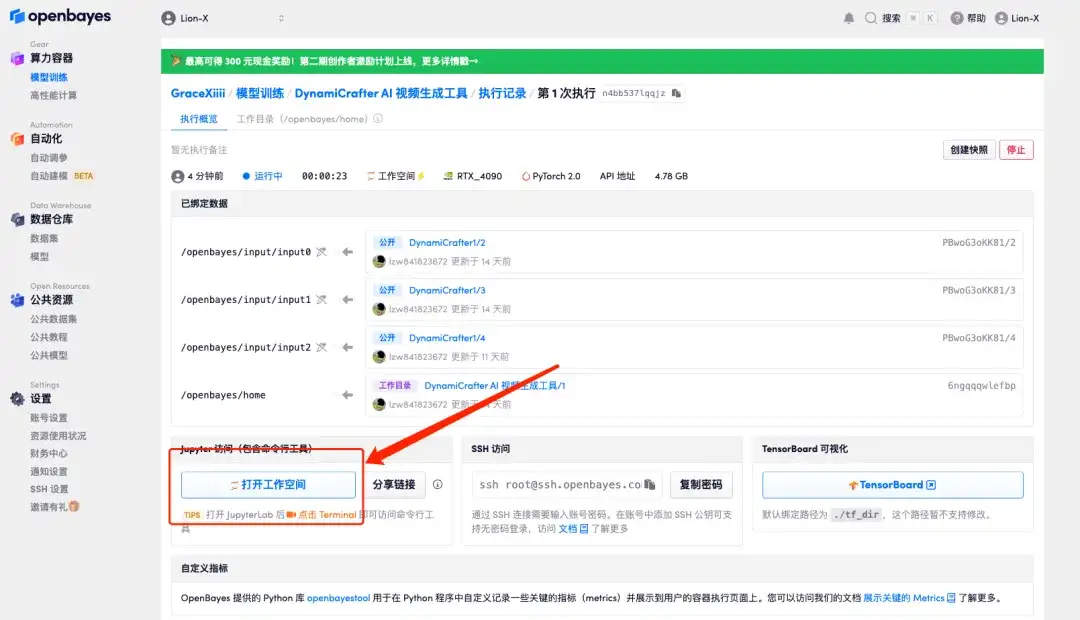

5. Cliquez sur « Continuer » et attendez que les ressources soient allouées. Le premier processus de clonage prendra environ 3 à 5 minutes. Lorsque le statut passe à « En cours d’exécution », cliquez sur « Ouvrir l’espace de travail ».

Si le problème persiste pendant plus de 10 minutes et que le système est toujours dans l’état « Allocation des ressources », essayez d’arrêter et de redémarrer le conteneur. Si le redémarrage ne résout toujours pas le problème, veuillez contacter le service client de la plateforme sur le site officiel.

6. Ce tutoriel peut réaliser les deux effets suivants, qui seront démontrés un par un ci-dessous :

Générer des vidéos à partir d’images et de textes ;

Générez une vidéo en utilisant l'image de début, l'image de fin et les mots d'invite.

Générer des vidéos à partir d'images et de textes

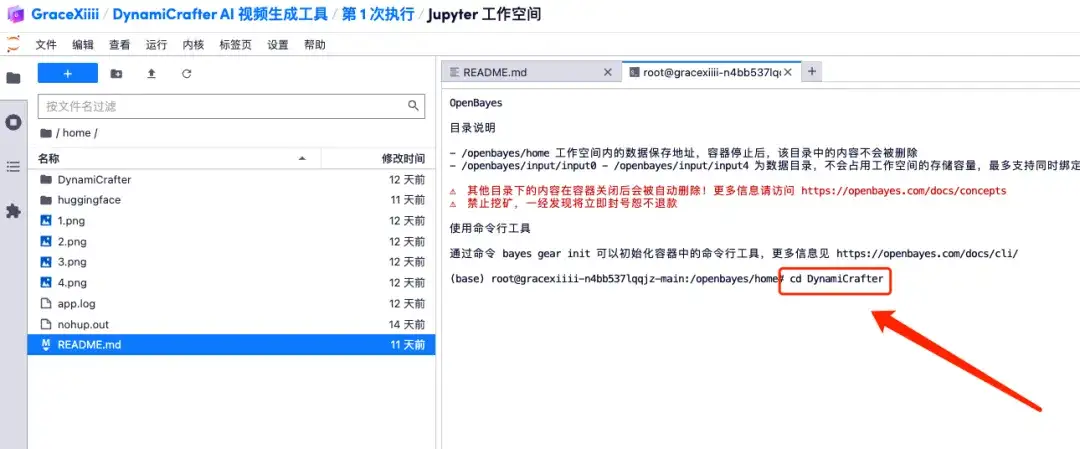

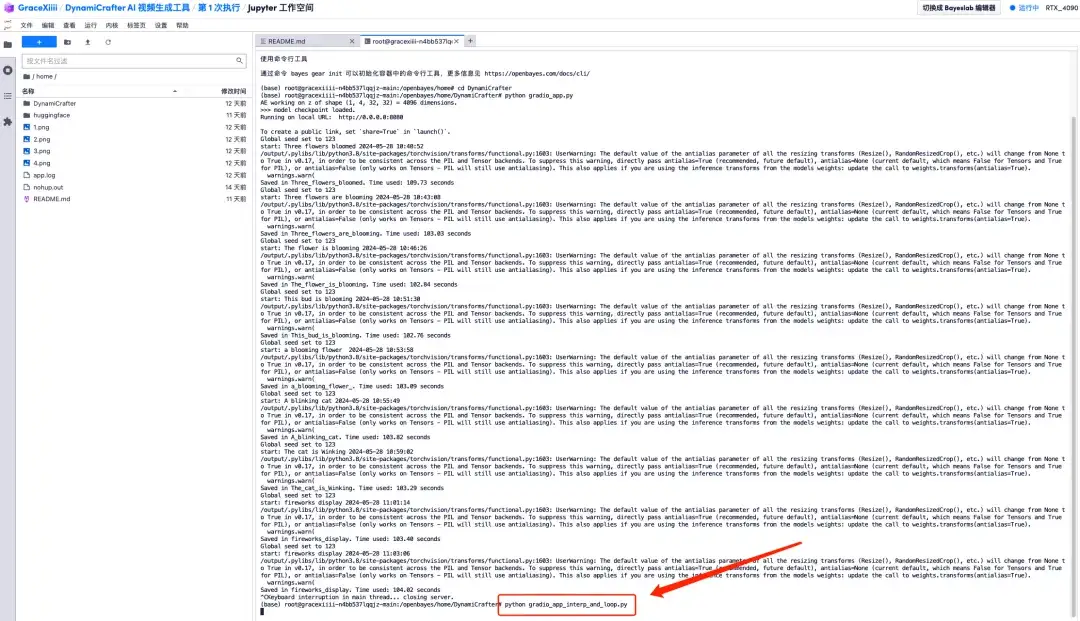

1. Créez un nouveau terminal et exécutez « cd DynamiCrafter » pour basculer vers le répertoire DynamiCrafter.

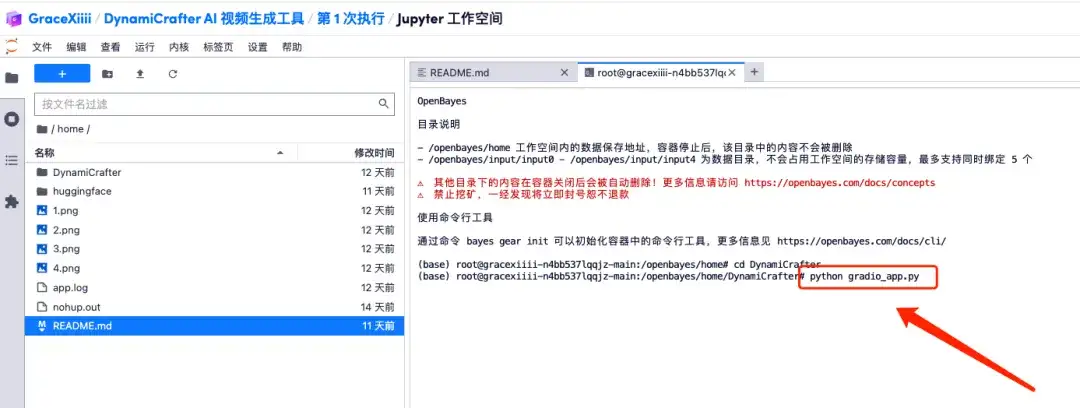

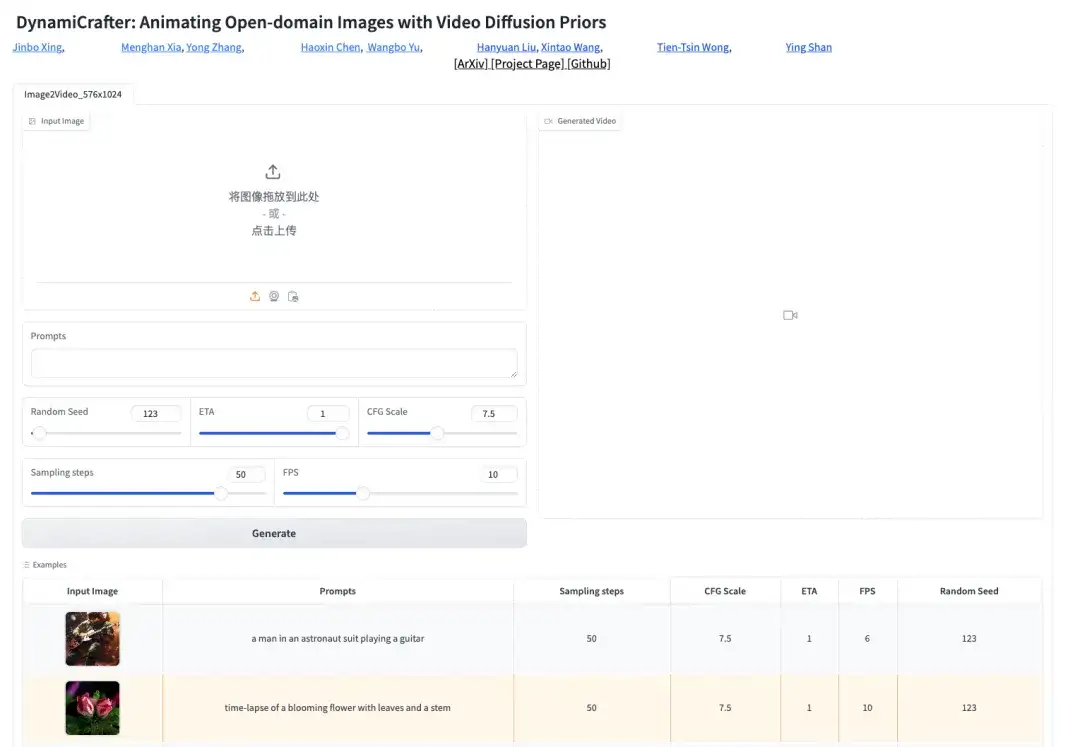

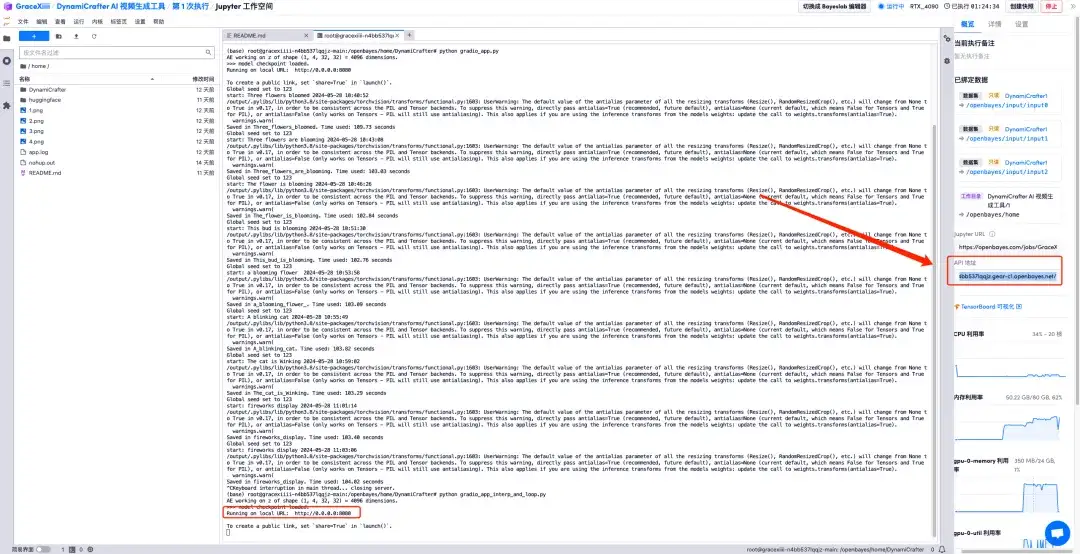

2. Exécutez la commande « python gradio_app.py » et attendez un moment. Lorsque la ligne de commande apparaît «https://0.0.0.0:8080", copiez l'adresse API à droite dans la barre d'adresse du navigateur pour ouvrir l'interface Gradio.Veuillez noter que les utilisateurs doivent effectuer l'authentification par nom réel avant d'utiliser la fonction d'accès à l'adresse API.

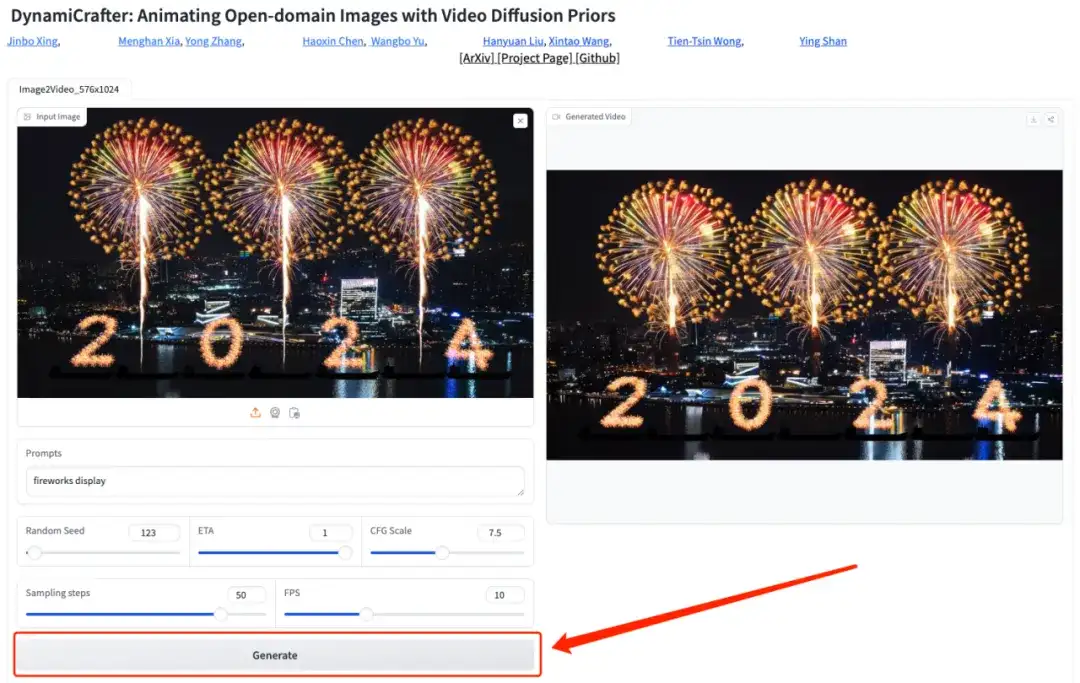

3. Après avoir ouvert la page Gradio, téléchargez une photo et ajoutez une description textuelle (par exemple : feu d'artifice), cliquez sur « Générer » et attendez un instant pour générer la vidéo.

Générer une vidéo en utilisant l'image de début, l'image de fin et les mots d'invite

1. Revenez à l'interface du terminal, terminez le processus en cours en appuyant sur « Ctrl + C », puis exécutez la commande « python gradio_app_interp_and_loop.py ».https://0.0.0.0:8080", puis ouvrez l'adresse API à droite.

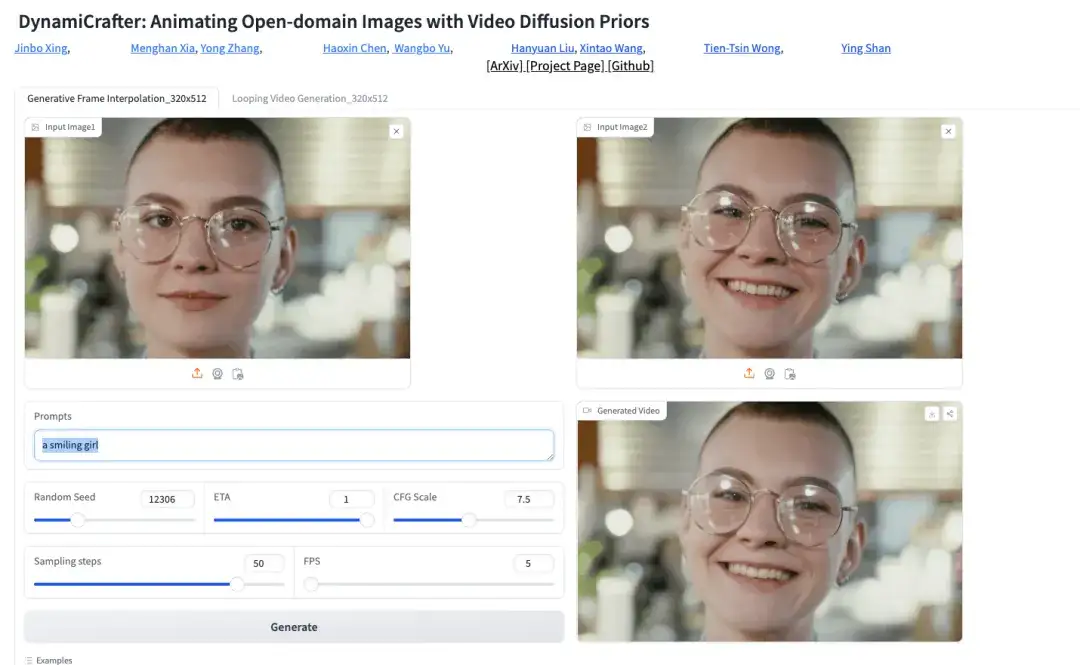

2. Sur la page Gradio, téléchargez une image de début, une image de fin et une description textuelle (par exemple : une fille souriante), puis cliquez sur « Générer » pour générer la vidéo.

À l’heure actuelle, le site Web officiel d’HyperAI a lancé des centaines de tutoriels sélectionnés liés à l’apprentissage automatique, qui sont organisés sous la forme de Jupyter Notebook.

Cliquez sur le lien pour rechercher des tutoriels et des ensembles de données associés :https://hyper.ai/tutorials

Ce qui précède est tout le contenu partagé par HyperAI Super Neural Network cette fois-ci. Si vous voyez des projets de haute qualité, veuillez laisser un message en arrière-plan pour nous les recommander !