Command Palette

Search for a command to run...

Tutoriel En Ligne丨similaire À l'itinéraire Technique De Sora ! Le Premier Modèle Vidéo DiT Open Source Vincent Au Monde, Déploiement En Un Clic De Latte

Depuis qu'OpenAI a lancé Sora, le concept de « vidéo vintage » et les applications associées ont attiré beaucoup d'attention. Avec la popularité de Sora,La technologie clé qui se cache derrière, DiT (Diffusion Transformers), a également été « fouillé archéologiquement ».

En fait, DiT est un modèle de graphique de texte qui a été rendu open source il y a deux ans. Ses développeurs sont Peebles et Xie Saining, parmi lesquels Peebles est également l'un des chefs de projet de Sora.

Avant que le modèle DiT ne soit proposé, Transformer dominait presque le domaine du traitement du langage naturel avec ses puissantes capacités d’extraction de fonctionnalités et de compréhension du contexte. U-Net, avec son architecture unique et ses performances supérieures, domine le domaine des modèles de génération et de diffusion d'images. La principale caractéristique de DiT est qu’il remplace l’architecture U-Net dans le modèle de diffusion par l’architecture Transformer.Il est intéressant de noter que ce travail a été rejeté par le CVPR en 2023 en raison d’un manque d’innovation.

Comparé à U-Net, Transformer a une meilleure évolutivité. Il peut apprendre les dépendances globales et gérer les problèmes de dépendance à longue distance dans les données séquentielles grâce au mécanisme d'auto-attention. Il présente de grands avantages dans le traitement des caractéristiques d’image globales. De plus, DiT basé sur l'architecture Transformer a également permis d'obtenir des améliorations significatives en termes d'efficacité de calcul et d'effets de génération, favorisant ainsi davantage l'application à grande échelle de la génération d'images.

Cependant, en raison de la structure élevée et de la complexité des données vidéo, il est difficile d’étendre le DiT au domaine de la génération vidéo. À cet égard,Une équipe de recherche du Shanghai Artificial Intelligence Laboratory a publié en open source la première vidéo vinyle au monde, DiT:Latte, fin 2023. En tant que modèle auto-développé avec une technologie similaire à Sora, Latte peut être déployé librement.Pour ceux qui souhaitent explorer la technologie vidéo Vincent, le Latte open source offre sans aucun doute une opportunité de pratique.

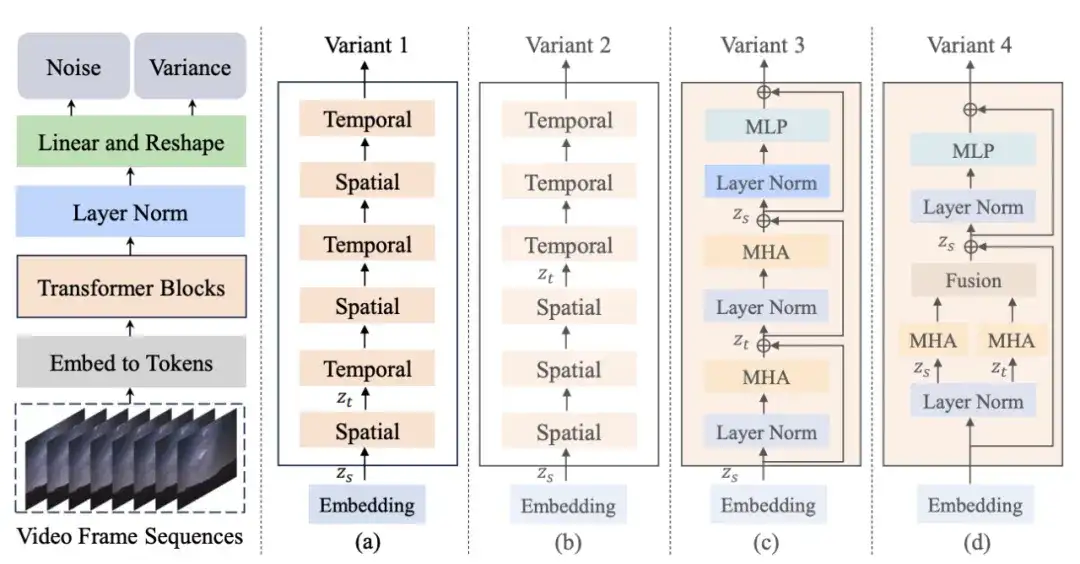

Tout d’abord, Latte encode la vidéo d’entrée en fonctionnalités dans l’espace latent via un autoencodeur variationnel pré-entraîné (VAE) et en extrait des jetons. Ensuite, ces jetons sont codés et décodés à l’aide de la structure de transformateur correspondante dans l’une des variantes ci-dessus. Au cours du processus de génération, le modèle restaurera progressivement la représentation de l'image vidéo à faible bruit dans l'espace latent en fonction du processus de rétrodiffusion appris, et la reconstruira finalement en contenu vidéo continu et réaliste.

Il convient de noter que le laboratoire d'intelligence artificielle de Shanghai, l'équipe de recherche et développement à l'origine de Latte, a travaillé avec la station de radio et de télévision centrale de Chine pourEnsemble, ils ont lancé la première série d'animation vidéo originale chinoise Wensheng AI « Poèmes des mille ans », qui a été diffusée sur la chaîne complète CCTV-1.Les initiés de l'industrie ont analysé qu'avec le lancement de la première animation IA en Chine, la mise en œuvre d'applications vidéo culturelles dans mon pays devrait s'accélérer, ce qui pourrait remodeler le processus de production de l'industrie du cinéma et de la télévision à l'avenir et favoriser le développement révolutionnaire de la production d'animation cinématographique et télévisuelle, du développement de jeux et de la conception publicitaire.

Dans ce contexte, afin d’aider davantage de travailleurs créatifs et de passionnés de vidéo à suivre la tendance technologique,HyperAI a lancé le tutoriel « Latte World's First Open Source Vincent Video DiT ».Ce tutoriel a créé un environnement pour vous. Vous n’avez plus besoin d’attendre que le modèle soit téléchargé et formé. Cliquez simplement sur Cloner pour le démarrer en un clic et entrez du texte pour générer une vidéo instantanément !

Adresse du tutoriel :https://hyper.ai/tutorials/32065

L'éditeur a utilisé le texte « un chien avec des lunettes de soleil » pour générer une vidéo d'un chiot portant des lunettes de soleil. Ça a l'air plutôt beau !

Essai de démonstration

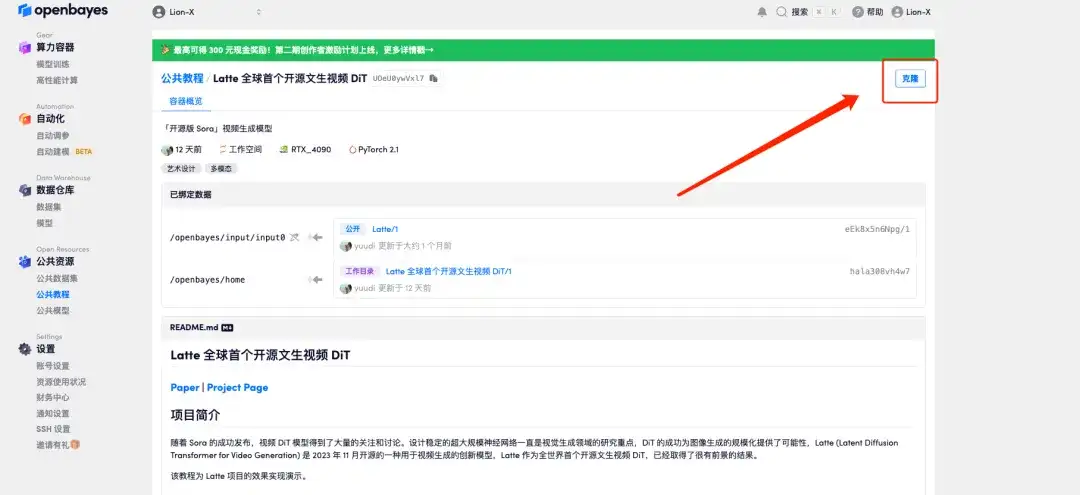

1. Connectez-vous à hyper.ai, sur la page « Tutoriels », sélectionnez « Latte World's First Open Source Vinyl Video DiT » et cliquez sur « Exécuter ce tutoriel en ligne ».

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

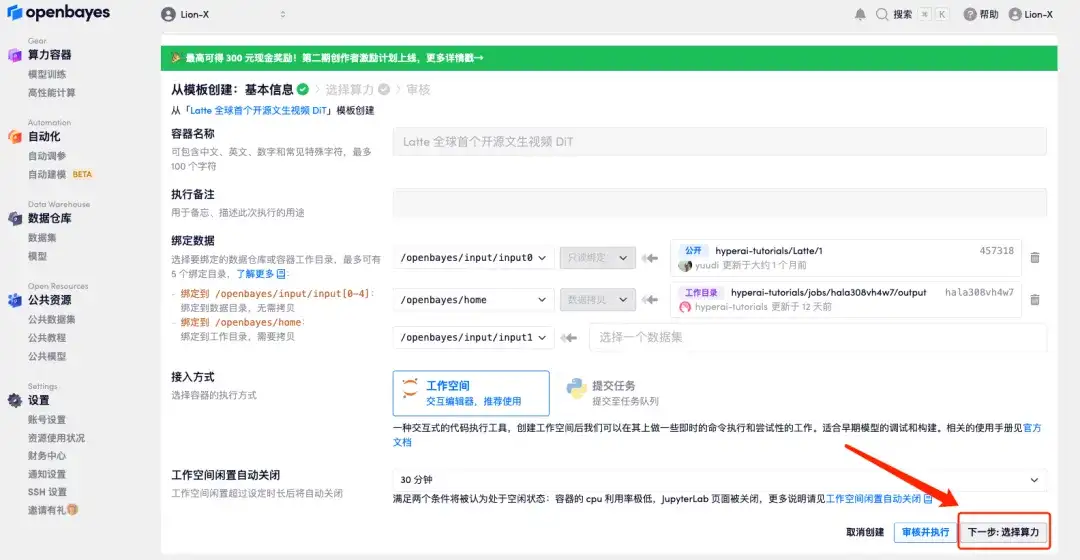

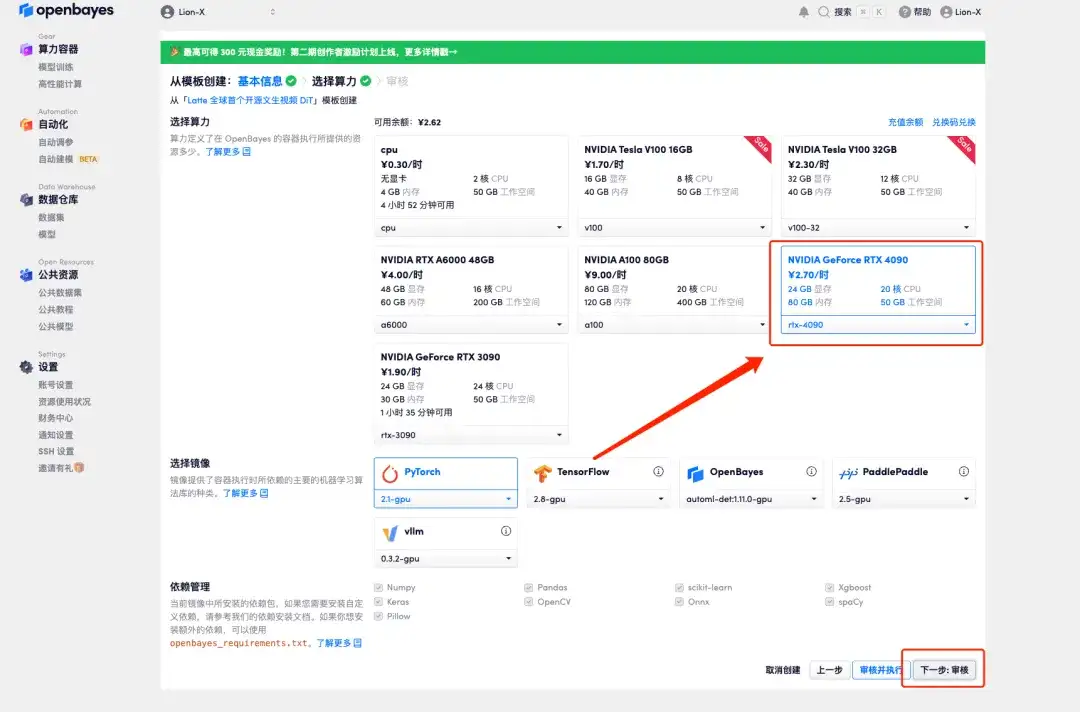

3. Cliquez sur « Suivant : sélectionner le taux de hachage » dans le coin inférieur droit.

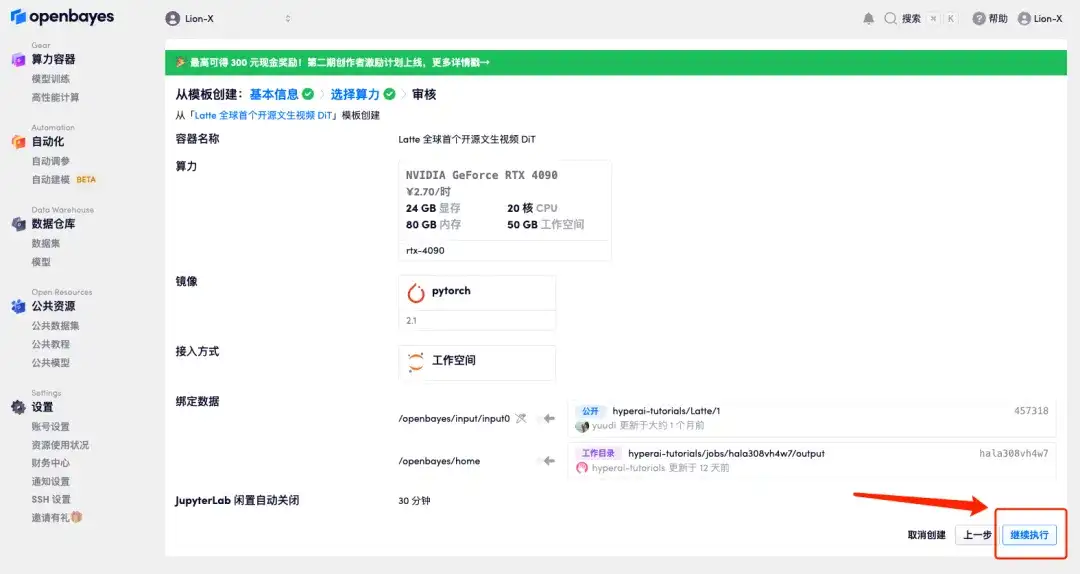

4. Après le saut, sélectionnez « NVIDIA GeForce RTX 4090 » et cliquez sur « Suivant : Réviser ».Les nouveaux utilisateurs peuvent s'inscrire en utilisant le lien d'invitation ci-dessous pour obtenir 4 heures de RTX 4090 + 5 heures de temps CPU gratuit !

Lien d'invitation exclusif HyperAI (copier et ouvrir dans le navigateur) :https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

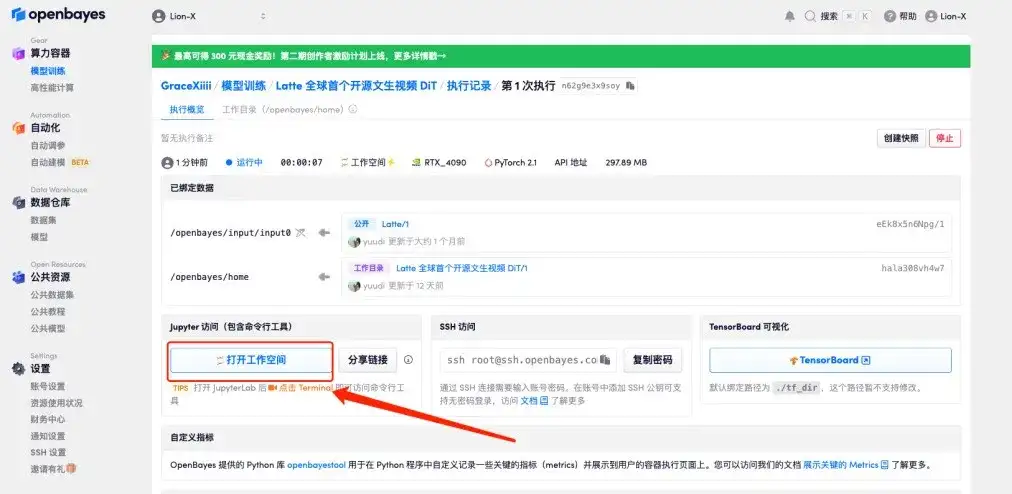

5. Cliquez sur « Continuer » et attendez que les ressources soient allouées. Le premier processus de clonage prendra environ 3 à 5 minutes. Lorsque le statut passe à « En cours d’exécution », cliquez sur « Ouvrir l’espace de travail ».

Si le problème persiste pendant plus de 10 minutes et que le système est toujours dans l’état « Allocation des ressources », essayez d’arrêter et de redémarrer le conteneur. Si le redémarrage ne résout toujours pas le problème, veuillez contacter le service client de la plateforme sur le site officiel.

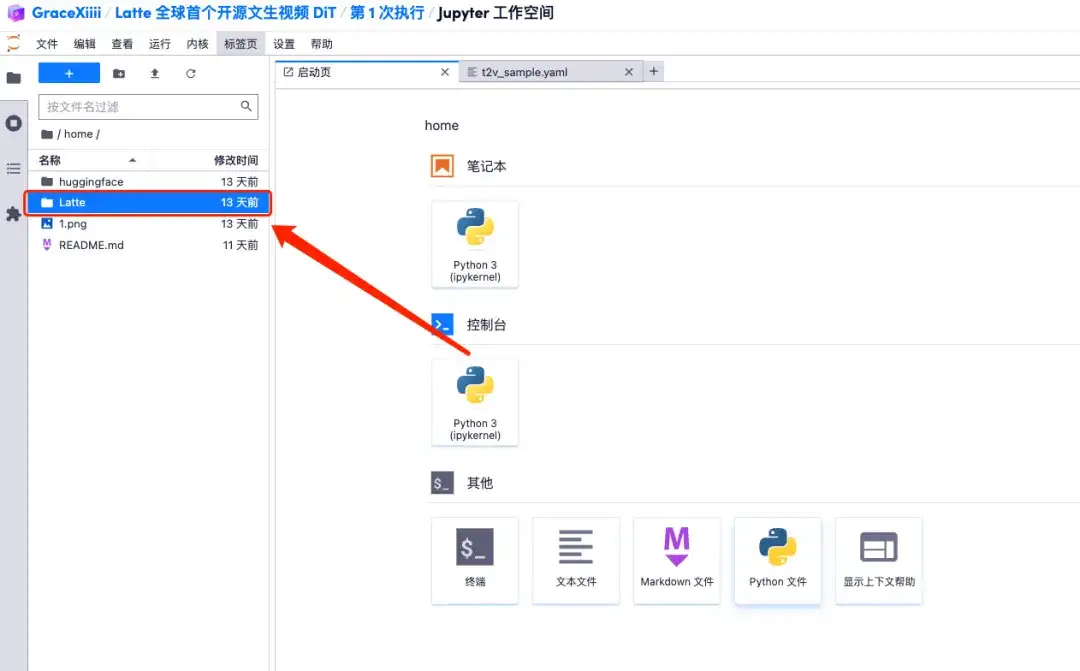

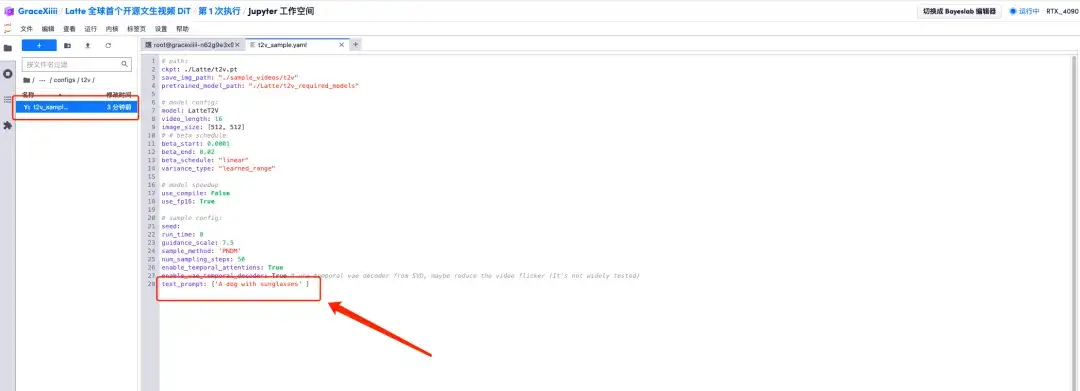

6. Après avoir ouvert l'espace de travail, ouvrez le fichier de configuration home/Latte/configs/t2v/t2v_sample.yaml selon le chemin dans le menu de gauche, entrez l'invite « par exemple : un chien avec des lunettes de soleil » sous text_prompt, et enregistrez-le avec Ctrl+S.

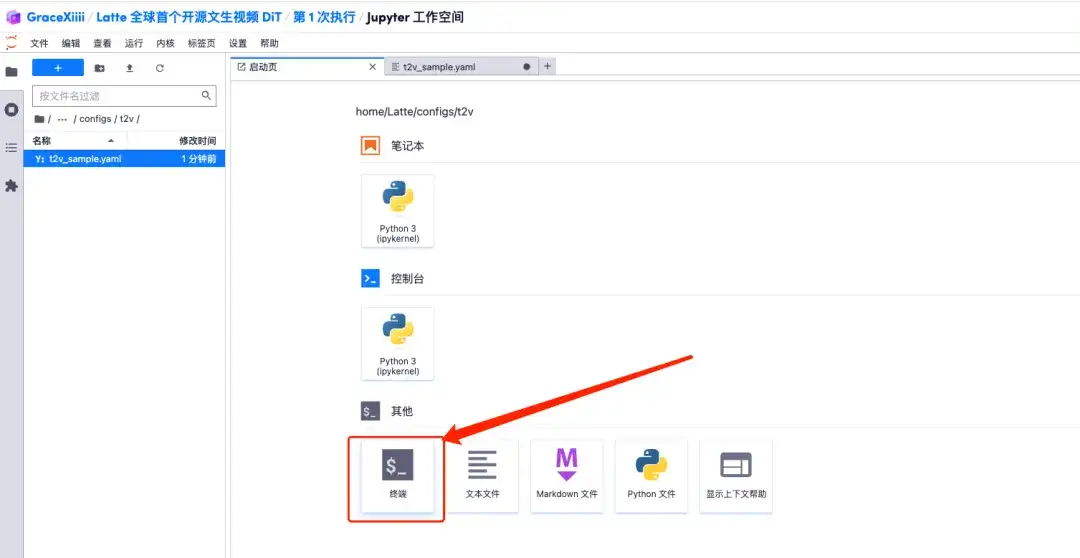

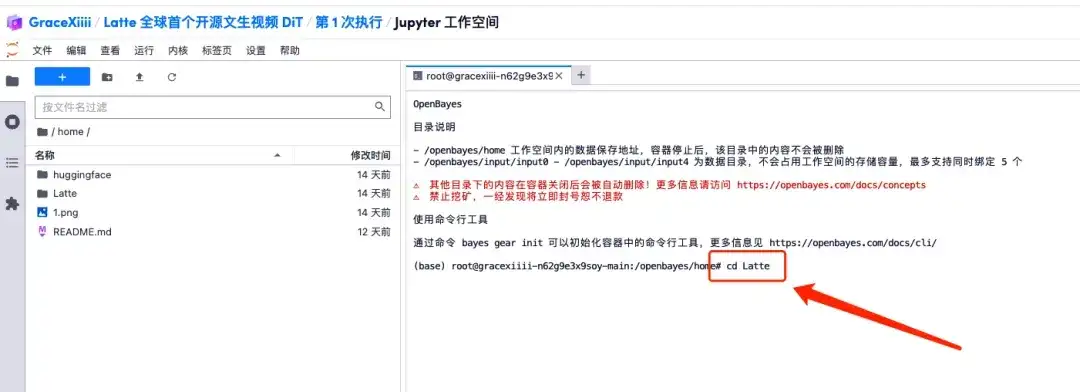

7. Après avoir enregistré, créez une nouvelle page de terminal, entrez « cd Latte » et appuyez sur Entrée pour entrer dans le répertoire « Latte ». Entrez « bash sample/t2v.sh » pour générer une vidéo haute définition.

Affichage des effets

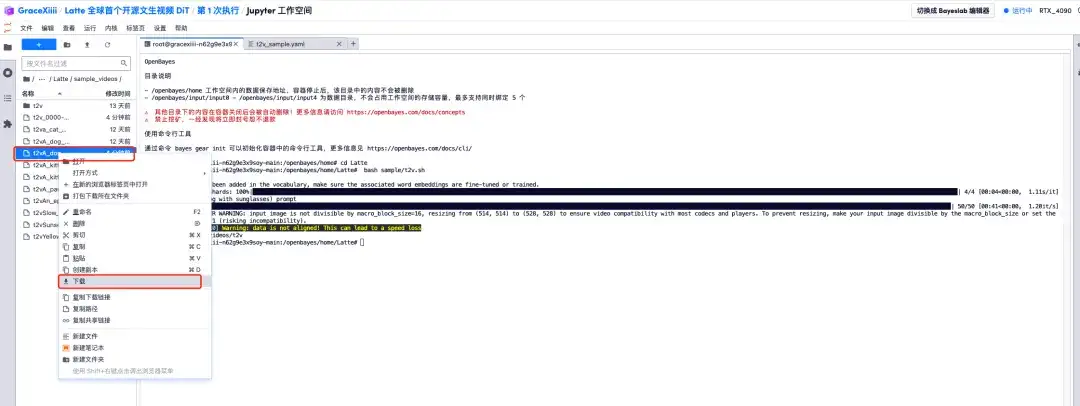

1. Lorsque la barre de progression affiche 100%, ouvrez la barre de menu de gauche « Latte/sample_videos », recherchez la vidéo que nous avons générée et faites un clic droit pour la télécharger.Veuillez noter que les vidéos MP4 ne peuvent pas être visionnées directement et doivent être téléchargées avant d'être visionnées.

2. Une vidéo d'un chiot portant des lunettes de soleil est générée !

À l’heure actuelle, le site Web officiel d’HyperAI a lancé des centaines de tutoriels sélectionnés liés à l’apprentissage automatique, qui sont organisés sous la forme de Jupyter Notebook.

Cliquez sur le lien pour rechercher des tutoriels et des ensembles de données associés :https://hyper.ai/tutorials

Ce qui précède est tout le contenu partagé par HyperAI Super Neural Network cette fois-ci. Si vous voyez des projets de haute qualité, veuillez laisser un message en arrière-plan pour nous les recommander ! De plus, nous avons également créé un « Groupe d'échange de tutoriels de diffusion stable ». Bienvenue aux amis pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats des applications~