Command Palette

Search for a command to run...

Choc Tueur De Dragon GPT-4o ! ChatGPT Est Une Application Interactive Multimodale En Temps Réel, Gratuite Pour tous. Il a Une Interaction Vocale fluide. C'est Un gagnant.

Il a été révélé début mai qu'un moteur de recherche serait lancé le 9 ; le 11 mai, il a été officiellement annoncé que les mises à jour de ChatGPT et GPT-4 seraient publiées à 10 heures du matin, heure locale, le 13 mai ; puis Sam Altman est venu personnellement réfuter la rumeur, en disant « ce n'est pas GPT-5, ni un moteur de recherche », mais « une nouvelle chose comme de la magie » ; Par la suite, les internautes ont commencé à approfondir le contenu de la version à travers divers indices, et finalement GPT-4.5 et la fonction d'appel de ChatGPT sont devenus des candidats populaires.

Au début, certains internautes ont plaisanté en disant que Sam Altman essayait de voler la vedette à la conférence Google I/O, mais comparé à la confrontation entre Gemini 1.5 et Sora, s'il n'y avait pas quelque chose de « dur », Altman ne serait probablement pas prêt à prendre le risque de publier une mise à jour la veille de la conférence annuelle de Google.

C'est effectivement le cas. La conférence en direct en ligne apparemment improvisée d'OpenAI était en fait bien préparée.

Sam Altman n'était pas présent dans ces mises à jour de printemps d'OpenAI, mais le CTO de la société, Muri Murati, a apporté une série de mises à jour, notamment :

- GPT-4o

- Fonction d'interaction vocale de ChatGPT

- Les capacités visuelles de ChatGPT

GPT-4o : Amélioration de la voix, gratuite pour tous les utilisateurs

Depuis sa sortie en mars 2023, GPT-4 domine les charts depuis longtemps. Chaque fois qu'un nouveau modèle est lancé, il est présenté à des fins de comparaison, ce qui suffit à prouver ses performances puissantes. De plus, GPT-4 est également une « vache à lait » avec une grande valeur commerciale pour OpenAI à ce stade, et a été critiqué à plusieurs reprises par Musk pour n'être « pas ouvert ».

Plus important encore, face à Llama open source de Meta, Gemma open source de Google et Grok open source de Musk, la version gratuite de ChatGPT basée sur GPT-3.5 subit une pression doublée. Comme GPT-5 n'est pas encore apparu, de nombreux internautes ont spéculé qu'OpenAI publierait une nouvelle version de GPT-4 pour remplacer GPT-3.5.

Comme prévu, lors de la diffusion en direct d'aujourd'hui, OpenAI a publié une nouvelle version, GPT-4o, qui est gratuite pour tous les utilisateurs, et les utilisateurs payants auront 5 fois la limite de capacité des utilisateurs gratuits. Le « o » signifie « omni », ce qui implique une évolution vers une interaction homme-ordinateur plus naturelle.

Muri Murati, directeur technique d'OpenAI, a expliqué que GPT-4o fournit des capacités d'IA de niveau GPT-4 et peut effectuer un raisonnement basé sur la parole, le texte et la vision. Il accepte n'importe quelle combinaison d'entrée de texte, d'audio et d'image et peut générer n'importe quelle combinaison de sortie de texte, d'audio et d'image.

Cliquez sur le lien pour voir la vidéo de démonstration du GPT-4o :

https://www.bilibili.com/video/BV1PH4y137ch

Avant GPT-4o, la latence moyenne pour converser avec ChatGPT en mode vocal était de 2,8 secondes (GPT-3.5) et de 5,4 secondes (GPT-4). Pour optimiser l'expérience interactive, OpenAI a formé un nouveau modèle de bout en bout pour le texte, la vision et l'audio, ce qui signifie que toutes les entrées et sorties sont traitées par le même réseau neuronal, réduisant ainsi la perte d'informations.

En termes de performances, le GPT-4o peut répondre à une entrée audio en 232 millisecondes, avec un temps de réaction moyen de 320 millisecondes, ce qui est similaire au temps de réaction des humains lors d'une conversation. De plus, GPT-4o fonctionne à égalité avec GPT-4 Turbo sur les textes anglais et codés, et améliore également considérablement les textes en langues autres que l'anglais, améliorant la qualité et la vitesse de reconnaissance dans 50 langues différentes. Dans le même temps, l'API est deux fois plus rapide, mais le prix est moins cher 50%.

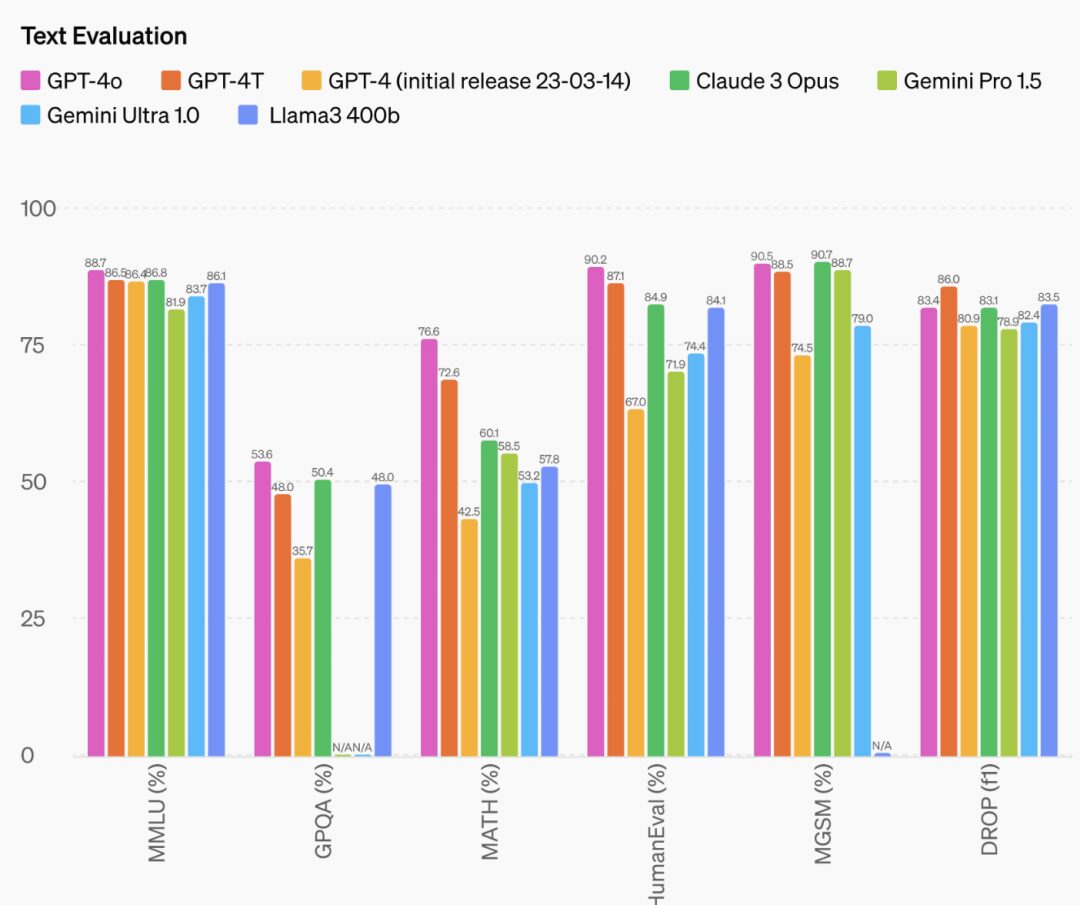

De plus, la capacité de raisonnement du GPT-4o a également été considérablement améliorée. Les données officielles montrent que GPT-4o a créé un nouveau score élevé de 88,7% dans le COT MMLU à 0 coup (questions de bon sens).

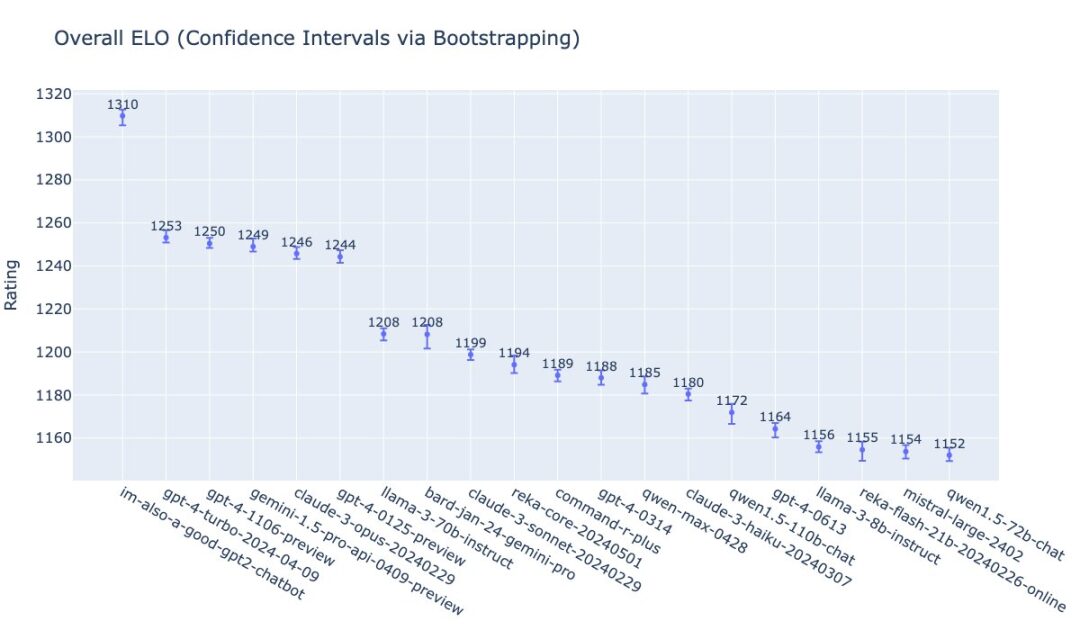

William Fedus d'OpenAI a publié le classement de GPT-4o sur la liste LMSys. Le nom que l'équipe a donné à GPT-4o est également très intéressant : im-also-a-good-gpt2-chatbot.

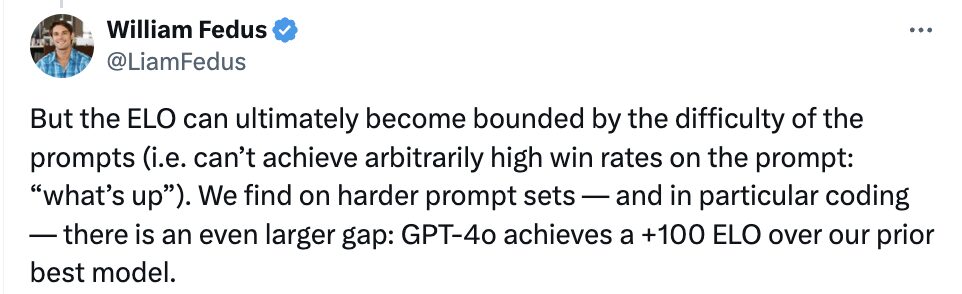

Il a également indiqué que sur les ensembles d'invites plus difficiles, en particulier en termes de capacité d'encodage, le niveau de GPT-4o est +100 ELO plus élevé que le précédent modèle le plus avancé d'OpenAI.

William Fedus a déclaré sans détour que le GPT-4o n'est pas seulement le meilleur modèle au monde, mais qu'il est également fourni gratuitement dans ChatGPT, ce qui crée un précédent dans les modèles de pointe.

Dans une certaine mesure, GPT-4o peut être considéré comme la mise à jour d'OpenAI de ses produits « open source ». Quant aux critiques répétées selon lesquelles OpenAI « n'est pas ouvert », Sam Altman a également déclaré sur son blog : « L'une des missions d'OpenAI est de fournir gratuitement (ou à prix réduit) de puissants outils d'intelligence artificielle. Je suis très fier que nous proposions gratuitement le meilleur modèle au monde sur ChatGPT, sans publicité ni rien de ce genre. »

Sam Altman a également salué les performances du GPT-4o : « Le nouveau mode voix (et vidéo) est la meilleure interface informatique que j'aie jamais utilisée. On se croirait dans l'intelligence artificielle des films ; et son authenticité me surprend encore un peu. L'un des changements importants réside dans le temps de réponse et l'expressivité, qui atteignent des niveaux humains. »

Plus tard, Altman a posté « elle » sur son compte, laissant entendre que son nouveau modèle inaugurera « l'ère Elle ».

Il convient de noter que la fonctionnalité vocale n’est pas disponible pour tous les clients dans l’API GPT-4o.

OpenAI a déclaré que GPT-4o prend en compte la sécurité de différents modes dans sa conception grâce à des techniques telles que le filtrage des données de formation et l'affinement du comportement du modèle après la formation. L’équipe a également créé un nouveau système de sécurité pour protéger la sortie vocale.

Cependant, OpenAI a déclaré qu'il prévoyait de déployer de nouvelles fonctionnalités audio et vidéo pour GPT-4o d'abord auprès d'un « petit groupe de partenaires de confiance » dans les semaines à venir, invoquant le risque d'abus.

Les fonctionnalités de texte et d’image de GPT-4o seront disponibles dans ChatGPT à partir d’aujourd’hui. Dans les semaines à venir, OpenAI lancera une nouvelle version du modèle vocal alpha avec GPT-4o dans ChatGPT Plus. Les développeurs peuvent désormais également accéder à GPT-4o en mode texte et visuel dans l'API.

Son époque est arrivée : interaction vocale émotionnelle ChatGPT

Dès février de cette année, l'ancien responsable des relations avec les développeurs d'OpenAI mentionnait que la forme ultime de ChatGPT n'était pas seulement le chat.

Le 11 mai, Sam Altman a également déclaré dans un podcast qu'OpenAI continuerait d'améliorer et d'optimiser la qualité des fonctions vocales de ChatGPT, et a déclaré que l'interaction vocale est un moyen important pour les futures méthodes d'interaction.

Lors de la conférence de presse d'aujourd'hui, OpenAI a également démontré ses résultats intermédiaires dans l'amélioration de la qualité vocale de ChatGPT - l'interaction vocale a été réalisée sur la base de GPT-4o et la vitesse de réponse a été considérablement améliorée.

Plus précisément, les mises à niveau et les mises à jour de ChatGPT se reflètent principalement dans trois aspects : l'interaction en temps réel, l'entrée et la sortie multimodales et la perception des émotions.

En termes d'interaction en temps réel, lors de la démonstration en direct, ChatGPT peut répondre à toutes les questions du questionneur presque instantanément. Si le questionneur interrompt la réponse de ChatGPT, celui-ci peut également s'arrêter. Muri Murati a également démontré les capacités de traduction en temps réel du GPT-4o à la demande du public.

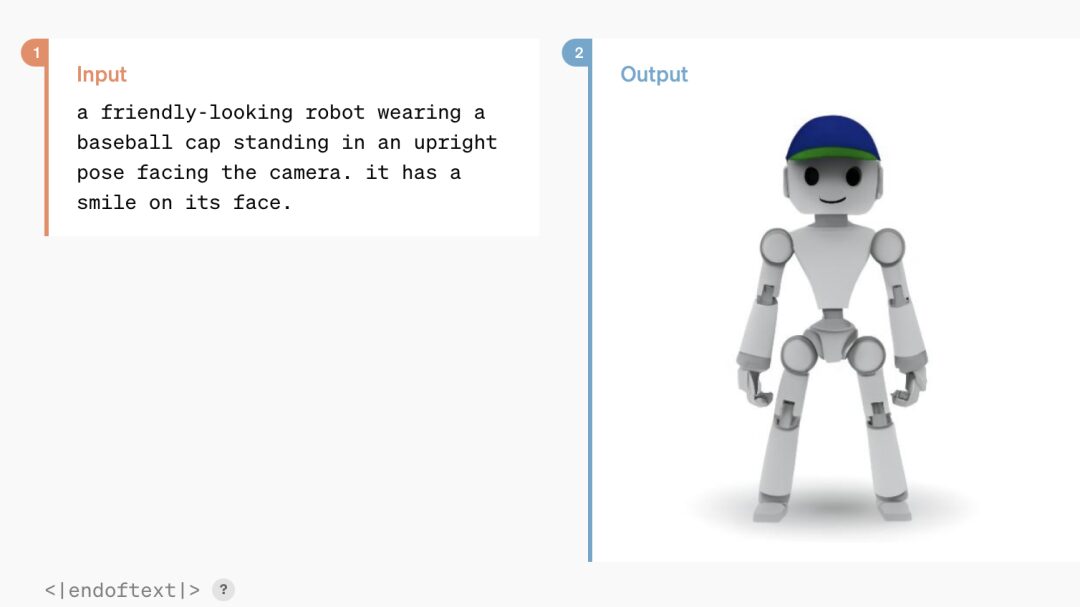

Il n’est pas nécessaire de s’étendre sur l’entrée/sortie multimodale. ChatGPT basé sur GPT-4o peut reconnaître du texte, de la voix et des informations visuelles, et répondre sous n'importe quelle forme selon les besoins.

En termes de perception des émotions et de retour émotionnel, le ChatGPT amélioré peut analyser rapidement les émotions faciales d’une personne en fonction de ses selfies. Il peut également ajuster son ton de voix en fonction des exigences de l'interlocuteur, du drame exagéré au froid et mécanique, et même chanter, ce qui montre son excellente plasticité.

À cet égard, Muri Murati a déclaré : « Nous savons que ces modèles deviennent de plus en plus complexes, mais nous espérons que l'expérience interactive deviendra plus naturelle et plus simple, de sorte que vous n'aurez pas du tout à prêter attention à l'interface utilisateur, mais que vous vous concentrerez uniquement sur la collaboration avec GPT, ce qui est très important. »

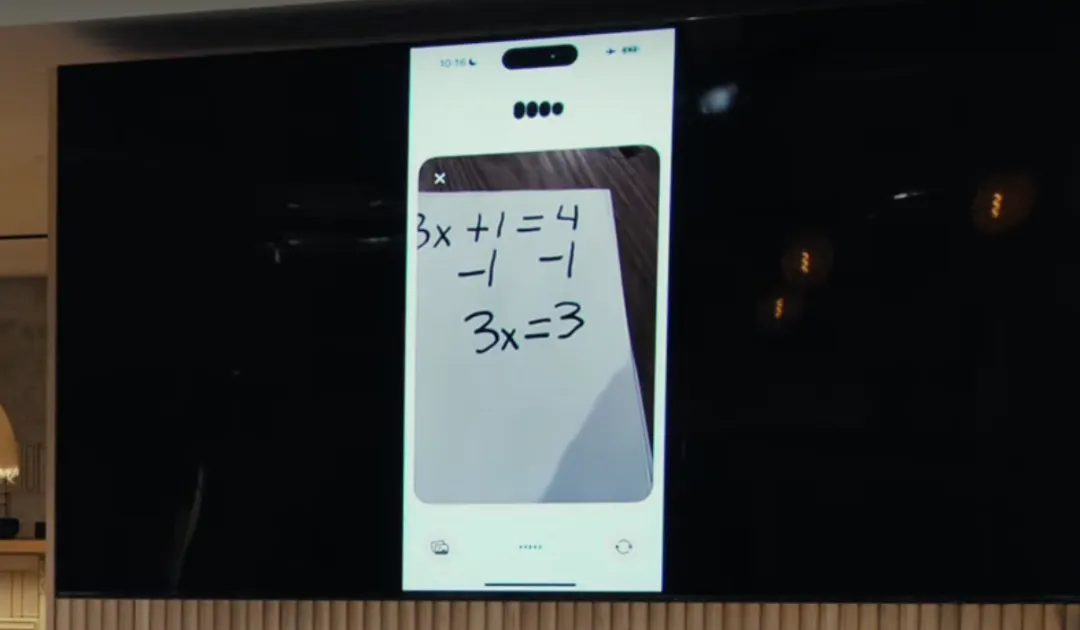

De plus, en termes d’analyse du raisonnement, GPT-4o améliore également les capacités visuelles de ChatGPT. Étant donné une photo que vous avez prise, ChatGPT peut parcourir rapidement le contenu de l’image et répondre aux questions associées, comme prendre une photo pour résoudre un problème mathématique.

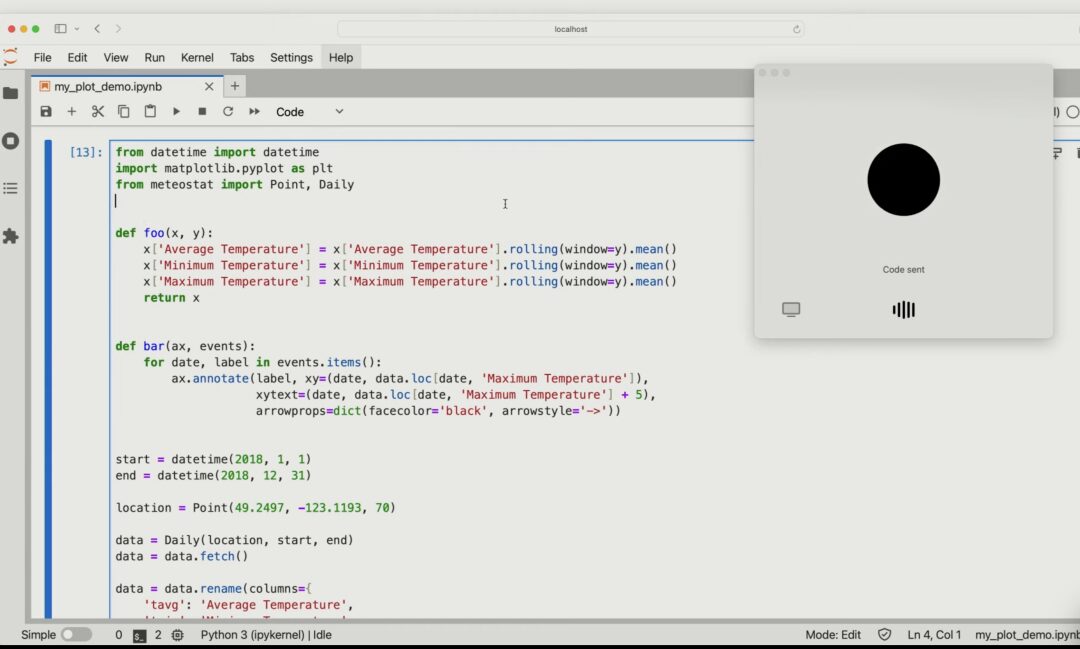

Vous pouvez également décrire le contenu spécifique du code en fonction de l'image de code partagée et analyser l'impact spécifique qui se produira si l'une des variables du code est modifiée.

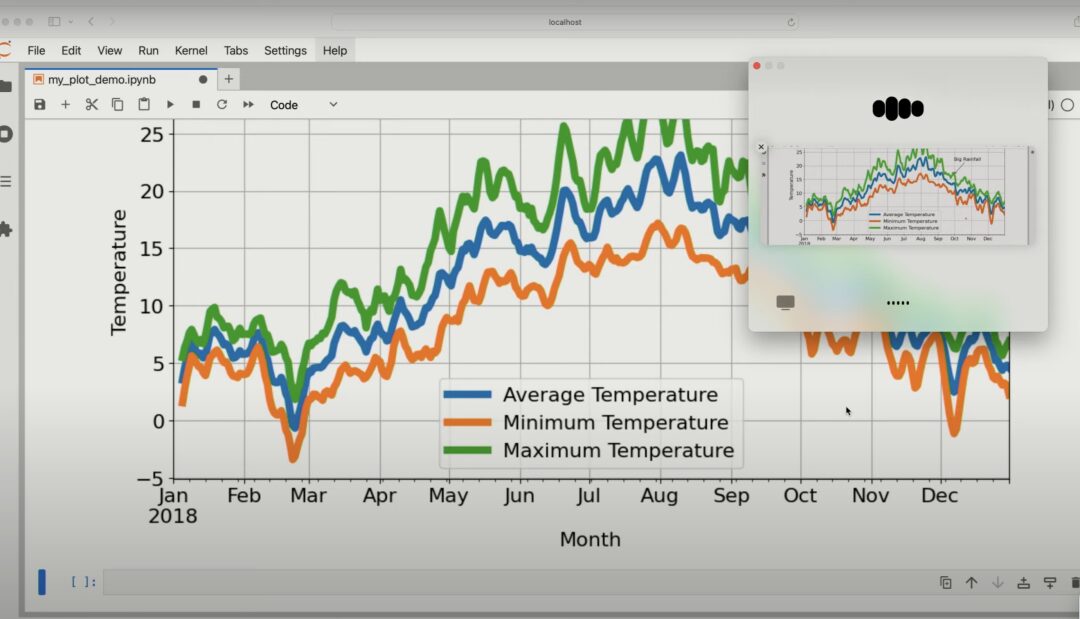

Donnez un graphique à GPT-4o et il pourra analyser le contenu du graphique en détail.

Cette tentative innovante d'OpenAI étend l'application de ChatGPT à la voix, au texte et à la vision, ce qui indique que l'interaction homme-ordinateur pourrait être plus naturelle et plus fluide à l'avenir.

En réponse, OpenAI a déclaré que les assistants vocaux IA dotés de capacités visuelles et audio ont le même potentiel de transformation que les smartphones. En théorie, ils peuvent faire toute une série de choses que les assistants IA actuels ne peuvent pas faire, comme agir comme tuteur de thèse ou de mathématiques, ou traduire les panneaux de signalisation et aider à résoudre les problèmes de voiture.

Derniers mots

Depuis l’émergence de GPT, OpenAI est considéré comme le « baromètre » de l’ère des grands modèles. Compter les géants traditionnels de la Silicon Valley :

- Microsoft entretient une relation délicate avec OpenAI. Il ne s’agit pas seulement d’un investisseur financier, mais il a également déployé le modèle GPT dans sa propre entreprise et fournit des services cloud à OpenAI.

- Apple a commencé à augmenter ses investissements dans l'IA générative cette année et a publié son propre grand modèle, mais il a commencé tard et il reste à voir s'il peut ébranler la position d'OpenAI. Dans le même temps, des rapports indiquent qu’Apple coopère déjà avec OpenAI et Google sur de grands modèles.

- En tant que plus grand fournisseur d'infrastructure cloud au monde, Amazon a également lancé son propre grand modèle, Amazon Titan, mais ce n'est qu'une partie de son service d'hébergement cloud Bedrock. Bien qu’Amazon ait également investi dans Anthropic, il semble toujours difficile de concurrencer OpenAI.

En comparaison, Google semble être l’entreprise qui a le plus d’espoir de concurrencer OpenAI. Il dispose non seulement d'une accumulation technique profonde (l'architecture Transformer vient de Google), mais dispose également d'un écosystème riche permettant aux grands modèles de montrer leur force.

Cependant, les lecteurs qui suivent Google trouveront peut-être que ce vieux géant a un physique un peu "Wang Feng" à l'ère des grands modèles (tête de chien pour sauver la vie) - de Bard et PaLM 2 étant inférieurs à GPT-4 en performance, à la sortie du chef-d'œuvre subversif Gemini 1.5 étant éclipsée par Sora, et la conférence Google I/O prévue en mars étant éclipsée par une diffusion en direct "improvisée" d'OpenAI pendant la meilleure période de promotion...

Ce matin même (14 mai), OpenAI a lancé le « meilleur modèle au monde ». Je me demande si Pichai va « changer le scénario » du jour au lendemain après avoir regardé la conférence de presse d’aujourd’hui ?

La réponse sera révélée demain matin. Nous attendons avec impatience le retour de Google et HyperAI continuera à fournir des rapports de première main !