Command Palette

Search for a command to run...

Revue De l'événement | Rassemblant Des Experts En Technologie De l'industrie Et Partageant Des Moments De Collision De Réflexion, 2023 Meet TVM · Beijing Station s'est Conclu Avec Succès

Contenu en un coup d'œil :« 2023 Meet TVM Beijing Station » s'est tenu avec succès au Zhongguancun Garage Coffee le 17 juin, attirant plus de 150 participants d'entreprises et d'universités, et tout le monde a eu une discussion complète et animée.

Mots-clés:Compilation d'apprentissage automatique 2023 : Rencontrez TVM

Cet article a été publié pour la première fois sur la plateforme publique HyperAI WeChat~

Le 17 juin, le deuxième rassemblement hors ligne du Meet TVM 2023, organisé par MLC.AI et HyperAI et co-organisé par OpenBayes, s'est conclu avec succès.

Nous sommes honorés d'avoir invité 7 experts techniques de l'Université Jiao Tong de Shanghai, d'ARM China, d'Horizon Robotics et de NIO.En combinant les cas d'application du compilateur d'IA dans ses propres scénarios commerciaux, il a apporté un merveilleux partage aux amis sur place.

En plus des amis locaux de Pékin, de nombreux amis de Tianjin, Nanjing, Hangzhou, Shanghai et d'autres endroits se sont également joints à nous. Chacun a apporté ses propres questions et défis métiers, et en plus d’écouter les partages techniques, ils ont également eu des échanges et des discussions actifs avec leurs pairs.

Obtenez la présentation PPT et la vidéo en direct

Voici une brève introduction à l’événement et une critique vidéo de l’événement.

Suivez le compte public WeChat « HyperAI 超神经元 », répondez avec le mot-clé TVM 北京 en arrière-plan et obtenez le PPT complet de l'invité.

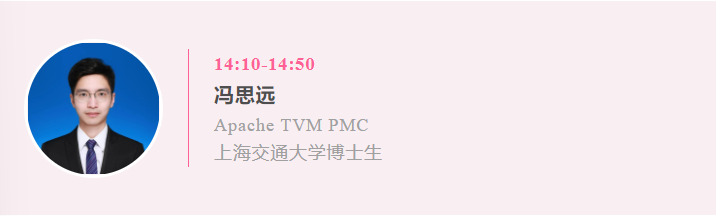

Partager le sujet:Déployez des modèles de langage sur n'importe quel appareil à l'aide de MLC-LLM

Contenu:Des progrès significatifs ont été réalisés dans le domaine de l’IA générative et des grands modèles linguistiques (LLM), qui ont des capacités remarquables et le potentiel de transformer fondamentalement de nombreux domaines. Actuellement, la plupart de ces modèles nécessitent une puissance de calcul et des besoins en mémoire importants et ne peuvent pas être déployés sur des PC personnels, des téléphones portables et des appareils finaux plus petits. MLC-LLM optimise la vitesse d'exécution et les besoins en mémoire grâce à la technologie de compilation, permettant de déployer des LLM côté client et fournissant une nouvelle infrastructure pour le développement ultérieur de modèles de langage.

Vidéo en direct :

https://www.bilibili.com/video/BV1rm4y1Y7Si/?spm_id_from=333.999.0.0

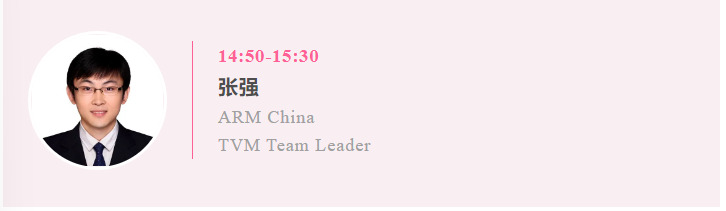

Partager le sujet:TVM chez ARM Chine

Contenu:Avec le développement vigoureux des applications d'IA, diverses puces NPU sont utilisées sur les appareils de pointe pour accélérer les applications d'IA. S’adapter rapidement à différents cadres d’apprentissage automatique et systèmes d’exploitation est devenu un problème difficile. En intégrant sa propre chaîne d'outils avec TVM, ARM China a réalisé de multiples fonctions pratiques telles que le fractionnement de graphes et l'exécution hétérogène automatique, aidant les clients à déployer rapidement des applications d'IA sur la puce ARM China Zhouyi NPU.

Vidéo en direct :

https://www.bilibili.com/video/BV1GW4y1X7tL/?spm_id_from=333.337.search-card.all.click

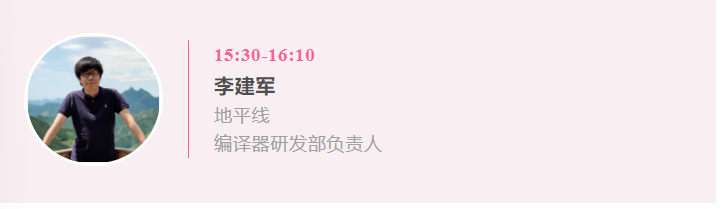

Partager le sujet:Pratique de la programmation hétérogène et de la compilation de l'IA

Contenu:Les puces d’IA évoluent constamment vers une hétérogénéité étroitement couplée. La programmabilité des puces et l’optimisation des performances sont des problèmes clés que l’industrie tente de résoudre. Ce partage présente principalement certaines des pratiques d'Horizon en matière d'optimisation de la compilation de l'IA, de programmabilité, etc., et mène des discussions approfondies sur certaines questions clés.

Vidéo en direct :

https://www.bilibili.com/video/BV1js4y117NT/?spm_id_from=333.337.search-card.all.click

Partager le sujet:TVM chez NIO

Contenu:Le domaine de la conduite autonome est un domaine où coexistent défis et opportunités. Avec l'itération des produits et les exigences de plus en plus élevées des utilisateurs en matière d'expérience de conduite, les moteurs d'IA courants ne sont pas en mesure de prendre en charge efficacement et en toute sécurité les lignes de production de produits complexes. Nous avons développé le propre compilateur d'IA de NIO basé sur TVM, qui a résolu certains problèmes courants dans le domaine de la conduite autonome et a formé une solution systématique et une architecture technique.

Trois ingénieurs de NIO, Meng Tong, Chen Xi (Zhihu aaronxic) et Wang Lulu, ont donné des explications détaillées sur les technologies et les architectures impliquées.

Vidéo en direct :

https://www.bilibili.com/video/BV1fV4y117g7/?spm_id_from=333.337.search-card.all.click

Partager le sujet:Optimisation de la compilation de réseaux neuronaux dynamiques

Contenu: Les réseaux neuronaux dynamiques présentent des avantages importants par rapport aux réseaux neuronaux statiques en termes de précision, d’efficacité de calcul et d’adaptabilité. Cependant, les cadres et compilateurs d’apprentissage profond existants se concentrent principalement sur l’optimisation des réseaux statiques avec une exécution déterministe, manquant ainsi les opportunités d’optimisation dans les réseaux dynamiques. La clé pour optimiser un réseau dynamique est de suivre les données qui le traversent. Ce partage détaille nos travaux sur la compilation de réseaux neuronaux dynamiques.

Vidéo en direct :

https://www.bilibili.com/video/BV1Mz4y1v7se/?spm_id_from=333.337.search-card.all.click

Rejoignez la communauté chinoise TVM pour débloquer plus de villes

Suite à la réunion de Shanghai en mars et à celle de Pékin en juin, nous sommes très heureux de réunir des ingénieurs intéressés par les compilateurs d'IA dans différentes villes pour fournir une plate-forme de communication entre pairs et d'échange de connaissances. Nous prévoyons d’organiser la troisième rencontre hors ligne de l’année à Shenzhen en septembre. Nous invitons toutes les entreprises et partenaires communautaires à participer à la co-création et à étendre continuellement l'influence de la communauté chinoise TVM !

aussi,Nous recrutons également activement des contributeurs de la communauté chinoise TVM.Si vous souhaitez devenir membre de nous, n'hésitez pas à ajouter WeChat antonia0912. Nous nous réjouissons de votre adhésion enthousiaste !

Nous recrutons actuellement :

* Les bénévoles de traduction de la documentation chinoise de TVM veillent à ce que la documentation chinoise soit synchronisée avec la documentation anglaise et fournissent une infrastructure à davantage d'ingénieurs qui souhaitent apprendre et comprendre TVM (visitez le site officiel : tvm.hyper.ai) !

* Bénévoles d'activité, chargés d'organiser, de planifier et d'exécuter des activités dans divers endroits, et d'établir notre base dans plusieurs centres Internet à travers le pays.

* Des bénévoles de questions-réponses, familiers avec TVM et désireux d'apporter leurs idées et leurs réflexions aux amis de la communauté qui rencontrent des problèmes, pour aider chacun à résoudre les problèmes techniques.

D'autres villes seront débloquées en 2023. Rejoignez-nous pour créer la communauté de compilateurs d'IA la plus active de Chine !

Enfin, prenons une photo de groupe sur les lieux❤️

Présentation des organisateurs et des partenaires

En tant qu'organisateur de cet événement, MLC.AI Community (https://mlc.ai/) a été fondée en juin 2022 et dirigée par Chen Tianqi, le principal inventeur d'Apache TVM et un jeune chercheur bien connu dans le domaine de l'apprentissage automatique, l'équipe a lancé le cours en ligne MLC, qui a systématiquement introduit les éléments clés et les concepts de base de la compilation d'apprentissage automatique.

En novembre 2022, grâce aux efforts conjoints des bénévoles de la communauté MLC.AI,Le premier document TVM chinois complet a été lancé et hébergé avec succès sur le site officiel d'HyperAI.Il fournit également aux développeurs nationaux intéressés par la compilation d'apprentissage automatique l'infrastructure - la documentation - pour accéder et apprendre une nouvelle technologie.

En 2023, la communauté lancera la série d'activités « 2023 Meet TVM » dans de nombreuses villes du pays et invite les entreprises et les partenaires communautaires à participer à la co-création.

Cours en ligne MLC :https://mlc.ai/

Documentation chinoise de TVM :https://tvm.hyper.ai/

HyperAI est la principale communauté chinoise d'intelligence artificielle et de calcul haute performance.Nous nous engageons à fournir des ressources publiques de haute qualité dans le domaine de la science des données aux développeurs nationaux.Jusqu'à présent, il a fourni des nœuds de téléchargement nationaux pour plus de 1 200 ensembles de données publiques, pris en charge plus de 300 requêtes de termes liés à l'intelligence artificielle et au calcul haute performance, hébergé la documentation chinoise complète de TVM et lancera bientôt plusieurs didacticiels de base et populaires.

Visitez le site officiel :https://orion.hyper.ai/

OpenBayes Bayesian Computing est un fournisseur national de premier plan de services de calcul haute performance. En greffant des écosystèmes logiciels classiques et des modèles d'apprentissage automatique sur des puces hétérogènes de nouvelle génération, il fournit des produits de calcul de science des données plus rapides et plus faciles à utiliser pour les entreprises industrielles et la recherche scientifique universitaire. Ses produits ont été adoptés par des dizaines de grands scénarios industriels ou d’instituts de recherche scientifique de premier plan.

Visitez le site officiel :https://openbayes.com/

Garage Coffee est une plateforme qui rassemble des entrepreneurs. S'appuyant sur un coffee shop, il offre aux start-ups une solution complète d'investissement et de financement à guichet unique, aidant les parties prenantes du projet à lever rapidement des fonds et à promouvoir un développement rapide. Parallèlement, il fournit des services à valeur ajoutée de haute qualité tels que le conseil en entrepreneuriat, la mise en correspondance des ressources, la publicité et le reporting, et aide les investisseurs à découvrir rapidement de bons projets, fournissant une base pour leur investissement principal, leur investissement de suivi, leur production de ressources, leur production d'expérience, etc., et favorisant le développement collaboratif entre les groupes d'investisseurs à plusieurs niveaux.

Cet article a été publié pour la première fois sur la plateforme publique HyperAI WeChat~