Command Palette

Search for a command to run...

GPT-4 Vise La Multimodalité, Avec Google PaLM-E Dans Le Passé, Le Paysage De l'IA va-t-il Changer ?

Contenu en un coup d'œil :GPT-4 était comme une bombe nucléaire qui a fait exploser tout le cercle technologique le 14 mars. Au centre de cette explosion nucléaire, le très attendu GPT-4 a montré ses muscles, tandis qu'à la périphérie de l'explosion nucléaire, Google et d'autres dieux observaient avec convoitise et faisaient des mouvements constants.

14 mars, heure de l'Est,OpenAI a lancé le modèle multimodal à grande échelle GPT-4. GPT-4 est la technologie derrière les chatbots ChatGPT et Bing AI. OpenAI a déclaré que GPT-4 peut accepter l'entrée d'images et de textes et la sortie de contenu textuel, bien que sa capacité dans de nombreux scénarios du monde réel ne soit pas aussi bonne que celle des humains.Cependant, il a atteint des performances de niveau humain sur une variété de critères professionnels et académiques.

GPT-4 a atterri soudainement : trois caractéristiques ont attiré l'attention

Cette mise à jour de GPT-4 comporte trois nouvelles fonctionnalités majeures qui ont été grandement améliorées :La limite de saisie de texte est améliorée et il a la capacité de reconnaître des images et des capacités de raisonnement plus fortes.

Un contenu plus long et plus riche

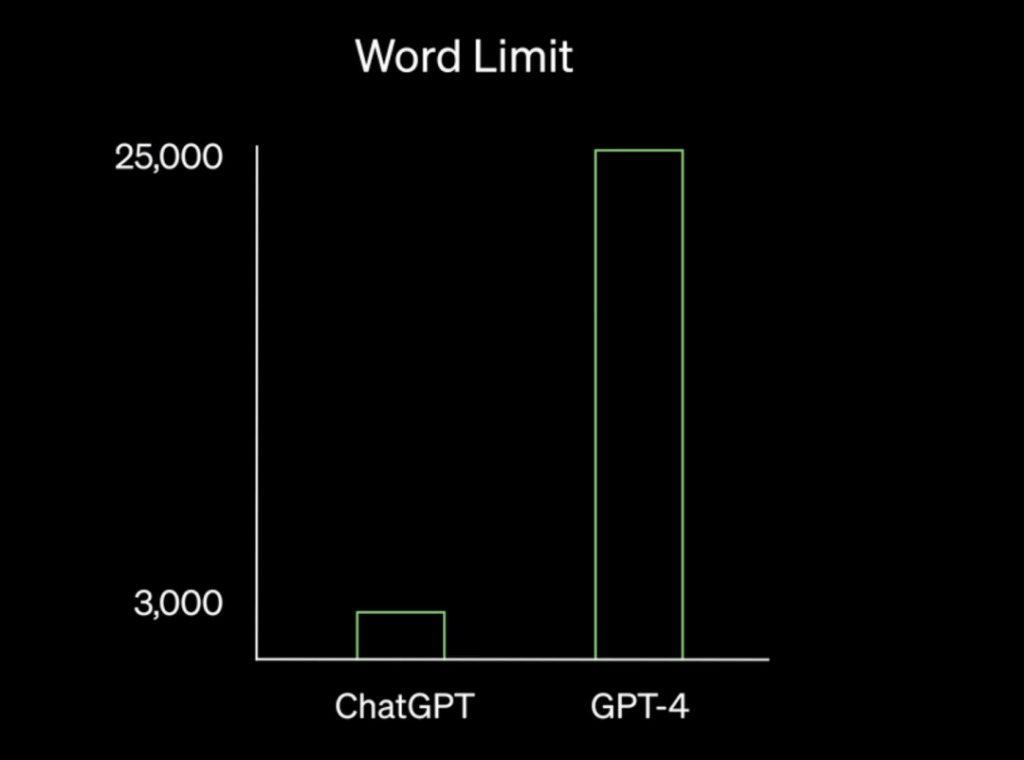

Selon OpenAI,GPT-4 est capable de traiter des textes de plus de 25 000 mots. Michael King, rédacteur chez Medium, a déclaré que cette fonctionnalité permet la création de contenu long, comme des articles et des blogs, ce qui peut faire gagner du temps et des ressources aux entreprises et aux particuliers.

De plus, le traitement de grandes quantités de texte par GPT-4 permet des conversations prolongées, ce qui signifie que dans des secteurs tels que le secteur des services, les chatbots IA peuvent fournir des réponses plus détaillées et plus perspicaces aux questions des clients. Parallèlement, cette fonctionnalité permet également une recherche et une analyse efficaces des documents, ce qui en fait un outil utile pour des secteurs tels que la finance, le droit et la santé.

Plus de capacité de raisonnement

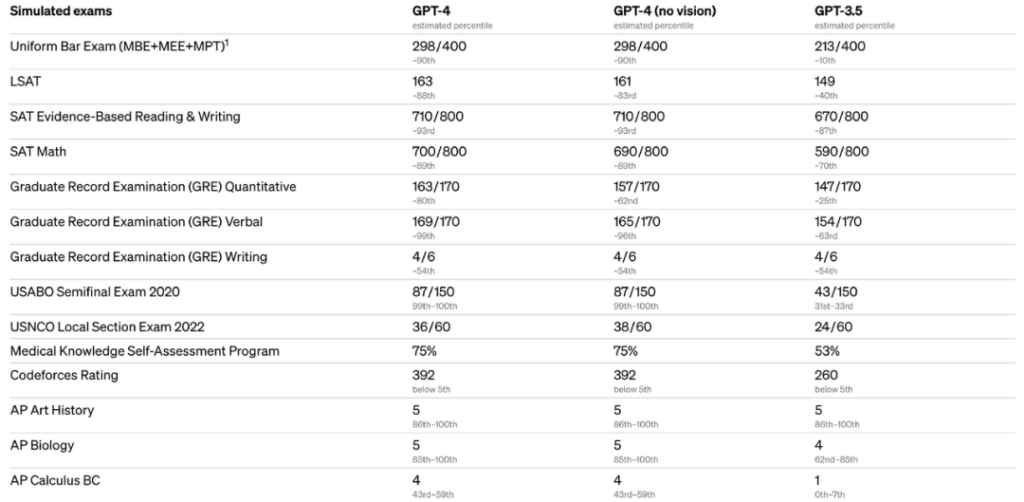

OpenAI a déclaré que les réponses générées par GPT-4 comportent moins d'erreurs et sont 40% plus précises que GPT-3.5. Dans le même temps, il n'y a pas beaucoup de différence entre GPT-3.5 et GPT-4 lors du chat, mais si la tâche est suffisamment complexe, GPT-4 est plus fiable, plus créatif et peut gérer des instructions plus subtiles que GPT-3.5. Il est rapporté que GPT-4 a participé à une variété de tests de référence.Parmi eux, les candidats qui ont obtenu un score supérieur à 88% à l'examen uniforme du barreau, au LSAT et à d'autres examens.

Nouvelle fonctionnalité intéressante : la multimodalité

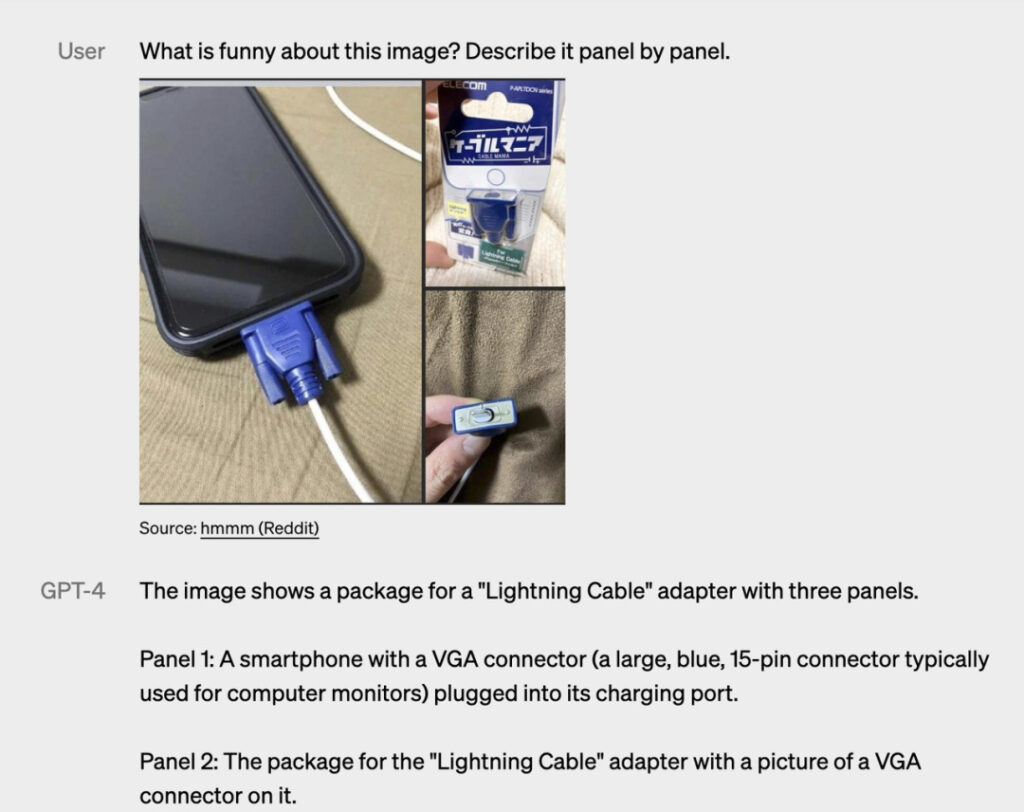

En plus de meilleures capacités de réponse,Une autre caractéristique remarquable de GPT-4 est qu’il peut accepter des entrées sous forme de texte et d’images.Les types d'images peuvent être des photos, des graphiques, des captures d'écran, etc. Par exemple, l'exemple suivant :

Question : Qu'est-ce qui est drôle dans cette image ? Décrivez-le point par point.

Réponse GPT-4 : L'image montre un adaptateur « Lightning Cable » contenant trois images.

Figure 1 : Un smartphone avec un connecteur VGA (un grand connecteur bleu à 15 broches couramment utilisé sur les écrans d’ordinateur) branché sur son port de charge.

Figure 2 : L’emballage de l’adaptateur « Lightning Cable », avec une image d’un connecteur VGA.

Figure 3 : Gros plan du connecteur VGA et, à l'extrémité, un petit connecteur Lightning (utilisé pour charger les iPhones et autres appareils Apple).

L'humour de cette image vient de l'absurdité de brancher un grand connecteur VGA obsolète sur un petit port de chargement de smartphone moderne.

Veuillez noter que cette fonctionnalité est toujours dans la version d'aperçu du chercheur.Il n'est pas ouvert au public.OpenAI n'a pas encore révélé quand il sera ouvert.

« Ce n’est pas parfait »

Lors de la présentation des nouvelles fonctionnalités de GPT-4, OpenAI a également reconnu certaines de ses limites. Comme avec les versions précédentes de GPT,Le GPT-4 présente toujours des problèmes tels que des biais sociaux, des hallucinations et des invites conflictuelles.En d’autres termes, GPT-4 n’est pas parfait pour le moment. Mais OpenAI a également déclaré qu’il s’agissait de problèmes pour lesquels ils s’efforçaient de les résoudre.

Modèles multimodaux : Google prend les devants dans la distribution d'amuse-gueules

Bien que la multimodalité soit un point fort de GPT-4, il faut dire queGPT-4 n’est pas le seul modèle multimodal.

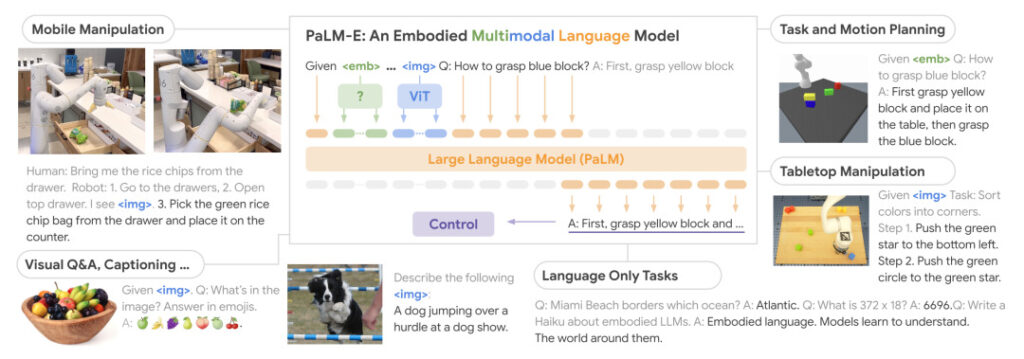

Holger Kenn, expert technique en IA chez Microsoft, a présenté le modèle dit multimodal, qui peut non seulement traduire du texte en images, mais également en audio et en vidéo. Plus tôt ce mois-ci,Google a publié le plus grand modèle de langage visuel de l'histoire - PaLM-E (Pathways Language Model with Embodied),Un modèle de langage multimodal intégré pour la robotique. PalM-E intègre le modèle de langage PaLM 540B et le modèle visuel ViT 22B, et possède ainsi 562B paramètres.

Les chercheurs ont mené une formation de bout en bout sur plusieurs tâches, notamment les règles de fonctionnement des robots, les réponses visuelles aux questions et le sous-titrage d'images. Les résultats de l’évaluation ont montré que le modèle peut résoudre efficacement diverses tâches de raisonnement et présenter un « transfert positif » sur différentes modalités d’observation et plusieurs entités. En plus d'être formé aux tâches robotiques, le modèle est également performant dans les tâches de langage visuel.

Dans l'exemple de démonstration, lorsqu'un humain donne la commande « Donne-moi les chips dans le tiroir », PaLM-E peut générer une commande d'action pour un robot équipé d'un bras robotique et exécuter l'action. Il le fait en analysant les données de la caméra du robot sans prétraiter la scène.

En plus de donner au robot les capacités ci-dessus, PaLM-E lui-même est également un modèle de langage visuel qui peut raconter des histoires basées sur des images ou répondre à des questions basées sur le contenu des images.

Le modèle multimodal est-il équivalent à la sortie de l’iPhone ?

Il semble désormais que l’ensemble du secteur de l’IA soit engagé dans une course aux armements en plein essor. Face à la popularité explosive de ChatGPT, Google a publié en urgence Bard pour continuer à le faire. Récemment, il a riposté en ouvrant sa propre API de modèle de langage de grande taille « PaLM API » et a également publié un outil MakerSuite pour aider les développeurs à créer rapidement des programmes d'IA.

Bien que le PDG d'OpenAI, Sam Altman, soit resté mystérieux sur la date de sortie de GPT-4 dans une interview il n'y a pas longtemps, affirmant que « nous voulons nous assurer qu'il est sûr et responsable lors de sa sortie », l'émergence soudaine de GPT-4Il est inévitable que les gens se demandent si c’est à cause des contre-attaques et des encerclements constants de géants comme Google que l’entreprise est obligée d’accélérer son rythme.

Il convient de noter que Sam a également mentionné un point dans l’interview.La prochaine étape évolutive de l’intelligence artificielle est l’arrivée de grands modèles multimodaux.« Je pense que cela va devenir une tendance majeure… Plus généralement, ces modèles puissants vont devenir l’une des véritables nouvelles plateformes technologiques que nous n’avons plus connues depuis le mobile. »

Reste à savoir si la sortie à succès de GPT-4 marquera l'arrivée officielle de l'ère des modèles multimodaux, mais ses puissantes capacités ont commencé à inquiéter de nombreux développeurs et même des gens ordinaires quant à savoir s'ils seront remplacés par lui. Peut-être que les déclarations publiques faites il y a quelques jours par Marianne Janik, PDG de Microsoft Allemagne, peuvent servir de réponse à cette question. Elle estime que le développement actuel de l’IA est comparable à l’émergence de l’iPhone. Dans le même temps, elle a également précisé queIl ne s’agit pas de remplacer des emplois, mais d’accomplir des tâches répétitives d’une manière différente qu’auparavant.

「Le changement entraînera une modification des modèles de travail traditionnels, mais nous devons également constater que ce changement a ajouté de nombreuses nouvelles possibilités et que, par conséquent, de nouvelles carrières passionnantes émergeront."

Liens de référence :

[1]https://openai.com/research/gpt-4

[2]https://venturebeat.com/ai/openai-releases-highly-anticipated-gpt-4-model-in-surprise-announcement/

[3] https://palm-e.github.io/

[4]https://medium.com/@neonforge