Command Palette

Search for a command to run...

DeepMind Lance DreamerV3, Un Algorithme d'apprentissage Par Renforcement Général Qui Peut Apprendre À Ramasser Des Diamants

Minecraft n'est pas seulement joué par des humains. La célèbre société de technologie d'IA DeepMind a également développé une IA dédiée pour jouer à Minecraft !

Contenu en un coup d'œil :L’apprentissage par renforcement est un produit interdisciplinaire dont l’essence est de parvenir à une prise de décision automatique et continue. Cet article présentera les derniers résultats de recherche et développement de DeepMind : DreamerV3, un algorithme général qui élargit le champ d’application de l’apprentissage par renforcement. Mots-clés:Apprentissage par renforcement Algorithme général DeepMind

Le 12 janvier, heure de Pékin, le compte Twitter officiel de DeepMind a publié :Dreamer V3 officiellement annoncé,Il s'agit du premier algorithme général capable de collecter des diamants à partir de zéro dans le jeu « Minecraft » sans se référer aux données humaines, résolvant ainsi un autre défi important dans le domaine de l'IA.

L'apprentissage par renforcement est un problème en termes d'évolutivité, et des algorithmes généraux sont nécessaires à son développement

L'apprentissage par renforcement permet aux ordinateurs de résoudre une tâche par interaction, comme AlphaGo battant des humains au jeu de Go et OpenAI Five battant des joueurs humains amateurs dans Dota 2.

Cependant, pour appliquer l'algorithme à de nouveaux scénarios d'application, comme le passage des jeux de société aux jeux vidéo ou aux tâches robotiques,Les ingénieurs sont tenus de développer en permanence des algorithmes spécialisés.Tels que le contrôle continu, les récompenses clairsemées, les entrées d'image et les environnements spatiaux.

Cela nécessite beaucoup d’expertise et de ressources informatiques pour affiner les algorithmes.Cela entrave considérablement l’expansion du modèle. La création d’algorithmes généraux capables d’apprendre et de maîtriser de nouveaux domaines sans réglage est devenue un moyen important d’élargir la portée des applications d’apprentissage par renforcement et de résoudre les problèmes de prise de décision.

C'est ainsi qu'est né DreamerV3, développé conjointement par DeepMind et l'Université de Toronto.

DreamerV3 : un algorithme général basé sur un modèle mondial

DreamerV3 est un algorithme général et évolutif basé sur le modèle mondial.Il peut être appliqué à un large éventail de domaines sous la prémisse d’hyperparamètres fixes et est meilleur que les algorithmes spécialisés.

Ces domaines comprennent l'action continue et l'action discrète, l'entrée visuelle et l'entrée de faible dimension, le monde 2D et le monde 3D, différents budgets de données, les fréquences de récompense et les échelles de récompense, etc.

DreamerV3 se compose de 3 réseaux neuronaux entraînés simultanément à partir d'expériences rejouées sans partage de gradients :

1. Modèle mondial :Prédire les résultats futurs des actions potentielles

2. Critique :Déterminer la valeur de chaque cas

3. Acteur: Apprenez à rendre possibles des situations précieuses

Comme le montre la figure ci-dessus, le modèle mondial encode l’entrée sensorielle dans une représentation discrète zt. zt est prédit par un modèle de séquence avec un état récurrent ht et une action donnée à. L'entrée est reconstruite en un signal d'apprentissage puis en une représentation de forme.

L’acteur et le critique apprennent de la trajectoire de représentation abstraite prédite par le modèle du monde.

Afin de mieux s'adapter aux tâches inter-domaines,Ces composants doivent s’adapter à différentes amplitudes de signaux et équilibrer de manière robuste les termes entre leurs objectifs.

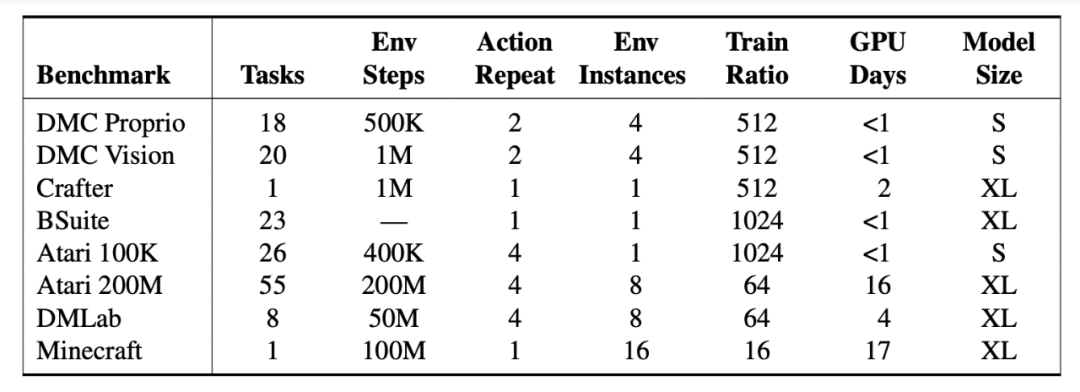

Les ingénieurs ont testé DreamerV3 sur plus de 150 tâches à paramètres fixes et les ont comparées aux meilleures méthodes enregistrées dans la littérature. Les expériences ont montré que DreamerV3 présente une grande polyvalence et une grande évolutivité pour les tâches dans différents domaines.

DreamerV3 a obtenu d'excellents résultats dans 7 benchmarks et a établi de nouveaux niveaux SOTA dans le contrôle continu de l'état et de l'image, BSuite et Crafter.

Cependant, DreamerV3 présente encore certaines limitations.Par exemple, lorsque les étapes de l'environnement sont inférieures à 100 millions, l'algorithme ne peut pas récupérer les diamants dans toutes les scènes comme les joueurs humains, mais seulement occasionnellement.

Debout sur les épaules de géants, retour sur l'histoire du développement de la famille Dreamer

Première génération : Dreamer

Heure de sortie :Décembre 2019

Institutions participantes :Université de Toronto, DeepMind, Google Brain

Adresse du document :https://arxiv.org/pdf/1912.01603.pdf

Introduction à l'algorithme :

Dreamer est un agent d'apprentissage par renforcement capable de résoudre des tâches à long terme à partir d'images en utilisant uniquement l'imagination latente.

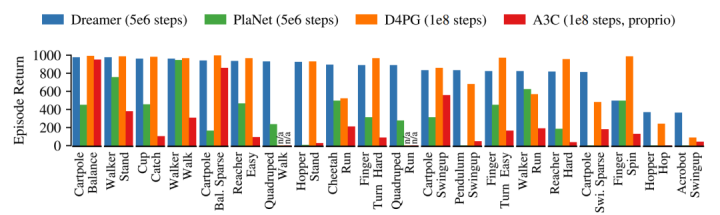

Il utilise le modèle mondial pour obtenir un apprentissage comportemental efficace basé sur la rétropropagation des prédictions du modèle. Au cours de 20 tâches de contrôle visuel difficiles, Dreamer a surpassé les méthodes dominantes en termes d'efficacité des données, de temps de calcul et de performances finales.

Dreamer hérite de l'efficacité des données de PlaNet tout en dépassant les performances asymptotiques du meilleur agent sans modèle du moment. Après 5×106 étapes d'environnement, la performance moyenne de Dreamer dans chaque tâche a atteint 823, tandis que celle de PlaNet n'était que de 332. L'agent D4PG sans modèle le plus élevé était de 786 après 108 étapes.

Deuxième génération : DreamerV2

Heure de sortie :Octobre 2020

Institutions participantes :Recherche Google, DeepMind, Université de Toronto

Adresse du document :https://arxiv.org/pdf/2010.02193.pdf

Introduction à l'algorithme :

DreamerV2 est un agent d'apprentissage par renforcement qui apprend les comportements à partir de prédictions dans un espace latent compact d'un modèle mondial.

Remarque : le modèle mondial utilise des représentations discrètes et est formé séparément de la politique.

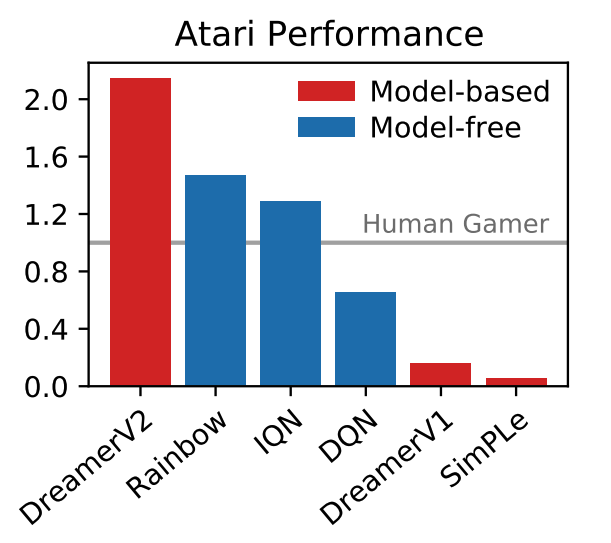

DreamerV2 est le premier agent à atteindre des performances de niveau humain sur 55 tâches du benchmark Atari en apprenant des comportements à partir d'un modèle mondial formé séparément. Avec le même budget de calcul et le même temps d'horloge, DreamerV2 atteint 200 millions d'images, surpassant les performances finales des meilleurs agents mono-GPU IQN et Rainbow.

De plus, DreamerV2 convient également aux tâches avec des actions continues. Il apprend un modèle mondial complexe d'un robot humanoïde et résout les problèmes de station debout et de marche uniquement grâce à une entrée de pixels.

Les utilisateurs de Twitter prennent l'initiative d'utiliser des mèmes dans la section des commentaires

Concernant la naissance de DreamerV3, de nombreux internautes ont également fait des blagues dans la section commentaires du Twitter de DeepMind.

Libérez l'humanité et n'ayez plus jamais à jouer à Minecraft.

Arrêtez de jouer à des jeux et faites quelque chose de réel ! @DeepMind et le PDG Demis Hassabis

Le BOSS ultime de "Minecraft", l'Ender Dragon, tremble.

Ces dernières années, le jeu « Minecraft » est devenu un centre de recherche sur l'apprentissage par renforcement, et des compétitions internationales autour de la collection de diamants dans « Minecraft » ont été organisées à de nombreuses reprises.

Résoudre ce défi sans données humaines est largement considéré comme une étape importante dans l’intelligence artificielle.En raison des obstacles liés aux récompenses rares, à l’exploration difficile et aux longues périodes de temps dans cet environnement de monde ouvert généré de manière procédurale, les méthodes précédentes doivent être basées sur des données humaines ou des tutoriels.

DreamerV3 est le premier algorithme qui a complètement appris à collecter des diamants dans Minecraft à partir de zéro.Cela élargit encore le champ d’application de l’apprentissage par renforcement.Comme l’ont dit les internautes, DreamerV3 est déjà un algorithme général mature. Il est temps d'apprendre à améliorer et à tuer des monstres par vous-même et à combattre le BOSS ultime, l'Ender Dragon !

Voir le lien original :DeepMind lance DreamerV3, un algorithme d'apprentissage par renforcement général qui peut apprendre à ramasser des diamants

Suivez HyperAI pour découvrir des algorithmes et des applications d’IA plus intéressants. Nous mettons également à jour régulièrement nos tutoriels, alors apprenons et améliorons-nous ensemble !