Command Palette

Search for a command to run...

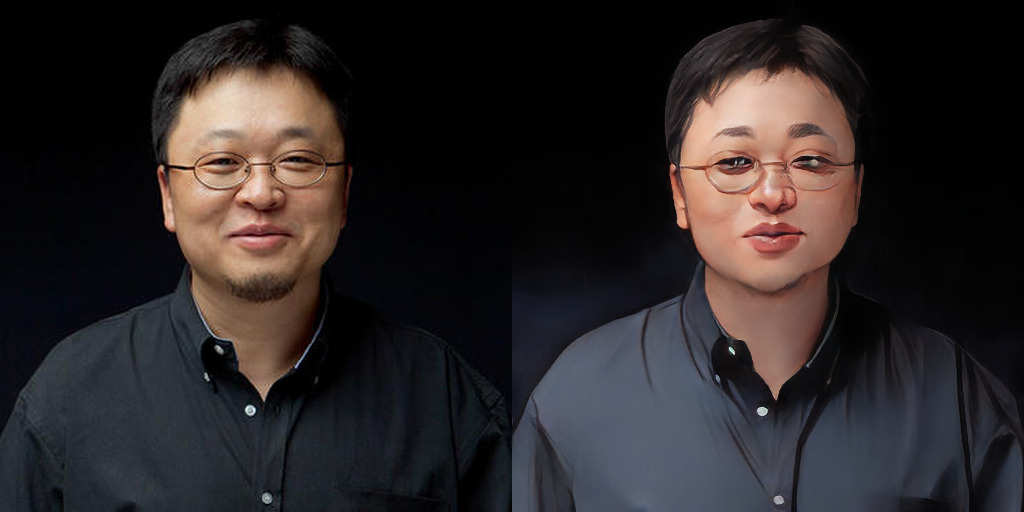

Transfert De Style Anime AnimeGANv2, Publié En Ligne Avec Une Démo

AnimeGANv2 a récemment publié une mise à jour développée par les contributeurs de la communauté.Une démo pouvant être exécutée en ligne est implémentée via Gradio et publiée sur huggingface.

accéder https://huggingface.co/spaces/akhaliq/AnimeGANv2

Vous pouvez facilement obtenir l'effet de traitement d'AnimeGANv2 en ligne (prend uniquement en charge le traitement d'image statique).

AnimeGAN : Tous les objets tridimensionnels deviennent bidimensionnels

AnimeGAN est une amélioration basée sur CartoonGAN et propose une architecture de générateur plus légère. En 2019, AnimeGAN a été ouvert pour la première fois et a suscité de vives discussions avec ses résultats extraordinaires.

Documents au moment de la publication initiale « AnimeGAN : un nouveau GAN léger pour l'animation photo »Trois nouvelles fonctions de perte sont également proposées dans cet article pour améliorer les effets visuels stylisés des animes.

Les trois fonctions de perte sont :Perte de style en niveaux de gris, perte contradictoire en niveaux de gris, perte de reconstruction des couleurs.

AnimeGANv2, sorti en septembre dernier, a optimisé le modèle et résolu certains problèmes de la version initiale d'AnimeGAN.

Dans la version 2, de nouveaux ensembles de données de formation de styles de bandes dessinées de trois dessinateurs, Makoto Shinkai, Hayao Miyazaki et Satoshi Kon, ont été ajoutés.

Prenons l'exemple de Musk : l'effet de la première génération d'AnimeGAN était déjà incroyable, mais il était trop juste et maladif, comme un membre d'un boys band coréen. En comparaison, la v2 est plus naturelle et plus en phase avec le tempérament réel.

Points forts de la mise à jour AnimeGANv2 :

– Le problème des artefacts à haute fréquence dans les images générées a été résolu ;

– la version v2 est plus facile à former et peut atteindre directement les résultats décrits dans le document ;

– Réduire encore davantage le nombre de paramètres du réseau de générateurs. (taille du générateur 8,17 Mo) ;

– Ajoutez davantage de données d’image de haute qualité.

Informations sur le projet

Exigences de configuration de l'environnement de version TensorFlow

- Python 3.6

- GPU tensorflow

- tensorflow-gpu 1.8.0 (ubuntu, GPU 1080Ti ou Titan xp, cuda 9.0, cudnn 7.1.3)

- tensorflow-gpu 1.15.0 (ubuntu, GPU 2080Ti, cuda 10.0.130, cudnn 7.6.0)

- opencv

- tqdm

- numpy

- globe

- argparse

Implémentation de PyTorch

Conversion de poids

git clone https://github.com/TachibanaYoshino/AnimeGANv2

python convert_weights.pyraisonnement

python test.py --input_dir [image_folder_path] --device [cpu/cuda]Colab à l'intérieur du mur

Projet GitHub

https://github.com/TachibanaYoshino/AnimeGANv2

Démo en ligne

https://huggingface.co/spaces/akhaliq/AnimeGANv2

Colab à l'intérieur du mur

https://openbayes.com/console/open-tutorials/containers/pROHrRgKItf