Command Palette

Search for a command to run...

Pas Le Temps De Regarder Des Films Ou Des Séries TV, l'IA Transforme Les Films Et Les Séries TV En Bandes Dessinées En Un Clic

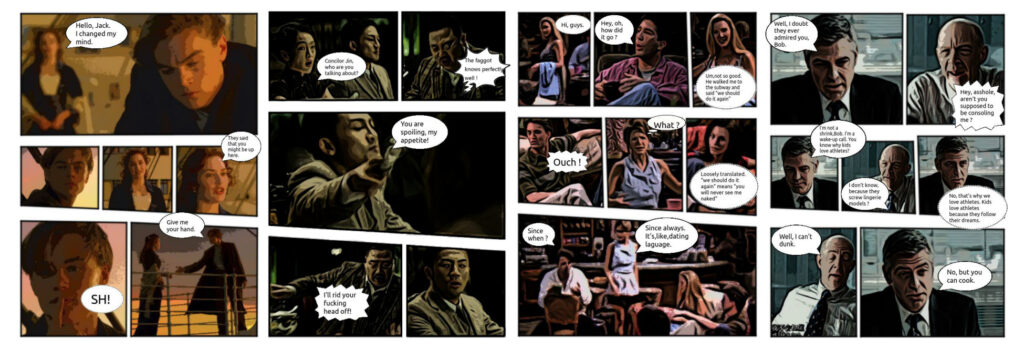

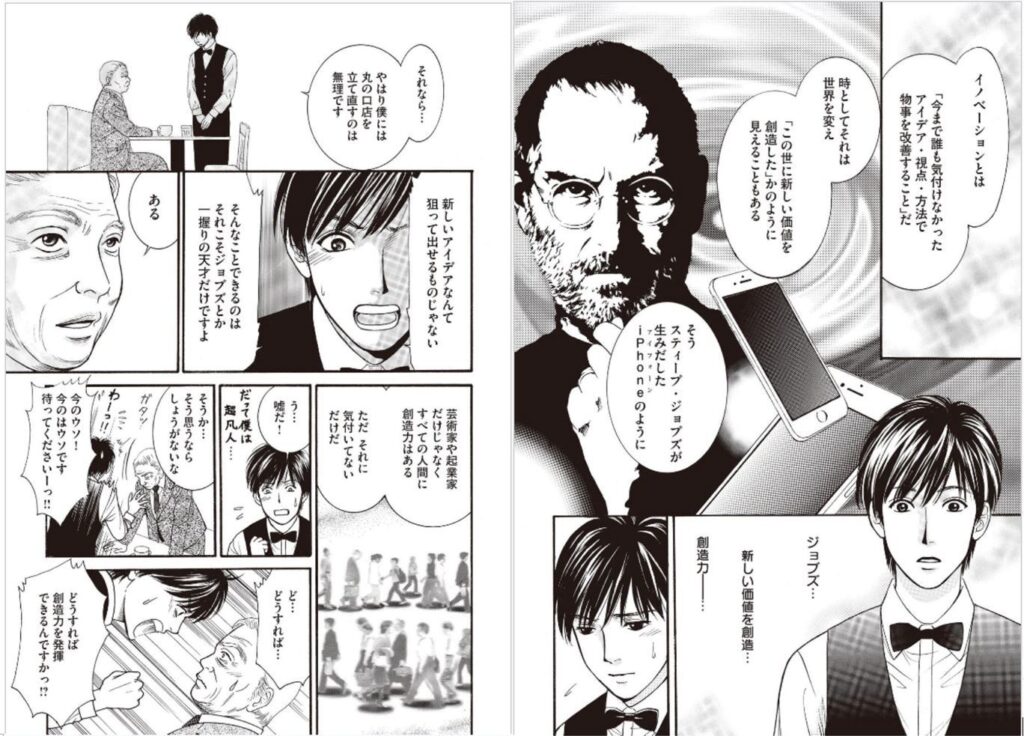

Quelle opération magique consiste à transformer un film ou une série télévisée en bande dessinée ? Une équipe de l'Université de technologie de Dalian et de l'Université de la ville de Hong Kong a récemment proposé un cadre d'IA capable de convertir automatiquement des films et des séries télévisées en bandes dessinées. Désormais, il existe une autre façon de regarder des films et des séries télévisées.

De nos jours, les films, les séries télévisées et diverses vidéos sont devenus une partie indispensable de nos vies. Il semblerait que la durée totale des vidéos téléchargées sur YouTube chaque jour prendrait plus de 82 ans à une personne pour les regarder.

Afin de gagner du temps lors du visionnage de séries télévisées, la lecture à vitesse 2x est devenue la norme pour le binge-watching de séries télévisées.En plus de regarder à deux fois plus vite, de manière saccadée, et d'écouter les commentaires des critiques de cinéma, il existe une autre façon de rattraper rapidement son retard sur les séries télévisées, qui est de transformer la série télévisée en bande dessinée.

Récemment, des chercheurs de l'Université de technologie de Dalian et de l'Université de la ville de Hong Kong ont publié une étude intéressante qui permet de générer automatiquement des images de séries télévisées, de films ou d'autres vidéos sous forme de bande dessinée et d'ajouter des bulles de texte.

« Comparé aux systèmes de génération de bandes dessinées de pointe, notre système peut synthétiser des bandes dessinées plus expressives et plus attrayantes », ont déclaré les chercheurs dans l'article. « À l’avenir, cette technologie sera étendue pour générer des bandes dessinées à partir d’informations textuelles. »

J’ai vu des adaptations de bandes dessinées, mais avez-vous déjà vu des « bandes dessinées adaptées » ?

Auparavant, des résultats de recherche similaires ont été obtenus dans l'industrie, proposant des systèmes automatisés pour convertir des vidéos en bandes dessinées, mais il y a encore place à l'amélioration en termes d'automatisation, d'effets visuels, de lisibilité, etc. Par conséquent, cette direction de recherche est encore pleine de défis.

Une équipe de l'Université de technologie de Dalian et de l'Université de la ville de Hong Kong a récemment publié un articleGénération automatique de bandes dessinées avec des mises en page multipages stylisées et des bulles de texte axées sur l'émotion.Une meilleure méthode est proposée dans .

Adresse de l'article : https://arxiv.org/abs/2101.11111

L’article propose un système de génération de bandes dessinées entièrement automatique.Pas besoinGrâce à des réglages manuels effectués par l'utilisateur, tout type de vidéo (séries télévisées, films, dessins animés) peut être généré en pages de bandes dessinées de haute qualité et les dialogues des personnages peuvent être convertis en texte à bulles.De plus, les bandes dessinées générées par le système ont des effets visuels riches et sont très lisibles.

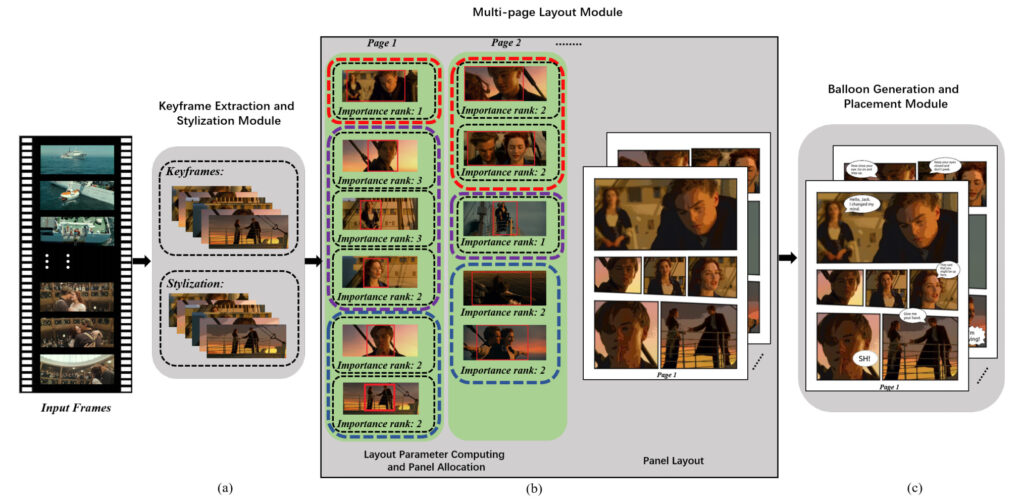

Trois modules, transformant des films et des séries télévisées en bandes dessinées

L’idée clé proposée dans cet article est queConcevez des systèmes de manière entièrement automatique sans aucun paramètre ni contrainte spécifié manuellement.Dans le même temps, l’équipe a introduit de manière sélective des interactions avec les utilisateurs pour rendre la conception plus personnalisée et diversifiée.

En général, le système comporte trois modules principaux :Sélection d'images clés et stylisation de bandes dessinées, génération de mise en page multipage, génération et placement de bulles de texte.

Module 1 : Extraction et stylisation d'images clés

L'entrée du système est une vidéo et ses sous-titres, qui contiennent des dialogues et des informations d'horodatage de début et de fin correspondantes.

Ils ont d’abord sélectionné une image de la vidéo originale toutes les 0,5 seconde, puis ont utilisé les informations temporelles dans les sous-titres et la similarité entre deux images consécutives pour sélectionner des images clés informatives. Enfin, les images clés sont stylisées, c'est-à-dire que les images ordinaires sont converties en images de style bande dessinée.

Extraction d'images clés

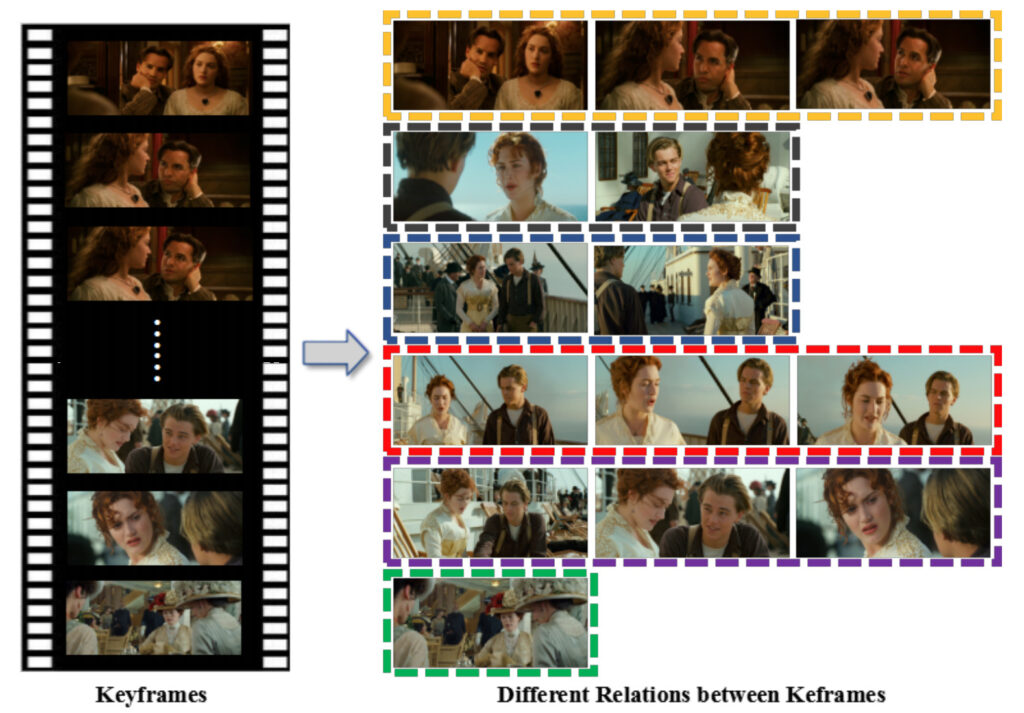

La sélection des images clés est une tâche particulièrement importante et difficile. L’équipe utilise principalement des informations temporelles pour effectuer la sélection.

Comme le montre la figure ci-dessus, l’équipe a d’abord utilisé l’heure de début et de fin de chaque sous-titre pour diviser la vidéo en plusieurs prises. Ces plans sont divisés en deux types : les plans dialogués (plans avec sous-titres) et les plans sans dialogue (plans sans sous-titres).

Pour les plans de dialogue :Le système calcule la similarité GIST entre deux images consécutives obtenues précédemment (si la similarité GIST est faible, la différence entre les deux images est grande).

Pendant l'exécution, si la similarité est inférieure à la valeur seuil prédéfinie ?1, alors l'image suivante sera sélectionnée comme image clé.Si aucune des images correspondant à un groupe de sous-titres n'est sélectionnée, l'image du milieu est sélectionnée comme image clé.

Considérant qu’un dialogue continu et une même scène peuvent correspondre à plusieurs sous-titres, l’équipe a calculé la similarité GIST entre les images clés consécutives obtenues précédemment. Si la similarité est supérieure au seuil défini ?2, ils sont considérés comme appartenant à la même scène. Ensuite, conservez simplement l’une des images clés et fusionnez les sous-titres.

De plus, dans le même ensemble de sous-titres, le système peut sélectionner plusieurs images clés car après calcul, il peut être constaté que ces images clés ont des relations sémantiques et ces images clés seront utilisées pour la mise en page multipage.

Pour les prises de vue sans dialogue :Les images les moins identiques aux images de la prise de vue actuelle sont sélectionnées en premier. Afin de réduire la redondance des images sélectionnées, le système calculera la similarité GIST entre cette prise de vue et l'image clé précédemment sélectionnée. Ce n'est que lorsqu'il est inférieur au seuil précédemment défini qu'il sera sélectionné comme image clé.

Enfin, les ensembles de sous-titres sont regroupés en comparant les horodatages de début et les horodatages des images clés. Tous les sous-titres qui se situent dans la plage d'horodatage de début et de fin d'une image clé seront collectés ensemble.

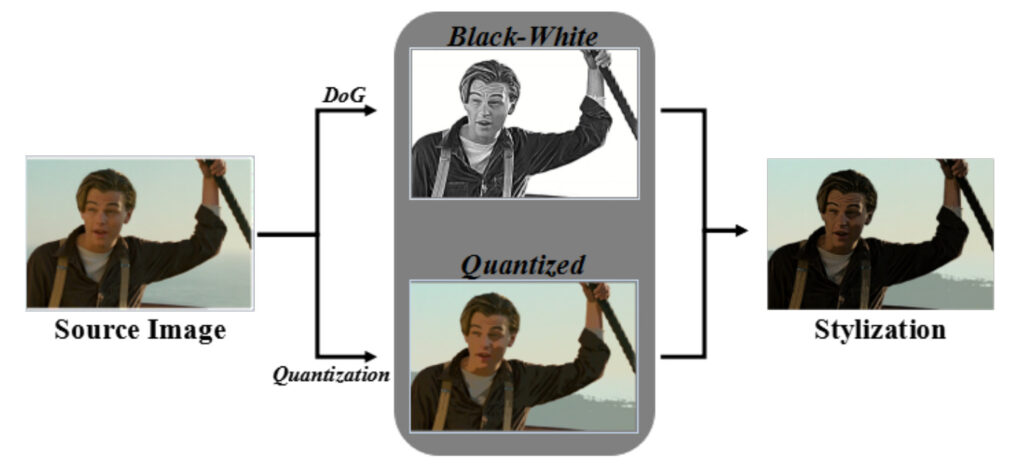

Image stylisée

L’équipe a utilisé une méthode de différence gaussienne étendue pour convertir les images sources en noir et blanc. Après le repas, une quantification des couleurs à 128 niveaux est effectuée pour obtenir l'image quantifiée et réaliser une stylisation des couleurs. C'est ainsi, une série de prises de vue réelles de films transformées en bande dessinée.

Module 2 : Mise en page multipage

L'équipe a proposé un cadre de mise en page multipage pour allouer et organiser automatiquement les mises en page tout en présentant des effets visuels plus riches.

Dans ce module, nous devons d'abord calculer quatre facteurs clés pour guider la génération de mises en page multipages, notamment : la région d'intérêt (ROI) des images clés, le niveau d'importance des images clés, la relation sémantique entre les images clés et le nombre de panneaux sur une page.

L'équipe a ensuite proposé une méthode d'attribution de panneaux basée sur l'optimisation pour attribuer des images clés à une séquence de pages et a utilisé une méthode de synthèse de mise en page de bande dessinée basée sur les données pour générer la mise en page de chaque page.

Les amis qui suivent les bandes dessinées savent que le nombre d’images sur chaque page d’une bande dessinée n’est pas fixe. Afin d'offrir aux lecteurs une meilleure expérience de lecture, les dessinateurs organiseront le nombre d'images en fonction de l'intrigue.

Dans cette étude, l’équipe a traité ce problème comme un problème d’optimisation globale pour compléter l’allocation de chaque plan dans la page de bande dessinée.

Module 3 : Génération et placement de bulles de texte

Générer des bulles de texte

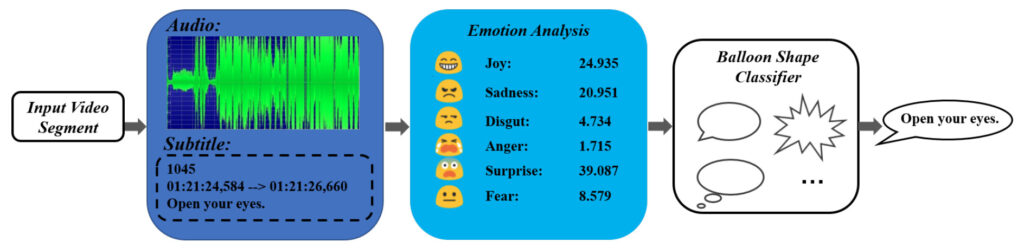

Habituellement, dans les bandes dessinées, l'auteur choisit différentes formes de bulles pour les dialogues dans différentes situations et émotions, ce qui est très important pour exprimer le contenu des bandes dessinées. Cependant, les études existantes sur le sujet n’utilisent généralement que des formes de bulles elliptiques de base, qui ne sont pas suffisamment riches pour l’expression émotionnelle.

Un résultat important proposé dans cet article est une méthode de génération de bulles basée sur la perception des émotions, qui peut utiliser des informations vidéo, audio et de sous-titres contenant des émotions pour générer des formes de bulles de texte qui leur conviennent.

Dans ce système, l’auteur a adopté trois formes de bulles courantes : les bulles ovales, les bulles de pensée et les bulles dentelées. Les trois types de bulles conviennent aux émotions suivantes : les émotions calmes, les pensées (non exprimées) et les émotions fortes.

Pour la formation du classificateur de bulles, l'équipe a principalement utilisé des vidéos d'anime et des bandes dessinées correspondantes pour collecter des données sur les émotions audio, les émotions des sous-titres et les types de bulles.

Positionnement et placement des bulles

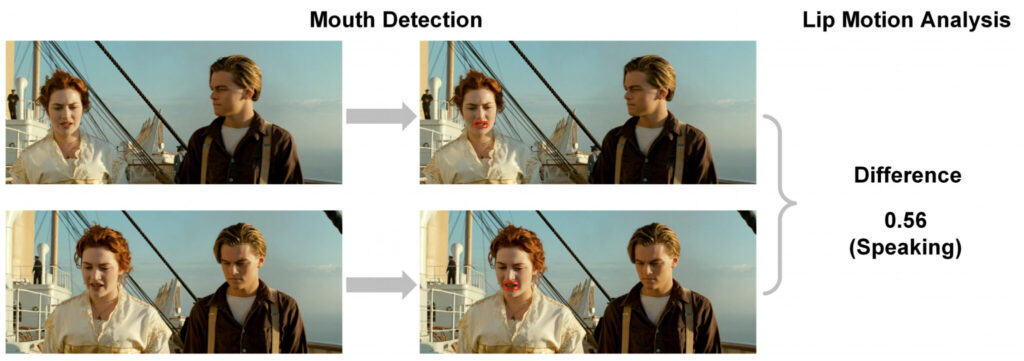

Similaire à la méthode précédente, cet article utilise également la détection du locuteur et la détection du mouvement des lèvres pour obtenir la position de la personne qui parle dans un cadre, puis place le ballon près de la personne à laquelle il appartient.

Le processus d’exécution spécifique est le suivant :

- Tout d’abord, utilisez la bibliothèque Python de détection de visage « Dlib » pour détecter la bouche de chaque personnage dans un cadre ;

- Ensuite, l'analyse du mouvement des lèvres est utilisée pour calculer la différence quadratique moyenne des valeurs de pixels de la zone de la bouche entre deux images consécutives. La différence est calculée sur la zone de recherche autour de la bouche dans l'image actuelle pour déterminer si les lèvres bougent ;

- Enfin, définissez un seuil pour déterminer si un personnage parle.

Une fois que vous avez l'emplacement de l'orateur, placez la bulle de texte à proximité, avec la queue de la bulle pointant vers la bouche de l'orateur.

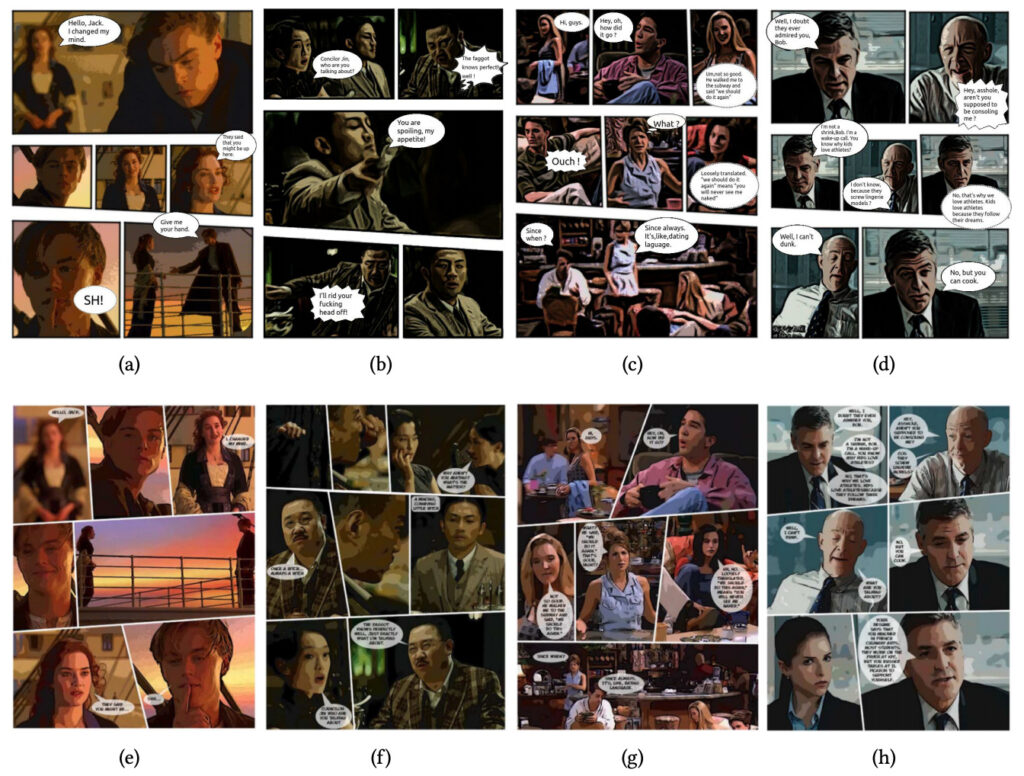

Utilisez quatre films classiques pour évaluer l’effet du système

Pour tester le modèle, l’équipe a saisi 16 extraits de quatre films différents : Titanic, The Message, Friends et Up in the Air.

La durée des vidéos d’entrée variait de 2 à 6 minutes, et chaque clip contenait une partie avec un dialogue.

Pour chaque clip, l'équipe a enregistré le temps nécessaire pour générer une bande dessinée à l'aide du système et a calculé le temps moyen nécessaire pour évaluer les performances du système.

Les auteurs ont conclu que la méthode de cette étude est supérieure aux autres méthodes par rapport aux méthodes précédentes. Cela se reflète principalement dans les trois aspects suivants :

- Premièrement, le système peut générer des formes de bulles plus riches pour les conversations, alors que les méthodes existantes n’utilisent que de simples bulles de mots elliptiques ;

- Deuxièmement, en utilisant la méthode de résumé de texte, certains sous-titres connexes sont fusionnés, ce qui peut garantir que les phrases dans les bulles de texte ne sont pas trop longues et améliorer la lisibilité ;

- Troisièmement, en obtenant automatiquement quatre paramètres importants, une mise en page multipage entièrement automatique est obtenue (les méthodes précédentes étaient principalement semi-automatiques et nécessitaient une intervention manuelle), et les résultats de mise en page sont raisonnables et riches.

Pour éviter toute interférence due à des facteurs subjectifs, l'équipe a également recruté 40 volontaires via Amazon Mechanical Turk pour comparer les résultats générés par l'équipe avec ceux générés par d'autres systèmes similaires.

Les volontaires ont d’abord regardé la vidéo originale, puis ont lu les bandes dessinées générées par différentes méthodes et ont donné une évaluation de l’effet. Pour éviter tout biais subjectif, les vidéos et les dessins animés correspondants ont été disposés de manière aléatoire.

Le résultat final a été que le système a reçu de meilleures notes que les autres méthodes, que les volontaires aient ou non déjà vu les vidéos.

Générer des bandes dessinées en un clic, que pouvez-vous faire d'autre ?

Bien qu'il ait reçu des critiques positives de la part des utilisateurs, le système n'est certainement pas parfait et il reste encore quelques problèmes à résoudre.

Par exemple, lors de la sélection d'images clés, il peut toujours y avoir une situation où la similarité est trop élevée, ce qui entraînera une redondance dans l'image.

De plus, si la vidéo d’entrée ne comporte pas de sous-titres, le système doit d’abord extraire les lignes par reconnaissance vocale avant de générer les bandes dessinées. Cependant, les résultats de la reconnaissance vocale sont souvent sujets à des erreurs, ce qui constitue également un défi pour le système. Cependant, l'équipe a déclaré qu'elle pensait qu'avec les progrès continus de la technologie de reconnaissance vocale, ce problème serait résolu à l'avenir.

À l’avenir, lorsque cette technologie sera suffisamment mature, de nombreuses œuvres vidéo disposeront d’un moyen supplémentaire de les ouvrir. « Regarder » un film sous forme de bande dessinée peut apporter plus d’espace à l’imagination des lecteurs.

De plus, les gens ordinaires peuvent facilement convertir des vidéos en bandes dessinées sans avoir aucune compétence en peinture. Cela pourrait devenir un nouvel outil de divertissement de masse, tout comme l'application Prisma qui peut convertir des photos en images de style peinture.

L’équipe prévoit également d’étendre cette méthode pour générer des bandes dessinées à l’aide d’informations textuelles à l’étape suivante. En d'autres termes, tant que le script de la bande dessinée est fourni, le système peut générer automatiquement des bandes dessinées, ce qui permet aux dessinateurs de gagner beaucoup de temps.