Command Palette

Search for a command to run...

L'équipe Huake a Publié l'ensemble De Données De Référence De Segmentation d'instances Vidéo Occluses OVIS

La segmentation d’instance peut être largement utilisée dans divers scénarios d’application. En tant qu’axe de recherche important dans le domaine de la vision par ordinateur, il est également très difficile et stimulant. Cependant, en raison de l’occlusion dans de nombreuses scènes, la segmentation des instances devient un problème difficile. Récemment, des chercheurs de l'Université Huazhong, d'Alibaba et d'autres institutions ont proposé un ensemble de données de segmentation d'instances vidéo occultées à grande échelle OVIS pour résoudre ce problème.

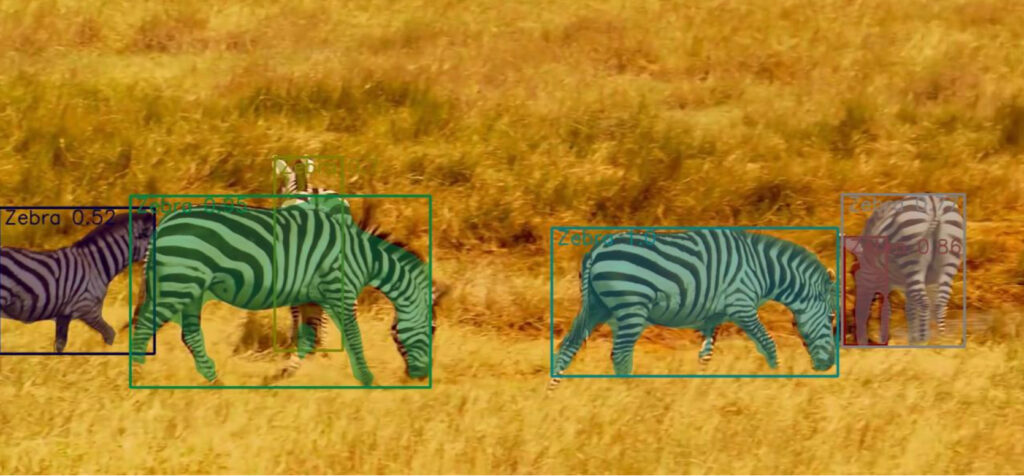

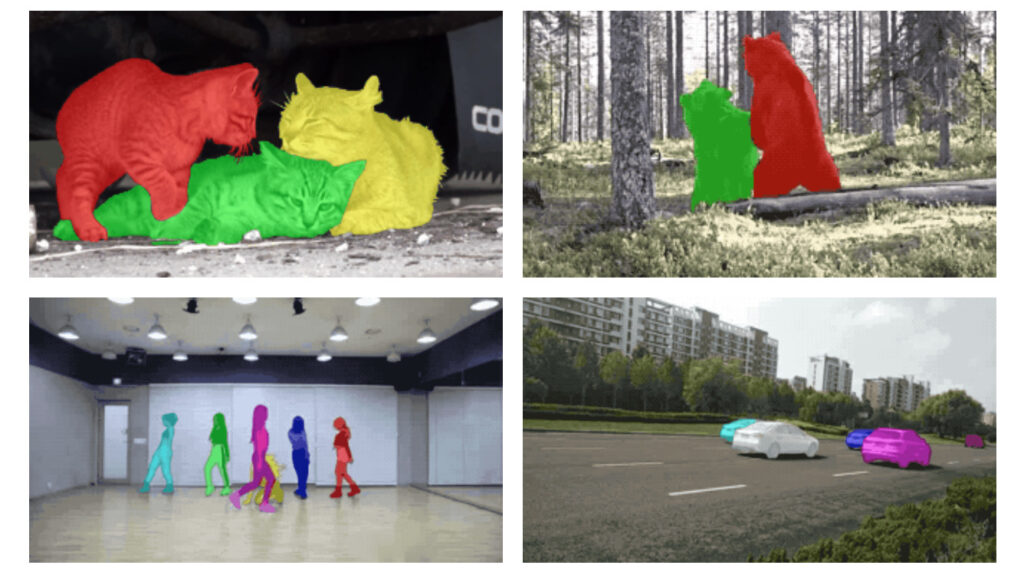

En vision par ordinateur, la détection d'objets est le problème le plus important et la segmentation des instances est considérée comme la tâche la plus difficile dans la détection d'objets. La segmentation d'instance consiste à segmenter les pixels d'un objet en fonction de la détection de la cible.

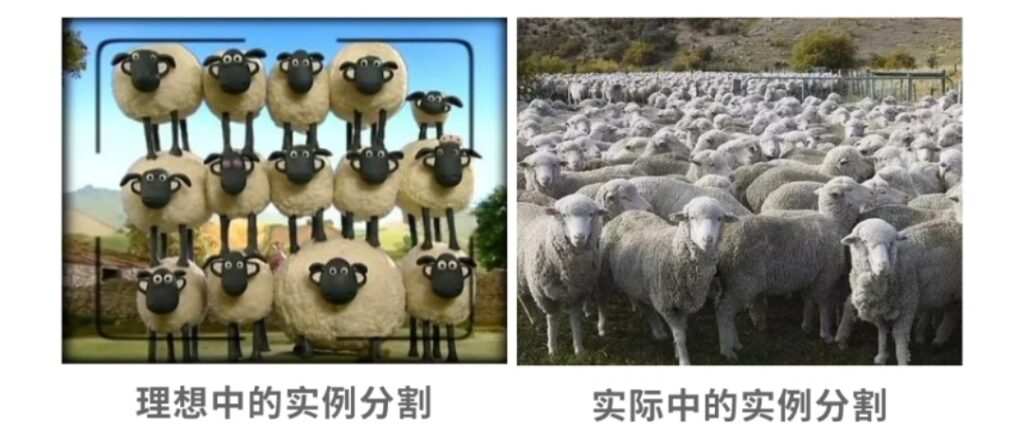

Les objets se bloquent souvent les uns les autres, ce qui est devenu un casse-tête pour les ingénieurs. Lorsque nous, les humains, voyons des objets obscurcis, nous pouvons les identifier par l’expérience ou par association.

Alors, en vision par ordinateur, est-il possible d’identifier avec précision les objets occultés comme les humains ? Dans le domaine de la recherche sur la segmentation des instances, la résolution des interférences causées par l'occlusion a toujours été une direction de recherche importante.

Pour résoudre ce problème, des équipes de l'Université des sciences et technologies de Huazhong, d'Alibaba, de l'Université Cornell, de l'Université Johns Hopkins et de l'Université d'Oxford,Un ensemble de données à grande échelle OVIS (Occluded Video Instance Segmentation) pour la segmentation des instances vidéo occluses est collecté, qui peut être utilisé pour détecter, segmenter et suivre simultanément les instances dans les scènes occluses.

Il s'agit du deuxième ensemble de données de segmentation d'instances vidéo occluses à grande échelle après l'ensemble de données Google YouTube-VIS.

OVIS : Né de 901 vidéos gravement obstruées

Pour tout ce que nous voyons dans notre vie quotidienne, il y a très peu d’objets qui apparaissent isolément, et il y a plus ou moins d’occlusion. Cependant, les recherches montrent que le système visuel humain peut toujours distinguer les limites réelles de l'objet cible en cas d'occlusion, mais pour le système de vision par ordinateur, cela devient un gros problème, à savoir le problème de segmentation de l'instance vidéo occluse.

Afin d'explorer et de résoudre davantage ce problème, des équipes de l'Université des sciences et technologies de Huazhong, d'Alibaba et d'autres institutions ont tenté de développer un meilleur modèle basé sur l'algorithme de segmentation d'instance open source d'origine.

Pour réaliser ce travail, l’équipe a d’abord collecté l’ensemble de données OVIS, spécialement conçu pour la segmentation des instances vidéo dans les scènes occultées. Dans un article récemment publié« Segmentation d'instances vidéo occluses »Cet ensemble de données est présenté en détail.

Adresse du document : https://arxiv.org/pdf/2102.01558.pdf

Pour collecter cet ensemble de données,L'équipe a collecté près de 10 000 vidéos au total et a finalement sélectionné 901 clips présentant une occlusion sévère, beaucoup de mouvement et des scènes complexes. Chaque vidéo comportait au moins deux objets cibles qui s'occultaient mutuellement.

La plupart des vidéos ont une résolution de 1920×1080 et une durée comprise entre 5s et 60s. Ils ont effectué une annotation de haute qualité à une densité d'une image pour cinq images et ont finalement obtenu l'ensemble de données OVIS.

OVIS contient un total de 296 000 annotations de masque de haute qualité de 5 223 objets cibles.Par rapport au précédent ensemble de données Google Youtube-VIS avec 4883 objets cibles et 131 000 masques, OVIS a évidemment plus d'objets cibles et d'annotations de masque.

Cependant, OVIS utilise en réalité moins de vidéos que YouTube-VIS, car la philosophie de l'équipe privilégie les vidéos plus longues pour permettre des capacités de suivi à long terme. La durée moyenne de la vidéo et la durée moyenne de l'instance d'OVIS sont respectivement de 12,77 s et 10,55 s, tandis que celles de YouTube-VIS sont respectivement de 4,63 s et 4,47 s.

Afin de rendre la tâche de segmentation des instances vidéo occluses plus difficile, l'équipe a sacrifié un certain nombre de segments vidéo et annoté des vidéos plus longues et plus complexes.

L'ensemble de données OVIS contient 25 catégories courantes dans la vie.Comme le montre la figure ci-dessous, les catégories spécifiques comprennent : les personnes, les poissons, les véhicules, les chevaux, les moutons, les zèbres, les lapins, les oiseaux, la volaille, les éléphants, les motos, les chiens, les singes, les bateaux, les tortues, les chats, les vaches, les perroquets, les vélos, les girafes, les tigres, les pandas géants, les avions, les ours et les lézards.

Ces catégories ont été choisies sur la base des trois considérations suivantes :

- Ces cibles sont souvent en mouvement et sont plus susceptibles d’être gravement occultées ;

- Ils sont très courants dans la vie ;

- Ces catégories présentent un chevauchement élevé avec les ensembles de données de segmentation d'instances d'images à grande échelle actuellement populaires (tels que MS COCO, LVIS, Pascal VOC, etc.), ce qui permet aux chercheurs de migrer facilement les modèles et de réutiliser les données.

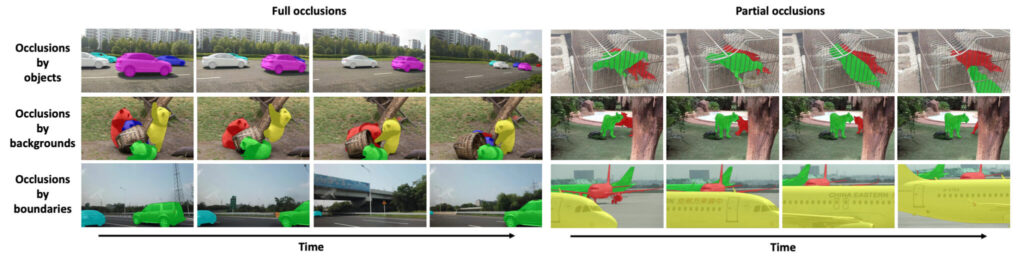

Par rapport aux autres ensembles de données VIS précédents,La caractéristique la plus notable de l’ensemble de données OVIS est qu’une grande partie des objets sont gravement occultés en raison de divers facteurs.Par conséquent, OVIS est un banc d’essai efficace pour évaluer les modèles de segmentation d’instances vidéo traitant des occlusions sévères.

Afin de quantifier la gravité de l'occlusion, l'équipe a proposé un indicateur de taux de chevauchement moyen de la boîte englobante (mBOR) pour refléter approximativement le degré d'occlusion. mBOR fait référence au rapport entre la surface des boîtes englobantes qui se chevauchent et la surface de toutes les boîtes englobantes de l'image. À partir de la liste de comparaison des paramètres, nous pouvons voir qu'OVIS présente une occlusion plus grave que YouTube-VIS.

Les détails de l'ensemble de données OVIS sont les suivants :

Segmentation des instances vidéo occluses

Ensemble de données de segmentation d'instances vidéo d'occlusion

Source des données :« Segmentation d'instances vidéo occluses »

Quantité incluse :5223 objets cibles, 296 000 masques

Nombre de types :25 types

Format des données :Cadre : jpg ; Commentaire : Json

Résolution vidéo :1920 × 1080 Taille des données :12,7 Go

Adresse de téléchargement :https://orion.hyper.ai/datasets/14585

OVIS propose une référence plus élevée pour la segmentation des instances vidéo

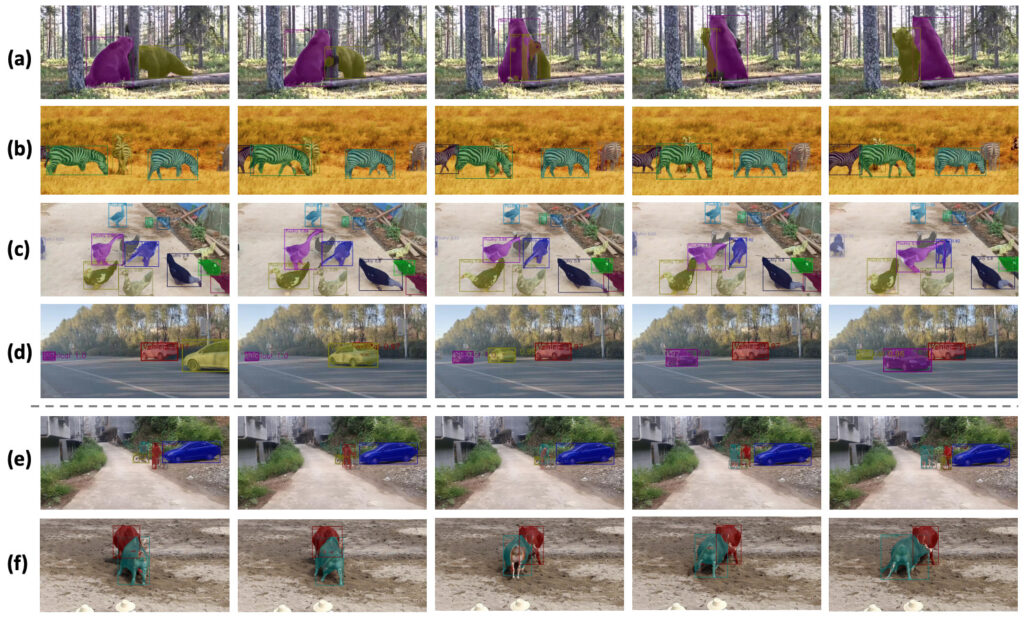

L'ensemble de données OVIS est divisé aléatoirement en 607 vidéos de formation, 140 vidéos de validation et 154 vidéos de test. L'équipe a mené une évaluation complète de cinq algorithmes de segmentation d'instances vidéo open source existants sur OVIS, qui ont également servi de référence pour les performances de base de l'ensemble de données OVIS.

Les résultats de l’évaluation sont présentés dans le tableau suivant :

Par rapport à YouTube0-VIS, les performances des cinq algorithmes, FEELVOS, IoUTracker+, MaskTrack R-CNN, SipMask et STEm-Seg, sur OVIS ont chuté d'au moins 50%.Par exemple, l'AP de SipMask passe de 32,5 à 12,1, tandis que celui de STEm-Seg passe de 30,6 à 14,4. Ces résultats rappellent aux chercheurs qu’une attention accrue doit être accordée au problème de la segmentation des instances vidéo.

De plus, l’équipe a considérablement amélioré les performances de l’algorithme d’origine en utilisant un module d’étalonnage.Le CMaskTrack R-CNN développé par lui a amélioré l'AP de l'algorithme original MaskTrack R-CNN de 2,6, de 12,6 à 15,2, et CSipMask a amélioré l'AP de SipMask de 2,9, de 12,1 à 15,0.

Dans la figure (c) ci-dessus, dans une scène bondée de canards, la méthode de l’équipe a presque correctement détecté et suivi tous les canards, mais la détection du canard le plus à gauche dans la deuxième image a échoué. Cependant, dans une image ultérieure, le canard a été suivi à nouveau, démontrant que le modèle de l’équipe capturait bien les indices temporels.

L'équipe a ensuite évalué ses algorithmes CMaskTrack R-CNN et CSipMask proposés sur l'ensemble de données YouTube-VIS, et les résultats ont montré qu'ils surpassaient les méthodes originales en termes d'AP.

Applications futures : segmentation de panoramas vidéo, données d'occlusion synthétiques

L'équipe a déclaré que les performances de base des algorithmes de segmentation vidéo couramment utilisés sur OVIS sont bien inférieures à celles de YouTube-VIS, ce qui indique qu'à l'avenir, les chercheurs devraient investir plus d'énergie dans le traitement des objets vidéo occultés.

De plus, l’équipe a exploré des moyens de résoudre les problèmes d’occlusion en exploitant des indices contextuels temporels. À l’avenir, l’équipe formalisera la piste expérimentale d’OVIS dans des scénarios de segmentation d’objets vidéo dans des environnements non supervisés, semi-supervisés ou interactifs. De plus, il est également crucial d'étendre OVIS à la segmentation panoramique vidéo (Remarque : la segmentation panoramique vidéo vise à réaliser à la fois la segmentation sémantique de l'arrière-plan et la segmentation d'instance du premier plan, ce qui est une nouvelle tendance récente dans le domaine de la segmentation d'instance).

De plus, les données d’occlusion synthétiques constituent également une direction que l’équipe doit explorer davantage. L'équipe a déclaré qu'elle pensait que l'ensemble de données OVIS déclencherait davantage de recherches sur la compréhension des vidéos dans des scénarios complexes et divers.

Cette technologie jouera un rôle important dans la séparation des personnages et des arrière-plans dans les effets spéciaux du cinéma et de la télévision, les courtes vidéos et les diffusions en direct à l’avenir.

Références :

Adresse du document : https://arxiv.org/pdf/2102.01558.pdf

Site officiel du projet : http://songbai.site/ovis/

Ensemble de données Google YouTube-VIS :