Command Palette

Search for a command to run...

Au-delà De PyTorch Et TensorFlow, Ce Framework Domestique a Quelque Chose

Il existe déjà de nombreux frameworks d’apprentissage profond, pourquoi avons-nous besoin de OneFlow ? Dans le domaine de l’apprentissage automatique, Yuan Jinhui a une vision à plus long terme que quiconque au sein du 90%.

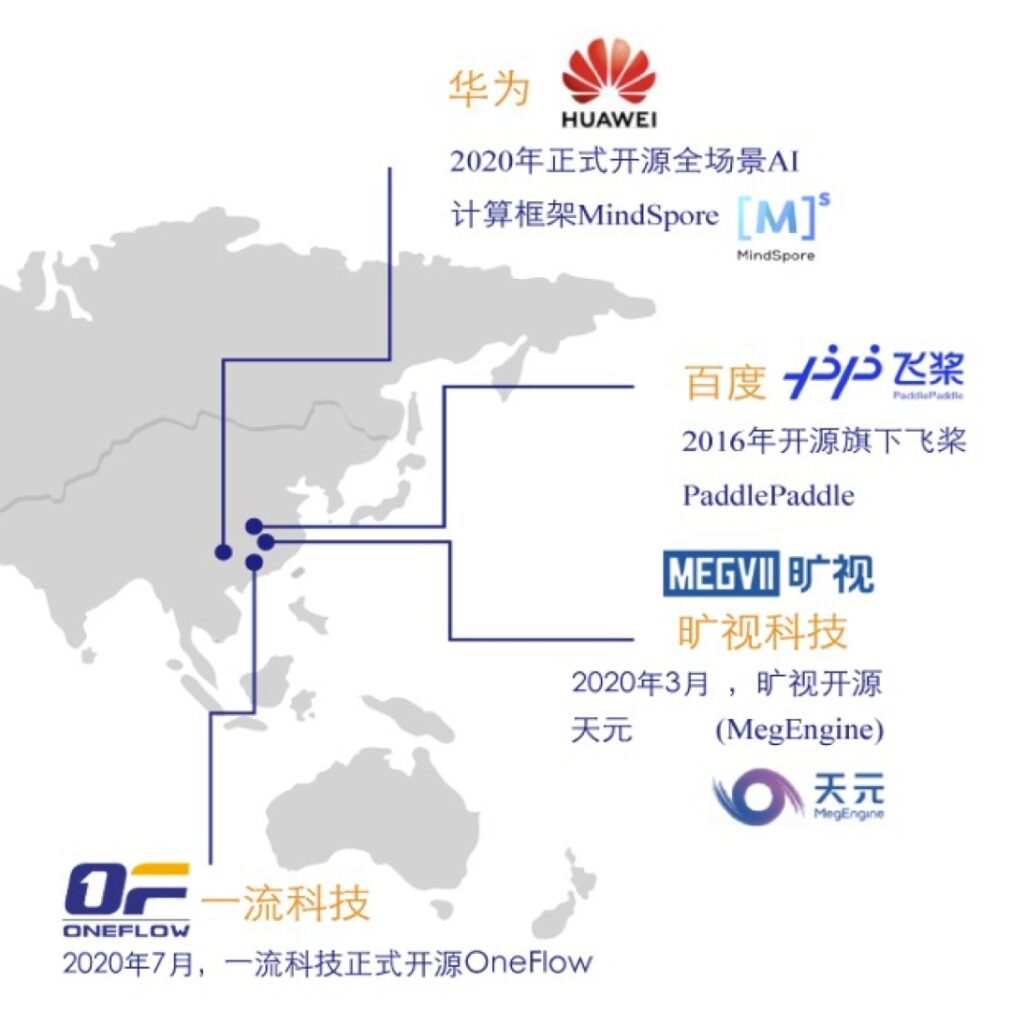

Dans le domaine de l’apprentissage profond, les frameworks grand public tels que PyTorch et TensorFlow occupent sans aucun doute la grande majorité des parts de marché. Même une entreprise du niveau de Baidu a dépensé beaucoup de main-d'œuvre et de ressources pour propulser PaddlePaddle dans le grand public.

Dans un tel environnement concurrentiel dominé par les ressources et axé sur les prédateurs, une startup nationale de cadre d'apprentissage profond, OneFlow, a émergé.

Il excelle dans le traitement de modèles à grande échelle et, même cette année, il a rendu tout son code source et ses données de comparaison expérimentales open source sur GitHub.

Inévitablement, des questions se posent :OneFlow, une nouvelle architecture capable de résoudre les problèmes de formation de modèles de grande taille, est-elle nécessaire ? L’efficacité des frameworks d’apprentissage profond est-elle si importante ? Est-il possible pour les startups de se démarquer de la concurrence ?

Nous avons profité de la conférence annuelle open source CosCon 20 pour interviewer Yuan Jinhui, PDG de Yili Technology, et avons découvert l'histoire derrière plus de 1 300 jours et nuits et des centaines de milliers de lignes de code sur lesquelles lui et ses ingénieurs ont travaillé.

Peu importe le nombre d'auréoles que vous possédez, vous devez toujours procéder étape par étape lorsque vous démarrez une entreprise.

En novembre 2016, Yuan Jinhui a écrit la première version du concept de design de OneFlow dans un immeuble de bureaux près de l'Université Tsinghua. À cette époque, Yuan Jinhui venait de démissionner de Microsoft Research Asia (MSRA), où il avait travaillé pendant près de quatre ans.

« Ancien employé de MSRA » n’est pas le seul tag associé à Yuan Jinhui. Après avoir obtenu son diplôme de l'Université Xidian en 2003, il a été recommandé au Département d'informatique de l'Université Tsinghua pour poursuivre ses études de doctorat.Il a étudié auprès du professeur Zhang Bei, académicien de l'Académie chinoise des sciences et l'un des fondateurs de la discipline de l'IA en Chine.

Après avoir obtenu son diplôme de l'Université Tsinghua en 2008, Yuan Jinhui a rejoint NetEase et 360 Search. Le système Hawkeye qu'il a développé est utilisé par l'équipe nationale chinoise comme système auxiliaire d'entraînement quotidien. De plus, pendant son séjour à la MSRA, il s’est concentré sur les plateformes d’apprentissage automatique à grande échelle.Nous avons également développé l'algorithme et le système de formation de modèles de sujets les plus rapides au monde, LightLDA,Utilisé dans le système de publicité en ligne de Microsoft.

LightLDA a été lancé en 2014. Deux ans plus tard, Yuan Jinhui, doté d'une vision unique, a émis une hypothèse audacieuse :À mesure que les besoins et les scénarios commerciaux augmentent, les cadres d’apprentissage profond distribués capables de gérer efficacement la formation de modèles de grande taille deviendront inévitablement le cœur de l’infrastructure à l’ère de l’intelligence des données après Hadoop et Spark.

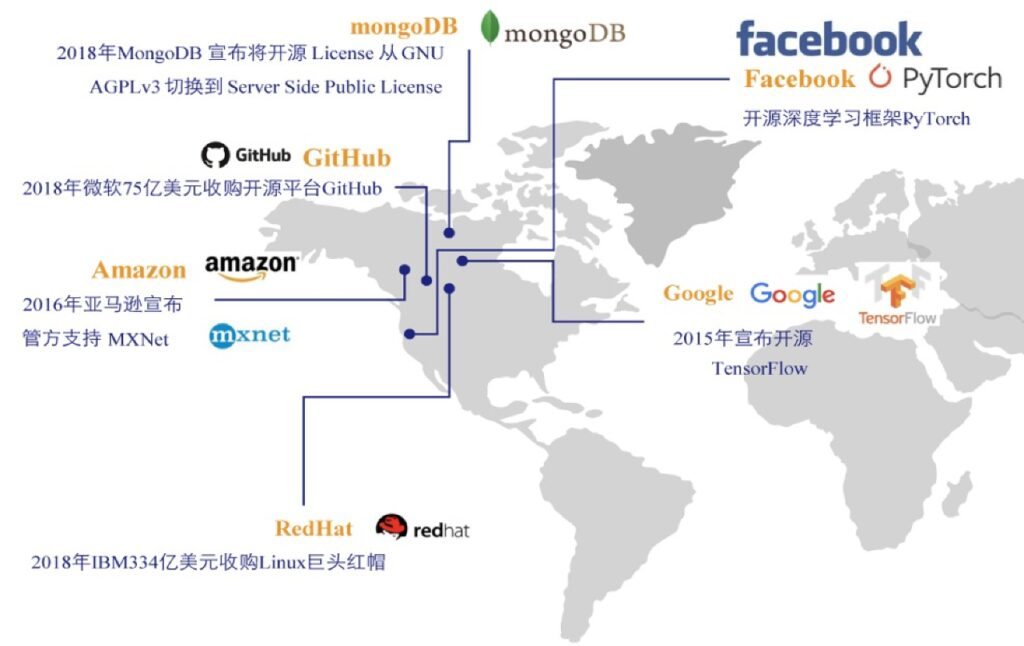

Cependant, les principaux cadres d’apprentissage profond de l’époque étaient tous développés par de grandes entreprises telles que Google, Amazon et Facebook, et la situation était similaire même en Chine.En effet, le développement d’un cadre d’apprentissage profond nécessite non seulement d’énormes coûts de R&D, mais surtout, il nécessite la capacité de supporter la solitude et d’être préparé à une guerre prolongée. Ainsi, aucune startup n’ose tenter l’aventure dans ce domaine.

Les cadres d’apprentissage profond existants fonctionnent déjà à plein régime. Si une startup propose un nouveau framework, les utilisateurs l’achèteront-ils ? Yuan Jinhui, un homme d'action, n'ose pas seulement penser, il ose aussi agir.

Lorsqu'il a tapé la première ligne de code pour OneFlow, il n'avait pas encore réfléchi à la stratégie de mise en œuvre détaillée, et encore moins à la logique métier parfaite. Son idée est simple mais complexe.Nous voulons créer un produit que les développeurs aiment utiliser.

Un groupe de génies + 21 mois, la première version de OneFlow est lancée

En janvier 2017, Yuan Jinhui a fondé Yiliu Technology, a rassemblé plus de 30 ingénieurs et a lancé la « bataille d'équipe » officielle de OneFlow. Bien que tout le monde ait pleinement anticipé les difficultés, les nombreuses difficultés apparues au fur et à mesure du développement dépassaient encore les attentes de l'équipe.

La technologie du framework d’apprentissage profond est très complexe et OneFlow adopte une toute nouvelle architecture technique sans précédent à laquelle se référer. Il a fallu près de deux ans pour que le concept technique fonctionne.

À l’automne 2018, le développement d’une technologie de première classe est entré dans sa phase la plus difficile. Le développement du produit a été retardé, la patience et la confiance de certains employés ont été épuisées et le prochain cycle de financement de l'entreprise a été plein de rebondissements, de sorte que le moral et la confiance de l'équipe sont confrontés à de grands défis.

Dans le milieu des startups, il existe un dicton appelé la « malédiction des 18 mois », qui signifie que s'il n'y a aucun espoir et aucun retour positif pendant un an et demi, la mentalité de l'équipe de startup changera et elle perdra patience. Yuan Jinhui réalisa qu'il ne pouvait plus attendre.OneFlow doit être utilisé dans des scénarios réels dès que possible pour permettre à chacun de voir que l'innovation de OneFlow est effectivement précieuse, créant ainsi un retour positif.

En septembre 2018, après 1 an et 9 mois de recherche et développement,Yuan Jinhui et son équipe ont lancé la version fermée de OneFlow.À cette époque, OneFlow n'était pas encore open source et il y avait des problèmes de différentes tailles, mais la sortie officielle du produit a finalement rassuré les membres de l'équipe.

Privilégiez la formation à grande échelle, l'efficacité surpasse celle des cadres similaires

En novembre 2018, la chance est venue à First-Class Technology. Google a lancé le modèle de langage naturel le plus puissant, BERT, ouvrant une nouvelle ère du PNL. Cela vérifie la prédiction de Yuan Jinhui.De nouvelles architectures capables de gérer efficacement les formations à grande échelle sont nécessaires et essentielles.

bientôt,Des ingénieurs en technologie de premier ordre ont soutenu la formation distribuée de BERT-Large basée sur OneFlow.C'était également le seul framework à l'époque qui prenait en charge la formation BERT-Large distribuée, avec des performances et une vitesse de traitement dépassant de loin les frameworks open source existants.

OneFlow est devenu célèbre du jour au lendemain, ce qui a également donné l'occasion à First-Class Technology d'accumuler le premier lot d'utilisateurs d'entreprise Internet de premier plan. Étonnamment,À cette époque, Yuan Jinhui a choisi une voie extrêmement discrète car il n'était « toujours pas satisfait du produit ».

De la sortie de la version fermée en septembre 2018 à sa sortie officielle en open source en juillet 2020, Yuan Jinhui a passé 22 mois supplémentaires à peaufiner OneFlow.Lui et son équipe ont continué à optimiser le modèle classique tout en résolvant des problèmes inattendus.Selon Yuan Jinhui, même si la documentation du produit n'est pas bien faite, il ne poussera pas facilement OneFlow sur la table.

Le 31 juillet 2020, OneFlow a été officiellement open source sur GitHub.Ce framework open source, connu pour sa capacité à entraîner des modèles à grande échelle, revient sous le feu des projecteurs pour la deuxième fois, illustrant parfaitement le dicton : l'efficacité est reine.

Vitesse de formation plus rapide, utilisation plus élevée du GPU, rapport d'accélération multi-machines plus élevé, coûts d'exploitation et de maintenance inférieurs et expérience utilisateur plus simple.Cinq avantages puissants permettent à OneFlow de s’adapter rapidement à divers scénarios et de se développer rapidement. Yuan Jinhui et son équipe ont atteint le summum dans leur quête et leur optimisation des performances de OneFlow.

Récemment, OneFlow a publié la version v0.2.0.Jusqu'à 17 nouvelles optimisations de performances ont été ajoutées.Cela améliore considérablement la vitesse d’entraînement automatique de précision mixte de CNN et BERT.

L'équipe de développement a également mis en place un projet open source appelé DLPerf, qui rend entièrement open source l'environnement expérimental, les données expérimentales et les algorithmes reproductibles.Le débit et le taux d'accélération de OneFlow et de plusieurs autres frameworks grand public sur les modèles ResNet50-v1.5 et BERT ont été évalués dans le même environnement physique (4 machines V100 16G x8).

Les résultats montrent que le débit de OneFlow est nettement supérieur à celui des autres frameworks, à la fois sur une seule machine et un seul GPU, et sur plusieurs machines et plusieurs GPU, ce qui en fait le framework le plus rapide pour la formation des modèles ResNet50-v1.5 et BERT sur les cartes graphiques phares grand public (V100 16G).La carte unique OneFlow ResNet50-v1.5 AMP est 80% plus rapide que PyTorch profondément optimisé de NVIDIA et 35% plus rapide que TensorFlow 2.3.

Le rapport d’évaluation spécifique est accessible à partir du lien suivant :

https://github.com/Oneflow-Inc/DLPerf

Faire face aux doutes et devenir une « minorité » sur la piste

En fait, OneFlow a été remis en question à de nombreuses reprises depuis sa création.« Arriver tard et avoir un petit espace de vie » est la voix la plus répandue.Yuan Jinhui a fait preuve d'un calme extraordinaire à ce sujet.

Selon lui, le cadre d’apprentissage profond est une nouveauté, et la technologie et l’industrie en sont aux premiers ou au milieu de leur développement, il n’est donc pas question de s’y mettre tôt ou tard. Avant que la technologie ne converge,Les produits à hautes performances, à forte facilité d’utilisation et à valeur conviviale seront privilégiés par les utilisateurs.

Quant à l’idée selon laquelle il y aurait moins d’espace habitable, elle est complètement fausse.L'open source permet aux produits des petites et des grandes entreprises de rivaliser équitablement.D’excellents nouveaux frameworks défient les frameworks faisant autorité, ce qui est l’un des éléments fondamentaux de l’esprit open source.

Les doutes n’ont pas entravé le développement de OneFlow. Au contraire,Yuan Jinhui et son équipe ont accéléré la mise à niveau et l'amélioration de OneFlow, en mettant à jour et en optimisant les performances, en triant la documentation des développeurs et en recueillant les commentaires de la communauté...Ces efforts et cette persévérance ont attiré davantage d’utilisateurs vers OneFlow, y compris certains des « sceptiques » initiaux.

Lors de la conférence annuelle COSCon'20 China Open Source, Yuan Jinhui a fait une présentation intitulée « Évolution des systèmes de formation en apprentissage profond ».Le prochain plan de développement de OneFlow a été présenté à tous les développeurs. En plus d’insister sur l’efficacité avant tout et d’optimiser continuellement les performances,L'équipe de développement travaille également dur pour réduire les coûts d'apprentissage et de migration des utilisateurs.Actuellement, le coût pour les utilisateurs de PyTorch de migrer vers OneFlow est déjà assez faible, car les interfaces utilisateur des deux sont presque les mêmes, et le coût de conversion des modèles formés vers OneFlow est également suffisamment faible.

Objectivement parlant, OneFlow est toujours à la traîne par rapport à TensorFlow et PyTorch en termes d'exhaustivité et de facilité d'utilisation. Cependant, OneFlow se caractérise par une efficacité élevée, une bonne évolutivité et une facilité d'utilisation distribuée.Il est très adapté à la reconnaissance faciale à grande échelle, aux systèmes de recommandation publicitaire à grande échelle et aux scénarios de formation de modèles avec d'énormes paramètres de modèle tels que GPT-3.

À la fin de l’entretien, M. Yuan Jinhui n’a pas caché son désir de talent. Il a déclaré que OneFlow recrute des ingénieurs en apprentissage automatique et en apprentissage profond, et accueille chaleureusement les personnes perspicaces pour rejoindre cette équipe dynamique et désireuse de gagner.

-- sur--