Command Palette

Search for a command to run...

5 Milliards De Vues, 17 Millions De Personnes Ont Participé À « Transformation Comics », l'équipe De Douyin a Accepté Une Interview Avec CSDN

Ces dernières années, diverses applications de retouche photo, d’embellissement et d’effets spéciaux sont devenues très populaires auprès des utilisateurs. Récemment, les nouveaux effets spéciaux de « transformation en bande dessinée » de Douyin sont redevenus un sujet brûlant. Quelles sont les technologies clés à l’origine de cette explosion de popularité ?

Rédacteur en chef : Neuro Xiaoxi

Le contenu est compilé à partir de CSDN et ByteFan (lien joint à la fin de l'article)

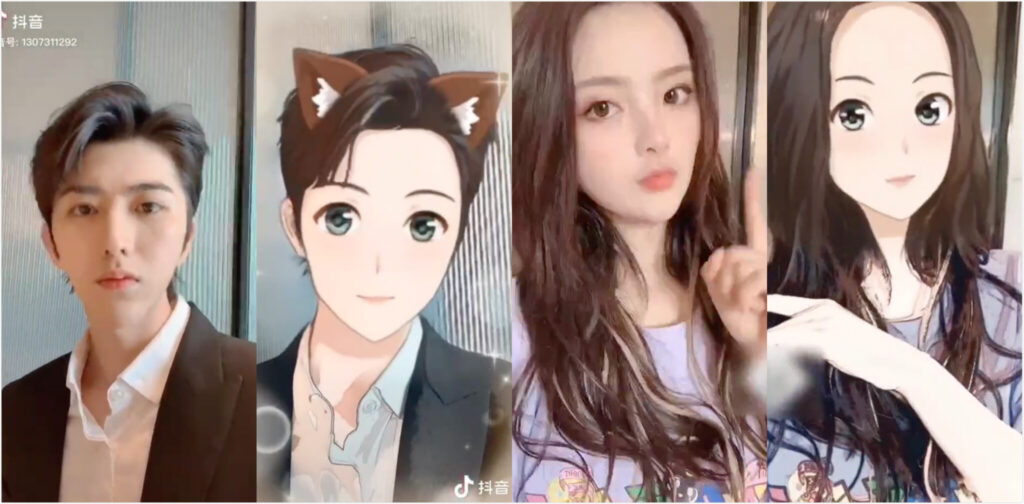

Récemment, un effet spécial de « transformation en bande dessinée » sur TikTok est devenu populaire, et tout le monde, des passants aux célébrités, ne peut s'empêcher de l'essayer.

En une seconde seulement, vous pouvez vous voir dans le monde en deux dimensions, avec de grands yeux larmoyants et une peau claire, l'air plein d'énergie.

À ce jour, plus de 17,7 millions d'utilisateurs sur Douyin ont créé des vidéos en utilisant les effets spéciaux « Transformation en bandes dessinées », et cette série de vidéos a accumulé 5,67 milliards de vues.

Inspiration d'il y a un an, utiliser GAN pour percer

Bien que cet effet spécial soit facile à utiliser et que la transformation ne prenne qu'une seconde, le succès est en fait le résultat d'une recherche et d'un développement à long terme et d'un perfectionnement par l'équipe vidéo de Douyin.

En 2018, ByteDance a créé une équipe d’imagerie spéciale.Il prend en charge le perfectionnement de l'ensemble de la série de produits, y compris Tik Tok, Volcano et Qingyan, y compris l'exploration à long terme du gameplay stylisé en personne réelle, et s'efforce de créer en permanence des effets spéciaux qui frappent les utilisateurs.

Le média technologique CSDN a interviewé l'équipe concernée dès que possible, et nous en avons cité une partie :

L'inspiration du projet « Transformation Comics » lancé cette fois-ci est venue d'une réunion de brainstorming il y a environ un an.

J'ai appris cela lors d'une séance de brainstorming,L'idée de « transformer une vraie personne en un visage de dessin animé en quelques secondes » a été évoquée.L’idée a enthousiasmé l’équipe.

Fais ce que tu dis. En septembre 2019, l'équipe vidéo de Douyin a rapidement fait appel à des collègues de la R&D, de la conception et d'autres domaines pour un soutien collaboratif afin de participer.

La principale technologie utilisée dans les effets spéciaux de transformation de bandes dessinées lancés par TikTok cette fois-ci est toujours le GAN, mais il existe également quelques différences par rapport au passé.L'équipe a ajouté de nouvelles tentatives basées sur GAN.

En fait, avant la sélection technologique finale, les effets spéciaux de bandes dessinées en temps réel de Douyin ont comparé un grand nombre de méthodes technologiques de génération actuelle, y compris des méthodes de génération de bandes dessinées, telles que ugatit, et des méthodes pour d'autres tâches, telles que MUNIT.

Cependant, la recherche a révélé queIl existe certains problèmes avec les GAN actuels utilisés pour des tâches telles que la génération de bandes dessinées et le transfert de style.

Premièrement, la formation est instable. Deuxièmement, même un petit ajustement des hyperparamètres peut avoir un impact significatif sur les résultats. De plus, il est facile de rencontrer le problème de la disparition du gradient.

À cet égard,Le plan d'amélioration de Douyin est d'essayer plusieurs pertes, notamment WGAN, LSGAN, etc.Mais il n’existe pas encore de solution miracle, il est donc nécessaire de surveiller les changements de gradients au cours de l’expérience.

L'équipe technique de Douyin a également déclaré qu'au cours du processus d'exploration de la technologie vidéo comique, l'équipe technique a rencontré de nombreux revers lors des premières tentatives. Lors des premières recherches préliminaires, la version de sortie était très différente de la version illustrée et les performances ne répondaient pas aux normes.

Après plusieurs tentatives insatisfaisantes, l’équipe a commencé à douter de la faisabilité des bandes dessinées en temps réel.

Mais heureusement, après plusieurs tentatives infructueuses, quelqu'un a souligné la clé en résumant l'expérience :Les modèles précédents avaient une structure unique et les avantages et les inconvénients des différents modèles n’étaient pas totalement cohérents.

alors,L'équipe technique a essayé la méthode de greffe de modèles, en utilisant différents modules pour assembler de nouveaux modèles, ce qui a considérablement amélioré la qualité de la génération de bandes dessinées.

Une fois les normes de qualité respectées, le modèle a été ajusté en calculant l'importance de chaque couche, et enfin la structure du modèle en temps réel a été déterminée.

L'équipe de produits de performance participe également au réglage des performances du modèle, résume la relation quantitative entre les paramètres et les effets et optimise le modèle en affinant les paramètres. Enfin, ce produit à succès est né.

La transformation en temps réel en bande dessinée présente de nombreuses difficultés. Comment les surmonter ?

L’un des aspects les plus attrayants de « Transformation Comics » est sa transformation en temps réel.

Alors, par rapport au traitement d’images statiques, quelle est la difficulté de réaliser un traitement de bande dessinée en temps réel, notamment sur les téléphones portables ?

L'équipe technique de Douyin a déclaré que le traitement de bandes dessinées vidéo en temps réel est encore assez difficile, par exemple :

- Premièrement, la complexité de calcul du modèle lui-même doit être très faible. Pour obtenir un bon effet comique avec une complexité de calcul limitée, il est nécessaire d’exploiter pleinement la valeur de chaque opération.

- Deuxièmement, Douyin compte un grand nombre d'utilisateurs et les performances des modèles utilisés par les utilisateurs varient considérablement, il est donc nécessaire de développer spécialement des stratégies de livraison de modèles complexes et personnalisées.

Afin de répondre aux besoins des utilisateurs à différents niveaux, Douyin a développé une stratégie de distribution de modèles complexe et réalisé une distribution de modèles personnalisée, qui a finalement assuré le lancement réussi des bandes dessinées en temps réel et a répondu aux exigences des bandes dessinées en temps réel en termes d'effet et de performance.

aussi,Les effets spéciaux des bandes dessinées Tik Tok utilisent ByteNN, le moteur d'inférence développé par ByteDance.Ce moteur d'inférence, conçu pour la mise en œuvre rapide d'algorithmes côté périphérique, prend non seulement en charge les capacités de calcul générales du CPU et du GPU, mais exploite également pleinement les capacités d'accélération du matériel NPU/DSP du fabricant, garantissant que les bandes dessinées en temps réel peuvent prendre en charge de manière stable la base d'utilisateurs massive de TikTok.

Bien sûr, l'algorithme actuel pour ces effets de bande dessinée en temps réel peut encore être optimisé pour certains scénarios particuliers. Dans les itérations suivantes, nous partirons également du modèle lui-même et du moteur d’inférence pour améliorer l’effet du modèle tout en optimisant les performances d’inférence.

Équipe d'imagerie ByteDance : les filtres de bande dessinée doivent être à la fois réalistes et beaux

Ces dernières années, des effets spéciaux tels que des styles de bandes dessinées et de peinture à la main ont émergé les uns après les autres.Comment se démarquer et devenir un succès est le problème difficile auquel l'équipe est confrontée.

Selon Da Peng de l'équipe d'imagerie de ByteDance, la chose la plus importante est,L’objectif est d’apporter surprise et résonance aux utilisateurs.

D'un côté, l'équipe des effets spéciaux de « Transformation Comics »Il atteint à la fois la « ressemblance » et la « beauté ».D’autre part, grâce à l’amélioration continue de la technologie,Des effets de transformation en temps réel de milliers de visages pour des milliers de personnes sont obtenus.

Yu Chen, membre de l'équipe projet, a déclaré : « Nous avons défini deux caractéristiques majeures : la beauté exquise et la ressemblance extrême. Nous devons préserver pleinement les caractéristiques de l'utilisateur et faire en sorte que l'image ressemble à la personne réelle, tout en générant la beauté artistique unique de la bande dessinée. »

De plus, l'équipe a combiné les points forts des images des bandes dessinées japonaises, chinoises et coréennes pour concevoir la version finale des bandes dessinées, et son esthétique a été largement reconnue.

En termes de gameplay, l'équipe a finalement sélectionné 6 accessoires créatifs, tels que les mains coulissantes, les hochements de tête et d'autres méthodes de transformation, pour améliorer l'expérience interactive et prendre en compte les besoins des utilisateurs d'âges, de niveaux et de préférences différents.

GAN : une arme magique importante dans le domaine de la génération d'images

Parlons de la technologie de base de ce produit à succès : GAN (Generative Adversarial Networks).

Ces dernières années, la recherche basée sur le GAN bat son plein. Chaque fois que les résultats de recherche sur la génération et la conversion d'images sont impressionnants, la technologie GAN est presque toujours utilisée.

En 2014, Ian Goodfellow et son équipe ont publié un article intitulé « Generative Adversarial Networks » dans lequel ils ont été les pionniers d'un modèle d'apprentissage profond appelé GAN.

La structure principale du modèle GAN comprend le générateur G (Générateur) et le discriminateur D (Discriminateur).L’entraînement de ce modèle se déroule dans un état de jeu conflictuel.

En utilisant l'idée du jeu adverse, lors du processus d'entraînement, le but du générateur G est de générer des images aussi réalistes que possible pour tromper le discriminateur D. Le but de D est d'essayer de distinguer les images générées par G des images réelles. De cette façon, G et D constituent un « processus de jeu » dynamique.

Quel est le résultat final du match ? Autrement dit, dans des conditions idéales, G peut générer des images suffisamment « réelles » pour être confondues avec la réalité.

En termes simples, G est comme un faussaire d'une œuvre d'art, essayant par tous les moyens possibles de tromper le discriminateur D et obtenant finalement une œuvre dont il est difficile de distinguer l'authentique du faux.

Ces dernières années, on peut dire que l’application du GAN est très riche. Par exemple, utilisé pour générer des personnages d'anime :

Conversion d'images à l'aide de CycleGAN :

StyleGAN, proposé par NVIDIA en 2018, génère de faux portraits :

Sources :

https://mp.weixin.qq.com/s/lLfp8F6G2uHxYpCMCF1Tmw

https://mp.weixin.qq.com/s/WeZD__I7Y98Fg18pEZ9L9g

-- sur--