Command Palette

Search for a command to run...

La Première Diffusion En Direct En Ligne, De Quoi Parlait Le TF Dev Summit ?

Le sommet annuel TensorFlow Dev Summit a eu lieu récemment. En raison de l’impact de la nouvelle pandémie de coronavirus, le sommet s’est tenu entièrement en ligne pour la première fois.

La diffusion en direct a eu lieu de 0h30 à 8h00 le 12 mars, heure de Pékin. Cet événement annuel destiné aux développeurs d'apprentissage automatique a incité d'innombrables téléspectateurs chinois à rester éveillés tard pour regarder la diffusion en direct. Alors, quelles sont les grandes astuces que TensorFlow (TF en abrégé) a dévoilées ?

Nous allons sélectionner quelques-uns de ces aspects et faire un bref aperçu des points saillants.

TensorFlow : le framework ML le plus populaire

La conférence a été ouverte par un discours d’ouverture de Megan Kacholia.

Megan Kacholia est la directrice de l'ingénierie de TensorFlow et de Google Brain, se concentrant sur TensorFlow. Elle travaille chez Google depuis de nombreuses années et son objectif est d'étudier les grands systèmes distribués et de trouver des moyens d'améliorer et d'optimiser les performances.

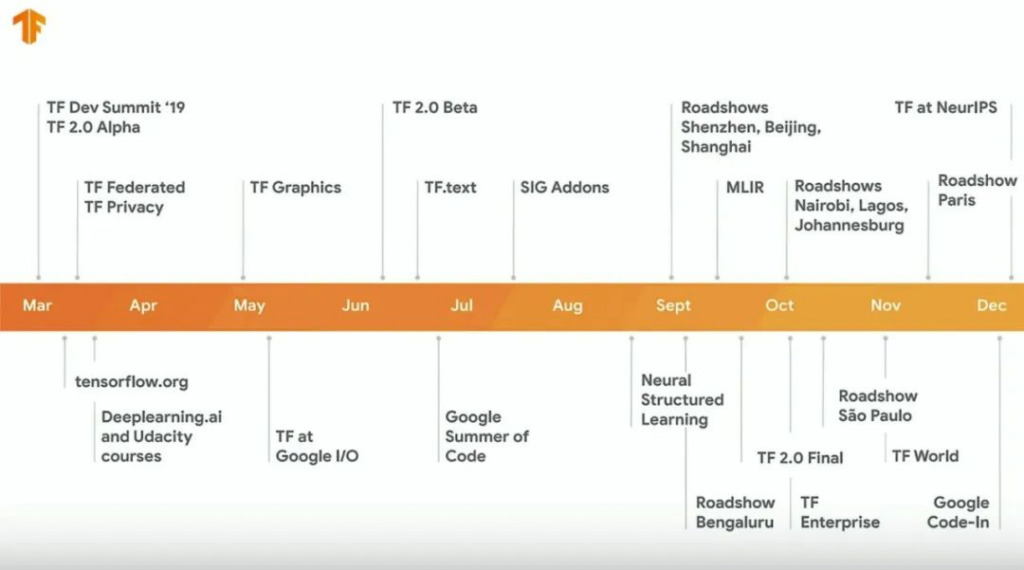

Lors de la séance Keynote, comme d'habitude, certaines réalisations de TF l'année dernière ont été présentées, notamment les événements majeurs, l'utilisation par le public, etc.

L'utilisation actuelle de TF a atteint 76 millions de téléchargements, plus de 80 000 soumissions, plus de 13 000 demandes d'extraction et plus de 2 400 contributeurs, démontrant pleinement que TF est le framework d'apprentissage automatique le plus populaire.

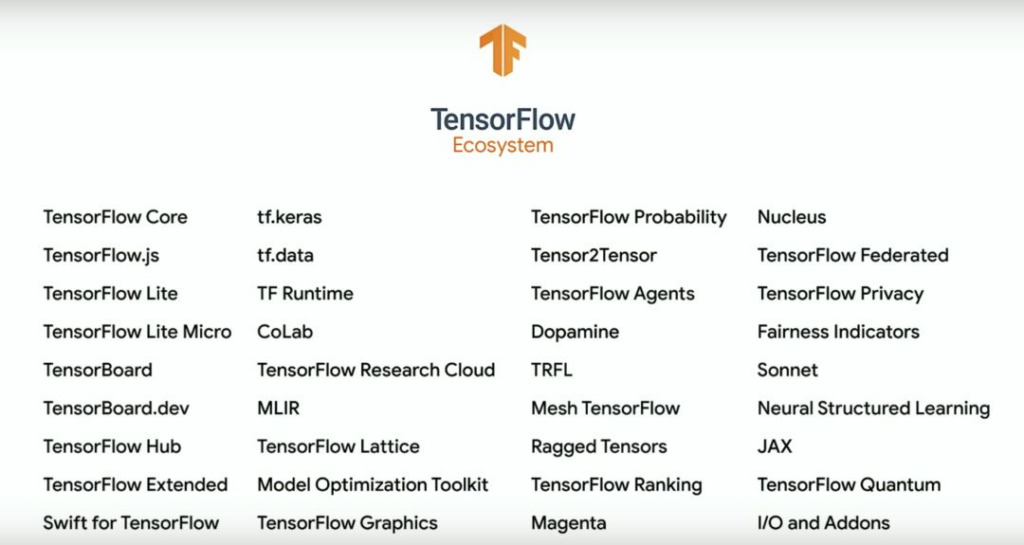

La session Keynote s'est concentrée sur les trois grands acteurs qui ont présenté l'écosystème TensorFlow.

Avec le développement de TF au fil des années, ses outils associés ont progressivement formé un écosystème puissant, comprenant de nombreuses bibliothèques et composants d'extension utilisables, ainsi que différentes applications pour diverses tâches.

Megan Kacholia s'est d'abord concentrée sur l'introduction de l'utilisation de TF et a donné une introduction détaillée sous trois aspects : la recherche liée à TF, les cas réels dans la réalité et le développement et le déploiement pour chaque utilisateur.

Manasi Joshi a ensuite présenté les normes éthiques de TF pour l'IA, décrivant comment éviter la discrimination fondée sur le sexe, garantir l'équité, l'explicabilité, la confidentialité, la sécurité et d'autres problèmes lors de l'utilisation de l'IA, et a énuméré une série d'outils que TF utilise pour résoudre ces problèmes.

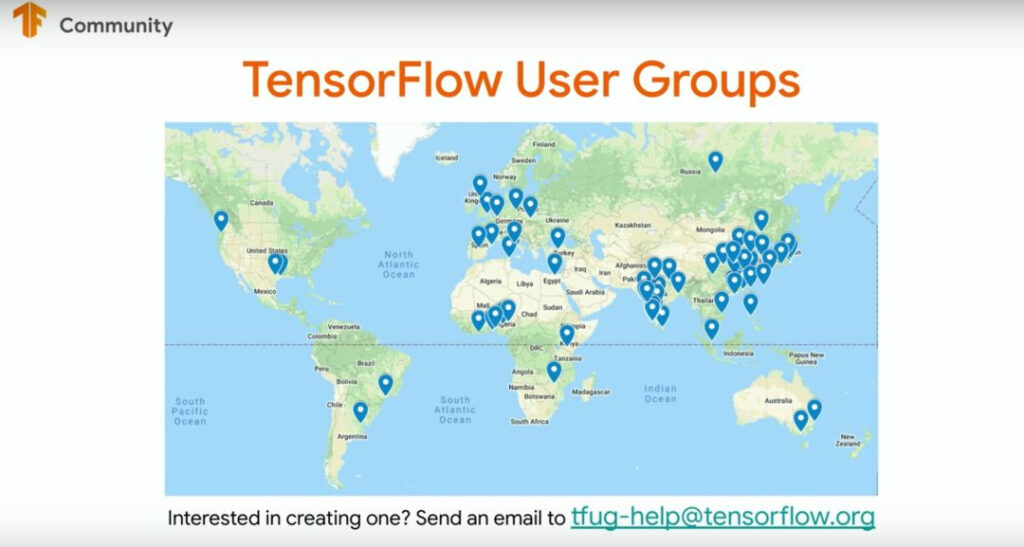

Enfin, Kemal El Moujahid a présenté la communauté TF, la répartition mondiale des membres de la communauté, a démontré une série d'activités menées par la communauté et a mis à jour le contenu des ressources telles que le Machine Learning Crash Course.

Une nouvelle version arrive ! TF 2.2 est sorti discrètement

Comparé à l'écosystème TF qui a été tant discuté lors du Keynote, la dernière version TF 2.2 lancée cette fois-ci semble beaucoup plus discrète.

Mais en tant que nouvelle version, elle apporte également quelques mises à jour majeures. TF 2.2 a principalement apporté des ajustements dans trois aspects : accorder plus d'attention aux performances, s'intégrer à l'écosystème TF et rendre la bibliothèque principale stable.

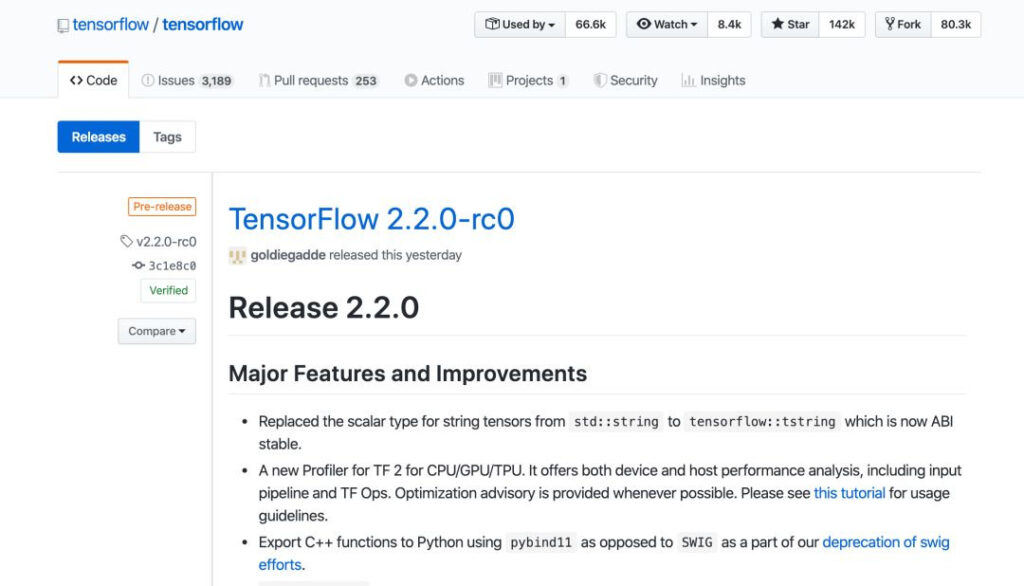

Cette version est désormais disponible sur Github :

https://github.com/tensorflow/tensorflow/releases

Les principales fonctionnalités et améliorations sont :

1) Remplacement du type scalaire du tenseur de chaîne de std::string par tensorflow::tstring, maintenant l'ABI est plus stable.

2) Nouveau profileur pour CPU/GPU/TPU. Il fournit une analyse des performances des appareils et des hôtes, y compris le pipeline d'entrée et les opérations TF. Fournir des suggestions d’optimisation chaque fois que possible.

3) Dépréciez Swig et utilisez pybind11 pour exporter des fonctions C++ vers Python au lieu de SWIG.

D'autres mises à jour peuvent être trouvées dans tf.keras, tf.lite et XLA, et les détails peuvent être trouvés sur GitHub.

Une révolution en PNL ? Ajouter un traitement d'image

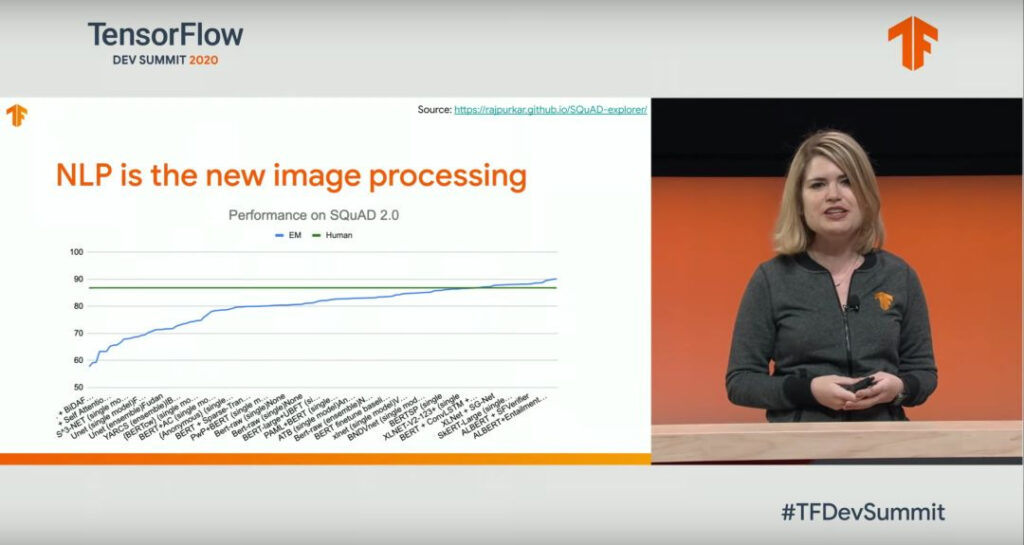

Immédiatement après la session Keynote, les progrès de TensorFlow en PNL ont été partagés et l'orateur a prononcé un discours sur « Apprendre à lire avec TensorFlow et Keras ».

Le rapport indique que le traitement du langage naturel (NLP) a atteint un point d'inflexion, de sorte que la recherche actuelle se concentre sur la manière d'utiliser TF et Keras pour faciliter le prétraitement, la formation et l'hyperréglage des modèles de texte.

Un point est souligné : la PNL est une nouvelle façon de traiter l’image.

L'orateur a cité l'exemple d'un enfant qui apprend à écrire en regardant des choses et a déclaré que TF a commencé à essayer d'améliorer ses performances en PNL du point de vue du traitement d'images.

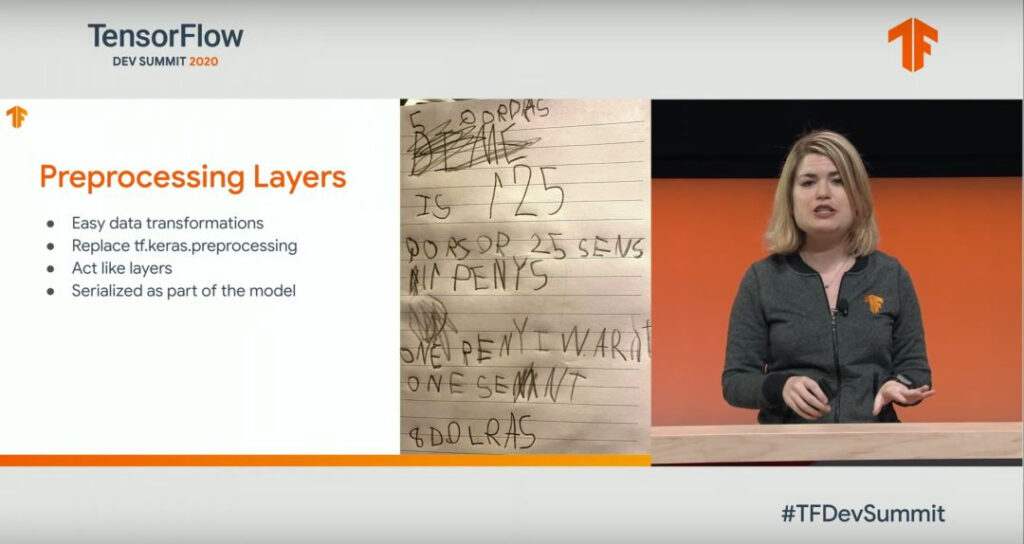

En fait, TF a introduit les couches de protraitement depuis la version 2.X. Cette amélioration présente les caractéristiques suivantes :

Il est plus facile de convertir les données en remplaçant le programme tf.keras, agissant comme une couche de traitement en tant que séquence de modèles.

Afin de prouver que le PNL est un nouveau traitement d'image, le conférencier a également comparé les couches de protraitement dans le domaine de l'image et le domaine du PNL, en soulignant certains de leurs points communs.

Mise à niveau TF Lite : plus d'importance accordée à l'expérience du téléphone mobile

Alors que les téléphones mobiles deviennent de plus en plus importants dans la vie quotidienne, TF accorde de plus en plus d'attention à l'expérience utilisateur dans les appareils périphériques. Cette fois, nous avons également utilisé un rapport principal pour partager quelques mises à jour sur TensorFlow Lite.

Le contenu comprend comment déployer le ML sur les téléphones mobiles, les appareils embarqués ou d'autres terminaux plus rapidement et de manière plus sécurisée grâce aux nouvelles technologies de TF.

Actuellement, TF a été déployé sur des milliards d’appareils périphériques et est utilisé par plus de 1 000 applications mobiles. Il s'agit du framework ML multiplateforme le plus populaire dans le domaine des appareils mobiles et des microcontrôleurs.

Le contenu mis en avant cette fois-ci comprend l'adaptation à divers appareils, le développement d'une série de boîtes à outils pour un traitement optimal des performances, l'augmentation continue du support des performances de pointe, la possibilité d'utilisation dans des situations hors ligne et une plus grande importance accordée aux fonctionnalités de confidentialité et de sécurité.

En ce qui concerne la nouvelle bibliothèque d'extensions TF Lite, davantage d'API d'images et de langues ont été ajoutées, l'intégration d'Android Studio a été ajoutée et des fonctions telles que la génération de code ont été améliorées.

Le rapport a également publié Core ML Delegation, qui peut accélérer la vitesse de calcul en virgule flottante sur les terminaux d'Apple via l'agent ML de base de la puce neuronale d'Apple.

Enfin, nous avons également présenté en avant-première les développements ultérieurs. Il y aura d'autres méthodes d'optimisation du processeur, comme dans TensorFlow Lite 2.3, qui apporteront de plus grandes améliorations de performances, et un nouveau convertisseur de modèle sera inclus par défaut sur TF 2.2.

Nuke : TF Quantum est sorti

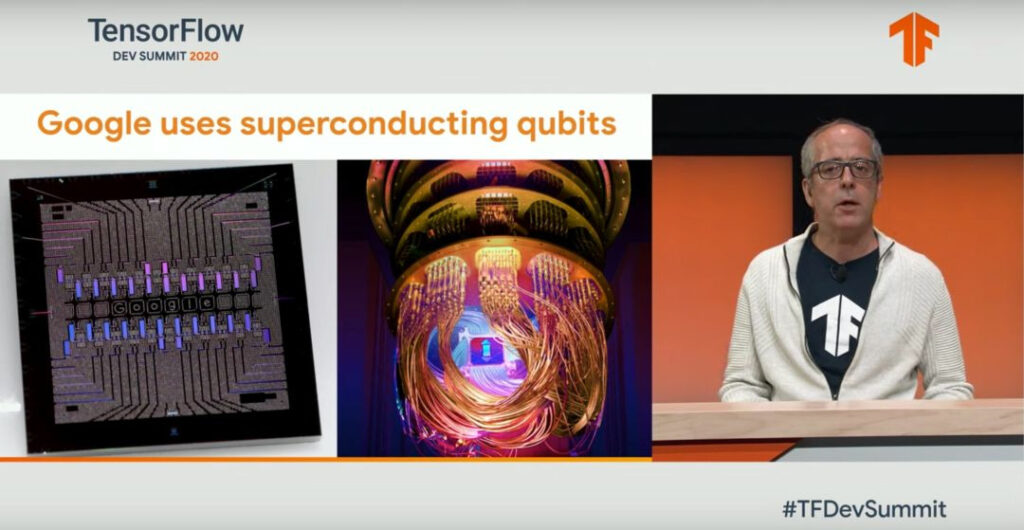

Vers la fin du sommet, Masoud Mohseni est apparu et a une fois de plus présenté TensorFlow Quantum, une bibliothèque d'apprentissage automatique open source récemment annoncée pour la formation de modèles quantiques.

Le discours d’ouverture était très long, prenant près d’une demi-heure pour expliquer les principes de l’informatique quantique et les problèmes que TF Quantum est prêt à résoudre.

TFQ fournit les outils nécessaires pour réunir la recherche en informatique quantique et en apprentissage automatique pour contrôler et modéliser des systèmes quantiques naturels ou artificiels.

Plus précisément, TFQ se concentre sur le traitement des données quantiques et construit un modèle hybride quantique-classique qui intègre des algorithmes et une logique de calcul quantique conçus dans Cirq et fournit une unité de calcul quantique compatible avec l'API TensorFlow existante, ainsi qu'un simulateur de circuit quantique haute performance.

Le discours a souligné que Google a appliqué TFQ aux réseaux neuronaux convolutifs hybrides quantiques-classiques, à l'apprentissage automatique contrôlé quantique, à l'apprentissage hiérarchique des réseaux neuronaux quantiques, à l'apprentissage dynamique quantique, à la modélisation générative des états quantiques hybrides et à l'apprentissage des réseaux neuronaux quantiques via les réseaux neuronaux récursifs classiques.

Cet outil sera également utilisé pour apprendre les réseaux de neurones quantiques et d'autres utilisations via les réseaux de neurones récurrents classiques. Cela apportera un élan significatif au domaine de l’informatique quantique.

Bien que l'explication des principes soit très présente dans le discours, l'utilisation spécifique n'est pas difficile :

Vous pouvez l'utiliser en introduisant des bibliothèques et des définitions pertinentes, en définissant le modèle, en formant le modèle et enfin en utilisant le modèle pour la prédiction.

C'est une diffusion en direct qui vaut la peine d'être regardée

En plus du contenu mentionné ci-dessus, TensorFlow dev Summit a également organisé de nombreuses autres sessions de partage.

Y compris l'utilisation de TF pour la recherche scientifique, une introduction à TF Hub, des recherches sur le ML collaboratif, l'utilisation de TF sur Google Cloud, des discussions sur la confidentialité équitable dans l'utilisation de l'IA, et plus encore.

Au cours de près de 8 heures de diffusion en direct, tous les aspects de TensorFlow ont été démontrés. Même si c'était la première fois que l'on adoptait la forme d'une diffusion en direct en ligne complète, elle contenait beaucoup de contenu utile, ce qui valait la peine que tout le monde reste éveillé tard.

Si vous souhaitez en savoir plus, vous pouvez revoir cet événement via l'émission enregistrée :

https://space.bilibili.com/64169458

-- sur--