Command Palette

Search for a command to run...

Lors Des Élections Parlementaires Indiennes, Les Candidats Ont Utilisé DeepFake Pour Falsifier Des Vidéos En Dialecte Afin De Solliciter Des votes.

Lors des récentes élections législatives de Delhi en Inde, un candidat a utilisé la technologie DeepFake pour générer des vidéos promotionnelles dans d'autres langues afin de gagner des voix pour son équipe. Bien que cette méthode ait eu de bons effets publicitaires et ait permis de remporter quelques voix, les résultats finaux des élections ont été inattendus.

Récemment, DeepFake est apparu pour la première fois lors des élections indiennes et a été utilisé par les candidats dans leurs supports de campagne.

Lors des élections législatives de l'État de Delhi qui viennent de se terminer en Inde, Manoj Tiwari, l'un des candidats du Bharatiya Janata Party (BJP), a utilisé une technologie de fraude vidéo pour « parler » une langue qu'il ne connaissait pas afin de gagner les électeurs des langues minoritaires.

Malheureusement, le destin leur a joué des tours. Même avec l'aide de l'IA, la propagande a connu un certain essor, mais le BJP a finalement perdu les élections, ne remportant que 8 sièges parlementaires (sur un total de 70) dans l'État.

Parler couramment le dialecte aide les candidats à obtenir du soutien

Le 7 février, la veille des élections à l'Assemblée de Delhi, Manoj Tiwari du Bharatiya Janata Party a partagé deux courtes vidéos sur les réseaux sociaux, apparaissant dans la publicité de son parti.

Première vidéo (anglais)

Deuxième vidéo (Haryana)

Les deux vidéos, l'une en anglais et l'autre en haryanvi (un dialecte indien), critiquaient principalement l'actuel ministre en chef de Delhi, Arvind Kejriwal, et encourageaient les électeurs à voter pour le Bharatiya Janata Party.

Dans la vidéo, Tiwari, qui n'est pas bon en Haryanvi, parle couramment Haryanvi et appelle tout le monde à voter pour le BJP. Cette initiative a suscité une réaction enthousiaste parmi les personnes qui parlent la langue, et la vidéo a été largement diffusée sur WhatsApp.

Le chef du BJP a affirmé dans les médias que cette initiative avait donné de bons résultats. De nombreuses femmes au foyer ont déclaré qu'elles se sentaient très proches des candidats parlant dans leur propre dialecte, ce qui a également influencé les décisions de vote de certaines personnes.

Mais ensuite, des personnes prudentes ont découvert quelque chose d’étrange dans la vidéo.

Les agences de relations publiques utilisent DeepFakes à la demande des partis politiques

En observant attentivement la vidéo de Tiwari, les internautes ont souligné que les mouvements de la bouche du personnage donnent une sensation gênante et ne semblent pas être enregistrés naturellement.

Plus tard, des chercheurs du célèbre média technologique Vice et du Rochester Institute of Technology (RIT) de New York ont également remarqué des anomalies dans la vidéo.

Vice a ensuite vérifié l'affaire et révélé le secret derrière la vidéo.

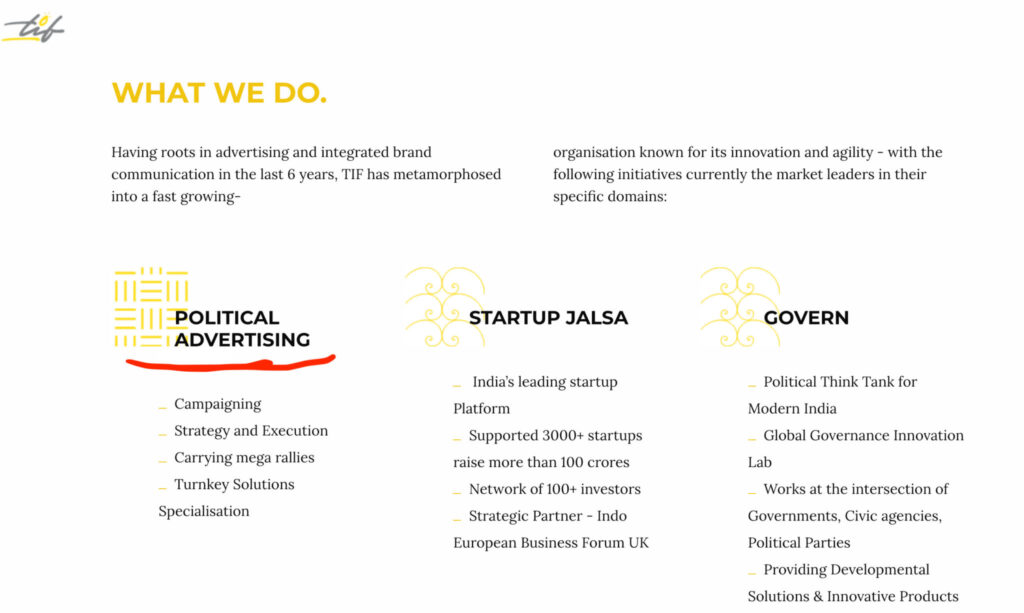

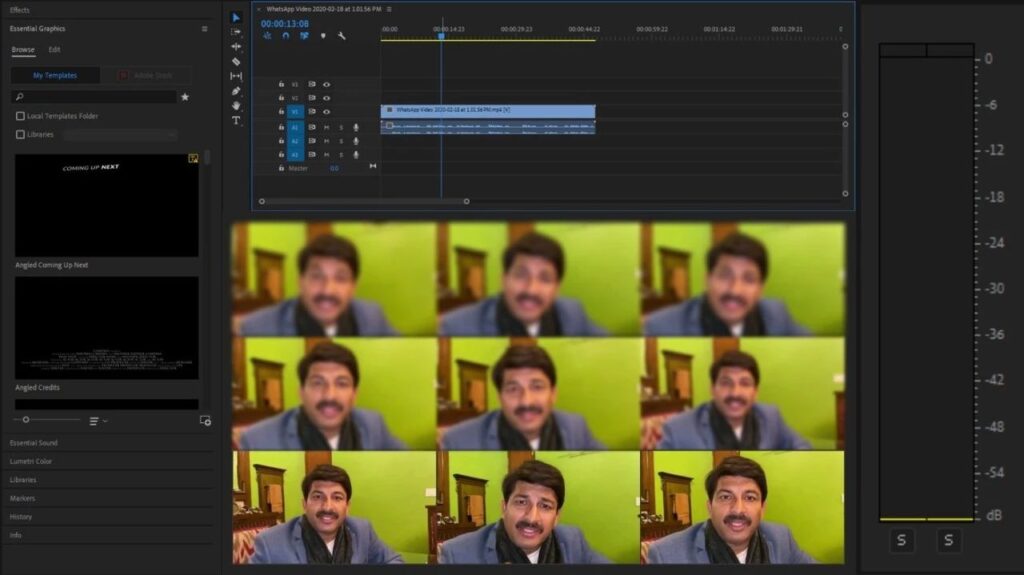

Il a été confirmé que la deuxième vidéo de Haryana n'a pas été réellement tournée, mais qu'il s'agit d'un produit DeepFake créé par le département informatique du BJP en collaboration avec la société de relations publiques The Ideaz Factory.

Apparemment, afin de permettre aux candidats de gagner des électeurs de différentes langues, le BJP et The Ideaz Factory se sont associés pour faire parler Tiwari en dialecte et « apparaître » à l'écran.

Bakshi, responsable des médias et de la technologie du BJP pour l'État de Delhi, a déclaré à Vice que la fausse vidéo du candidat Tiwari visait le grand nombre de travailleurs migrants parlant l'Haryana à Delhi pour les empêcher de voter pour son rival.

Bakshi a également déclaré avec fierté que grâce à l'utilisation de la technologie DeepFake, la communication bénigne de la campagne a été étendue de manière sans précédent.

L'Inde compte 30 langues et 2 000 dialectes

Il y a une raison pour laquelle l’équipe candidate s’est creusé la tête pour faire parler DeepFake en dialecte.

Il existe de nombreuses langues parlées parmi les différents groupes ethniques en Inde. Selon les statistiques actuelles, il existe au moins 30 langues différentes et 2 000 dialectes.

La Constitution indienne stipule que l'hindi, le sanskrit et l'anglais sont les langues officielles du gouvernement indien, mais il existe 14 autres langues populaires (avec une population de plus de 5 millions). L'haryanvi mentionné dans l'article (généralement considéré comme un sous-type de l'hindi) en fait partie.

Les statistiques montrent que cette courte vidéo en langue Haryanvi a été partagée dans 5 800 groupes WhatsApp et a été visionnée par environ 15 millions de personnes.

Les faits ont prouvé que DeepFake a grandement contribué à son effet de diffusion.

Utiliser des algorithmes pour ajouter de « fausses voix » aux vidéos

Comment cette technologie est-elle mise en œuvre ?

L'Ideaz Factory a affirmé avoir effectué le processus de correspondance vocale dans d'autres langues sur la base de la vidéo Tiwari.

Plus précisément, un algorithme Deepfake avec technologie de mouvement des lèvres a été utilisé, entraîné avec la voix de Tiwari, et enfin l'audio externe et les mouvements de la bouche ont été fusionnés.

Après avoir obtenu le modèle formé, la société a embauché un doubleur pour imiter Tiwari lisant les lignes écrites en Haryanvi et a finalement injecté la voix dans la vidéo.

En d’autres termes, la vidéo de Tiwari parlant en dialecte est une véritable image de lui-même avec la voix de quelqu’un d’autre ajoutée, et les mouvements des lèvres sont modifiés pour lui donner un aspect réel.

L'entreprise affirme également que la technologie actuelle n'est pas suffisamment mature pour générer directement la voix de la personne ciblée à l'aide d'un algorithme. Mais ils ont confiance dans la technologie et prévoient de la promouvoir à plus grande échelle, par exemple en l'utilisant lors des prochaines élections générales du Bihar et des élections américaines de 2020.

Bien que The Ideaz Factory ait refusé de partager les détails de la technologie utilisée, les chercheurs du RIT ont néanmoins deviné, à partir de certains indices, qu'ils avaient peut-être utilisé le modèle vid2vid de Nvidia.

Malheureusement, DeepFake ne les a pas aidés à remporter la victoire finale

Ce n’est pas la première fois que DeepFake est utilisé dans les campagnes électorales, mais c’est une première sans précédent en Inde, où la situation est relativement compliquée.

Le Royaume-Uni et les États-Unis ont déjà été confrontés à des incidents de fausses vidéos lors d’élections. C’est pourquoi de nombreuses régions ont introduit des mesures réglementaires légales plus strictes.

Même sur les plateformes de médias sociaux telles que Twitter, Facebook et Reddit, des réglementations strictes ont été formulées pour réprimer l’utilisation des DeepFakes dans les campagnes électorales.

Cependant, il n’existe actuellement aucune disposition légale pertinente concernant les DeepFakes apparus lors des élections indiennes. Certains pensent même que déclarer cette mesure illégale ne sera probablement pas appliqué à court terme, car elle ne recevra pas le soutien public du parti au pouvoir.

Il convient de mentionner que malgré l’utilisation de la technologie DeepFake, le BJP a subi une défaite écrasante lors de cette élection.

Le 11 février, les résultats des élections à Delhi ont été publiés, le BJP n'ayant remporté que huit des 70 sièges, tandis que l'AAP (Common Man Party) a remporté les 62 sièges restants.

Il semble donc peu probable que l’Inde envisage de faire face à l’impact de DeepFake.

Références :

https://www.vice.com/en_in/article/jgedjb/the-first-use-of-deepfakes-in-indian-election-by-bjp?utm_source=reddit.com

http://www.fx361.com/page/2020/0210/6345716.shtml

-- sur--