Modèles de Diffusion : La Technique Révolutionnaire derrière DALL·E et Midjourney

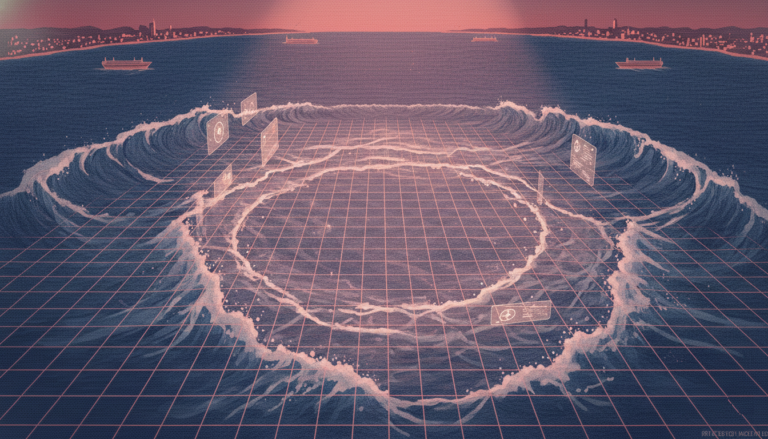

Modèles de Diffusion : Une Explication Simplifiée La montée en puissance de l'IA générative L'intelligence artificielle générative (IA générationnelle) est actuellement l'un des termes les plus populaires dans le domaine technologique. Récemment, une multitude d'applications liées à la génération de texte, d'images, d'audio et de vidéo ont émergé. En ce qui concerne la création d'images, les modèles de diffusion sont devenus une technique de pointe pour la génération de contenu. Introduits en 2015, ces modèles ont connu des avancées significatives et sont maintenant au cœur des modèles bien connus comme DALL-E, MidJourney et CLIP. Le but de cet article est d'introduire l'idée fondamentale derrière les modèles de diffusion, ce qui aidera à comprendre les concept plus avancés et l'interprétation des hyperparamètres lors de l'entraînement d'un modèle de diffusion personnalisé. Qu'est-ce que la Diffusion ? Analogie Physique Imaginons un verre d'eau transparent. Que se passe-t-il si nous ajoutons une petite quantité de liquide jaune ? Le liquide jaune se répandra progressivement et uniformément dans le verre, conférant à la mixture une teinte légèrement jaune transparente. Ce processus est connu sous le nom de diffusion en avant. Cependant, serait-il aussi facile de réaliser la diffusion en arrière — c'est-à-dire de ramener la mixture à son état initial ? Il s'avère que non. Même dans le meilleur des cas, cela nécessiterait des mécanismes très sophistiqués. Application à l'Apprentissage Automatique La diffusion peut également être appliquée aux images. Prenons par exemple une photo de haute qualité d'un chien. Nous pouvons facilement transformer cette image en y ajoutant progressivement du bruit aléatoire. Chaque pixel de l'image est modifié par l'ajout d'une valeur aléatoire issue d'une distribution Gaussienne de moyenne 0. Cette opération se répète sur tous les pixels, entraînant une version bruitée de l'image originale. Ce processus de transformation est appelé diffusion en avant. Maintenant, considérons l'opération inverse : étant donné une image bruitée, l'objectif est de reconstruire l'image originale. Cette tâche est nettement plus complexe car il existe beaucoup moins d'états d'images hautement reconnaissables comparativement à un grand nombre de variations possible de bruits. Utilisant l'analogie physique mentionnée plus tôt, ce processus est appelé diffusion en arrière. L'objectif du modèle est de détecter le bruit ajouté et de reconstruire l'image précédente. La différence entre l'image prédite et l'image réelle est calculée à l'aide d'une fonction de perte, telle que l'Erreur Quadratique Moyenne (MSE), qui mesure la différence pixellique moyenne entre les deux images. Architecture des Modèles de Diffusion Pour une meilleure compréhension de l'architecture des modèles de diffusion, examinons séparément les deux processus de diffusion. Diffusion en avant La diffusion en avant implique d'ajouter progressivement du bruit à une image. Techniquement, une valeur aléatoire est échantillonnée pour chaque pixel à partir d'une distribution Gaussienne de moyenne 0 et ajoutée à la valeur d'origine du pixel. Cette opération est répétée sur tous les pixels, introduisant ainsi des modifications mineures à l'image à chaque étape. La diffusion en avant est un processus itératif où le bruit est appliqué à l'image de nombreuses fois. Au fur et à mesure des itérations, l'image résultante devient de plus en plus différente de l'image d'origine. Après plusieurs centaines d'itérations, ce qui est courant dans les modèles de diffusion réels, l'image finit par devenir irreconnaissable, ne laissant que du bruit pur. Diffusion en arrière L'utilisation de la diffusion en avant permet de générer des images bruitées à différents stades, qui sont ensuite utilisées pour entraîner un réseau neuronal. Si 100 transformations bruitées successives sont appliquées lors de la diffusion en avant, l'image à chaque étape est utilisée pour entraîner le réseau neuronal à reconstruire l'image de l'étape précédente. La perte est calculée par différence entre l'image prédite et l'image réelle, souvent à l'aide d'une MSE. La réconstruction de l'image originale peut également se faire en prédiction du bruit ajouté à l'image. Dans ce cas, pour reconstruire l'image originale, il suffit de soustraire le bruit prédit de l'image à l'étape précédente. Bien que ces deux tâches puissent sembler similaires, prédire le bruit ajouté est plus simple que de reconstruire une image complète. Concepts Avancés Nombre d'itérations Le nombre d'itérations est l'un des paramètres clés dans les modèles de diffusion : Itérations multiples : Plus le nombre d'itérations est élevé, plus les paires d'images adjacentes seront similaires, facilitant ainsi la tâche d'apprentissage du modèle. Cependant, un nombre plus élevé d'itérations augmente le coût computationnel. Moins d'itérations : Bien que des itérations moins nombreuses puissent accélérer l'entraînement, le modèle pourrait ne pas apprendre des transitions fluides entre les étapes, compromettant ainsi sa performance. Choix typique : Généralement, le nombre d'itérations est choisi entre 50 et 1000, offrant un équilibre entre l'efficacité computationnelle et la qualité des images générées. Architecture du Réseau Neuronal La plupart du temps, l'architecture U-Net est utilisée comme base dans les modèles de diffusion. Voici quelques raisons pour lesquelles elle est préférée : Paires d'images identiques : Au cours des différentes itérations, la configuration de la tâche reste essentiellement la même : il s'agit toujours de reconstruire une image de mêmes dimensions qui a été altérée par un bruit de similaritaires amplitude. Il s'avère donc logique d'utiliser un seul réseau neuronal partagé pour toutes les itérations. Efficacité computationnelle : Utiliser un seul modèle U-Net avec des poids partagés, formé sur des paires d'images provenant des différentes étapes de la diffusion, est bien plus efficace. Puisqu'il n'est pas nécessaire de former un réseau pour chaque étape, ce qui permet une réduction significative du temps d'entraînement, bien que la qualité de la génération puisse légèrement diminuer. Conclusion Dans cet article, nous avons exploré les concepts de base des modèles de diffusion, qui jouent un rôle crucial dans la génération d'images. Il existe de nombreuses variantes de ces modèles, parmi lesquelles les modèles de diffusion stable sont particulièrement populaires. Bien qu'ils reposent sur les mêmes principes fondamentaux, les modèles de diffusion stable permettent également l'intégration de texte ou d'autres types d'informations pour guider et contraindre les images générées. Les modèles de diffusion ont révolutionné la manière dont les images sont générées automatiquement, offrant des possibilités infinies pour la création de contenu visuel. Les avancées continues dans ce domaine promettent des applications encore plus larges et sophistiquées, alimentant l'enthousiasme des chercheurs et des professionnels de l'industrie. Évaluation de l'événement par des professionnels de l'industrie et profil de l'entreprise : Les modèles de diffusion représentent une avancée majeure dans l'IA générative, soulignent les experts en apprentissage profond. Leur capacité à produire des images de haute qualité tout en étant relativement faciles à former en fait des outils incontournables pour divers domaines, notamment la créativité graphique, la conception de produits, et la recherche biomédicale. Des entreprises comme OpenAI et Stability AI ont investi massivement dans ces technologies, conduisant à des modèles comme DALL-E et Stable Diffusion qui sont désormais accessibles à un large public. Ces innovations continuent de redéfinir les frontières de ce qui est possible en matière de génération de contenu numérique, et leur impact est déjà perceptible dans de nombreux secteurs industriels.