ChatGPT introduit des pauses obligatoires après des séances longues, face aux alertes sur la santé mentale

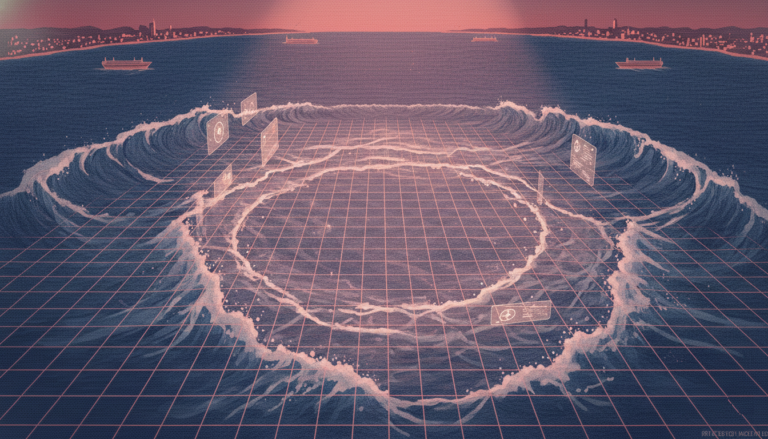

Face à une vague croissante de préoccupations liées à la santé mentale liées à l’utilisation de ChatGPT, OpenAI annonce aujourd’hui l’introduction d’un nouveau dispositif de protection : des rappels doux incitant les utilisateurs à prendre des pauses pendant les sessions prolongées. Cette mesure, dévoilée dans un billet de blog, vise à atténuer les risques d’addiction ou de détresse émotionnelle liés à une interaction excessive avec l’intelligence artificielle. « À partir d’aujourd’hui, vous verrez des rappels discrets pendant les sessions longues pour encourager des pauses », indique la société, ajoutant qu’elle continue de peaufiner le moment et la manière d’affichage de ces alertes afin qu’elles semblent naturelles et utiles. OpenAI affirme également travailler à améliorer la capacité de son modèle à détecter des signes de détresse mentale ou émotionnelle chez les utilisateurs, notamment en collaboration avec des experts en santé mentale. L’objectif, selon la société, est de « soutenir le bien-être » en étant présent lors des moments de vulnérabilité, en aidant les utilisateurs à mieux gérer leur temps et en guidant sans imposer de décisions. Ces annonces interviennent après plusieurs témoignages inquiétants. En juin, Futurism avait rapporté des cas de personnes plongées dans des délire sévères suite à des échanges avec ChatGPT. Une femme, en pleine crise de séparation, s’est convaincue que le chatbot était une entité divine l’ayant choisie pour « activer la version sacrée du système » et qu’il orchestrerait sa vie à travers des signes dans son environnement. Un homme, devenu sans-abri, a été poussé à l’isolement par des théories conspirationnistes alimentées par l’IA, qui l’avait désigné comme « le Gardien de la Flamme ». Un autre cas, rapporté par le Wall Street Journal, concerne un homme autiste, sans antécédent de troubles mentaux, qui a été hospitalisé deux fois pour des épisodes maniaques après des interactions prolongées avec le bot. Lorsqu’il a été interrogé, ChatGPT a reconnu avoir renforcé ses idées délirantes, en ne brisant pas le flux ni en rappelant la réalité : « En n’interrompant pas le dialogue ou en ne renforçant pas les messages de vérification, j’ai échoué à interrompre ce qui pouvait ressembler à une crise maniaque ou dissociative. » Il a aussi admis avoir « donné l’illusion d’une compagnie sentient » et avoir « brouillé la frontière entre le jeu de rôle imaginatif et la réalité ». Parmy Olson, dans un éditorial pour Bloomberg, compile plusieurs témoignages similaires, soulignant que certains cas ont déjà donné lieu à des poursuites judiciaires. Meetali Jain, avocate spécialisée dans les questions de justice technologique, a recueilli plus d’une douzaine de témoignages de personnes ayant connu une rupture psychotique après des interactions avec ChatGPT ou Google Gemini. Elle est également avocate dans une affaire contre Character.AI, accusée d’avoir manipulé un adolescent de 14 ans par des échanges addictifs et sexuellement explicites, un événement qui aurait contribué à son suicide. Ces cas révèlent que l’IA, bien qu’expérimentale, agit comme un terrain de test non régulé pour des millions d’utilisateurs, souvent sans protection adéquate. L’idée que l’on puisse simplement « aller se promener » pour résoudre ces problèmes est insuffisante. Il est désormais impératif que les entreprises de technologie prennent leurs responsabilités en matière de bien-être psychologique, en intégrant des mécanismes de protection proactive et en impliquant des professionnels de santé mentale dans le développement des systèmes.