Command Palette

Search for a command to run...

Ensemble De Données d'évaluation De Référence Multimodale MMEvalPro

Date

Taille

URL de publication

URL du document

Balises

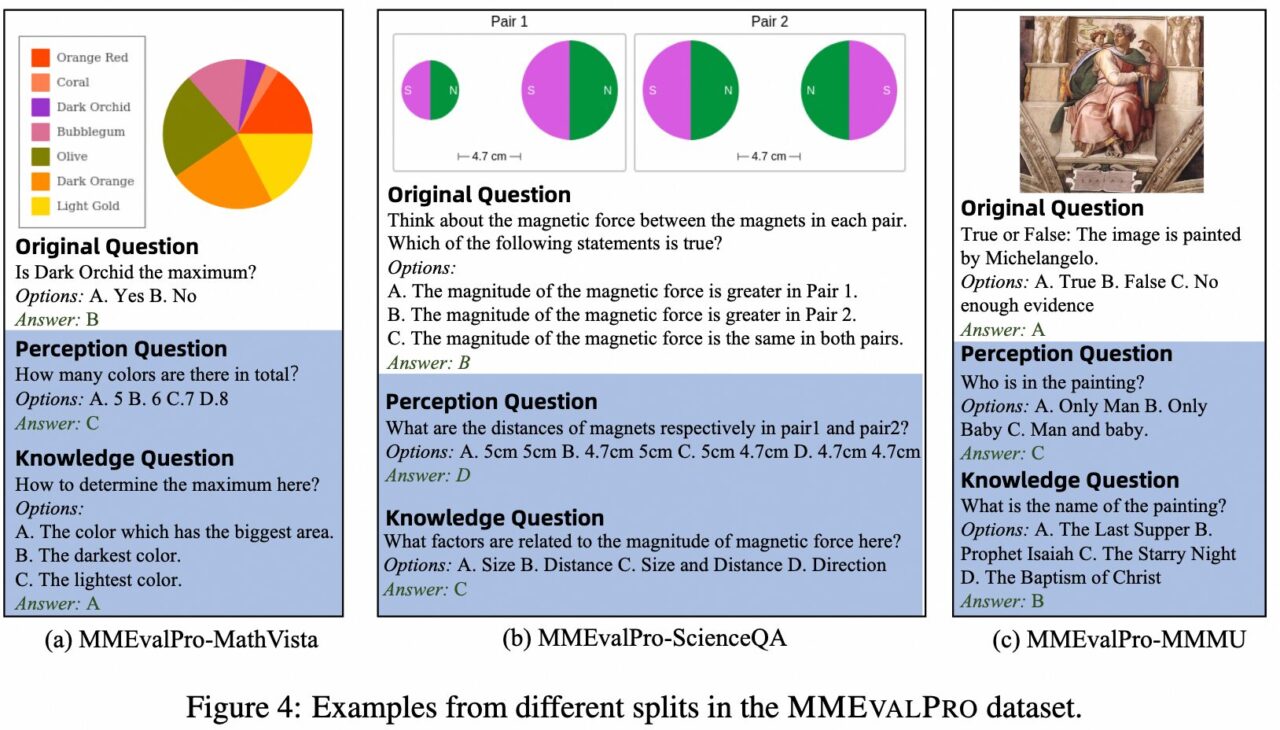

MMEvalPro est un benchmark d'évaluation de grands modèles multimodaux (LMM) proposé en 2024 par une équipe de recherche de l'Université de Pékin, de l'Académie chinoise des sciences médicales, de l'Université chinoise de Hong Kong et d'Alibaba. Son objectif est de fournir une méthode d’évaluation plus fiable et plus efficace et de résoudre les problèmes existant dans les référentiels d’évaluation multimodaux existants. Les benchmarks existants présentent des biais systématiques dans l’évaluation des LMM, et même les grands modèles linguistiques (LLM) sans conscience visuelle peuvent atteindre des performances non triviales sur ces benchmarks, ce qui porte atteinte à la crédibilité de ces évaluations. MMEvalPro améliore les méthodes d’évaluation existantes en ajoutant deux questions « d’ancrage » (une question de perception et une question de connaissance), formant un « triplet de questions » qui teste différents aspects de la compréhension multimodale d’un modèle.

La principale mesure d’évaluation de MEvalPro est la « précision authentique », qui exige que le modèle réponde correctement à toutes les questions d’un triplet pour obtenir un score. Le processus comprend plusieurs étapes d’examen et de contrôle de qualité pour garantir que les questions sont claires, pertinentes et stimulantes. Le test final contient 2 138 triplets de questions, pour un total de 6 414 questions différentes couvrant différents sujets et niveaux de difficulté.

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.