Command Palette

Search for a command to run...

Ensemble De Données De Capture De Mouvement Multimodal MMVP

Date

Taille

URL de publication

MMVP (Multimodal MoCap Dataset with Vision and Pressure Sensors) est un ensemble de données de capture de mouvement multimodal combinant des capteurs de vision et de pression développés conjointement par l'Université Beihang, l'Université Tsinghua et l'Université de Nanjing.

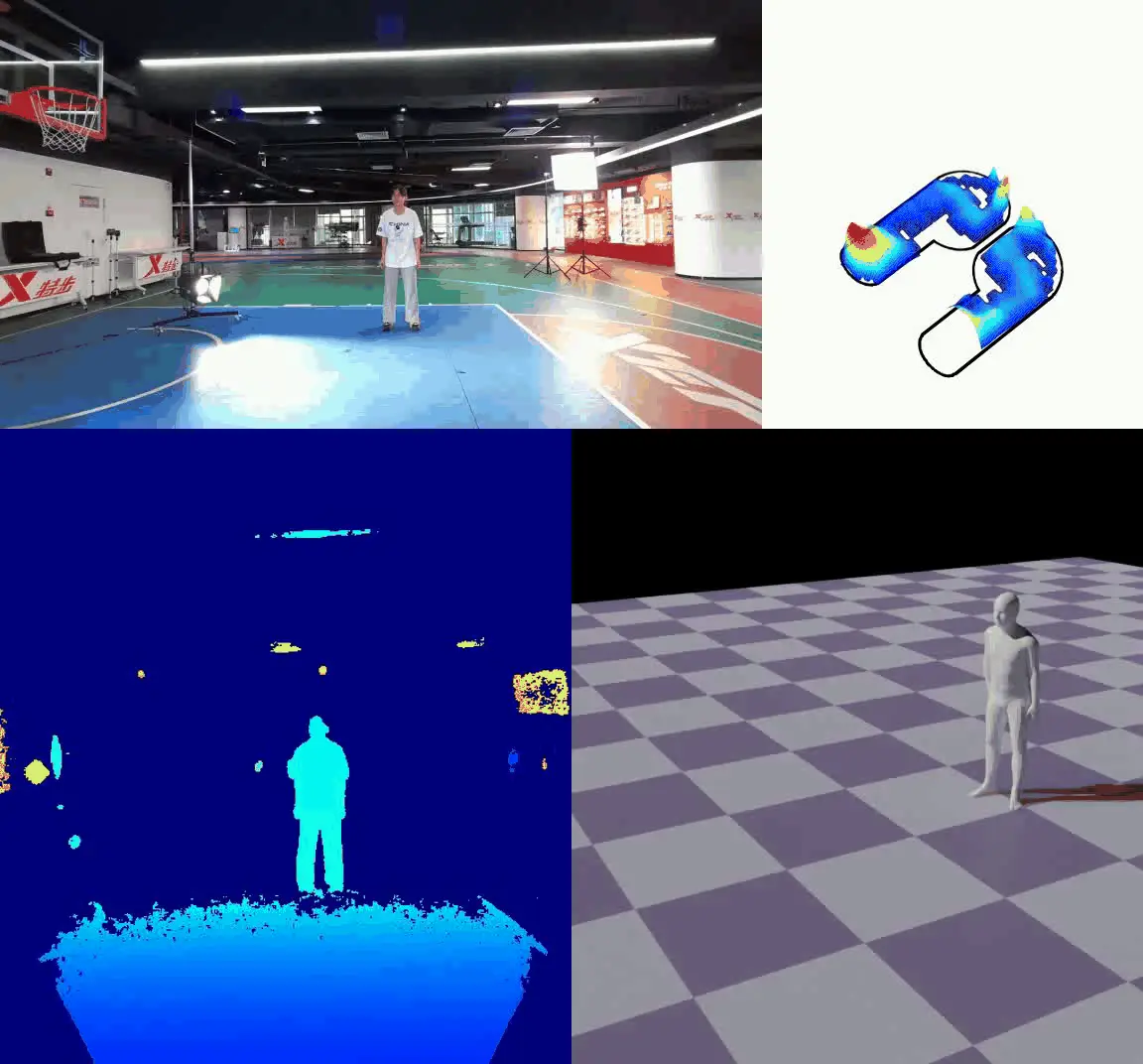

L'ensemble de données contient une large gamme de mouvements humains rapides, tels que la course, le saut à la corde, le saut en longueur debout, etc. Au total, plus de 44 000 images RGBD synchronisées et des données de pression provenant de 16 sujets ont été collectées. Les chercheurs ont utilisé la caméra Azure Kinect pour enregistrer des vidéos RGBD à une fréquence de 30 images par seconde et ont utilisé des semelles de pression Xsensor pour capturer des données de pression plantaire à une fréquence allant jusqu'à 150 images par seconde. En synchronisant manuellement les deux flux de données et en les combinant avec des algorithmes d’apprentissage en profondeur tels que FPP-Net et CLIFF, ils ont obtenu un traitement et une analyse détaillés des données. Cet ensemble de données fournit une nouvelle ressource de données pour la recherche sur la capture de mouvement humain basée sur des capteurs de vision et de pression, ce qui peut favoriser les progrès dans ce domaine.

décrire: Le benchmark MMVP (Multimodal Visual Patterns) se concentre sur l'identification des « paires CLIP-blind » — des images que CLIP considère comme similaires malgré des différences visuelles évidentes. MMVP évalue les performances des systèmes de pointe, dont le GPT-4V, sur neuf modalités visuelles de base. Il met en évidence les défis auxquels ces systèmes sont confrontés pour répondre à des questions simples, ce qui conduit souvent à des réponses erronées et à des interprétations hallucinatoires.

- Type de contenu : Images (paires CLIP-aveugles)

- quantité: 300 images

- Source des données : Dérivé d'ImageNet-1k et LAION-Aesthetics

- Méthodes de collecte de données : Identification des paires aveugles CLIP par analyse comparative

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.